Événements

31 mars, 23 h - 2 avr., 23 h

Le plus grand événement d’apprentissage Fabric, Power BI et SQL. 31 mars au 2 avril. Utilisez le code FABINSIDER pour économiser 400 $.

Inscrivez-vous aujourd’huiCe navigateur n’est plus pris en charge.

Effectuez une mise à niveau vers Microsoft Edge pour tirer parti des dernières fonctionnalités, des mises à jour de sécurité et du support technique.

S’APPLIQUE À :  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Conseil

Essayez Data Factory dans Microsoft Fabric, une solution d’analyse tout-en-un pour les entreprises. Microsoft Fabric couvre tous les aspects, du déplacement des données à la science des données, en passant par l’analyse en temps réel, l’aide à la décision et la création de rapports. Découvrez comment démarrer un nouvel essai gratuitement !

Notes

Le gestionnaire du flux de travail est basé sur Apache Airflow.

Notes

Le gestionnaire du flux de travail pour Azure Data Factory s’appuie sur l’application open source Apache Airflow. Vous trouverez de la documentation et d’autres tutoriels sur Airflow dans les pages Documentation ou Communauté d’Apache Airflow.

Les pipelines Data Factory fournissent plus de 100 connecteurs de source de données qui fournissent une intégration de données/des flux de données évolutifs et fiables. Il existe des scénarios dans lesquels vous souhaitez exécuter un pipeline de fabrique de données existant à partir de votre DAG Apache Airflow. Ce tutoriel vous explique comment faire exactement cela.

Créez un fichier Python adf.py avec le contenu ci-dessous :

from datetime import datetime, timedelta

from airflow.models import DAG, BaseOperator

try:

from airflow.operators.empty import EmptyOperator

except ModuleNotFoundError:

from airflow.operators.dummy import DummyOperator as EmptyOperator # type: ignore

from airflow.providers.microsoft.azure.operators.data_factory import AzureDataFactoryRunPipelineOperator

from airflow.providers.microsoft.azure.sensors.data_factory import AzureDataFactoryPipelineRunStatusSensor

from airflow.utils.edgemodifier import Label

with DAG(

dag_id="example_adf_run_pipeline",

start_date=datetime(2022, 5, 14),

schedule_interval="@daily",

catchup=False,

default_args={

"retries": 1,

"retry_delay": timedelta(minutes=3),

"azure_data_factory_conn_id": "<connection_id>", #This is a connection created on Airflow UI

"factory_name": "<FactoryName>", # This can also be specified in the ADF connection.

"resource_group_name": "<ResourceGroupName>", # This can also be specified in the ADF connection.

},

default_view="graph",

) as dag:

begin = EmptyOperator(task_id="begin")

end = EmptyOperator(task_id="end")

# [START howto_operator_adf_run_pipeline]

run_pipeline1: BaseOperator = AzureDataFactoryRunPipelineOperator(

task_id="run_pipeline1",

pipeline_name="<PipelineName>",

parameters={"myParam": "value"},

)

# [END howto_operator_adf_run_pipeline]

# [START howto_operator_adf_run_pipeline_async]

run_pipeline2: BaseOperator = AzureDataFactoryRunPipelineOperator(

task_id="run_pipeline2",

pipeline_name="<PipelineName>",

wait_for_termination=False,

)

pipeline_run_sensor: BaseOperator = AzureDataFactoryPipelineRunStatusSensor(

task_id="pipeline_run_sensor",

run_id=run_pipeline2.output["run_id"],

)

# [END howto_operator_adf_run_pipeline_async]

begin >> Label("No async wait") >> run_pipeline1

begin >> Label("Do async wait with sensor") >> run_pipeline2

[run_pipeline1, pipeline_run_sensor] >> end

# Task dependency created via `XComArgs`:

# run_pipeline2 >> pipeline_run_sensor

Vous devez créer la connexion à l’aide de l’interface utilisateur du gestionnaire du flux de travail Administration -> Connexions -> '+' -> Choisissez 'Type de connexion' comme 'Azure Data Factory', puis renseignez vos client_id, client_secret, tenant_id, subscription_id, resource_group_name, data_factory_name et pipeline_name.

Chargez le fichier adf.py dans votre stockage d’objets blob dans un dossier appelé DAGS.

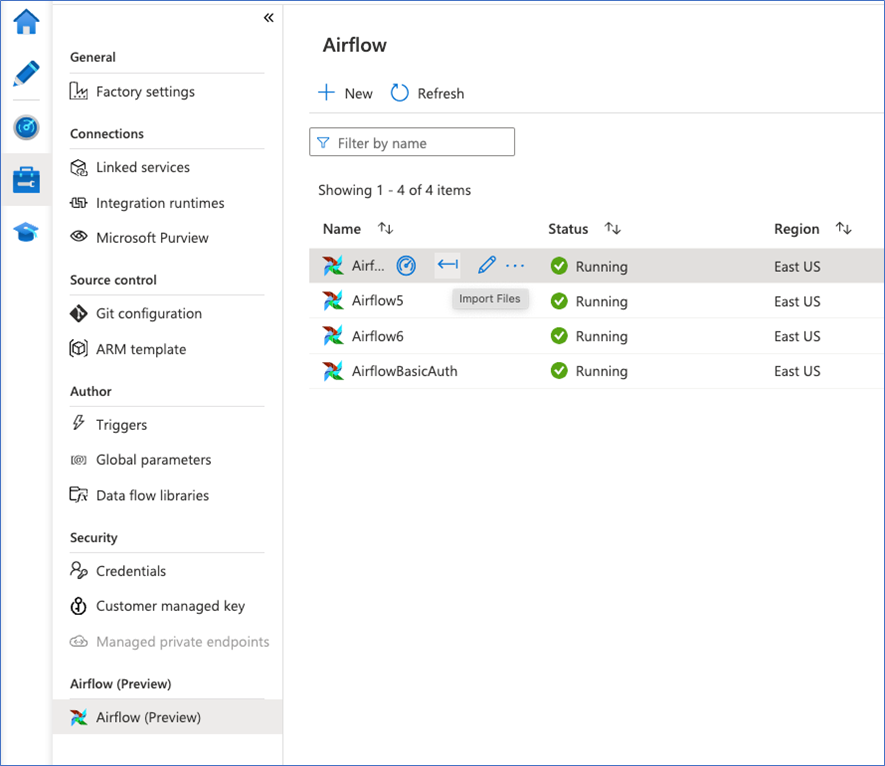

Importez le dossier DAGS dans votre environnement du gestionnaire du flux de travail. Si vous n’en avez pas, créez-en un

Événements

31 mars, 23 h - 2 avr., 23 h

Le plus grand événement d’apprentissage Fabric, Power BI et SQL. 31 mars au 2 avril. Utilisez le code FABINSIDER pour économiser 400 $.

Inscrivez-vous aujourd’huiEntrainement

Module

Orchestration du déplacement et de la transformation des données dans Azure Data Factory - Training

Orchestrer le déplacement et la transformation des données dans le pipeline Azure Data Factory ou Azure Synapse

Certification

Microsoft Certified : Azure Data Engineer Associate - Certifications

Faites la démonstration d’une compréhension des tâches d’engineering données courantes pour implémenter et gérer des charges de travail d’engineering données sur Microsoft Azure en utilisant un certain nombre de services Azure.