Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Important

Le support de Machine Learning Studio (classique) prend fin le 31 août 2024. Nous vous recommandons de passer à Azure Machine Learning avant cette date.

À partir du 1er décembre 2021, vous ne pourrez plus créer de nouvelles ressources Machine Learning Studio (classique). Jusqu’au 31 août 2024, vous pouvez continuer à utiliser les ressources Machine Learning Studio (classique) existantes.

- Consultez les informations sur le déplacement des projets de machine learning de ML Studio (classique) à Azure Machine Learning.

- En savoir plus sur Azure Machine Learning.

La documentation ML Studio (classique) est en cours de retrait et ne sera probablement plus mise à jour.

Évalue les résultats d’un modèle de classification ou de régression avec des métriques standard

Catégorie : Machine Learning / Évaluer

Notes

S’applique à : Machine Learning Studio (classique) uniquement

Des modules par glisser-déposer similaires sont disponibles dans Concepteur Azure Machine Learning.

Vue d’ensemble du module

Cet article explique comment utiliser le module Évaluer le modèle dans Machine Learning Studio (classique) pour mesurer la précision d’un modèle entraîné. Vous fournissez un jeu de données qui contient les scores générés à partir d’un modèle et le module Évaluer le modèle calcule un ensemble de métriques d’évaluation standard du secteur.

Les métriques retournées par Évaluer le modèle varient selon le type de modèle que vous évaluez :

Pour les modèles de recommandation, utilisez le module Évaluer le générateur de recommandations .

Conseil

Si vous débutez avec l’évaluation du modèle, nous vous recommandons ces exemples dans azure AI Gallery, qui créent un modèle, puis expliquent comment utiliser les métriques associées :

- Comparer les modèles de régression

- Comparer des classifieurs binaires

- Comparer des classifieurs multiclasses

Nous recommandons également la série vidéo de Dr Stephen Elston, dans le cadre du cours machine learning de EdX.

Comment utiliser le modèle Evaluate

Il existe trois façons d’utiliser le module Évaluer le modèle :

- Générer des scores sur vos données d’apprentissage et évaluer le modèle en fonction de ces scores

- Générer des scores sur le modèle, mais comparer ces scores à ceux d’un jeu de tests réservé

- Comparer les scores de deux modèles différents mais liés, en utilisant le même jeu de données

Utiliser les données d’apprentissage

Pour évaluer un modèle, vous devez connecter un jeu de données qui contient un ensemble de colonnes d’entrée et de scores. Si aucune autre donnée n’est disponible, vous pouvez utiliser votre jeu de données d’origine.

- Connecter la sortie datset notée du modèle de score à l’entrée du modèle d’évaluation.

- Cliquez sur le module Évaluer le modèle, puis sélectionnez Exécuter la sélection pour générer les scores d’évaluation.

Utiliser des données de test

Un scénario courant de Machine Learning consiste à séparer votre jeu de données d’origine en jeux de données d’apprentissage et de test, à l’aide du module Fractionner ou du module Partition et échantillon.

- Connectez la sortie du jeu de données noté du module Scorer le modèle à l’entrée du module Évaluer le modèle.

- Connectez la sortie du module Fractionner des données qui contient les données de test à l’entrée de droite du module Évaluer le modèle.

- Cliquez sur le module Évaluer le modèle, puis sélectionnez Exécuter la sélection pour générer les scores d’évaluation.

Comparer les scores de deux modèles

Vous pouvez également connecter un second jeu de résultats au module Évaluer le modèle. Les scores peuvent être un ensemble d’évaluations partagé contenant des résultats connus, ou un ensemble de résultats d’un autre modèle pour les mêmes données.

Cette fonctionnalité est utile car vous pouvez facilement comparer les résultats de deux modèles différents sur les mêmes données. Vous pouvez également comparer les scores de deux exécutions différentes sur les mêmes données avec des paramètres différents.

- Connecter la sortie datset notée du modèle de score à l’entrée du modèle d’évaluation.

- Connectez la sortie du module Scorer le modèle pour le second modèle à l’entrée de droite du module Évaluer le modèle.

- Cliquez avec le bouton droit sur le module Évaluer le modèle, puis sélectionnez Exécuter la sélection pour générer les scores d’évaluation.

Résultats

Après avoir exécuté Évaluer le modèle, cliquez avec le bouton droit sur le module et sélectionnez Résultats de l’évaluation pour afficher les résultats. Vous pouvez :

- Enregistrer les résultats dans un jeu de données, pour faciliter l’analyse avec d’autres outils

- Générer une visualisation dans l’interface Studio (classique)

Si vous connectez des jeux de données aux deux entrées du module Évaluer le modèle, les résultats contiennent des métriques pour les deux jeux de données ou les deux modèles. Le modèle ou les données attachés au port gauche sont présentés en premier dans le rapport, suivis des métriques du jeu de données ou du modèle attaché sur le port droit.

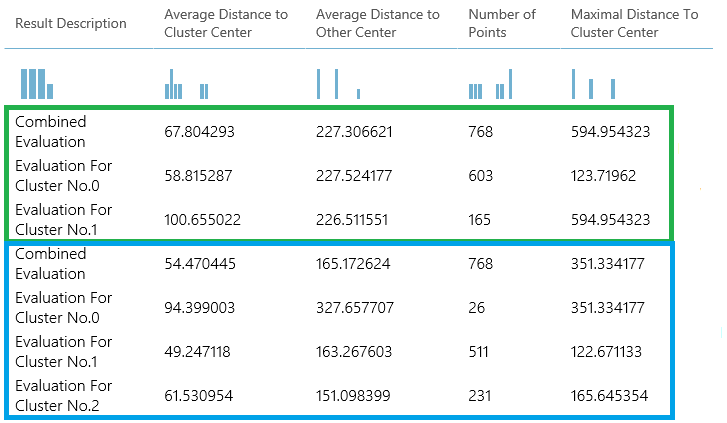

Par exemple, l’image suivante représente une comparaison des résultats de deux modèles de clustering qui ont été créés sur les mêmes données, mais avec des paramètres différents.

Comme il s’agit d’un modèle de clustering, les résultats de l’évaluation sont différents de ceux obtenus si vous aviez comparé les scores de deux modèles de régression ou comparé deux modèles de classification. La présentation globale est toutefois la même.

Mesures

Cette section décrit les métriques retournées pour les types spécifiques de modèles pris en charge avec Évaluer le modèle :

Métriques pour les modèles de classification

Les métriques suivantes sont rapportées lors de l’évaluation de modèles de classification. Si vous comparez des modèles, elles sont classées selon la métrique que vous sélectionnez pour l’évaluation.

L’exactitude mesure l’adéquation d’un modèle de classification sous forme de proportion de résultats réels sur le nombre total de cas.

La précision correspond à la proportion de résultats réels sur tous les résultats positifs.

Le rappel correspond à la fraction de tous les résultats corrects retournés par le modèle.

Le score F est calculé comme étant la moyenne pondérée de précision et de rappel comprise entre 0 et 1, où la valeur de score F idéale est 1.

AUC mesure la zone sous la courbe tracée avec les vrais positifs sur l’axe y et les faux positifs sur l’axe x. Cette métrique est utile car elle fournit un nombre unique qui vous permet de comparer les modèles de types différents.

La perte de journaux moyenne est un score unique utilisé pour exprimer la pénalité des résultats incorrects. Elle est calculée comme étant la différence entre deux distributions de probabilité : la réelle et celle du modèle.

La perte de journaux d’apprentissage est un score unique qui représente l’avantage du classifieur sur une prédiction aléatoire. La perte de journaux mesure l’incertitude de votre modèle en comparant les probabilités qu’il génère avec les valeurs connues (terrestre exacte) dans les étiquettes. Vous souhaitez minimiser la perte de journaux pour l’ensemble du modèle.

Métriques pour les modèles de régression

Les métriques retournées pour les modèles de régression sont généralement conçues pour estimer la quantité d’erreurs. Un modèle est jugé correctement adapté aux données si la différence entre valeurs observées et prévues est faible. Toutefois, l’observation du modèle des résidus (la différence entre n’importe quel point prédit et sa valeur réelle correspondante) peut vous en apprendre beaucoup sur un éventuel décalage dans le modèle.

Les métriques suivantes sont rapportées lors de l’évaluation de modèles de régression. Lorsque vous comparez des modèles, elles sont classées selon la métrique que vous sélectionnez pour l’évaluation.

La probabilité de journal négatif mesure la fonction de perte, un score inférieur est préférable. Notez que cette métrique est calculée uniquement pour la régression linéaire bayésienne et la régression de forêt décisionnelle; pour d’autres algorithmes, la valeur est

Infinityce qui signifie rien pour rien.L’erreur absolue moyenne (MAE) mesure la précision des prédictions par rapport aux résultats réels ; un score inférieur est donc préférence.

La racine carrée de l’erreur quadratique moyenne (RMSE) crée une valeur unique qui résume l’erreur dans le modèle. En mettant la différence au carré, la métrique ne tient pas compte de la différence entre sur-prédiction et sous-prédiction.

L’erreur absolue relative (RAE) est la différence absolue relative entre valeurs prévues et réelles ; elle est relative car la différence moyenne est divisée par la moyenne arithmétique.

L’erreur quadratique relative (RSE) normalise de manière similaire l’erreur quadratique totale des valeurs prévues en divisant par l’erreur quadratique totale des valeurs réelles.

L’erreur zéro-un moyenne (MZOE) indique si la prédiction était correcte ou non. En d’autres termes :

ZeroOneLoss(x,y) = 1lorsquex!=y; sinon0.Le coefficient de détermination, généralement appelé R2, représente la puissance prédictive du modèle sous la forme d’une valeur comprise entre 0 et 1. Zéro signifie que le modèle est aléatoire ; 1 signifie qu’il convient parfaitement. Soyez toutefois vigilant dans l’interprétation de valeurs R2 car des valeurs faibles peuvent être totalement normales et des valeurs élevées peuvent être suspectes.

Mesures pour les modèles de clustering

Étant donné que les modèles de clustering diffèrent considérablement des modèles de classification et de régression à de nombreux égards, Évaluer le modèle retourne également un ensemble différent de statistiques pour les modèles de clustering.

Les statistiques retournées pour un modèle de clustering décrivent le nombre de points de données attribués à chaque cluster, le degré de séparation entre les clusters et le degré de regroupement des points de données dans chaque cluster.

Les statistiques du modèle de clustering sont calculées par rapport à la moyenne de l’ensemble du jeu de données, avec des lignes supplémentaires contenant les statistiques par cluster.

Par exemple, les résultats suivants montrent une partie des résultats d’une expérience d’exemple qui clusterise les données dans le jeu de données de classification binaire du diabète indien PIMA, qui est disponible dans Machine Learning Studio (classique).

| Description du résultat | Distance moyenne vers le centre de cluster | Distance moyenne vers d’autres centres | Nombre de points | Distance maximale vers le centre de cluster |

|---|---|---|---|---|

| Évaluation combinée | 55.915068 | 169.897505 | 538 | 303.545166 |

| Évaluation du cluster no.0 | 0 | 1 | 570 | 0 |

| Évaluation du cluster No.1 | 0 | 1 | 178 | 0 |

| Évaluation du cluster n° 2 | 0 | 1 | 178 | 0 |

À partir de ces résultats, vous obtenez les informations suivantes :

Le module De clustering de balayage crée plusieurs modèles de clustering, répertoriés dans l’ordre de précision. Par souci de simplicité, nous n’avons montré que le modèle le mieux classé ici. Les modèles sont mesurés à l’aide de toutes les métriques possibles, mais les modèles sont classés à l’aide de la métrique que vous avez spécifiée. Si vous avez modifié la métrique, un autre modèle peut être classé plus haut.

Le score d’évaluation combiné en haut de chaque section de résultats répertorie les scores moyens pour les clusters créés dans ce modèle particulier.

Ce modèle classé le plus élevé s’est produit pour créer trois clusters ; d’autres modèles peuvent créer deux clusters ou quatre clusters. Par conséquent, ce score d’évaluation combiné vous permet de comparer des modèles avec un nombre différent de clusters.

Les scores de la colonne Average Distance to Cluster Center (distance moyenne au centre du cluster) représentent la proximité de tous les points d’un cluster par rapport au centroïde de ce cluster.

Les scores de la colonne Average Distance to Other Center (distance moyenne à un autre centre) représentent la proximité moyenne de chaque point dans le cluster par rapport aux centroïdes de tous les autres clusters.

Vous pouvez choisir l’une des quatre mesures pour mesurer cette distance, mais toutes les mesures doivent utiliser la même métrique.

La colonne Number of Points (Nombre de points) indique le nombre de points de données attribués à chaque cluster, ainsi que le nombre total de points de données dans chaque cluster.

Si le nombre de points de données attribués aux clusters est inférieur au nombre total de points de données disponibles, cela signifie que les points de données n’ont pas pu être attribués à un cluster.

Les scores de la colonne, Distance maximale au centre de cluster, représentent la somme des distances entre chaque point et le centroïde du cluster de ce point.

Si ce nombre est élevé, cela peut signifier que le cluster est très dispersé. Vous devez passer en revue cette statistique avec la distance moyenne au centre de cluster pour déterminer la répartition du cluster.

Exemples

Pour obtenir des exemples de génération, de visualisation et d’interprétation des métriques d’évaluation, consultez ces exemples d’expériences dans la galerie Azure AI. Ces expériences montrent comment générer plusieurs modèles et utiliser le module Evaluate Model pour déterminer le meilleur modèle.

Comparer des classifieurs binaires : explique comment comparer les performances de différents classifieurs créés à l’aide des mêmes données.

Comparer des classifieurs multiclasse : montre comment comparer la précision des différents modèles de classification qui ont été créés sur le jeu de données de reconnaissance de lettres.

Comparer les régresseurs : vous guide tout au long du processus d’évaluation de différents modèles de régression.

Estimation de la demande : Découvrez comment combiner des métriques d’évaluation à partir de plusieurs modèles.

Prédiction de relation client : montre comment évaluer plusieurs modèles associés.

Entrées attendues

| Nom | Type | Description |

|---|---|---|

| Jeu de données noté | Table de données | Jeu de données noté |

| Jeu de données au score calculé à comparer | Table de données | Jeu de données au score calculé à comparer (facultatif) |

Sorties

| Nom | Type | Description |

|---|---|---|

| Evaluation results | Table de données | Résultat de l'évaluation des données |

Exceptions

| Exception | Description |

|---|---|

| Erreur 0003 | Cette exception se produit si une ou plusieurs entrées sont null ou vide. |

| Erreur 0013 | Une exception se produit si la transmission à l'apprenant du module a un type non valide. |

| Erreur 0020 | Une exception se produit si le nombre de colonnes de certains jeux de données transmis au module est trop faible. |

| Erreur 0021 | Une exception se produit si le nombre de lignes de certains jeux de données transmis au module est trop faible. |

| Erreur 0024 | Une exception se produit si le jeu de données ne contient pas de colonne d’étiquette. |

| Erreur 0025 | Une exception se produit si le jeu de données ne contient pas de colonne de score. |

Voir aussi

Modèle de validation croisée

Évaluer le générateur de recommandations

Évaluer

Noter le modèle