Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Important

Le support de Machine Learning Studio (classique) prend fin le 31 août 2024. Nous vous recommandons de passer à Azure Machine Learning avant cette date.

À partir du 1er décembre 2021, vous ne pourrez plus créer de nouvelles ressources Machine Learning Studio (classique). Jusqu’au 31 août 2024, vous pouvez continuer à utiliser les ressources Machine Learning Studio (classique) existantes.

- Consultez les informations sur le déplacement des projets de machine learning de ML Studio (classique) à Azure Machine Learning.

- En savoir plus sur Azure Machine Learning.

La documentation ML Studio (classique) est en cours de retrait et ne sera probablement plus mise à jour.

Charge les données provenant de sources externes sur le web ; à partir de différentes formes de stockage cloud dans Azure, telles que des tables, des objets blob et des bases de données SQL; et à partir de bases de données SQL Server locales

Catégorie : Entrée et sortie des données

Notes

S’applique à : Machine Learning Studio (classique) uniquement

Des modules par glisser-déposer similaires sont disponibles dans Concepteur Azure Machine Learning.

Vue d’ensemble du module

Cet article explique comment utiliser le module Importer des données dans Machine Learning Studio (classique) pour charger des données dans une expérience Machine Learning à partir de services de données cloud existants.

Le module comporte désormais un Assistant pour vous aider à choisir une option de stockage et à sélectionner parmi des abonnements et comptes existants pour configurer rapidement toutes les options. Vous voulez modifier une connexion de données existante ? Pas de problème. L’Assistant charge tous les détails de configuration précédents pour que vous n’ayez pas à recommencer à partir de zéro.

Une fois que vous avez défini les données souhaitées et que vous vous connectez à la source, importez les données du type de données de chaque colonne en fonction des valeurs qu’il contient et charge les données dans votre espace de travail Machine Learning Studio (classique). La sortie de Importer des données est un jeu de données qui peut être utilisé avec n’importe quelle expérience.

Important

Actuellement, il existe des limitations sur les types de comptes de stockage pris en charge. Pour plus d’informations, consultez Notes techniques.

Si vos données sources changent, vous pouvez actualiser le jeu de données et ajouter de nouvelles données en réécutant Les données d’importation. Toutefois, si vous ne souhaitez pas relire la source chaque fois que vous exécutez l’expérience, définissez l’option Use cached results (Utiliser les résultats mis en cache) sur TRUE. Lorsque cette option est sélectionnée, le module vérifie si l’expérience a déjà été exécutée avec la même source et les mêmes options d’entrée. Si une exécution précédente est trouvée, les données du cache sont utilisées, au lieu de recharger les données à partir de la source.

Notes

Ce module a été précédemment nommé Lecteur. Si vous avez précédemment utilisé le module Lecteur dans une expérience, il est renommé importer des données lorsque vous actualisez l’expérience.

Sources de données

Le module Import Data prend en charge les sources de données suivantes. Cliquez sur les liens pour obtenir des instructions détaillées et des exemples d’utilisation de chaque source de données.

Si vous ne savez pas comment ou où stocker vos données, consultez ce guide sur les scénarios de données courants dans le processus de science des données : scénarios d’analytique avancée dans Machine Learning.

| Source de données | Utiliser avec |

|---|---|

| URL Web via HTTP | Obtenir des données qui sont hébergées sur une URL web qui utilise le protocole HTTP et qui a été fournie dans les formats CSV, TSV, ARFF ou SvmLight |

| Requête Hive | Obtenez des données à partir d’un stockage distribué dans Hadoop. Vous spécifiez les données souhaitées à l’aide du langage HiveQL |

| Azure SQL Database | Obtenir des données à partir de Azure SQL Database ou de Azure SQL Data Warehouse |

| Table Azure | Obtenir des données stockées dans le service de table Azure |

| Importer à partir du Stockage Blob Azure | Obtenir des données qui sont stockées dans le service blob Azure |

| Fournisseurs de flux de données | Obtenir des données exposées sous forme de flux au format OData |

| Importer à partir d’une base de données SQL Server locale | Obtenir des données à partir d’une base de données SQL Server locale à l’aide de la passerelle Microsoft Gestion des données |

| Azure Cosmos DB | Obtenez des données stockées au format JSON dans Azure Cosmos DB. |

Conseil

Vous devez importer des données au format JSON ? R et Python prennent en charge les API REST. Utilisez donc les modules Execute Python Script ou Execute R Script pour analyser vos données et l’enregistrer en tant que jeu de données Azure ML.

Vous pouvez également utiliser l’API SQL DB pour CosmosDB, qui prend en charge plusieurs magasins JSON, y compris MongoDB, pour lire vos données à l’aide de l’option Importer à partir d’Azure Cosmos DB. Pour plus d’informations, consultez Importer à partir d’Azure Cosmos DB.

Comment utiliser Importer des données

Ajoutez le module Importer des données à votre expérience. Vous trouverez ce module dans la catégorie d’entrée et de sortie des données dans Studio (classique).

Cliquez sur Launch Data Import Wizard (Lancer l’Assistant Importation de données) pour configurer la source de données à l’aide d’un Assistant.

L’Assistant obtient le nom et les informations d’identification du compte, et vous aide à configurer d’autres options. Si vous modifiez une configuration existante, il charge tout d’abord les valeurs actuelles.

Si vous ne souhaitez pas utiliser l’Assistant, cliquez sur Source de données, puis choisissez le type de stockage basé sur le cloud que vous consultez.

Les paramètres supplémentaires varient selon le type de stockage que vous choisissez, et si le stockage est sécurisé ou non. Vous devrez peut-être fournir le nom de compte, le type de fichier ou les informations d’identification. Certaines sources ne nécessitent pas d’authentification. Pour d’autres, vous devrez peut-être connaître le nom du compte, une clé ou le nom du conteneur.

Pour plus d’informations, consultez la liste des sources de données.

Sélectionnez l’option Utiliser les résultats mis en cache si vous souhaitez mettre en cache le jeu de données pour une réutilisation sur les exécutions successives.

Si l’on suppose qu’aucune autre modification n’a été apportée aux paramètres de module, l’expérience charge les données de la première exécution du module uniquement, puis utilise une version mise en cache du jeu de données.

Désélectionnez cette option si vous devez recharger les données à chaque exécution de l’expérience.

Exécutez l’expérience.

Lorsque l’importation de données charge les données dans Studio (classique), elle déduit le type de données de chaque colonne en fonction des valeurs qu’il contient, numérique ou catégorielle.

Si un en-tête est présent, il est utilisé pour nommer les colonnes du jeu de données de sortie.

S’il n’existe aucun en-tête de colonne dans les données, les nouveaux noms de colonnes sont générés au format col1, col2, ... ,coln.

Résultats

Lorsque l’importation est terminée, cliquez sur le jeu de données de sortie et sélectionnez Visualiser pour voir si les données ont bien été importées.

Si vous souhaitez enregistrer les données pour les réutiliser, plutôt que d’importer un nouveau jeu de données à chaque exécution de l’expérience, cliquez avec le bouton droit sur la sortie et sélectionnez Enregistrer comme dataset. Choisissez un nom pour le jeu de données. Le jeu de données enregistré conserve les données au moment de l’enregistrement et les données ne sont pas mises à jour lorsque l’expérience est réexécuter, même si le jeu de données dans l’expérience change. Cela peut être pratique pour prendre des captures instantanées de données.

Après l’importation des données, d’autres préparations seront peut-être nécessaires pour modélisation et l’analyse :

Générez des résumés statistiques des données, à l’aide de La synthèse des données ou des statistiques élémentaires de calcul.

Utilisez Modifier les métadonnées pour modifier les noms de colonnes, traiter une colonne comme un autre type de données, ou pour indiquer que certaines colonnes sont des étiquettes ou des fonctionnalités.

Utilisez Sélectionner des colonnes dans le jeu de données pour sélectionner un sous-ensemble de colonnes à transformer ou à utiliser dans la modélisation. Les colonnes transformées ou supprimées peuvent facilement être jointes au jeu de données d’origine à l’aide du module Ajouter des colonnes ou du module Joindre des données .

Utilisez Partition and Sample (Partition et échantillon) pour diviser le jeu de données, effectuer un échantillonnage ou obtenir les n premières lignes.

Utilisez Appliquer SQL Transformation pour agréger des données, filtrer ou transformer à l’aide d’instructions SQL.

Utilisez ces modules pour nettoyer les colonnes de texte et générer de nouvelles fonctionnalités de texte :

- Pré-traiter le texte

- Extraire les caractéristiques de N-grammes du texte

- Reconnaissance d’entité nommée

- Exécutez un script Python pour implémenter un NLP personnalisé basé sur nltk.

Notes techniques

Cette section fournit une liste des problèmes connus liés au module Importer des données , ainsi que certaines informations de dépannage générales non spécifiques à un type source.

Types de comptes pris en charge

Fréquemment, Azure publie de nouveaux services ou de nouveaux types de stockage ; Toutefois, il existe généralement un délai pendant que la prise en charge des nouveaux types de comptes est implémentée dans Machine Learning Studio (classique).

Actuellement, Machine Learning prend en charge tous les comptes de stockage à usage général, à l’exception de ceux qui utilisent un stockage redondant interzone (ZRS).

Les options de stockage localement redondant (LRS) et de stockage géoredondant sont prises en charge.

Les objets blob de blocs sont pris en charge, mais les objets blob d’ajout ne le sont pas.

Questions et problèmes courants

Cette section décrit certains problèmes connus, les questions courantes et les solutions de contournement.

Les en-têtes doivent être des lignes uniques

Si vous importez à partir de fichiers CSV, sachez que Machine Learning autorise une seule ligne d’en-tête. Vous ne pouvez pas insérer d’en-têtes multilignes.

Séparateurs personnalisés pris en charge lors de l’importation, mais pas de l’exportation

Le module Import Data prend en charge l’importation de données qui utilise d’autres séparateurs de colonnes, tels que le point-virgule (;), souvent utilisé en Europe. Lorsque vous importez des données à partir de fichiers CSV dans un stockage externe, sélectionnez le fichier CSV avec l’option encodages , puis choisissez un encodage pris en charge.

Toutefois, vous ne pouvez pas générer d’autres séparateurs lorsque vous préparez des données à exporter à l’aide du module Convertir en CSV .

Séparation médiocre des colonnes sur les données de chaîne contenant des virgules

À peu près tous les caractères qui peuvent être spécifiés en tant que séparateur de colonnes (onglets, espaces, virgules, etc.) peuvent également être trouvés de manière aléatoire dans les champs de texte. L’importation de texte à partir de CSV nécessite toujours une prudence pour éviter de séparer le texte entre de nouvelles colonnes inutiles. Il s’agit d’un problème courant dans le traitement de texte que vous avez probablement rencontré et traité de différentes façons.

Des problèmes peuvent également se produire lorsque vous essayez d’exporter une colonne de données de chaîne qui contient des virgules. Machine Learning ne prend pas en charge la gestion spéciale ou la traduction spéciale de ces données, telles que l’insertion de chaînes entre guillemets. En outre, vous ne pouvez pas utiliser de caractères d’échappement avant une virgule pour vous assurer que les virgules sont gérées comme un caractère littéral. Par conséquent, de nouveaux champs sont créés dans le fichier de sortie pour chaque virgule rencontrée dans le champ de chaîne.

Pour éviter des problèmes lors de l’exportation, utilisez le module De prétraitement de texte pour supprimer les caractères de ponctuation des champs de chaîne.

Vous pouvez également utiliser un script R personnalisé ou un script Python pour traiter du texte complexe et vous assurer que les données peuvent être importées ou exportées correctement.

Encodage UTF-8 requis

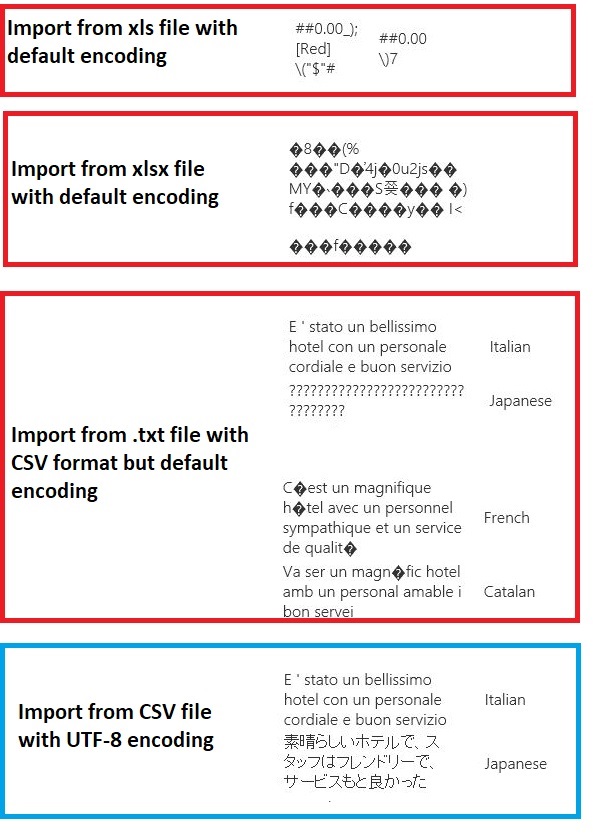

Machine Learning nécessite un encodage UTF-8. Si les données que vous importez utilisent un encodage différent ou ont été exportées à partir d’une source de données qui utilise un encodage par défaut différent, différents problèmes peuvent apparaître dans le texte.

Par exemple, l’image suivante contient le même jeu de données multi-anguage exporté à partir de Excel, puis importé dans Machine Learning sous quatre combinaisons différentes de type de fichier et d’encodage.

Le troisième exemple représente les données qui ont été perdues pendant l’enregistrement à partir de Excel au format CSV, car l’encodage correct n’a pas été spécifié à ce moment-là. Par conséquent, si vous rencontrez des problèmes, veillez à vérifier non seulement le fichier à partir duquel vous importez, mais si le fichier a été correctement exporté à partir de la source.

Le jeu de données n’a pas de noms de colonnes

Si le jeu de données que vous importez n’a pas de noms de colonnes, veillez à spécifier l’une des options « aucun en-tête ». Lorsque vous le faites, Import Data ajoute des noms de colonnes par défaut au format Col1, Col2, etc. Ensuite, utilisez Modifier les métadonnées pour corriger les noms des colonnes.

Si vous exportez un jeu de données dans un fichier CSV, utilisez Modifier les métadonnées pour ajouter des noms de colonnes avant de les convertir ou de les exporter.

Solutions de contournement pour les sources de données non prises en charge

Si vous avez besoin d’obtenir des données à partir d’une source qui n’est pas dans la liste, il existe différentes solutions de contournement que vous pouvez essayer :

Pour charger des données à partir d’un fichier sur votre ordinateur, cliquez sur Nouveau dans Studio (classique), sélectionnez Jeu de données, puis Sélectionnez À partir du fichier local. Recherchez le fichier et spécifiez le format (TSV, CSV, etc.). Pour plus d’informations, consultez Importer des données d’apprentissage dans Studio (classique).

Utilisez R ou Python. Vous pouvez utiliser le module Exécuter un script R avec un package R approprié pour obtenir des données à partir d’autres bases de données cloud.

Le module Exécuter un script Python vous permet également de lire et de convertir des données à partir de diverses sources. Consultez ces exemples de scientifiques des données Microsoft dans la galerie Cortana Intelligence :

Charger un fichier non texte à partir du stockage Blob Azure

Obtenir des données à partir de clusters AWS. Vous pouvez exécuter une requête sur un cluster Hive générique avec WebHCat ou un point de terminaison HCatalog activé. Vous pouvez également publier en tant que page et lire à partir de l’URL web.

Obtenir des données à partir de MongoDB. L’utilitaire de migration de données pour Azure Cosmos DB prend en charge un large éventail de sources et de formats. Pour plus d’informations et d’exemples, consultez Azure Cosmos DB : Outil de migration de données

Pour plus d’idées et de solutions de contournement, consultez le forum Machine Learning ou azure AI Gallery.

Paramètres du module

Chaque source de données doit être configurée à l’aide de différentes options. Ce tableau répertorie uniquement les options communes à toutes les sources de données.

| Nom | Plage | Type | Default | Description |

|---|---|---|---|---|

| Source de données | List | Source de données ou récepteur | Service BLOB dans Azure Storage | La source de données peut être HTTP, HTTPS anonyme, un fichier dans le service Blob ou le service Table, une base de données SQL dans Azure, un Azure SQL Data Warehouse, une table Hive ou un point de terminaison OData. |

| Utiliser les résultats mis en cache | TRUE/FALSE | Boolean | FALSE | Si la valeur est TRUE, le module vérifie si l’expérience s’exécute précédemment à l’aide des mêmes options d’entrée et si une exécution précédente est trouvée, les données du cache sont utilisées. Si la valeur est FALSE ou si des modifications sont trouvées, les données sont rechargées à partir de la source. |

Sorties

| Nom | Type | Description |

|---|---|---|

| Jeu de données de résultats | Table de données | Jeu de données avec des données téléchargées |

Exceptions

| Exception | Description |

|---|---|

| Erreur 0027 | Une exception se produit quand deux objets qui doivent avoir la même taille ne l'ont pas. |

| Erreur 0003 | Une exception se produit si une ou plusieurs entrées ont la valeur Null ou sont vides. |

| Erreur 0029 | Une exception se produit lorsqu'un URI non valide est passé. |

| Erreur 0030 | Une exception se produit lorsqu'il n'est pas possible de télécharger un fichier. |

| Erreur 0002 | Une exception se produit si un ou plusieurs paramètres n'ont pas pu être analysés ou convertis à partir du type spécifié dans le type requis par la méthode cible. |

| Erreur 0009 | Une exception se produit si le nom du compte de stockage Azure ou le nom du conteneur est spécifié de manière incorrecte. |

| Erreur 0048 | Une exception se produit quand il n'est pas possible d'ouvrir un fichier. |

| Erreur 0015 | Une exception se produit si la connexion à la base de données a échoué. |

| Erreur 0046 | Une exception se produit quand il n'est pas possible de créer un répertoire sur le chemin d'accès spécifié. |

| Erreur 0049 | Une exception se produit quand il n'est pas possible d'analyser un fichier. |

Pour obtenir la liste des erreurs spécifiques aux modules Studio (classique), consultez Machine Learning codes d’erreur.

Pour obtenir la liste des exceptions d’API, consultez Machine Learning codes d’erreur de l’API REST.

Voir aussi

Entrée et sortie de données

Conversion des formats de données

Exporter les données

Liste alphabétique des modules