Entrainement

Module

Mettre en œuvre la génération augmentée de récupération (RAG) avec Azure Databricks - Training

Mettre en œuvre la génération augmentée de récupération (RAG) avec Azure Databricks

Ce navigateur n’est plus pris en charge.

Effectuez une mise à niveau vers Microsoft Edge pour tirer parti des dernières fonctionnalités, des mises à jour de sécurité et du support technique.

Cet article décrit comment la génération augmentée par la recherche permet aux LLM de traiter vos sources de données comme des connaissances sans avoir à s'entraîner.

Les modules LLM ont des bases de connaissances étendues par le biais de la formation. Dans la plupart des cas, vous pouvez sélectionner un LLM conçu pour répondre à vos besoins, mais ces LLM nécessitent toujours une formation supplémentaire pour comprendre vos données spécifiques. La génération augmentée par récupération vous permet de rendre vos données disponibles pour les machines virtuelles LLM sans les entraîner en premier.

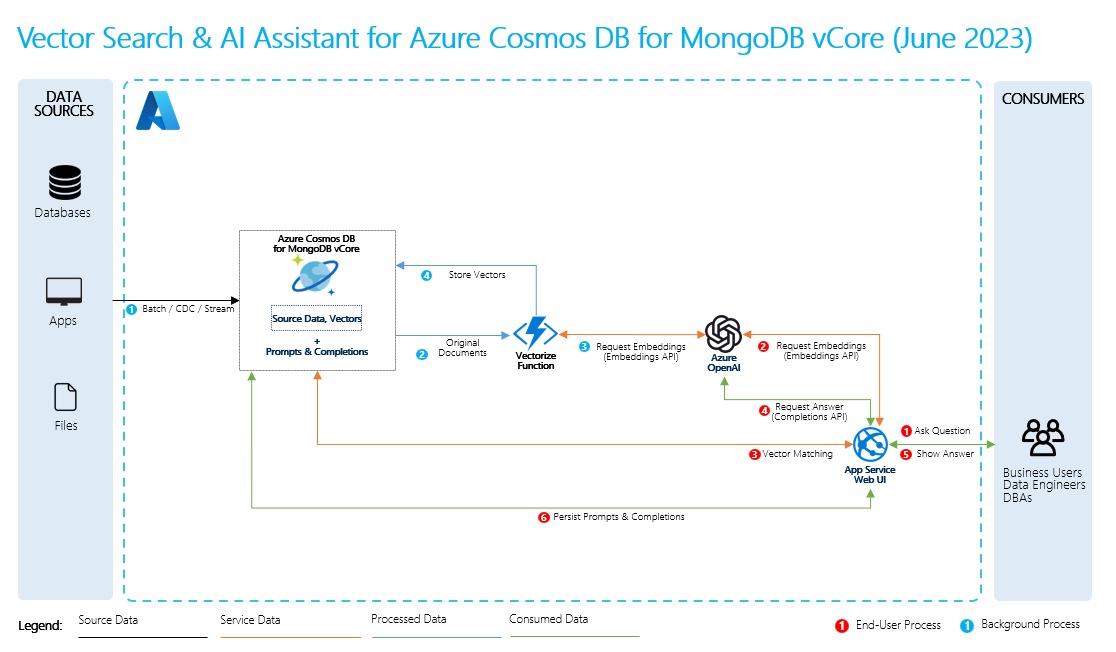

Pour effectuer une génération augmentée de récupération, vous créez des incorporations pour vos données, ainsi que des questions courantes sur celles-ci. Vous pouvez le faire à la volée ou vous pouvez créer et stocker les incorporations à l’aide d’une solution de base de données vectorielle.

Lorsqu’un utilisateur pose une question, le LLM utilise vos incorporations pour comparer la question de l’utilisateur à vos données et trouver le contexte le plus pertinent. Ce contexte et la question de l’utilisateur passent ensuite à LLM dans une invite, et le LLM fournit une réponse basée sur vos données.

Pour effectuer RAG, vous devez traiter chaque source de données que vous souhaitez utiliser pour les récupérations. Le processus de base est le suivant :

Commentaires sur .NET

.NET est un projet open source. Sélectionnez un lien pour fournir des commentaires :

Entrainement

Module

Mettre en œuvre la génération augmentée de récupération (RAG) avec Azure Databricks - Training

Mettre en œuvre la génération augmentée de récupération (RAG) avec Azure Databricks