Remarque

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

L’ingénierie des données dans Microsoft Fabric permet aux utilisateurs de concevoir, de créer et de gérer des infrastructures et des systèmes qui permettent à leurs organisations de collecter, stocker, traiter et analyser de grands volumes de données.

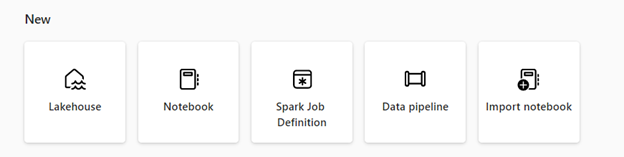

Microsoft Fabric fournit diverses fonctionnalités d’ingénierie des données pour vous assurer que vos données sont facilement accessibles, bien organisées et de haute qualité. Pour accéder à la page d’accueil de l’ingénierie des données, sélectionnez charges de travail dans le volet de navigation, puis sélectionnez la vignette Data Engineering. À partir de la page d’accueil de l’ingénierie des données, vous pouvez :

Créez et gérez vos données à l'aide d'un lac de données (lakehouse)

Concevoir des pipelines pour copier des données dans votre instance de lakehouse

Utiliser les définitions de travaux Spark pour envoyer un travail de traitement par lots/streaming au cluster Spark

Utiliser des notebooks pour écrire du code pour l’ingestion, la préparation et la transformation des données

Lakehouse

Les lakehouses sont des architectures de données qui permettent aux organisations de stocker et de gérer des données structurées et non structurées dans un emplacement unique, à l’aide de différents outils et infrastructures pour traiter et analyser ces données. Ces outils et infrastructures peuvent inclure des requêtes et des analyses BASÉEs sur SQL, ainsi que le Machine Learning et d’autres techniques d’analyse avancées.

Définition de la tâche Apache Spark

Les définitions de travaux Spark sont un ensemble d’instructions qui définissent comment exécuter un travail sur un cluster Spark. Il inclut des informations telles que les sources de données d’entrée et de sortie, les transformations et les paramètres de configuration de l’application Spark. La définition de travail Spark vous permet d’envoyer un travail de traitement par lots/streaming à un cluster Spark, d’appliquer une logique de transformation différente aux données hébergées sur votre lakehouse, ainsi que de nombreuses autres choses.

Carnet de notes

Les notebooks sont un environnement informatique interactif qui permet aux utilisateurs de créer et de partager des documents contenant du code en direct, des équations, des visualisations et du texte narratif. Ils permettent aux utilisateurs d’écrire et d’exécuter du code dans différents langages de programmation, notamment Python, R et Scala. Vous pouvez utiliser des blocs-notes pour l'ingestion des données, la préparation, l'analyse et d'autres tâches liées aux données.

Pipeline

Les pipelines sont une série d’étapes qui peuvent collecter, traiter et transformer des données de sa forme brute en un format que vous pouvez utiliser pour l’analyse et la prise de décision. Ils sont un composant essentiel de l’ingénierie des données, car ils fournissent un moyen de déplacer des données de sa source vers sa destination de manière fiable, évolutive et efficace.

Vous pouvez utiliser l’ingénierie des données dans Microsoft Fabric gratuitement lorsque vous vous inscrivez à la version d’évaluation Fabric. Vous pouvez également acheter une capacité Microsoft Fabric ou une capacité réservée de Fabric

Contenu connexe

Prise en main de l’ingénierie des données :

- Pour en savoir plus sur les lakehouses, consultez Qu’est-ce qu’un lakehouse dans Microsoft Fabric ?

- Pour commencer à utiliser un lakehouse, consultez Créer un lakehouse dans Microsoft Fabric.

- Pour en savoir plus sur les définitions de travaux Apache Spark, consultez Qu’est-ce qu’une définition de travail Apache Spark ?

- Pour commencer à utiliser une définition de travail Apache Spark, consultez Comment créer une définition de travail Apache Spark dans Fabric.

- Pour en savoir plus sur les notebooks, consultez Créer et exécuter le notebook.

- Pour démarrer avec l'activité de copie de pipeline, consultez Comment copier des données à l'aide de l'activité de copie.