Comment accéder aux sources de données locales dans Data Factory pour Microsoft Fabric

Data Factory pour Microsoft Fabric est un service d’intégration de données basé sur le cloud puissant qui vous permet de créer, planifier et gérer des flux de travail pour différentes sources de données. Dans les scénarios où vos sources de données se trouvent localement, Microsoft fournit la passerelle de données locale pour combler en toute sécurité l’écart entre votre environnement local et le cloud. Ce document vous guide tout au long du processus d’accès aux sources de données locales dans Data Factory pour Microsoft Fabric à l’aide de la passerelle de données locale.

Créer une passerelle de données locale

Une passerelle de données locale est une application logicielle conçue pour être installée dans un environnement réseau local. Il fournit un moyen d’installer directement la passerelle sur votre ordinateur local. Pour obtenir des instructions détaillées sur le téléchargement et l’installation de la passerelle de données locale, reportez-vous à Installer une passerelle de données locale.

Connectez-vous à l’aide de votre compte d’utilisateur pour accéder à la passerelle de données locale, après quoi elle sera préparée pour l’utilisation.

Remarque

Une passerelle de données locale d'une version supérieure ou égale à 3000.214.2 est nécessaire pour prendre en charge les pipelines Fabric.

Créer une connexion pour votre source de données locale

Accédez au portail d’administration et sélectionnez le bouton paramètres (une icône qui ressemble à un engrenage) en haut à droite de la page. Dans le menu déroulant qui s’affiche, choisissez ensuite Gérer les connexions et les passerelles.

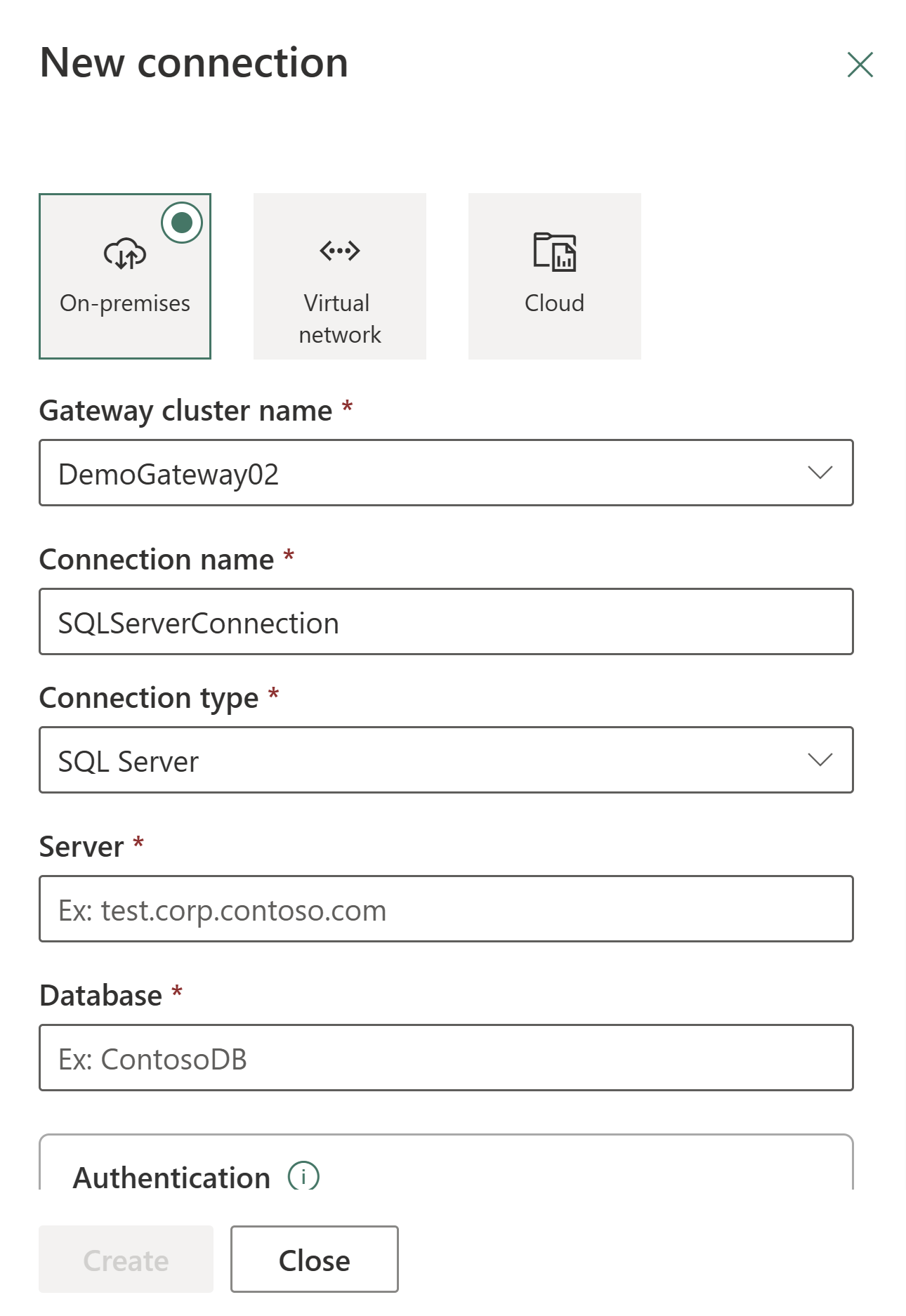

Dans la boîte de dialogue Nouvelle connexion qui s’affiche, sélectionnez local, puis fournissez votre cluster de passerelle, ainsi que le type de ressource associé et les informations pertinentes.

Les types de connexions disponibles pris en charge pour les connexions locales incluent :

- Entra ID

- Adobe Analytics

- Analysis Services

- Stockage Blob Azure

- Azure Data Lake Storage Gen2

- Azure Table Storage

- Essbase

- File

- Dossier

- Google Analytics

- IBM DB2

- MySQL

- OData

- ODBC

- OLE DB

- Oracle

- PostgreSQL

- Salesforce

- Serveur de messages SAP Business Warehouse

- Serveur SAP Business Warehouse

- SAP HANA

- SharePoint

- SQL Server

- Sybase

- Teradata

- web

Pour obtenir la liste complète des connecteurs pris en charge pour les types de données locaux, reportez-vous à Connecteurs de pipeline de données dans Microsoft Fabric.

Connecter votre source de données locale à un Dataflow Gen2 dans Data Factory pour Microsoft Fabric

Accédez à votre espace de travail et créez un Dataflow Gen2.

Ajoutez une nouvelle source au flux de données et sélectionnez la connexion établie à l’étape précédente.

Vous pouvez utiliser Dataflow Gen2 pour effectuer toutes les transformations de données nécessaires en fonction de vos besoins.

Utilisez le bouton Ajouter une destination de données sous l’onglet Accueil de l’éditeur Power Query pour ajouter une destination pour vos données à partir de la source locale.

Publiez Dataflow Gen2.

Vous avez créé un Dataflow Gen2 pour charger des données à partir d’une source de données locale dans une destination cloud.

Utilisation de données locales dans un pipeline

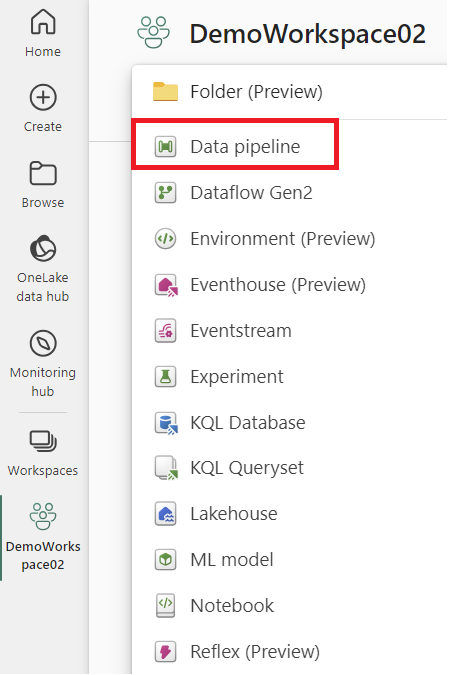

Accédez à votre espace de travail et créez un pipeline de données.

Remarque

Vous devez configurer le pare-feu pour autoriser les connexions sortantes *.frontend.clouddatahub.net à partir de la passerelle pour les fonctionnalités du pipeline Fabric.

Sous l’onglet Accueil de Pipeline editor, sélectionnez Copier des données, puis Utilisez l’assistant de copie. Ajoutez une nouvelle source à l’activité dans la page de l’Assistant Choisir la source de données, puis sélectionnez la connexion établie lors de l’étape précédente.

Sélectionnez une destination pour vos données à partir de la source de données locale.

Exécutez le pipeline.

À présent, vous avez créé et exécuté un pipeline pour charger des données à partir d’une source de données locale dans une destination cloud.

Remarque

L’accès local à l’ordinateur avec la passerelle de données locale installée n’est pas autorisé dans les pipelines de données.