Vue d’ensemble des connecteurs

Data Factory dans Microsoft Fabric propose un riche ensemble de connecteurs qui vous permettent de vous connecter à différents types de magasins de données. Vous pouvez tirer parti de ces connecteurs pour transformer des données en flux de données ou déplacer un ensemble de données de niveau PB à grande échelle dans un pipeline de données.

Prérequis

Avant de pouvoir configurer une connexion dans Dataflow Gen2 ou un pipeline de données, les conditions préalables suivantes sont requises :

Un compte de locataire Microsoft Fabric avec un abonnement actif. Créez un compte gratuitement.

Un espace de travail compatible avec Microsoft Fabric. Créez un espace de travail.

Connecteurs de données pris en charge dans les flux de données

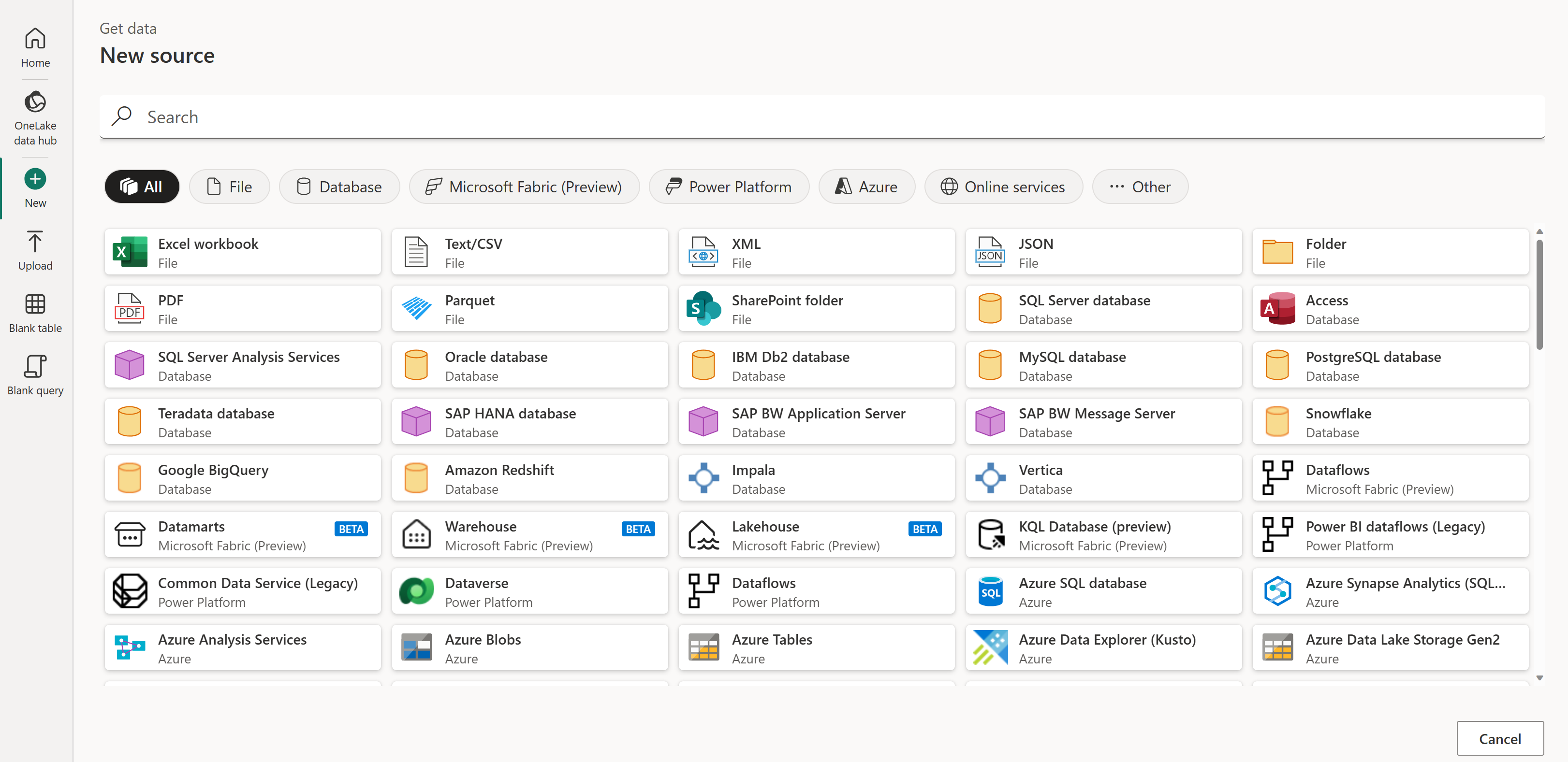

Dataflow Gen2 offre des capacités d’ingestion et de transformation des données sur un large éventail de sources de données. Ces sources de données incluent divers types de fichiers, de bases de données, de sources de données en ligne, dans le cloud et sur site. Il existe plus de 145 connecteurs de données différents, qui sont accessibles à partir de l'expérience de création de flux de données dans l'expérience d'obtention de données.

Pour obtenir la liste complète de tous les connecteurs de données actuellement pris en charge, accédez aux Connecteurs Dataflow Gen2 dans Microsoft Fabric.

Les connecteurs suivants sont actuellement disponibles pour les destinations de sortie dans Dataflow Gen2 :

- Explorateur de données Azure

- Azure SQL

- entrepôt de données

- Lakehouse

Magasins de données pris en charge dans le pipeline de données

Data Factory dans Microsoft Fabric prend en charge les magasins de données dans un pipeline de données via les activités Copier, Rechercher, Obtenir des métadonnées, Supprimer, Script et Procédure stockée. Pour obtenir la liste de tous les connecteurs de données actuellement pris en charge, accédez aux Connecteurs de pipeline de données dans Microsoft Fabric.

Remarque

Actuellement, un pipeline sur VNET managé et un accès aux données locales avec une passerelle ne sont pas pris en charge dans Data Factory pour Microsoft Fabric.

Contenu connexe

Commentaires

Bientôt disponible : Tout au long de 2024, nous allons supprimer progressivement GitHub Issues comme mécanisme de commentaires pour le contenu et le remplacer par un nouveau système de commentaires. Pour plus d’informations, consultez https://aka.ms/ContentUserFeedback.

Envoyer et afficher des commentaires pour