Notes

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Ce module prend environ 10 minutes. Vous allez ingérer des données brutes de la source de données dans une table dans la couche de données bronze d'un Data Lakehouse à l'aide de l'activité de copie dans un pipeline de données.

Les étapes générales du module 1 sont les suivantes :

- Créez un pipeline de données.

- Créez une activité de copie dans le pipeline pour charger des exemples de données dans un data Lakehouse.

- Exécuter et afficher les résultats de l’activité de copie

Conditions préalables

- Un compte de locataire Microsoft Fabric avec un abonnement actif. Si vous n’en avez pas, vous pouvez créer un compte gratuit.

- Un espace de travail compatible avec Microsoft Fabric. Découvrez comment créer un espace de travail.

- Accès à Power BI.

Créer un pipeline de données

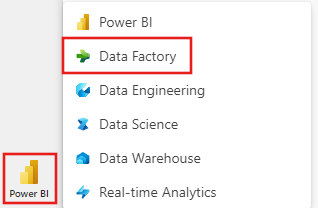

Connectez-vous à Power BI.

Sélectionnez l’icône Power BI par défaut en bas à gauche de l’écran, puis sélectionnez Fabric.

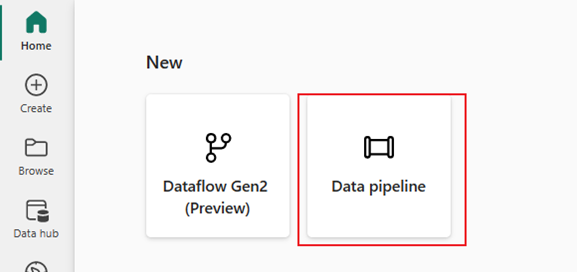

Sélectionnez un espace de travail sous l’onglet Espaces de travail, puis sélectionnez + Nouvel élément, puis choisissez pipeline de données.

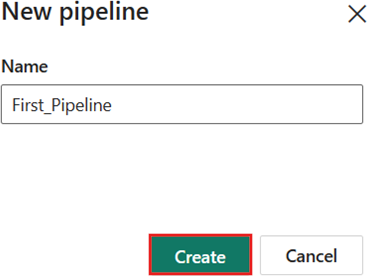

Fournissez un nom de pipeline. Sélectionnez ensuite Créer.

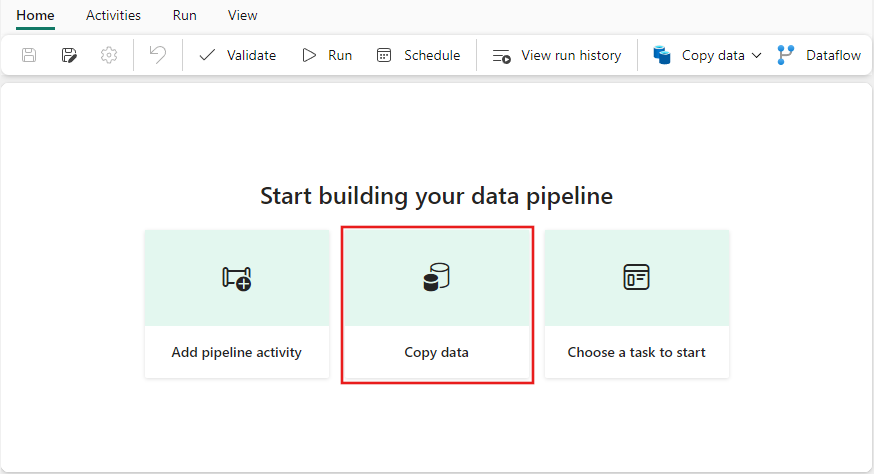

Créer une activité de copie dans le pipeline pour charger des exemples de données dans un data Lakehouse

Sélectionnez Assistant de copie de données pour ouvrir l’outil de l’assistant de copie.

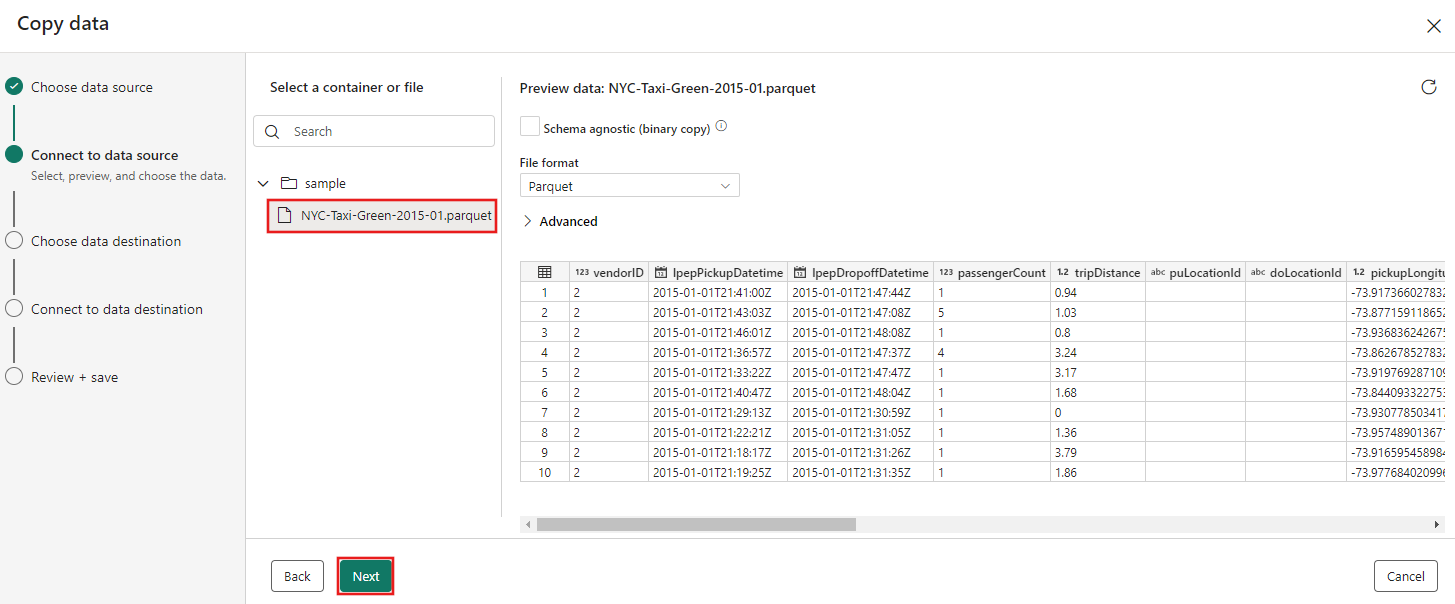

Dans la page Choisir une source de données , sélectionnez Exemples de données dans les options situées en haut de la boîte de dialogue, puis sélectionnez NyC Taxi - Vert.

L’aperçu de la source de données apparaît ensuite sur la page Se connecter à la source de données. Révisez, puis sélectionnez suivant.

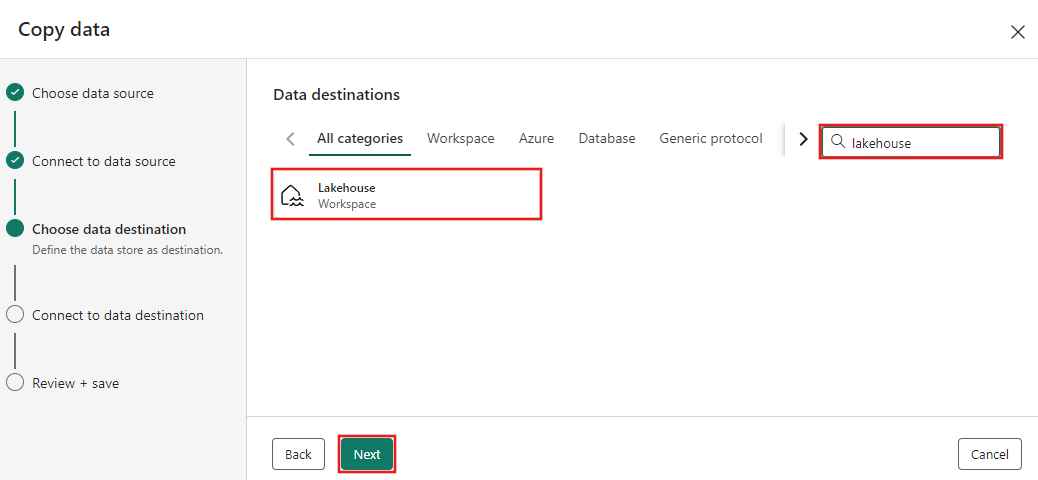

Pour l’étape Choisir la destination des données de l’Assistant copie, sélectionnez Lakehouse.

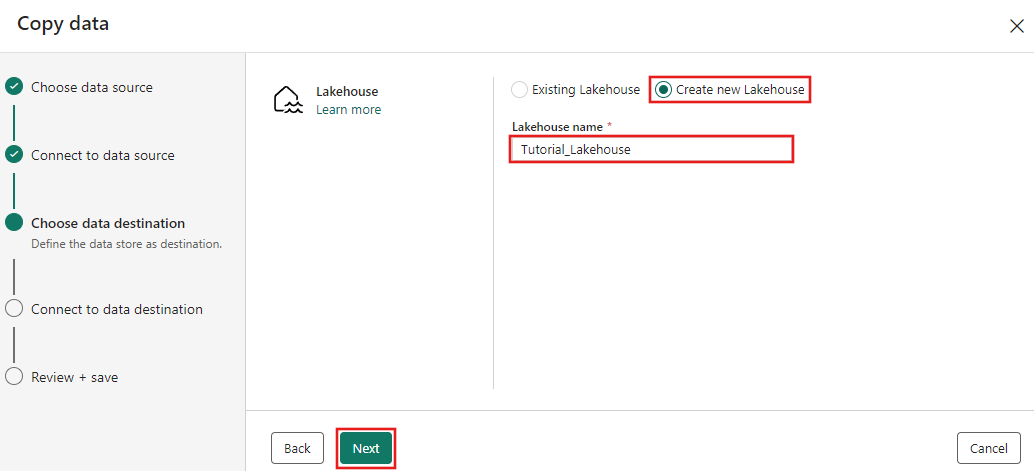

Entrez un nom Lakehouse, puis sélectionnez Créer et se connecter.

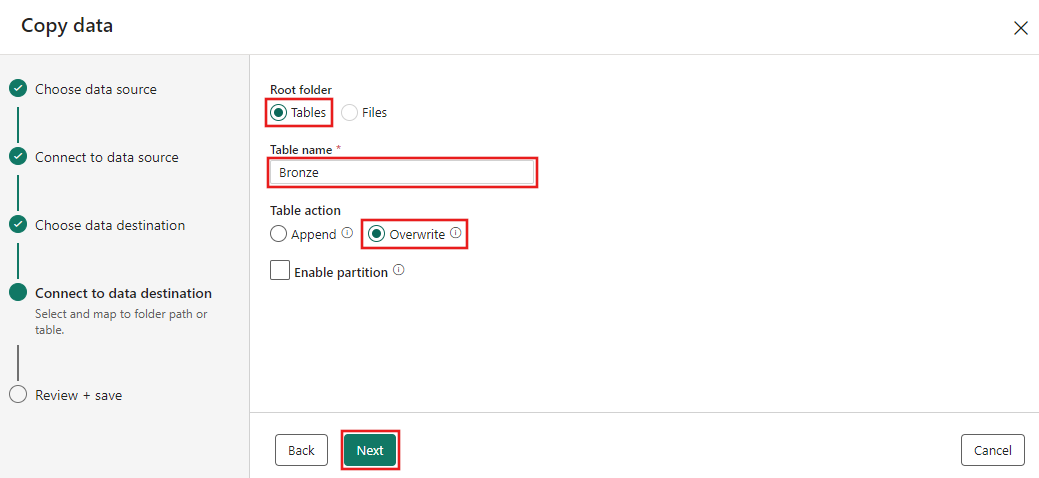

Sélectionnez Tables pour le dossier racine et chargez-les vers une nouvelle table pour les paramètres de chargement. Fournissez un nom de table (dans notre exemple, nous l’avons nommé Bronze) et sélectionnez Suivant.

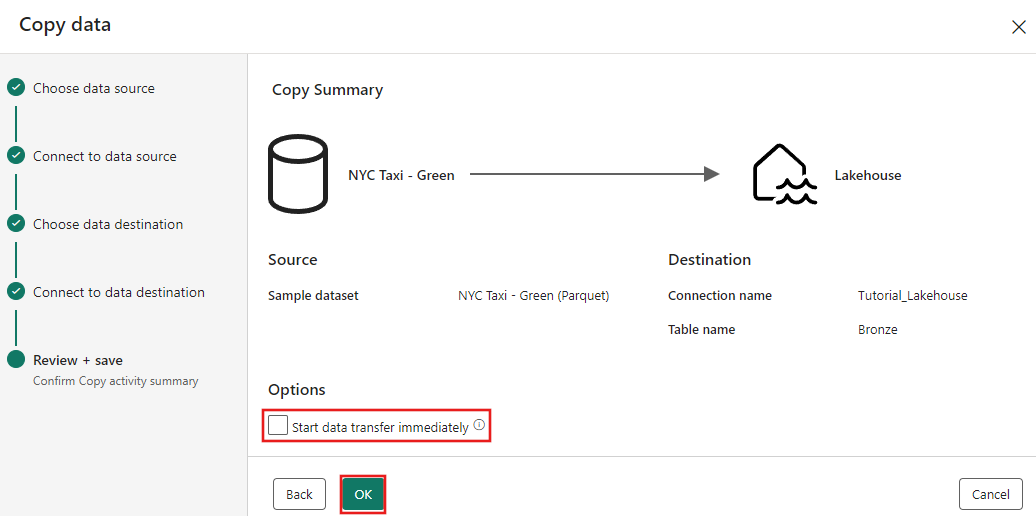

Enfin, dans la page Vérifier + enregistrer de l’assistant de copie des données, passez en revue la configuration. Pour ce didacticiel, décochez la case à cocher Démarrer le transfert des données immédiatement, car nous exécutons l’opération manuellement à l’étape suivante. Sélectionnez ensuite OK.

Exécuter et afficher les résultats de votre activité de copie

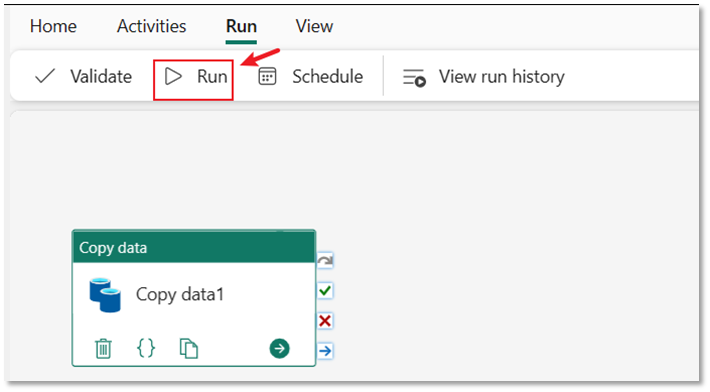

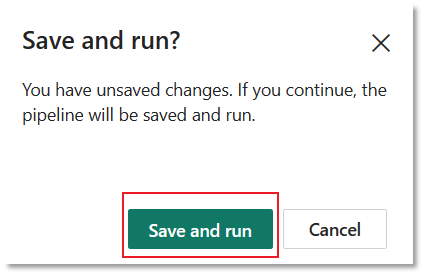

Sélectionnez l’onglet Exécuter dans l’éditeur de pipeline. Sélectionnez ensuite le bouton Exécuter , puis Enregistrez et exécutez pour exécuter l’activité Copier.

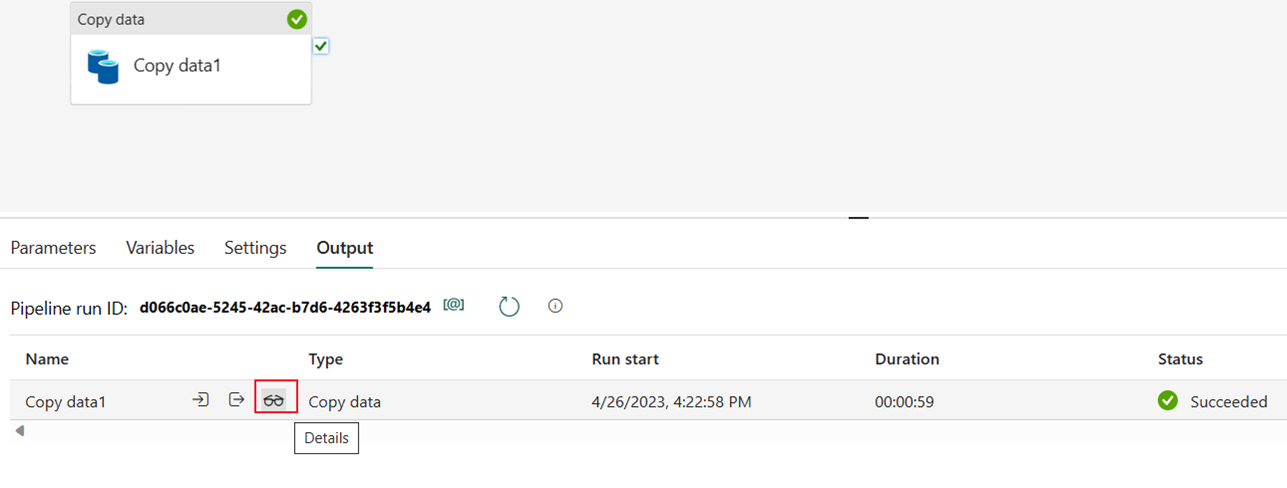

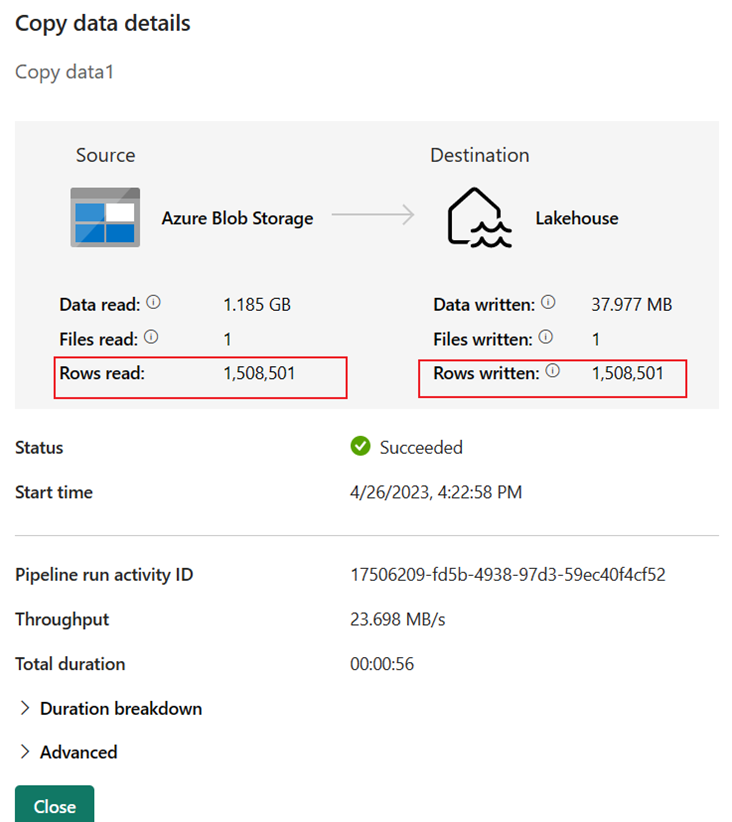

Vous pouvez superviser l’exécution, puis vérifier les résultats sous l’onglet Sortie sous le canevas du pipeline. Sélectionnez le nom du pipeline pour afficher les détails de l’exécution.

Les détails de l’exécution montrent 1 508 501 lignes lues et écrites.

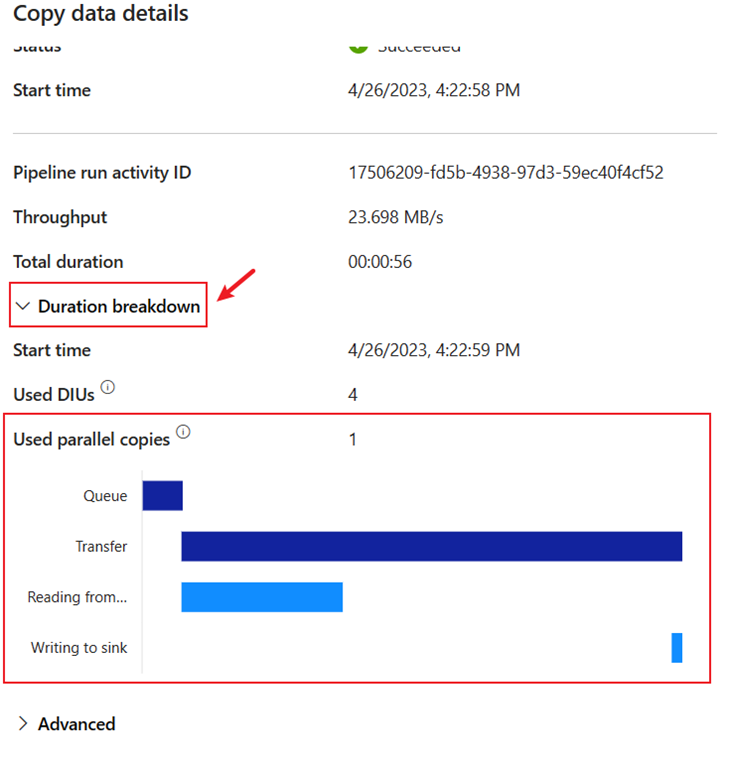

Développez la section Répartition des durées pour afficher la durée de chaque étape de l’activité Copy. Après avoir examiné les détails de la copie, sélectionnez Fermer.

Étape suivante

Passez à la section suivante pour créer votre dataflow.