Évaluer et comparer des modèles

Une fois qu’une expérience de Machine Learning automatisé (AutoML) est terminée, vous pouvez passer en revue les modèles qui ont été entraînés et déterminer celui qui a le mieux fonctionné.

Dans Azure Machine Learning studio, vous pouvez sélectionner une expérience AutoML pour en explorer les détails.

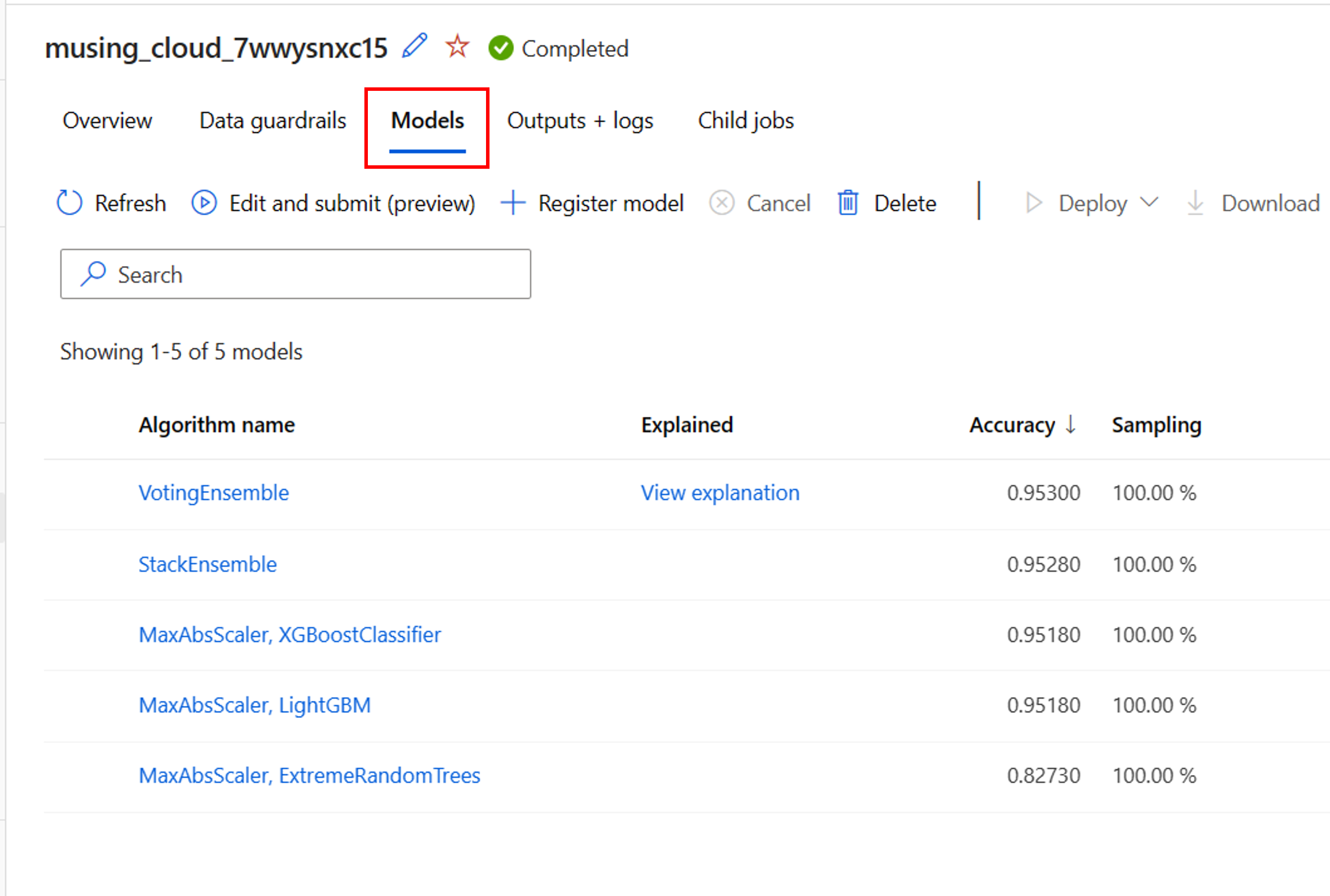

Dans la page Vue d’ensemble de l’exécution de l’expérience AutoML, vous pouvez passer en revue la ressource de données d’entrée et la synthèse du meilleur modèle. Pour explorer tous les modèles qui ont été entraînés, vous pouvez sélectionner l’onglet Modèles :

Explorer les étapes de prétraitement

Lorsque vous avez activé la caractérisation pour votre expérience AutoML, des garde-fous de données sont automatiquement appliqués. Les trois garde-fous de données pris en charge pour les modèles de classification sont les suivants :

- Détection de l’équilibrage des classes

- Imputation des valeurs de caractéristique manquantes

- Détection des caractéristiques à cardinalité élevée

Chacun de ces garde-fous de données affiche l’un des trois états possibles :

- Réussite : aucun problème de données n’a été détecté et aucune action n’est requise.

- Terminé : des modifications ont été appliquées à vos données. Vous devez passer en revue les modifications qu’AutoML a apportées à vos données.

- Alerté : un problème a été détecté, mais il n’a pas pu être résolu. Vous devez examiner les données pour résoudre le problème.

En plus des garde-fous de données, AutoML peut appliquer des techniques de mise à l’échelle et de normalisation à chaque modèle entraîné. Vous pouvez passer en revue la technique appliquée dans la liste des modèles sous Nom de l’algorithme.

Par exemple, le nom de l’algorithme d’un modèle listé peut être MaxAbsScaler, LightGBM. MaxAbsScaler fait référence à une technique de mise à l’échelle où chaque caractéristique est mise à l’échelle d’après sa valeur absolue maximale. LightGBM fait référence à l’algorithme de classification utilisé pour entraîner le modèle.

Récupérer la meilleure exécution et son modèle

Lorsque vous examinez les modèles dans AutoML, vous pouvez facilement identifier la meilleure exécution en fonction de la métrique principale que vous avez spécifiée. Dans Azure Machine Learning studio, les modèles sont automatiquement triés de façon à afficher le modèle le plus performant en haut.

Sous l’onglet Modèles de l’expérience AutoML, vous pouvez modifier les colonnes si vous souhaitez afficher d’autres métriques dans la même vue d’ensemble. En créant une vue d’ensemble plus complète qui inclut diverses métriques, il peut être plus facile de comparer des modèles.

Pour explorer encore davantage un modèle, vous pouvez générer des explications pour chaque modèle qui a été entraîné. Lors de la configuration d’une expérience AutoML, vous pouvez spécifier que des explications doivent être générées pour le modèle le plus performant. Si toutefois vous êtes intéressé par l’interprétabilité d’un autre modèle, vous pouvez sélectionner le modèle dans la vue d’ensemble, puis sélectionner Expliquer le modèle.

Notes

L’explication d’un modèle est une approximation de l’interprétabilité du modèle. Plus précisément, les explications permettent d’estimer l’importance relative des caractéristiques sur la caractéristique cible (ce que le modèle est entraîné à prédire). Apprenez-en davantage sur l’interprétabilité des modèles.

Conseil

Apprenez-en davantage sur la façon d’évaluer des exécutions AutoML.