A Hive Catalog használata az Apache Flinktel® a HDInsighton az AKS-en

Feljegyzés

2025. január 31-én kivonjuk az Azure HDInsightot az AKS-ből. 2025. január 31-ig át kell telepítenie a számítási feladatokat a Microsoft Fabricbe vagy egy azzal egyenértékű Azure-termékbe, hogy elkerülje a számítási feladatok hirtelen leállítását. Az előfizetés többi fürtje le lesz állítva, és el lesz távolítva a gazdagépről.

Fontos

Ez a szolgáltatás jelenleg előzetes kiadásban elérhető. A Microsoft Azure Előzetes verzió kiegészítő használati feltételei további jogi feltételeket tartalmaznak, amelyek a bétaverzióban, előzetes verzióban vagy egyébként még nem általánosan elérhető Azure-funkciókra vonatkoznak. Erről az adott előzetes verzióról az Azure HDInsight az AKS előzetes verziójában tájékozódhat. Ha kérdése vagy funkciójavaslata van, küldjön egy kérést az AskHDInsightban a részletekkel együtt, és kövessen minket további frissítésekért az Azure HDInsight-közösségről.

Ez a példa a Hive Metastore-t használja állandó katalógusként az Apache Flink Hive-katalógusával. Ezt a funkciót a Kafka-tábla és a MySQL-tábla metaadatainak tárolására használjuk a munkamenetek közötti Flinken. A Flink forrásként a Hive-katalógusban regisztrált Kafka-táblát használja, keresési és fogadó eredményeket hajt végre a MySQL-adatbázisban

Előfeltételek

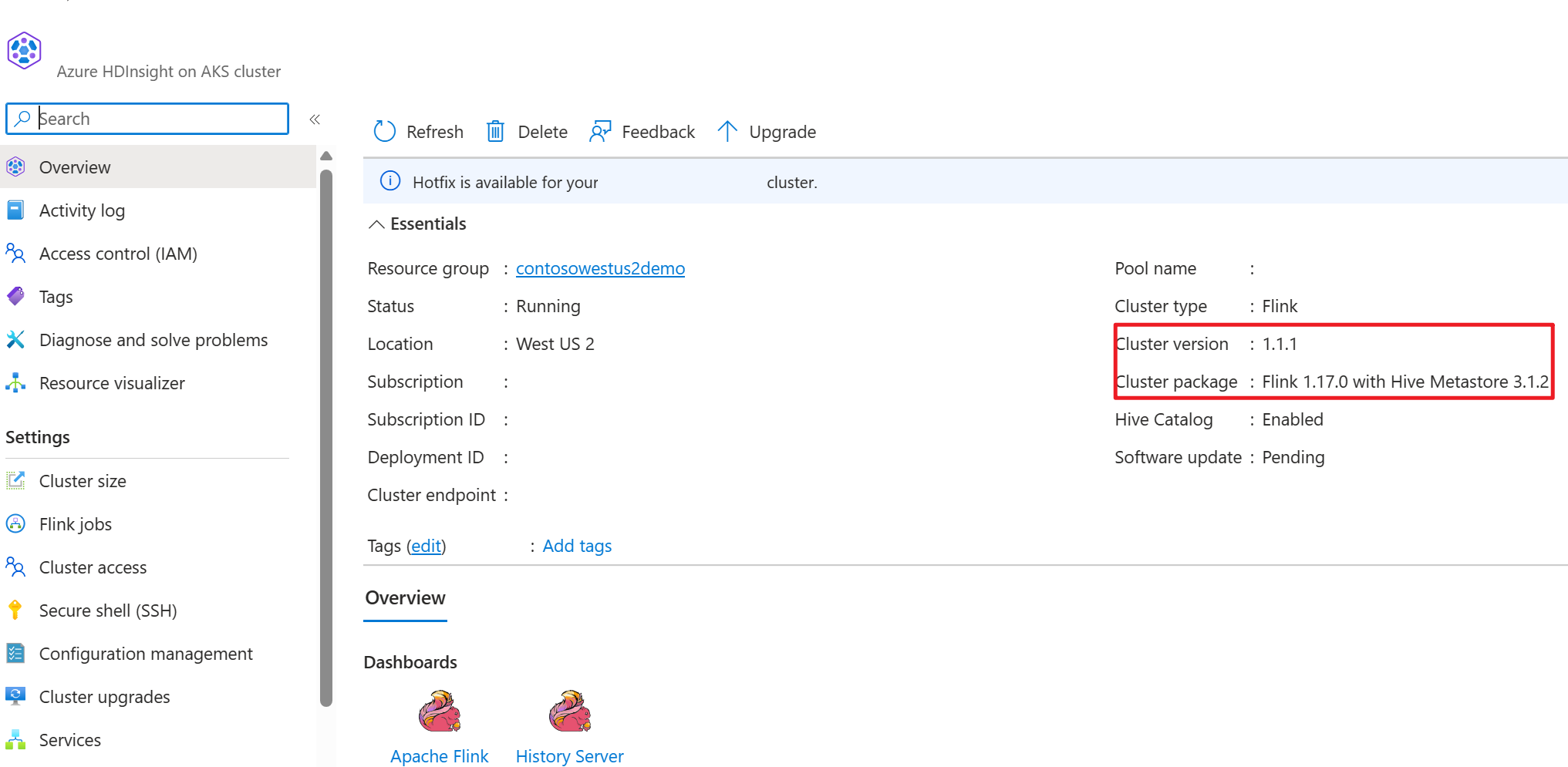

- Apache Flink Cluster on HDInsight on AKS with Hive Metastore 3.1.2

- Apache Kafka-fürt a HDInsighton

- Győződjön meg arról, hogy a hálózati beállítások teljesek a Kafka használatával kapcsolatban leírtak szerint. Ez azt jelzi, hogy az AKS-en és a HDInsight-fürtökön található HDInsight ugyanazon a virtuális hálózaton található-e.

- MySQL 8.0.33

Apache Hive az Apache Flinken

A Flink kétirányú integrációt kínál a Hive-vel.

- Az első lépés a Hive Metastore (HMS) állandó katalógusként való használata az Flink HiveCatalogjával a munkamenetek közötti Flink-specifikus metaadatok tárolásához.

- A felhasználók például a HiveCatalog használatával tárolhatják a Kafka- vagy ElasticSearch-tábláikat a Hive Metastore-ban, és később újra felhasználhatják őket az SQL-lekérdezésekben.

- A második az Flink alternatív motorként való felajánlása Hive-táblák olvasásához és írásához.

- A HiveCatalog úgy lett kialakítva, hogy "kívülről" kompatibilis legyen a meglévő Hive-telepítésekkel. Nem kell módosítania a meglévő Hive-metaadattárat, és nem kell módosítania a táblák adatelhelyezését vagy particionálását.

További információ: Apache Hive

Környezet előkészítése

Apache Flink-fürt létrehozása HMS-sel

Lehetővé teszi apache Flink-fürt létrehozását HMS-sel az Azure Portalon. A Flink-fürt létrehozásának részletes utasításait itt találja.

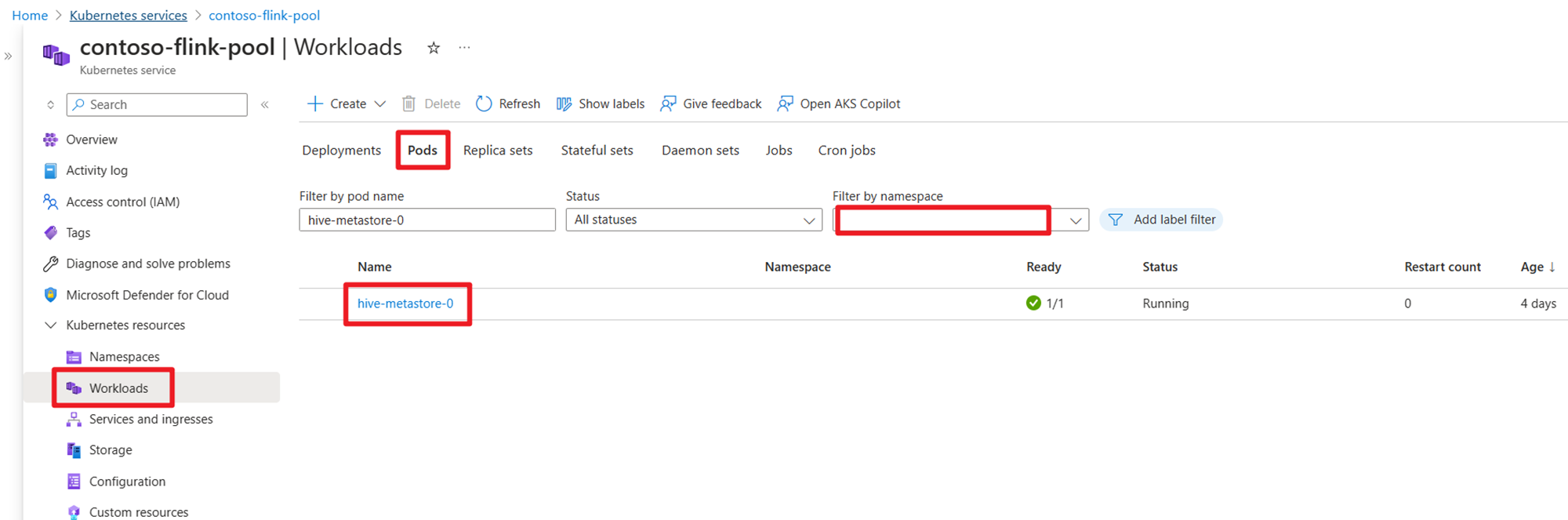

A fürt létrehozása után ellenőrizze, hogy a HMS fut-e vagy sem az AKS oldalán.

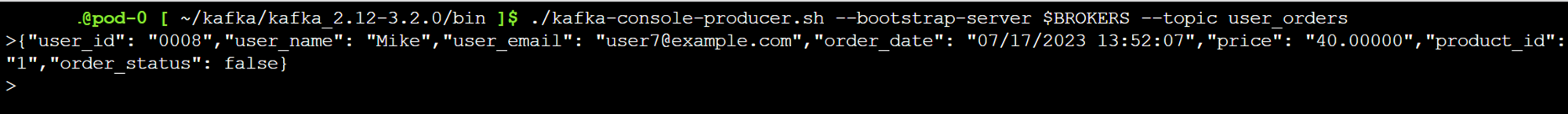

Felhasználói rendelés tranzakciós adatainak előkészítése Kafka-témakör a HDInsightban

Töltse le a kafka-ügyfél jart a következő paranccsal:

wget https://archive.apache.org/dist/kafka/3.2.0/kafka_2.12-3.2.0.tgz

A tárfájl leválasztása a következővel:

tar -xvf kafka_2.12-3.2.0.tgz

Hozza létre az üzeneteket a Kafka-témakörbe.

Egyéb parancsok:

Feljegyzés

A bootstrap-kiszolgálót le kell cserélnie a saját kafka brokers gazdagépnevére vagy IP-címére

--- delete topic

./kafka-topics.sh --delete --topic user_orders --bootstrap-server wn0-contsk:9092

--- create topic

./kafka-topics.sh --create --replication-factor 2 --partitions 3 --topic user_orders --bootstrap-server wn0-contsk:9092

--- produce topic

./kafka-console-producer.sh --bootstrap-server wn0-contsk:9092 --topic user_orders

--- consumer topic

./kafka-console-consumer.sh --bootstrap-server wn0-contsk:9092 --topic user_orders --from-beginning

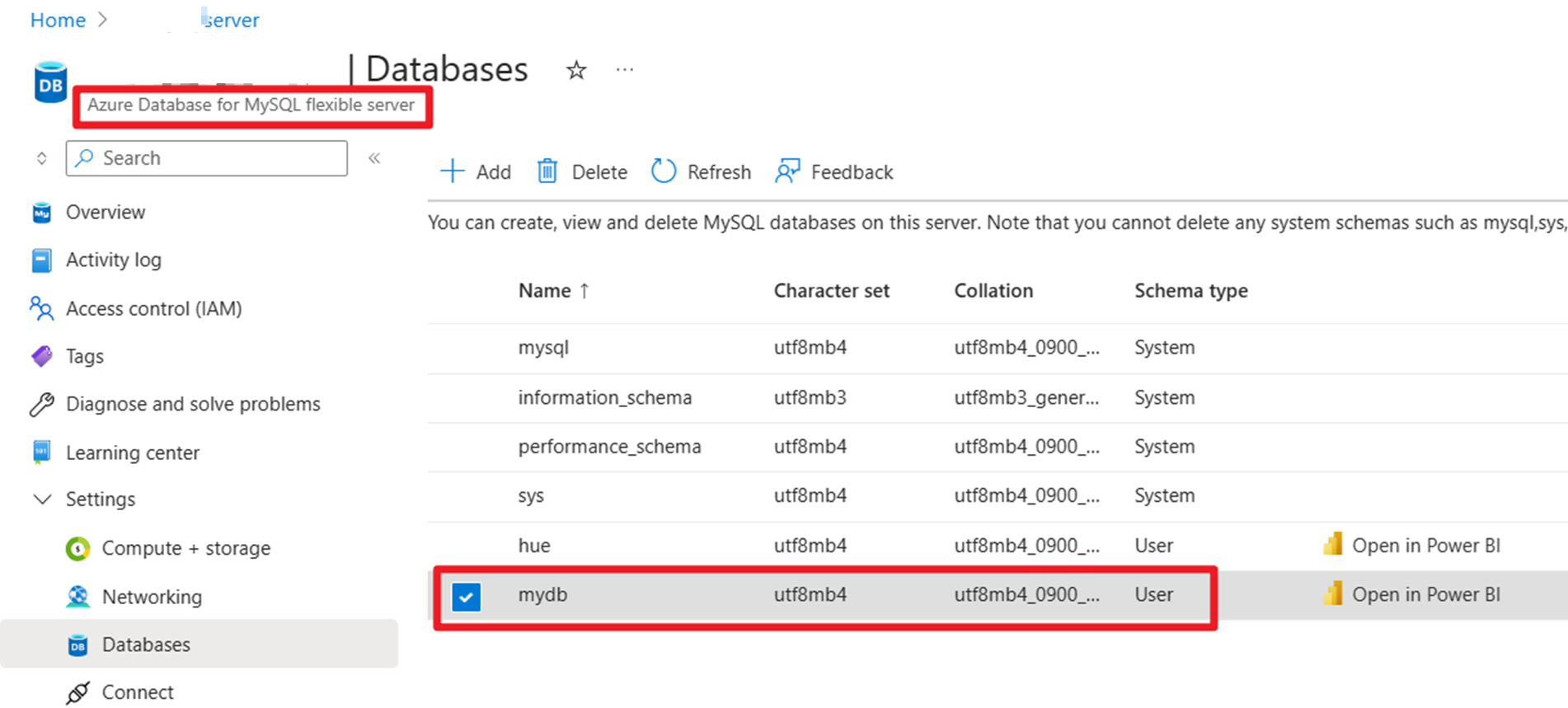

Felhasználói rendelések főadatainak előkészítése az Azure-on futó MySQL-en

Tesztelési adatbázis:

A rendelési tábla előkészítése:

mysql> use mydb

Reading table information for completion of table and column names

You can turn off this feature to get a quicker startup with -A

mysql> CREATE TABLE orders (

order_id INTEGER NOT NULL AUTO_INCREMENT PRIMARY KEY,

order_date DATETIME NOT NULL,

customer_id INTEGER NOT NULL,

customer_name VARCHAR(255) NOT NULL,

price DECIMAL(10, 5) NOT NULL,

product_id INTEGER NOT NULL,

order_status BOOLEAN NOT NULL

) AUTO_INCREMENT = 10001;

mysql> INSERT INTO orders

VALUES (default, '2023-07-16 10:08:22','0001', 'Jark', 50.00, 102, false),

(default, '2023-07-16 10:11:09','0002', 'Sally', 15.00, 105, false),

(default, '2023-07-16 10:11:09','000', 'Sally', 25.00, 105, false),

(default, '2023-07-16 10:11:09','0004', 'Sally', 45.00, 105, false),

(default, '2023-07-16 10:11:09','0005', 'Sally', 35.00, 105, false),

(default, '2023-07-16 12:00:30','0006', 'Edward', 90.00, 106, false);

mysql> select * from orders;

+----------+---------------------+-------------+---------------+----------+------------+--------------+

| order_id | order_date | customer_id | customer_name | price | product_id | order_status |

+----------+---------------------+-------------+---------------+----------+------------+--------------+

| 10001 | 2023-07-16 10:08:22 | 1 | Jark | 50.00000 | 102 | 0 |

| 10002 | 2023-07-16 10:11:09 | 2 | Sally | 15.00000 | 105 | 0 |

| 10003 | 2023-07-16 10:11:09 | 3 | Sally | 25.00000 | 105 | 0 |

| 10004 | 2023-07-16 10:11:09 | 4 | Sally | 45.00000 | 105 | 0 |

| 10005 | 2023-07-16 10:11:09 | 5 | Sally | 35.00000 | 105 | 0 |

| 10006 | 2023-07-16 12:00:30 | 6 | Edward | 90.00000 | 106 | 0 |

+----------+---------------------+-------------+---------------+----------+------------+--------------+

6 rows in set (0.22 sec)

mysql> desc orders;

+---------------+---------------+------+-----+---------+----------------+

| Field | Type | Null | Key | Default | Extra |

+---------------+---------------+------+-----+---------+----------------+

| order_id | int | NO | PRI | NULL | auto_increment |

| order_date | datetime | NO | | NULL | |

| customer_id | int | NO | | NULL | |

| customer_name | varchar(255) | NO | | NULL | |

| price | decimal(10,5) | NO | | NULL | |

| product_id | int | NO | | NULL | |

| order_status | tinyint(1) | NO | | NULL | |

+---------------+---------------+------+-----+---------+----------------+

7 rows in set (0.22 sec)

Az SSH-letöltéshez szükséges Kafka-összekötő és MySQL-adatbázis jarok használata

Feljegyzés

Töltse le a megfelelő verzió jart a HDInsight kafka és a MySQL verziónak megfelelően.

wget https://repo1.maven.org/maven2/org/apache/flink/flink-connector-jdbc/3.1.0-1.17/flink-connector-jdbc-3.1.0-1.17.jar

wget https://repo1.maven.org/maven2/com/mysql/mysql-connector-j/8.0.33/mysql-connector-j-8.0.33.jar

wget https://repo1.maven.org/maven2/org/apache/kafka/kafka-clients/3.2.0/kafka-clients-3.2.0.jar

wget https://repo1.maven.org/maven2/org/apache/flink/flink-connector-kafka/1.17.0/flink-connector-kafka-1.17.0.jar

A planner jar áthelyezése

A jar flink-table-planner_2.12-1.17.0-.... jar található webssh pod /opt to /lib és lépjen ki a jar flink-table-planner-loader1.17.0-.... jar /opt/flink-webssh/opt/ from /lib. További részletekért tekintse meg a problémát . A planner jar áthelyezéséhez hajtsa végre az alábbi lépéseket.

mv /opt/flink-webssh/lib/flink-table-planner-loader-1.17.0-*.*.*.*.jar /opt/flink-webssh/opt/

mv /opt/flink-webssh/opt/flink-table-planner_2.12-1.17.0-*.*.*.*.jar /opt/flink-webssh/lib/

Feljegyzés

Egy extra planner jar áthelyezésre csak Hive dialect vagy HiveServer2 végpont használatakor van szükség. Ez azonban a Hive-integráció ajánlott beállítása.

Érvényesítés

A bin/sql-client.sh használata az Flink SQL-hez való csatlakozáshoz

bin/sql-client.sh -j flink-connector-jdbc-3.1.0-1.17.jar -j mysql-connector-j-8.0.33.jar -j kafka-clients-3.2.0.jar -j flink-connector-kafka-1.17.0.jar

Hive-katalógus létrehozása és csatlakozás a hive-katalógushoz az Flink SQL-en

Feljegyzés

Mivel az Flink-fürtöt már használjuk a Hive Metastore-nal, nincs szükség további konfigurációk végrehajtására.

CREATE CATALOG myhive WITH (

'type' = 'hive'

);

USE CATALOG myhive;

Kafka-tábla létrehozása Apache Flink SQL-en

CREATE TABLE kafka_user_orders (

`user_id` BIGINT,

`user_name` STRING,

`user_email` STRING,

`order_date` TIMESTAMP(3) METADATA FROM 'timestamp',

`price` DECIMAL(10,5),

`product_id` BIGINT,

`order_status` BOOLEAN

) WITH (

'connector' = 'kafka',

'topic' = 'user_orders',

'scan.startup.mode' = 'latest-offset',

'properties.bootstrap.servers' = '10.0.0.38:9092,10.0.0.39:9092,10.0.0.40:9092',

'format' = 'json'

);

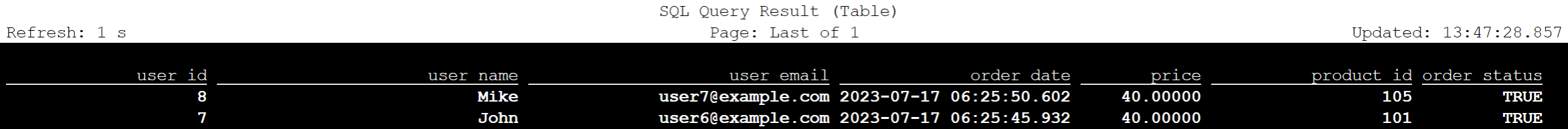

select * from kafka_user_orders;

MySQL-tábla létrehozása az Apache Flink SQL-en

CREATE TABLE mysql_user_orders (

`order_id` INT,

`order_date` TIMESTAMP,

`customer_id` INT,

`customer_name` STRING,

`price` DECIMAL(10,5),

`product_id` INT,

`order_status` BOOLEAN

) WITH (

'connector' = 'jdbc',

'url' = 'jdbc:mysql://<servername>.mysql.database.azure.com/mydb',

'table-name' = 'orders',

'username' = '<username>',

'password' = '<password>'

);

select * from mysql_user_orders;

A Flink SQL-en a Hive-katalógus felett regisztrált táblák ellenőrzése

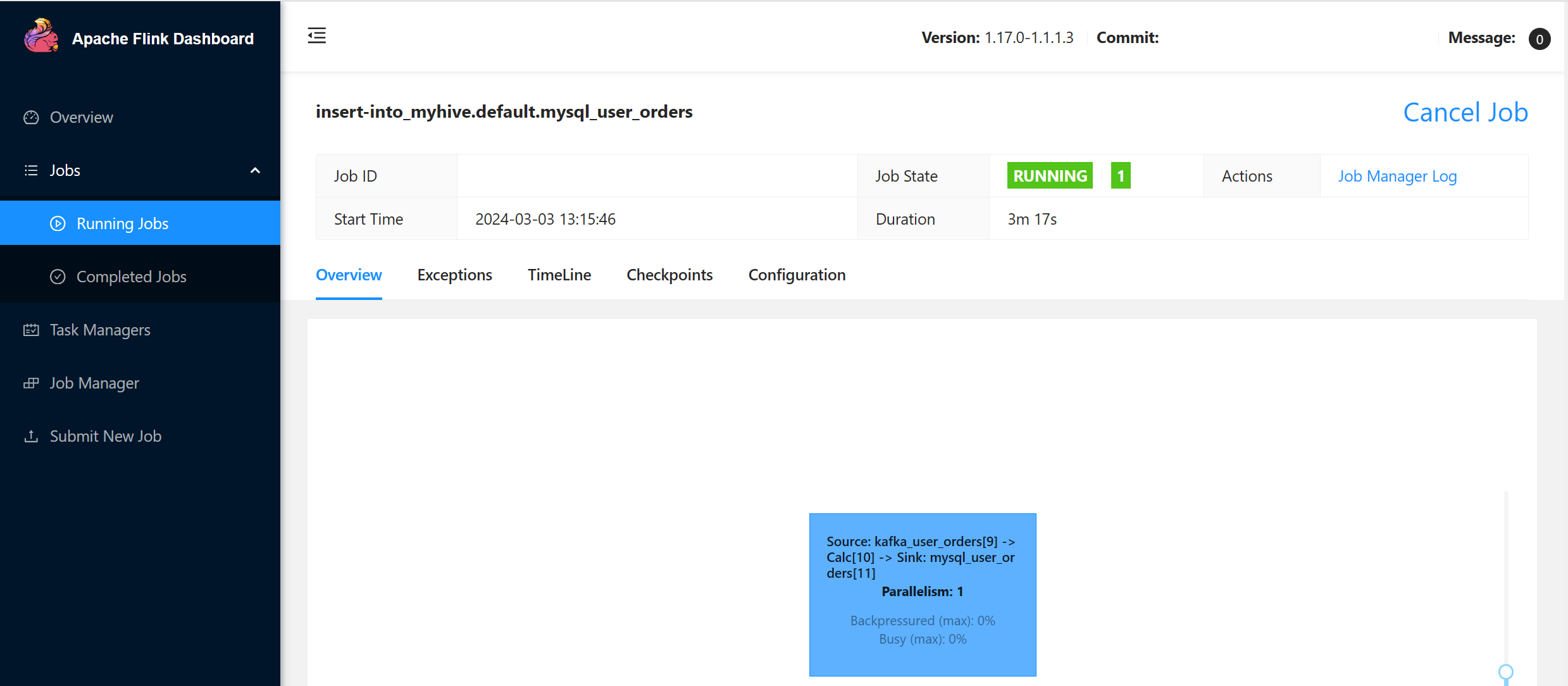

Felhasználói tranzakciós rendelés adatainak fogadója a master order táblába a MySQL-ben az Flink SQL-en

INSERT INTO mysql_user_orders (order_date, customer_id, customer_name, price, product_id, order_status)

SELECT order_date, CAST(user_id AS INT), user_name, price, CAST(product_id AS INT), order_status

FROM kafka_user_orders;

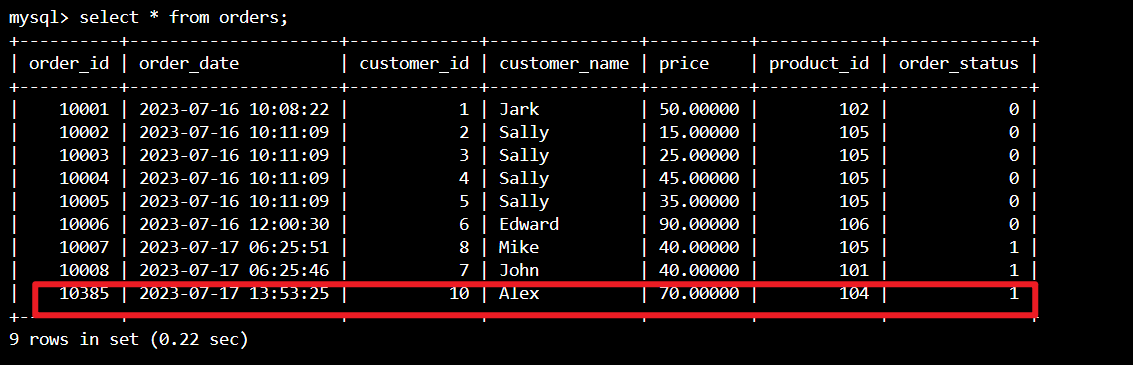

Ellenőrizze, hogy a Kafka felhasználói tranzakciós rendelési adatai hozzá lesznek-e adva a master table orderhez az Azure Cloud Shell mySQL-ben

További három felhasználói rendelés létrehozása a Kafkán

sshuser@hn0-contsk:~$ /usr/hdp/current/kafka-broker/bin/kafka-console-producer.sh --bootstrap-server wn0-contsk:9092 --topic user_orders

>{"user_id": null,"user_name": "Lucy","user_email": "user8@example.com","order_date": "07/17/2023 21:33:44","price": "90.00000","product_id": "102","order_status": false}

>{"user_id": "0009","user_name": "Zark","user_email": "user9@example.com","order_date": "07/17/2023 21:52:07","price": "80.00000","product_id": "103","order_status": true}

>{"user_id": "0010","user_name": "Alex","user_email": "user10@example.com","order_date": "07/17/2023 21:52:07","price": "70.00000","product_id": "104","order_status": true}

Kafka-táblaadatok ellenőrzése flink SQL-en

Flink SQL> select * from kafka_user_orders;

Beszúrás product_id=104 a Rendelések táblába a MySQL-ben a Flink SQL-en

INSERT INTO mysql_user_orders (order_date, customer_id, customer_name, price, product_id, order_status)

SELECT order_date, CAST(user_id AS INT), user_name, price, CAST(product_id AS INT), order_status

FROM kafka_user_orders where product_id = 104;

A product_id = 104 rendszer hozzáadja a rekordot a rendelési táblához az Azure Cloud Shellen futó MySQL-en

Referencia

- Apache Hive

- Az Apache, az Apache Hive, a Hive, az Apache Flink, a Flink és a társított nyílt forráskód projektnevek az Apache Software Foundation (ASF) védjegyei.