Adatok feldolgozása a peremhálózaton az Azure IoT-adatfeldolgozó előzetes verziójának folyamataival

Fontos

Az Azure IoT Operations Előzetes verziója – az Azure Arc által engedélyezett verzió jelenleg előzetes verzióban érhető el. Ezt az előzetes verziójú szoftvert nem szabad éles környezetben használni.

A bétaverziójú, előzetes verziójú vagy másként még általánosan nem elérhető Azure-szolgáltatások jogi feltételeit lásd: Kiegészítő használati feltételek a Microsoft Azure előzetes verziójú termékeihez.

Az ipari eszközök számos különböző formátumban hoznak létre adatokat, és különböző kommunikációs protokollokat használnak. Az adatforrások sokfélesége, valamint a különböző sémák és egységmunkák megnehezítik a nyers ipari adatok hatékony használatát és elemzését. Emellett megfelelőségi, biztonsági és teljesítménybeli okokból nem tölthet fel minden adathalmazt a felhőbe.

Az adatok hagyományos feldolgozásához költséges, összetett és időigényes adatfeldolgozásra van szükség. Az Azure IoT Data Processor Preview egy konfigurálható adatfeldolgozási szolgáltatás, amely képes kezelni az ipari adatok összetettségét és sokféleségét. Az Adatfeldolgozóval érthetőbbé, használhatóbbá és értékesebbé teheti a különböző forrásokból származó adatokat.

Mi az Azure IoT Data Processor Preview?

Az Azure IoT Data Processor Preview az Azure IoT Operations Preview egyik összetevője. Az adatfeldolgozó lehetővé teszi az adatok összesítését, bővítését, normalizálását és szűrését az eszközeiről. Az adatfeldolgozó egy folyamatalapú adatfeldolgozási motor, amely lehetővé teszi az adatok feldolgozását a peremhálózaton, mielőtt elküldené azokat a többi szolgáltatásnak a peremhálózaton vagy a felhőben:

Az adatfeldolgozó valós idejű streamelési adatokat tárol olyan forrásokból, mint az OPC UA-kiszolgálók, a történészek és más ipari rendszerek. Normalizálja ezeket az adatokat azáltal, hogy különböző adatformátumokat szabványosított, strukturált formátummá alakít át, ami megkönnyíti a lekérdezést és az elemzést. Az adatfeldolgozó emellett kontextusba helyezheti az adatokat, és referenciaadatokkal vagy utolsó ismert értékekkel (LKV) bővítheti azokat, hogy átfogó képet nyújtson az ipari műveletekről.

Az adatfeldolgozó kimenete tiszta, gazdagított és szabványosított adatok, amelyek készen állnak az alsóbb rétegbeli alkalmazásokra, például a valós idejű elemzési és elemzési eszközökre. Az adatfeldolgozó jelentősen csökkenti a nyers adatok végrehajtható megállapításokká alakításához szükséges időt.

Az adatfeldolgozó legfontosabb funkciói a következők:

Rugalmas adatnormalizálás több adatformátum szabványosított struktúrává alakításához.

Az adatfolyamok kibővítése referencia- vagy LKV-adatokkal a környezet javítása és jobb elemzések lehetővé tétele érdekében.

A Microsoft Fabric beépített integrációja leegyszerűsíti a tiszta adatok elemzését.

Különböző forrásokból származó adatok feldolgozásának és az adatok közzétételének lehetősége különböző célhelyeken.

Adatelemzési adatfeldolgozó platformként az adatfeldolgozó bármilyen formátumban betöltheti az adatokat, feldolgozhatja az adatokat, majd kiírhatja egy célhelyre. Ezeknek a képességeknek a támogatásához az adatfeldolgozó különböző formátumokat deszerializálhat és szerializálhat. Szerializálhatja például a parquetet, hogy fájlokat írjon a Microsoft Fabricbe.

Automatikus és konfigurálható újrapróbálkozási szabályzatok az átmeneti hibák kezeléséhez, amikor adatokat küldenek a felhőbeli célhelyekre.

Mik azok a folyamatok?

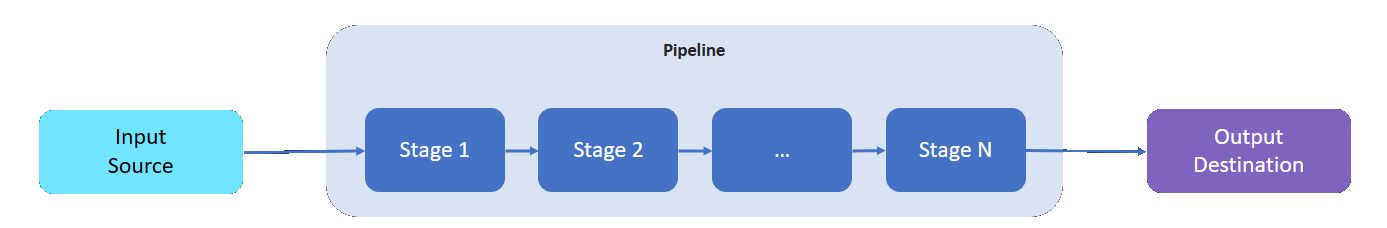

Az adatfeldolgozó folyamat olyan bemeneti forrással rendelkezik, amelyből adatokat olvas be, egy célhelyet, ahová a feldolgozott adatokat írja, valamint változó számú köztes szakaszt az adatok feldolgozásához.

A köztes szakaszok a rendelkezésre álló adatfeldolgozási képességeket jelölik:

- A folyamathoz annyi köztes szakaszt adhat hozzá, amennyi szükséges.

- Igény szerint megrendelheti a folyamat köztes szakaszait. A folyamat létrehozása után átrendezheti a fázisokat.

- Minden fázis egy meghatározott implementációs felülethez és bemeneti/kimeneti sémaszerződéshez igazodik.

- Minden fázis független a folyamat többi szakaszától.

- Minden fázis egy partíció hatókörén belül működik. Az adatok nincsenek megosztva a különböző partíciók között.

- Az adatok csak az egyik fázisból a következőbe áramlik.

Az adatfeldolgozó folyamatok a következő fázisokat használhatják:

| Szakasz | Leírás |

|---|---|

| Forrás – MQ | Adatokat kér le egy MQTT-közvetítőtől. |

| Forrás – HTTP-végpont | Adatokat kér le EGY HTTP-végpontról. |

| Forrás – SQL | Adatokat kér le egy Microsoft SQL Server-adatbázisból. |

| Forrás – InfluxDB | Adatokat kér le egy InfluxDB-adatbázisból. |

| Szűrő | Szűri a szakaszon áthaladó adatokat. Szűrjön ki például a tartományon kívüli 50F-150F hőmérsékletű üzeneteket. |

| Átalakítani | Normalizálja az adatok szerkezetét. Például módosítsa a struktúrát a következőre {"Name": "Temp", "value": 50}{"temp": 50}: . |

| LKV | A kiválasztott metrikaértékeket egy LKV-tárolóban tárolja. Például csak a hőmérséklet- és páratartalomméréseket tárolja az LKV-ban, hagyja figyelmen kívül a többit. Egy későbbi szakasz bővítheti az üzeneteket a tárolt LKV-adatokkal. |

| Gazdagítani | A referenciaadattárból származó adatokkal bővíti az üzeneteket. Adjon hozzá például egy operátornevet és egy tételszámot a műveleti adatkészletből. |

| Összesített | Összesíti a szakaszon áthaladó értékeket. Ha például a hőmérsékleti értékeket 100 ezredmásodpercenként küldi el, 30 másodpercenként átlagos hőmérsékleti metrikát bocsát ki. |

| Hívás | Külső HTTP- vagy gRPC-szolgáltatás hívását kezdeményezi. Meghívhat például egy Azure-függvényt az egyéni üzenetformátumból JSON-ra való konvertáláshoz. |

| Cél – MQ | A feldolgozott, tiszta és környezetfüggő adatokat egy MQTT-témakörbe írja. |

| Cél – Referencia | A feldolgozott adatokat a beépített referenciatárba írja. Más folyamatok a referenciatár használatával bővíthetik üzeneteiket. |

| Cél – gRPC | A feldolgozott, tiszta és környezetfüggő adatokat elküldi egy gRPC-végpontnak. |

| Cél – HTTP | A feldolgozott, tiszta és környezetfüggő adatokat elküldi egy HTTP-végpontnak. |

| Cél - Fabric Lakehouse | A feldolgozott, tiszta és környezetfüggő adatokat a felhőben található Microsoft Fabric lakehouse-ba küldi. |

| Cél – Azure Data Explorer | A feldolgozott, tiszta és környezetfüggő adatokat elküldi a felhőben található Azure Data Explorer-végpontnak. |

| Cél – Azure Blob Storage | A feldolgozott, tiszta és környezetfüggő adatokat elküldi a felhőben található Azure Blob Storage-végpontnak. |

Következő lépés

Az adatfeldolgozó folyamatok kipróbálásához tekintse meg az Azure IoT Operations rövid útmutatóit.

Az adatfeldolgozóval kapcsolatos további információkért lásd: