Mi a felelős AI?

ÉRVÉNYES: Azure CLI ml-bővítmény v2 (aktuális)

Azure CLI ml-bővítmény v2 (aktuális) Python SDK azure-ai-ml v2 (aktuális)

Python SDK azure-ai-ml v2 (aktuális)

A felelősségteljes mesterséges intelligencia (Responsible AI) az AI-rendszerek biztonságos, megbízható és etikus fejlesztésének, értékelésének és üzembe helyezésének megközelítése. Az AI-rendszerek számos olyan döntés terméke, amelyet azok hoztak, akik fejlesztik és üzembe helyezik őket. A rendszer céljától a mesterséges intelligenciával való interakcióig a felelős AI segíthet proaktív módon irányítani ezeket a döntéseket a előnyösebb és méltányosabb eredmények felé. Ez azt jelenti, hogy az emberek és céljaik a rendszertervezési döntések középpontjában maradnak, és tiszteletben tartják az olyan tartós értékeket, mint a méltányosság, a megbízhatóság és az átláthatóság.

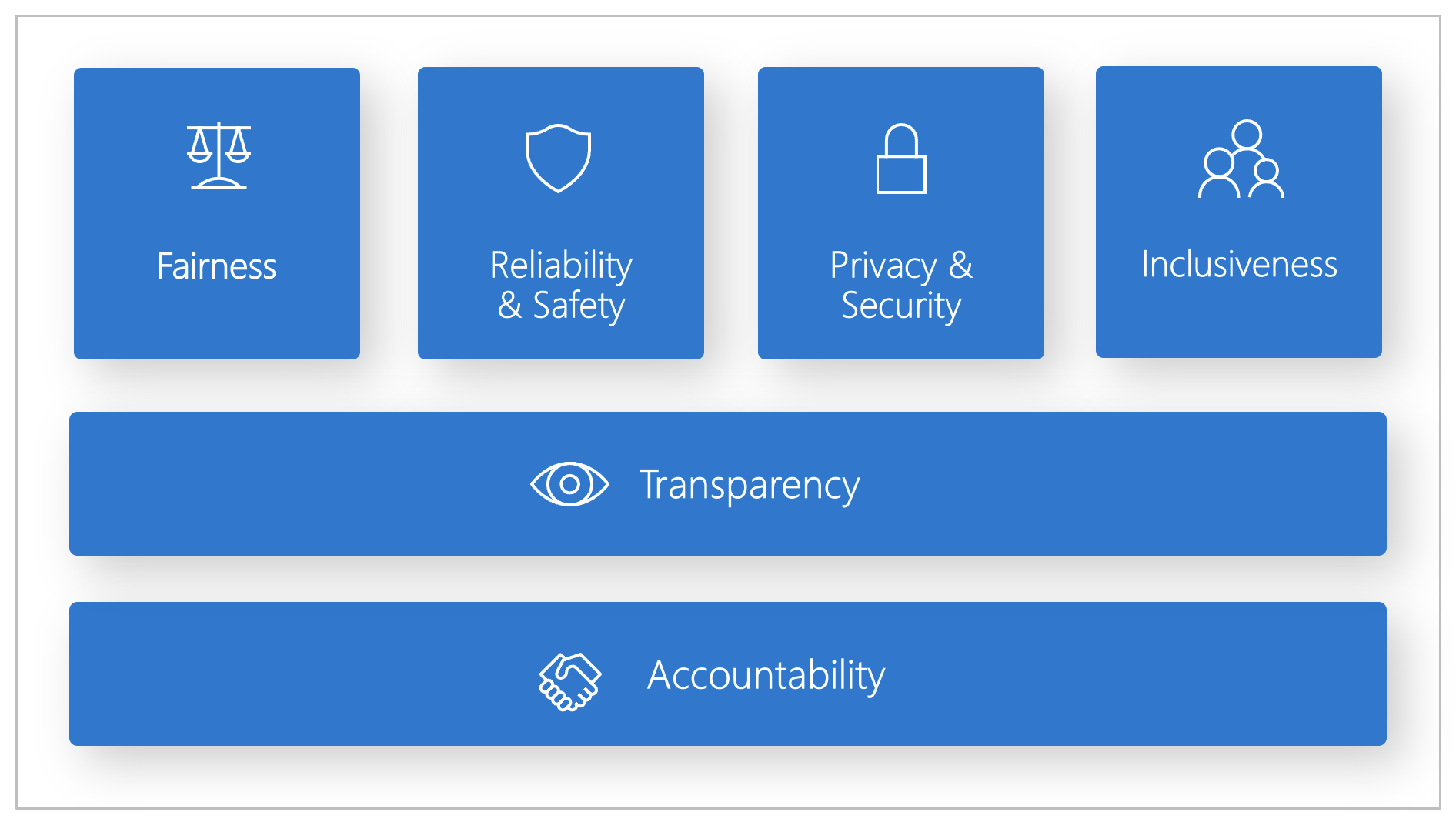

A Microsoft kifejlesztett egy Felelős AI Standardot. Ez egy keretrendszer az AI-rendszerek hat alapelv szerint történő kiépítéséhez: méltányosság, megbízhatóság és biztonság, adatvédelem és biztonság, befogadás, átláthatóság és elszámoltathatóság. A Microsoft számára ezek az alapelvek a mesterséges intelligencia felelős és megbízható megközelítésének sarokkövei, különösen mivel az intelligens technológia egyre elterjedtebbé válik az emberek által naponta használt termékekben és szolgáltatásokban.

Ez a cikk bemutatja, hogyan támogatja az Azure Machine Learning azokat az eszközöket, amelyek lehetővé teszik a fejlesztők és adattudósok számára a hat alapelv megvalósítását és üzembe helyezését.

Méltányosság és befogadás

Az MI-rendszereknek mindenkit igazságosan kell kezelniük, és nem szabad különböző módon hatniuk az alapvetően hasonló helyzetben lévő felhasználói csoportokra. Ha például az AI-rendszerek útmutatást nyújtanak az orvosi kezeléssel, hiteligényléssel vagy foglalkoztatással kapcsolatban, ugyanezeket a javaslatokat kell tenniük mindenki számára, aki hasonló tüneteket, pénzügyi körülményeket vagy szakmai képesítést igényel.

Méltányosság és befogadás az Azure Machine Learningben: A Felelős AI-irányítópult méltányossági felmérési összetevője lehetővé teszi, hogy az adattudósok és a fejlesztők felmérjék a modell méltányosságát a nem, az etnikum, az életkor és más jellemzők szempontjából meghatározott érzékeny csoportok között.

Megbízhatóság és biztonság

A bizalom kiépítéséhez kritikus fontosságú, hogy az AI-rendszerek megbízhatóan, biztonságosan és következetesen működjenek. Képesnek kell lenniük az eredeti szándék és terv szerint működni, biztonságosan reagálni a váratlan helyzetekre, valamint ellenállni a kártékony manipulációnak. A viselkedésük és a különböző feltételek, amelyeket kezelni tudnak, tükrözik a fejlesztők által a tervezés és tesztelés során várt helyzetek és körülmények körét.

Megbízhatóság és biztonság az Azure Machine Learningben: A Felelős AI-irányítópult hibaelemzési összetevője lehetővé teszi az adattudósok és fejlesztők számára a következőket:

- Részletes ismereteket szerezhet a hibák modellhez való elosztásáról.

- Azonosítsa az adatok kohorszait (részhalmazait) a teljes teljesítménymutatónál magasabb hibaarányú adatokkal.

Ezek az eltérések akkor fordulhatnak elő, ha a rendszer vagy a modell bizonyos demográfiai csoportoknál vagy a betanítási adatok ritkán megfigyelt bemeneti feltételeinél alulteljesít.

Átláthatóság

Amikor az AI-rendszerek segítenek tájékoztatni azokat a döntéseket, amelyek óriási hatással vannak az emberek életére, kritikus fontosságú, hogy az emberek megértsék, hogyan születtek ezek a döntések. Előfordulhat például, hogy egy bank AI-rendszert használ annak eldöntésére, hogy egy személy hitelképes-e. A vállalat AI-rendszer használatával határozhatja meg a leginkább képzett jelentkezőket.

Az átláthatóság fontos része az értelmezhetőség: az AI-rendszerek és összetevőik viselkedésének hasznos magyarázata. Az értelmezhetőség javításához az érdekelt feleknek meg kell tudniuk, hogyan és miért működnek az AI-rendszerek a működésükhöz hasonlóan. Az érdekelt felek ezután azonosíthatják a lehetséges teljesítményproblémákat, a méltányossági problémákat, a kizárási gyakorlatokat vagy a nem várt eredményeket.

Átláthatóság az Azure Machine Learningben: A felelős AI-irányítópult modellértelmezhetősége és hasznosítható összetevői lehetővé teszik az adattudósok és fejlesztők számára, hogy egy modell előrejelzéseinek emberi-érthető leírását generálják.

A modell értelmezhetőségi összetevője több nézetet is biztosít a modell viselkedéséhez:

- Globális magyarázatok. Milyen funkciók befolyásolják például a hitelkiosztási modell általános viselkedését?

- Helyi magyarázatok. Például miért hagytak jóvá vagy utasítottak el egy ügyfél hitelkérelmét?

- Modellmagyarázatok az adatpontok kiválasztott kohorszához. Milyen funkciók befolyásolják például az alacsony jövedelmű kérelmezők hitelkiosztási modelljének általános viselkedését?

Az ellenfaktuális lehetőségösszetevő lehetővé teszi a gépi tanulási modellek megértését és hibakeresését annak tekintetében, hogy hogyan reagál a funkcióváltozásokra és -zavarokra.

Az Azure Machine Learning egy felelős AI-scorecardot is támogat. A scorecard egy testreszabható PDF-jelentés, amelyet a fejlesztők egyszerűen konfigurálhatnak, hozhatnak létre, tölthetnek le és oszthatnak meg műszaki és nem technikai érdekelt felekkel, hogy megtanítsák őket az adathalmazaikra és modelljeik állapotára, a megfelelőség elérésére és a bizalom kiépítésére. Ez a scorecard az audit-felülvizsgálatokban is használható a gépi tanulási modellek jellemzőinek feltárásához.

Adatvédelem és biztonság

Ahogy az AI egyre elterjedtebbé válik, egyre fontosabbá és összetettebbé válik az adatvédelem, valamint a személyes és üzleti információk védelme. Az AI-vel az adatvédelem és az adatbiztonság fokozott figyelmet igényel, mivel az AI-rendszerek számára elengedhetetlen az adatokhoz való hozzáférés ahhoz, hogy pontos és tájékozott előrejelzéseket és döntéseket hozzanak az emberekről. Az AI-rendszereknek meg kell felelniük a következő adatvédelmi törvényeknek:

- Átláthatóságot igényel az adatok gyűjtéséről, használatáról és tárolásáról.

- Kötelezzék a fogyasztókat arra, hogy megfelelő vezérlőkkel rendelkezzenek adataik felhasználásának kiválasztásához.

Adatvédelem és biztonság az Azure Machine Learningben: Az Azure Machine Learning lehetővé teszi a rendszergazdák és fejlesztők számára, hogy biztonságos konfigurációt hozzanak létre, amely megfelel a vállalatuk szabályzatainak. Az Azure Machine Learning és az Azure platform használatával a felhasználók a következőket tehetik:

- Erőforrásokhoz és műveletekhez való hozzáférés korlátozása felhasználói fiók vagy csoport szerint.

- A bejövő és kimenő hálózati kommunikáció korlátozása.

- Az átvitel alatt lévő és inaktív adatok titkosítása.

- Keresse meg a biztonsági réseket.

- Konfigurációs szabályzatok alkalmazása és naplózása.

A Microsoft két nyílt forráskódú csomagot is létrehozott, amelyek lehetővé teszik az adatvédelmi és biztonsági alapelvek további megvalósítását:

SmartNoise: A differenciált adatvédelem olyan rendszerek és eljárások készlete, amelyek segítenek az egyének adatainak biztonságos és privát állapotban tartásában. A gépi tanulási megoldásokban a jogszabályi megfelelőséghez szükség lehet a differenciált adatvédelemre. A SmartNoise egy nyílt forráskódú projekt (amelyet a Microsoft fejlesztett ki), amely olyan összetevőket tartalmaz, amelyek különböző, globális magánrendszerek létrehozásához szükségesek.

Counterfit: Counterfit egy nyílt forráskódú projekt, amely egy parancssori eszközből és egy általános automatizálási rétegből áll, amely lehetővé teszi a fejlesztők számára, hogy kibertámadásokat szimuláljanak az AI-rendszereken. Az eszközt bárki letöltheti és üzembe helyezheti az Azure Cloud Shellen keresztül, hogy böngészőben fusson, vagy helyileg helyezze üzembe Anaconda Python-környezetben. Felmérheti a különböző felhőkörnyezetekben, a helyszínen vagy a peremhálózaton üzemeltetett AI-modelleket. Az eszköz agnosztikus az AI-modellek számára, és különböző adattípusokat támogat, például szöveget, képeket vagy általános bemeneteket.

Elszámoltathatóság

A AI-rendszereket tervező és telepítő személyeknek elszámoltathatónak kell lenniük azzal kapcsolatban, hogyan működnek a rendszereik. A cégeknek és szervezeteknek ki kell fejleszteniük iparági szabványokon alapuló elszámoltathatósági normákat. Ezek a normák biztosíthatják, hogy az AI-rendszerek ne legyenek végső hatalom az emberek életét érintő döntésekben. Azt is biztosíthatják, hogy az emberek értelmes ellenőrzést tartsanak fenn az egyébként erősen autonóm AI-rendszerek felett.

Az Azure Machine Learning: Machine Learning Operations (MLOps) az AI-munkafolyamatok hatékonyságát növelő DevOps-alapelveken és gyakorlatokon alapul. Az Azure Machine Learning a következő MLOps-képességeket biztosítja az AI-rendszerek jobb elszámoltathatóságához:

- Modellek regisztrálása, csomagolása és üzembe helyezése bárhonnan. A modell használatához szükséges kapcsolódó metaadatokat is nyomon követheti.

- Rögzítse a teljes körű gépi tanulási életciklus szabályozási adatait. A naplózott életútadatok tartalmazhatják a modellek közzétételének, a módosítások okainak, valamint a modellek üzembe helyezésének vagy éles környezetben való felhasználásának a adatait.

- Értesítés és riasztás a gépi tanulási életciklus eseményeiről. Ilyen például a kísérlet befejezése, a modellregisztráció, a modell üzembe helyezése és az adateltolódás észlelése.

- Alkalmazások monitorozása a gépi tanulással kapcsolatos működési problémák és problémák esetén. Hasonlítsa össze a modell bemeneteit a betanítás és a következtetés között, vizsgálja meg a modellspecifikus metrikákat, és biztosítson monitorozást és riasztásokat a gépi tanulási infrastruktúrán.

Az MLOps képességei mellett az Azure Machine Learning felelős AI-scorecardja elszámoltathatóságot hoz létre az érdekelt felek közötti kommunikáció engedélyezésével. A scorecard emellett elszámoltathatóságot is teremt azáltal, hogy lehetővé teszi a fejlesztők számára a modellállapot-elemzések konfigurálását, letöltését és megosztását a műszaki és nem technikai érdekelt felekkel az AI-adatokkal és a modell állapotával kapcsolatban. Az elemzések megosztása segíthet a bizalom kiépítésében.

A gépi tanulási platform a döntéshozatalt is lehetővé teszi azáltal, hogy tájékoztatja az üzleti döntéseket az alábbiakon keresztül:

- Adatvezérelt elemzések, amelyek segítenek az érdekelt feleknek megérteni az eredményre gyakorolt ok-okozati kezelési hatásokat, csak az előzményadatok használatával. Például: "Hogyan befolyásolná egy gyógyszer a beteg vérnyomását?" Ezeket az elemzéseket a Felelős AI-irányítópult oksági következtetési összetevője biztosítja.

- Modellalapú elemzések, amelyek választ adnak a felhasználók kérdéseire (például "Mit tehetek, hogy legközelebb más eredményt kapjak az AI-tól?"), hogy meg tudják tenni a szükséges lépéseket. Ezek az elemzések az adattudósok számára a Felelős AI-irányítópult kontrafaktuális lehetőségösszetevője révén érhetők el.

Következő lépések

- A Felelős AI Azure Machine Learningben való implementálásáról további információt a Felelős AI-irányítópulton talál.

- Megtudhatja, hogyan hozhatja létre a Felelős AI-irányítópultot a parancssori felület és az SDK vagy az Azure Machine Learning Studio felhasználói felületén keresztül.

- Megtudhatja, hogyan hozhat létre felelős AI scorecardot a Felelős AI-irányítópulton megfigyelt megállapítások alapján.

- Ismerje meg a felelős AI-szabványt , amely az AI-rendszerek hat fő alapelv szerint történő kiépítéséhez használható.