Apache Spark-feladatdefiníciók létrehozása és kezelése a Visual Studio Code-ban

A Synapse Visual Studio (VS) kódbővítménye teljes mértékben támogatja a CURD (létrehozás, frissítés, olvasás és törlés) Spark-feladatdefiníciós műveleteket a Fabricben. A Spark-feladatdefiníció létrehozása után további hivatkozott kódtárakat tölthet fel, kérést küldhet a Spark-feladatdefiníció futtatására, és ellenőrizheti a futtatási előzményeket.

Spark-feladatdefiníció létrehozása

Új Spark-feladatdefiníció létrehozása:

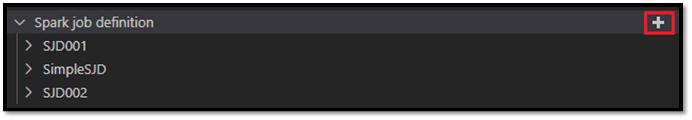

A VS Code Explorerben válassza a Spark-feladatdefiníció létrehozása lehetőséget.

Adja meg a kezdeti kötelező mezőket: név, hivatkozott lakehouse és alapértelmezett lakehouse.

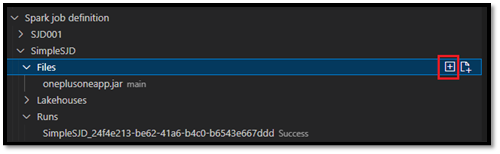

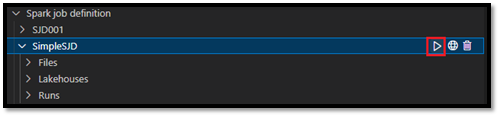

A kérelemfolyamatok és az újonnan létrehozott Spark-feladatdefiníció neve a VS Code Explorer Spark-feladatdefiníció gyökércsomópontja alatt jelenik meg. A Spark-feladatdefiníció névcsomópontja alatt három alcsomópont látható:

- Fájlok: A fő definíciós fájl és más hivatkozott kódtárak listája. Ebből a listából új fájlokat tölthet fel.

- Lakehouse: A Spark-feladat definíciója által hivatkozott összes tóház listája. Az alapértelmezett tóház meg van jelölve a listában, és a relatív útvonalon

Files/…, Tables/…keresztül érheti el. - Futtatás: A Spark-feladat definíciójának futtatási előzményeinek és az egyes futtatások feladatállapotának listája.

Fődefiníciós fájl feltöltése egy hivatkozott tárba

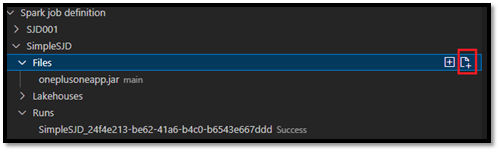

A fődefiníciós fájl feltöltéséhez vagy felülírásához válassza a Fő fájl hozzáadása lehetőséget.

A fő definíciós fájl által hivatkozott kódtárfájl feltöltéséhez válassza a Lib Fájl hozzáadása lehetőséget.

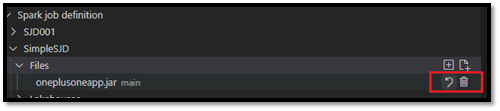

Miután feltöltött egy fájlt, felülbírálhatja a Fájl frissítése beállításra kattintva és egy új fájl feltöltésével, vagy törölheti a fájlt a Törlés beállítással.

Futtatási kérelem elküldése

A Spark-feladat definíciójának VS Code-ból való futtatására irányuló kérés elküldése:

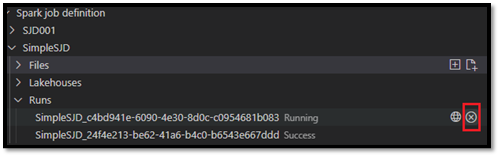

A futtatni kívánt Spark-feladatdefiníció nevétől jobbra található beállítások közül válassza a Spark-feladat futtatása lehetőséget.

A kérés elküldése után megjelenik egy új Apache Spark-alkalmazás a Futtatások csomópontban az Explorer listában. A futó feladatot a Spark-feladat megszakítása lehetőség kiválasztásával szakíthatja meg.

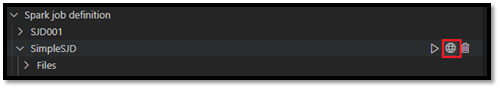

Spark-feladatdefiníció megnyitása a Háló portálon

A Spark-feladatdefiníció szerzői lapját megnyithatja a Háló portálon a Megnyitás böngészőben lehetőség kiválasztásával.

Az elvégzett futtatás mellett a Megnyitás böngészőben lehetőséget is választhatja a futtatás részletes monitorozási oldalának megtekintéséhez.

Spark-feladatdefiníció forráskódjának hibakeresése (Python)

Ha a Spark-feladatdefiníció a PySpark (Python) használatával jön létre, letöltheti a fő definíciós fájl és a hivatkozott fájl .py szkriptét, és hibakeresést végezhet a VS Code-ban.

A forráskód letöltéséhez válassza a Spark-feladatdefiníciótól jobbra található Hibakeresési Spark-feladatdefiníció lehetőséget.

A letöltés befejezése után a forráskód mappája automatikusan megnyílik.

Amikor a rendszer kéri, válassza a Szerzők megbízhatósága lehetőséget. (Ez a beállítás csak a mappa első megnyitásakor jelenik meg. Ha nem választja ezt a lehetőséget, nem tudja hibakeresésre vagy a forrásszkript futtatására. További információ: Visual Studio Code Workspace Trust security.)

Ha korábban letöltötte a forráskódot, a rendszer kéri, hogy erősítse meg, hogy felülírja a helyi verziót az új letöltéssel.

Feljegyzés

A forrásszkript gyökérmappájában a rendszer létrehoz egy conf nevű almappát. Ebben a mappában egy lighter-config.json nevű fájl tartalmazza a távoli futtatáshoz szükséges rendszer metaadatait. Ne módosítsa a módosításokat.

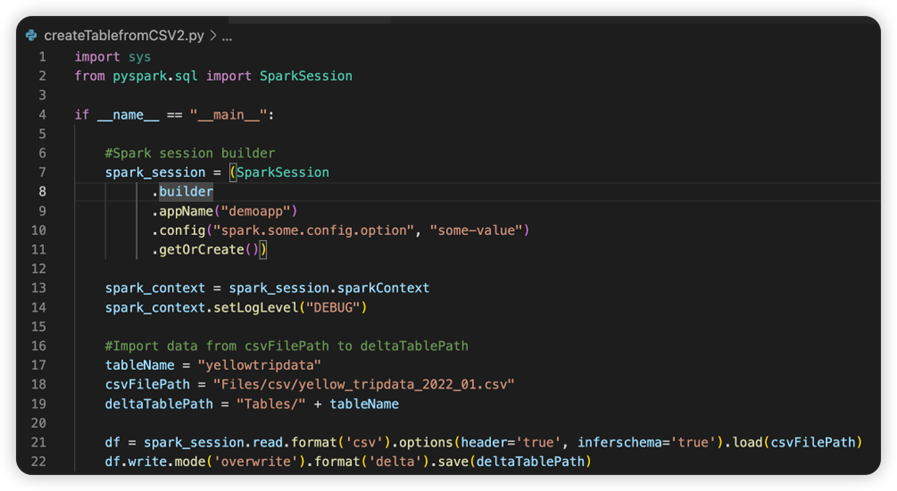

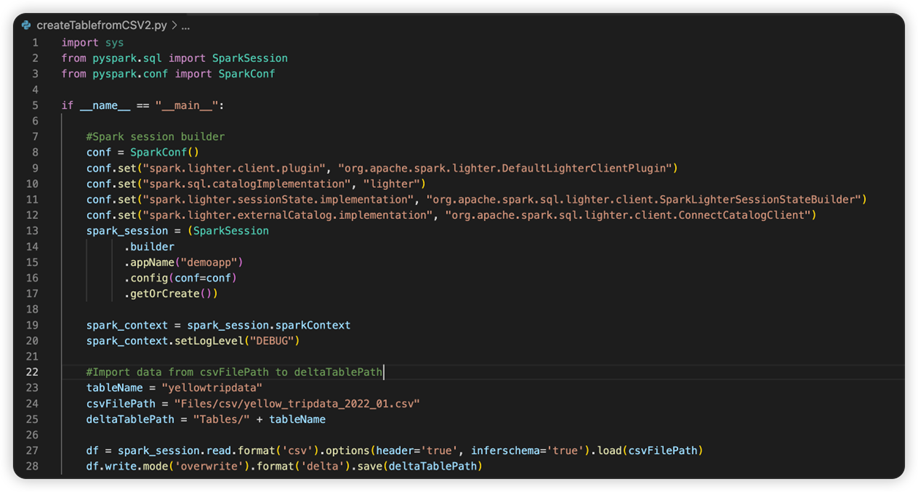

A sparkconf.py nevű fájl tartalmaz egy kódrészletet, amelyet hozzá kell adnia a SparkConf-objektum beállításához. A távoli hibakeresés engedélyezéséhez győződjön meg arról, hogy a SparkConf-objektum megfelelően van beállítva. Az alábbi képen a forráskód eredeti verziója látható.

A következő kép a kódrészlet másolása és beillesztése után frissített forráskód.

Miután frissítette a forráskódot a szükséges konföderációval, ki kell választania a megfelelő Python-értelmezőt. Győződjön meg arról, hogy a synapse-spark-kernel conda környezetből telepített példányt választja ki.

Spark-feladatdefiníció tulajdonságainak szerkesztése

Szerkesztheti a Spark-feladatdefiníciók részletes tulajdonságait, például parancssori argumentumokat.

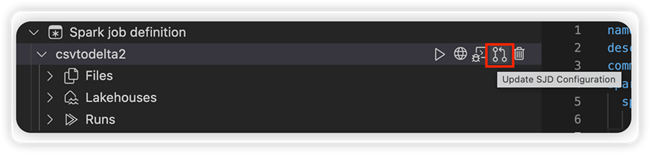

Válassza az SJD-konfiguráció frissítése lehetőséget egy settings.yml fájl megnyitásához. A meglévő tulajdonságok feltöltik a fájl tartalmát.

Frissítse és mentse a .yml fájlt.

A módosítás távoli munkaterületre való szinkronizálásához válassza a jobb felső sarokban található Közzététel SJD tulajdonság lehetőséget.

Kapcsolódó tartalom

Visszajelzés

Hamarosan elérhető: 2024-ben fokozatosan kivezetjük a GitHub-problémákat a tartalom visszajelzési mechanizmusaként, és lecseréljük egy új visszajelzési rendszerre. További információ: https://aka.ms/ContentUserFeedback.

Visszajelzés küldése és megtekintése a következőhöz: