Az Azure Data Lake Storage Gen1 használata big data-követelményekhez

Feljegyzés

Az Azure Data Lake Storage Gen1 ki lett állítva. A nyugdíjazási bejelentést itt találja. A Data Lake Storage Gen1-erőforrások már nem érhetők el.

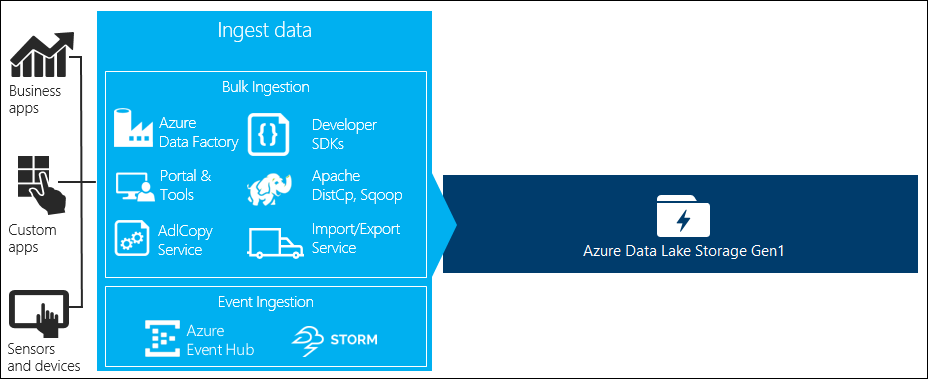

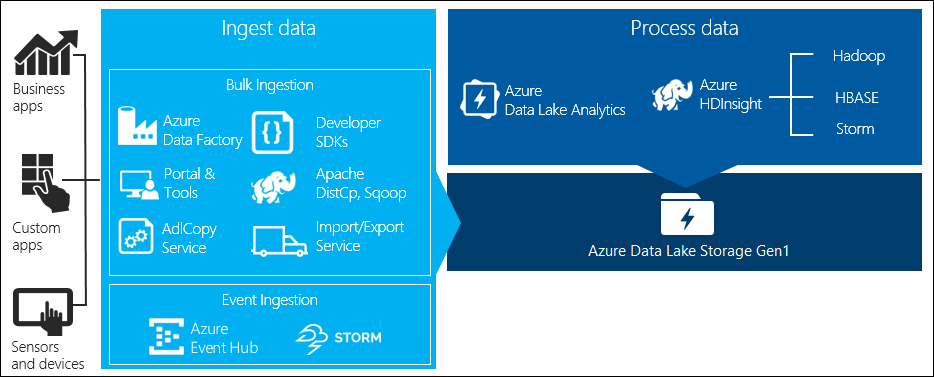

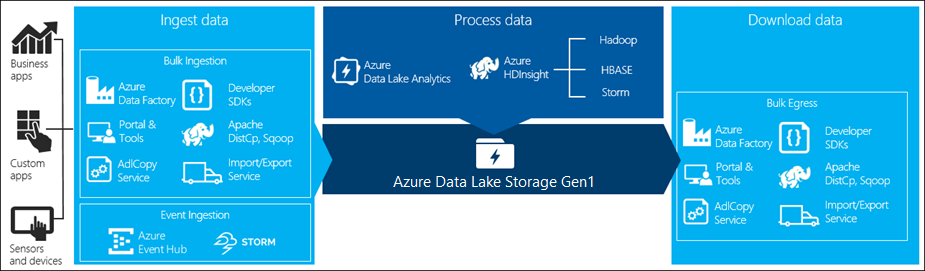

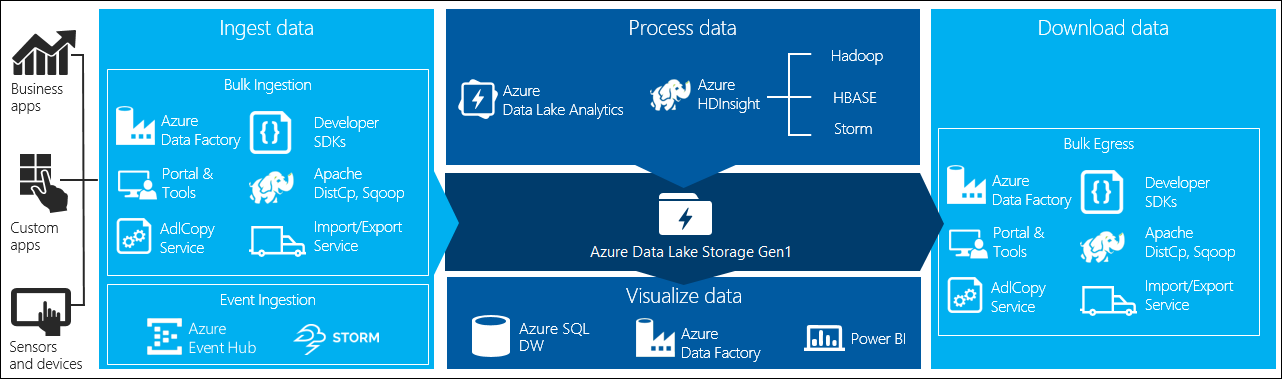

A big data-feldolgozásnak négy fő fázisa van:

- Nagy mennyiségű adat betöltése adattárba valós időben vagy kötegekben

- Az adatok feldolgozása

- Az adatok letöltése

- Az adatok vizualizációja

Ebben a cikkben ezeket a szakaszokat tekintjük át az Azure Data Lake Storage Gen1 tekintetében, hogy megismerjük a big data-igények kielégítéséhez rendelkezésre álló lehetőségeket és eszközöket.

Adatok betöltése a Data Lake Storage Gen1-be

Ez a szakasz kiemeli a különböző adatforrásokat és azokat a különböző módszereket, amelyekkel az adatok betölthetők egy Data Lake Storage Gen1-fiókba.

Alkalmi adatok

Ez a big data-alkalmazások prototípus-készítéshez használt kisebb adatkészleteket jelöli. Az adatok forrásától függően az alkalmi adatok betöltésének különböző módjai vannak.

| Adatforrás | Betöltési funkció |

|---|---|

| Helyi számítógép | |

| Azure Storage Blob |

Streamelt adatok

Ez olyan adatokat jelöl, amelyeket különböző források, például alkalmazások, eszközök, érzékelők stb. hozhatnak létre. Ezek az adatok többféle eszközzel betölthetők a Data Lake Storage Gen1-be. Ezek az eszközök általában eseményenként, valós időben rögzítik és dolgozzák fel az adatokat, majd kötegekben írják az eseményeket a Data Lake Storage Gen1-be, hogy azok tovább feldolgozhatók legyenek.

Az alábbi eszközöket használhatja:

- Azure Stream Analytics – Az Event Hubsba betöltött események azure Data Lake Storage Gen1-kimenettel írhatók az Azure Data Lake Storage Gen1-be.

- EventProcessorHost – Eseményeket fogadhat az Event Hubstól, majd a Data Lake Storage Gen1 .NET SDK használatával írhatja azt a Data Lake Storage Gen1-be.

Relációs adatok

Relációs adatbázisokból is származtathat adatokat. Egy idő alatt a relációs adatbázisok hatalmas mennyiségű adatot gyűjtenek, amelyek kulcsfontosságú elemzéseket nyújthatnak, ha big data-folyamaton keresztül dolgozzák fel. Az alábbi eszközökkel áthelyezheti ezeket az adatokat a Data Lake Storage Gen1-be.

Webkiszolgáló naplóadatai (feltöltés egyéni alkalmazásokkal)

Ezt az adathalmaztípust kifejezetten azért hívjuk fel, mert a webkiszolgálói naplóadatok elemzése gyakori használati eset a big data-alkalmazások esetében, és nagy mennyiségű naplófájlt kell feltölteni a Data Lake Storage Gen1-be. Az alábbi eszközök bármelyikével saját szkripteket vagy alkalmazásokat írhat az ilyen adatok feltöltéséhez.

Webkiszolgálói naplóadatok feltöltéséhez és más típusú adatok (pl. közösségi hangulatadatok) feltöltéséhez is érdemes saját egyéni szkripteket/alkalmazásokat írni, mert így rugalmasan belefoglalhatja az adatfeltöltési összetevőt a nagyobb big data-alkalmazásba. Bizonyos esetekben ez a kód egy szkript vagy egy egyszerű parancssori segédprogram formájában jelenhet meg. Más esetekben a kód használható a big data-feldolgozás üzleti alkalmazásba vagy megoldásba való integrálásához.

Azure HDInsight-fürtökhöz társított adatok

A LEGTÖBB HDInsight-fürttípus (Hadoop, HBase, Storm) támogatja a Data Lake Storage Gen1-et adattárként. A HDInsight-fürtök az Azure Storage-blobokból (WASB) férnek hozzá az adatokhoz. A jobb teljesítmény érdekében a WASB-ből átmásolhatja az adatokat a fürthöz társított Data Lake Storage Gen1-fiókba. Az alábbi eszközökkel másolhatja az adatokat.

Helyszíni vagy IaaS Hadoop-fürtökben tárolt adatok

Nagy mennyiségű adat tárolható meglévő Hadoop-fürtökön, helyileg a HDFS-t használó gépeken. Előfordulhat, hogy a Hadoop-fürtök helyszíni üzembe helyezésben vagy egy Azure-beli IaaS-fürtben találhatók. Előfordulhat, hogy az ilyen adatok egyszeri vagy ismétlődő módon történő másolása az Azure Data Lake Storage Gen1-be szükséges. Ennek eléréséhez különböző lehetőségek állnak rendelkezésre. Az alábbiakban az alternatívák és a kapcsolódó kompromisszumok listája látható.

| Módszer | Részletek | Előnyök | Megfontolások |

|---|---|---|---|

| Adatok másolása közvetlenül Hadoop-fürtökről az Azure Data Lake Storage Gen1-be az Azure Data Factory (ADF) használatával | Az ADF támogatja a HDFS-t adatforrásként | Az ADF beépített támogatást nyújt a HDFS és az első osztályú végpontok közötti felügyelethez és monitorozáshoz | A adatkezelés Átjáró helyszíni vagy IaaS-fürtben történő üzembe helyezését igényli |

| Adatok exportálása a Hadoopból fájlokként. Ezután másolja a fájlokat az Azure Data Lake Storage Gen1-be a megfelelő mechanizmus használatával. | Fájlokat másolhat az Azure Data Lake Storage Gen1-be a következő használatával:

|

Első lépések. Testre szabott feltöltések is elvégezhetők | Többlépéses folyamat, amely több technológiát is magában foglal. A felügyelet és a monitorozás idővel kihívást jelent az eszközök testre szabott jellege miatt |

| A Distcp használatával adatokat másolhat a Hadoopból az Azure Storage-ba. Ezután másolja az adatokat az Azure Storage-ból a Data Lake Storage Gen1-be a megfelelő mechanizmus használatával. | Az Azure Storage-ból az 1. generációs Data Lake Storage-ba másolhat adatokat a következő használatával: | Nyílt forráskódú eszközöket is használhat. | Többlépéses folyamat, amely több technológiát is magában foglal |

Igazán nagy adathalmazok

A több terabájtos adathalmazok feltöltése esetén a fent leírt módszerek használata néha lassú és költséges lehet. Ilyen esetekben az alábbi lehetőségeket használhatja.

Az Azure ExpressRoute használata. Az Azure ExpressRoute-tal privát kapcsolatokat hozhat létre az Azure-adatközpontok és a helyszíni infrastruktúra között. Ez megbízható lehetőséget biztosít nagy mennyiségű adat átviteléhez. További információkért tekintse meg az Azure ExpressRoute dokumentációját.

Adatok "offline" feltöltése. Ha az Azure ExpressRoute használata bármilyen okból nem megvalósítható, az Azure Import/Export szolgáltatással merevlemez-meghajtókat szállíthat az adataival egy Azure-adatközpontba. Az adatok először fel lesznek töltve az Azure Storage-blobokbe. Ezután az Azure Data Factory vagy az AdlCopy eszközzel adatokat másolhat az Azure Storage-blobokból a Data Lake Storage Gen1-be.

Feljegyzés

Az Importálás/exportálás szolgáltatás használata során az Azure-adatközpontba szállított lemezek fájlmérete nem lehet nagyobb 195 GB-nál.

A Data Lake Storage Gen1-ben tárolt adatok feldolgozása

Miután az adatok elérhetővé válnak a Data Lake Storage Gen1-ben, elemzést futtathat az adatokon a támogatott big data-alkalmazások használatával. Jelenleg az Azure HDInsight és az Azure Data Lake Analytics használatával futtathat adatelemzési feladatokat az 1. generációs Data Lake Storage-ban tárolt adatokon.

Az alábbi példákat tekintheti meg.

- HDInsight-fürt létrehozása a Data Lake Storage Gen1 tárolóval tárolóként

- Az Azure Data Lake Analytics használata az 1. generációs Data Lake Storage szolgáltatással

Adatok letöltése a Data Lake Storage Gen1-ből

Előfordulhat, hogy az Azure Data Lake Storage Gen1-ből is szeretne adatokat letölteni vagy áthelyezni az alábbi helyzetekben:

- Adatok áthelyezése más adattárakba a meglévő adatfeldolgozási folyamatokhoz való kapcsolódáshoz. Előfordulhat például, hogy adatokat szeretne áthelyezni a Data Lake Storage Gen1-ből az Azure SQL Database-be vagy az SQL Serverbe.

- Töltse le az adatokat a helyi számítógépre IDE-környezetekben történő feldolgozás céljából, miközben alkalmazás prototípusokat készít.

Ilyen esetekben az alábbi lehetőségek bármelyikét használhatja:

Az alábbi módszerekkel saját szkriptet/alkalmazást is írhat az adatok Data Lake Storage Gen1-ből való letöltéséhez.

Adatok vizualizációja a Data Lake Storage Gen1-ben

A szolgáltatások kombinációjával vizuális ábrázolásokat hozhat létre az 1. generációs Data Lake Storage-ban tárolt adatokról.

- Először az Azure Data Factory használatával helyezhet át adatokat a Data Lake Storage Gen1-ből az Azure Synapse Analyticsbe

- Ezt követően integrálhatja a Power BI-t az Azure Synapse Analyticsszel az adatok vizuális ábrázolásának létrehozásához.