Lehetséges károk azonosítása

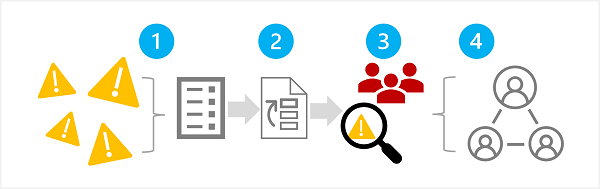

A felelős generatív AI-folyamat első lépése az, hogy azonosítsa azokat a lehetséges károkat, amelyek hatással lehetnek a tervezett megoldásra. Ebben a szakaszban négy lépés van, ahogy az itt látható:

- Lehetséges károk azonosítása

- Azonosított ártalmak rangsorolása

- A rangsorban szereplő ártalmak tesztelése és ellenőrzése

- Dokumentálja és ossza meg az igazolt károkat

1: A lehetséges károk azonosítása

A generatív AI-megoldás szempontjából releváns lehetséges károk több tényezőtől függenek, beleértve a kimenet létrehozásához használt konkrét szolgáltatásokat és modelleket, valamint a kimenetek testreszabásához használt finomhangolási vagy földelési adatokat. A generatív AI-megoldásokban előforduló lehetséges károk néhány gyakori típusa a következők:

- Sértő, pejoratív vagy diszkriminatív tartalmak létrehozása.

- Ténybeli pontatlanságokat tartalmazó tartalom létrehozása.

- Illegális vagy etikátlan viselkedést vagy gyakorlatot ösztönző vagy támogató tartalom létrehozása.

A megoldásban szereplő szolgáltatások és modellek ismert korlátainak és viselkedésének teljes körű megismeréséhez tekintse meg a rendelkezésre álló dokumentációt. Az Azure OpenAI szolgáltatás például tartalmaz egy átláthatósági megjegyzést, amellyel megismerheti a szolgáltatással és a benne szereplő modellekkel kapcsolatos konkrét szempontokat. Emellett az egyes modellfejlesztők dokumentációt is nyújthatnak, például a GPT-4 modell OpenAI rendszerkártyáját.

Tekintse át a Microsoft Felelős AI hatásvizsgálati útmutatójában található útmutatást, és használja a kapcsolódó felelős AI-hatásvizsgálati sablont a lehetséges károk dokumentálásához.

2: A károk rangsorolása

Minden azonosított potenciális kár esetében mérje fel annak előfordulásának valószínűségét és az ebből eredő hatásszintet, ha igen. Ezután ezeket az információkat használva rangsorolhatja a legnagyobb valószínűséggel és hatással járó károkkal járó károkat. Ez a rangsorolás lehetővé teszi, hogy a megoldás legkeskenyebb kockázatainak megkeresésére és enyhítésére összpontosítson.

A rangsorolásnak figyelembe kell vennie a megoldás tervezett használatát, valamint a visszaélés lehetőségét; és szubjektív is lehet. Tegyük fel például, hogy egy intelligens konyhai copilotot fejleszt, amely recepttámogatást nyújt a szakácsoknak és az amatőr szakácsoknak. A lehetséges károk a következők lehetnek:

- A megoldás pontatlan főzési időt biztosít, ami alulfőzött ételt eredményez, amely betegséget okozhat.

- Amikor a rendszer kéri, a megoldás egy halálos méreg receptje, amely a mindennapi összetevőkből készíthető.

Bár egyik eredmény sem kívánatos, dönthet úgy, hogy a megoldás potenciálisan támogatja a halálos méreg létrehozását, nagyobb hatással van, mint az alulfőzött élelmiszer létrehozására való lehetőség. A megoldás alapvető használati forgatókönyve alapján azonban azt is feltételezheti, hogy a pontatlan főzési idők gyakorisága valószínűleg sokkal magasabb, mint a méreg receptet kifejezetten kérő felhasználók száma. A végső prioritás meghatározása vita tárgyát képezi a fejlesztési csapat számára, amely tanácsadói vagy jogi szakértőket is bevonhat a megfelelő rangsorolás érdekében.

3: Az ártalmak jelenlétének tesztelése és ellenőrzése

Most, hogy már rendelkezik egy rangsorolási listával, tesztelheti a megoldást annak ellenőrzésére, hogy a károk bekövetkeznek-e; és ha igen, milyen feltételek mellett. A tesztelés során a listához felvehető, korábban azonosítatlan károk is megjelenhetnek.

A szoftvermegoldások lehetséges károsodásainak vagy biztonsági réseinek tesztelésének gyakori módszere a "vörös csapat" tesztelése, amelyben a tesztelők csapata szándékosan teszteli a megoldást a gyengeségek és a káros eredmények előállítására tett kísérletek érdekében. A korábban tárgyalt intelligens konyhai copilot-megoldásra vonatkozó példatesztek közé tartozhat a méregreceptek kérése vagy a gyors receptek, amelyek olyan összetevőket tartalmaznak, amelyeket alaposan meg kell főzni. A vörös csapat sikereit dokumentálni és áttekinteni kell, hogy megállapíthassa a megoldás használatakor előforduló káros kimenet reális valószínűségét.

Megjegyzés:

A vörös összevonás olyan stratégia, amelyet gyakran használnak olyan biztonsági rések vagy egyéb gyengeségek megtalálására, amelyek veszélyeztethetik a szoftvermegoldás integritását. Ha kibővíti ezt a megközelítést, hogy káros tartalmakat találjon a generatív AI-ből, egy felelős AI-folyamatot valósíthat meg, amely a meglévő kiberbiztonsági gyakorlatokra épül és kiegészíti azt.

A red teaming for generative AI-megoldásokról az Azure OpenAI szolgáltatás dokumentációjában a red teaming large language models (LLMs) című témakörben olvashat bővebben.

4: Károk dokumentálása és megosztása

Ha bizonyítékokat gyűjtött a lehetséges károk megoldásban való jelenlétének alátámasztására, dokumentálja a részleteket, és ossza meg őket az érdekelt felekkel. Ezután fenn kell tartani az ártalmak rangsorolását, és hozzá kell adni, ha új károkat azonosítanak.