Zona dan kontainer data lake

Penting untuk merencanakan struktur data Anda sebelum Anda mendaratkannya ke data lake. Ketika Anda memiliki rencana, Anda dapat menggunakan keamanan, partisi, dan pemrosesan secara efektif.

Untuk gambaran umum data lake, lihat Gambaran Umum Azure Data Lake Storage untuk analitik skala cloud.

Gambaran Umum

Tiga akun data lake Anda harus selaras dengan lapisan data lake yang khas.

| Nomor lake | Lapisan | Nomor kontainer | Nama kontainer |

|---|---|---|---|

| 1 | Mentah | 1 | Landing |

| 1 | Mentah | 2 | Kesesuaian |

| 2 | Diperkaya | 1 | Standar |

| 2 | Dikumpulkan | 2 | Produk data |

| 3 | Pengembangan | 1 | Kotak pasir analitik |

| 3 | Pengembangan | # | Nomor penyimpanan utama Synapse |

Tabel sebelumnya menunjukkan jumlah standar kontainer yang kami rekomendasikan per zona pendaratan data. Pengecualian untuk rekomendasi ini adalah jika kebijakan penghapusan sementara yang berbeda diperlukan untuk data dalam kontainer. Persyaratan ini menentukan kebutuhan Anda akan lebih banyak kontainer.

Catatan

Tiga data lake diilustrasikan di setiap zona pendaratan data. Data lake berada di tiga akun data lake, beberapa kontainer, dan folder, tetapi mewakili satu data lake logis untuk zona pendaratan data Anda.

Bergantung pada kebutuhan Anda, Anda mungkin ingin mengonsolidasikan lapisan mentah, diperkaya, dan dikumpulkan ke dalam satu akun penyimpanan. Pertahankan akun penyimpanan lain bernama "pengembangan" bagi konsumen data untuk membawa produk data berguna lainnya.

Untuk informasi selengkapnya tentang memisahkan akun data lake, lihat Akun penyimpanan di data lake logis.

Aktifkan Azure Storage dengan fitur ruang nama hierarkis, yang memungkinkan Anda mengelola file secara efisien. Fitur ruang nama hierarkis mengatur objek dan file dalam akun ke dalam hierarki direktori dan subdirektori berlapis. Hierarki ini diatur dengan cara yang sama seperti sistem file pada komputer Anda.

Ketika mesin penyerapan agnostik data atau aplikasi orientasi Anda mendaftarkan sistem rekaman baru, itu membuat folder yang diperlukan dalam kontainer dalam lapisan data mentah, diperkaya, dan standar. Jika aplikasi data yang selaras dengan sumber menyerap data, tim aplikasi data Anda memerlukan tim zona pendaratan data Anda untuk membuat folder dan grup keamanan. Masukkan nama prinsip layanan atau identitas terkelola ke dalam grup yang benar, dan tetapkan tingkat izin. Dokumentasikan proses ini untuk tim aplikasi data dan zona pendaratan data Anda.

Untuk informasi selengkapnya tentang tim, lihat Memahami peran dan tim untuk analitik skala cloud di Azure.

Setiap produk data harus memiliki dua folder dalam kontainer produk data yang dimiliki tim produk data Anda.

Dalam lapisan kontainer standar yang diperkaya, ada dua folder per sistem sumber, dibagi berdasarkan klasifikasi. Dengan struktur ini, tim Anda dapat menyimpan data secara terpisah yang memiliki klasifikasi keamanan dan data yang berbeda, dan menetapkan akses keamanan yang berbeda.

Kontainer standar Anda memerlukan folder umum untuk data rahasia atau di bawah ini dan folder sensitif untuk data pribadi. Mengontrol akses ke folder ini dengan menggunakan daftar kontrol akses (ACL). Anda dapat membuat himpunan data dengan semua data pribadi dihapus, dan menyimpannya di folder umum Anda. Anda dapat memiliki himpunan data lain yang menyertakan semua data pribadi di folder data pribadi sensitif Anda.

Kombinasi ACL dan grup Microsoft Entra membatasi akses data. Daftar dan grup ini mengontrol apa yang dapat dan tidak dapat diakses oleh grup lain. Pemilik data dan tim aplikasi data dapat menyetujui atau menolak akses ke aset data mereka.

Untuk informasi selengkapnya, lihat Manajemen akses data dan Data terbatas.

Peringatan

Beberapa produk perangkat lunak tidak mendukung pemasangan akar kontainer data lake. Karena keterbatasan ini, setiap kontainer data lake dalam lapisan mentah, dikumpulkan, diperkaya, dan pengembangan harus berisi satu folder yang bercabang ke beberapa folder. Siapkan izin folder Anda dengan hati-hati. Saat Anda membuat folder baru dari akar, ACL default pada direktori induk menentukan ACL default direktori turunan dan mengakses ACL. ACL file anak tidak memiliki ACL default.

Untuk informasi lebih lanjut, lihat Daftar kontrol akses di Azure Data Lake Storage Gen2.

Lapisan mentah atau data lake satu

Anggap lapisan mentah sebagai reservoir yang menyimpan data dalam keadaan alami dan asli. Data tersebut tidak difilter dan tidak dimurnikan. Anda dapat menyimpan data dalam format aslinya, seperti JSON atau CSV. Atau mungkin hemat biaya untuk menyimpan konten file sebagai kolom dalam format file terkompresi, seperti Avro, Parquet, atau Databricks Delta Lake.

Data mentah ini tidak dapat diubah. Jaga agar data mentah Anda tetap terkunci, dan jika Anda memberikan izin kepada konsumen mana pun, otomatis atau manusia, pastikan bahwa data tersebut bersifat baca-saja. Anda dapat mengatur lapisan ini dengan menggunakan satu folder per sistem sumber. Berikan setiap proses penyerapan akses tulis hanya ke folder terkait.

Saat Anda memuat data dari sistem sumber ke zona mentah, Anda dapat memilih untuk melakukan:

- Beban penuh untuk mengekstrak himpunan data lengkap.

- Delta dimuat untuk memuat hanya data yang diubah.

Tunjukkan pola pemuatan yang Anda pilih dalam struktur folder Anda untuk menyederhanakan penggunaan bagi konsumen data Anda.

Data mentah dari sistem sumber untuk setiap aplikasi data yang selaras dengan sumber atau sumber mesin penyerapan otomatis mendarat di folder lengkap atau folder delta. Setiap proses penyerapan harus memiliki akses tulis hanya ke folder terkait.

Perbedaan antara beban penuh dan beban delta adalah:

Beban penuh - Melengkapi data dari sumber dapat di-onboarding jika:

- Volume data di sumbernya kecil.

- Sistem sumber tidak mempertahankan bidang tanda waktu yang mengidentifikasi apakah data telah ditambahkan, diperbarui, atau dihapus.

- Sistem sumber menimpa data lengkap setiap kali.

Beban Delta - Data bertahas dari sumber dapat di-onboarding jika:

- Volume data di sumber besar.

- Sistem sumber mempertahankan bidang tanda waktu yang mengidentifikasi apakah data telah ditambahkan, diperbarui, atau dihapus.

- Sistem sumber membuat dan memperbarui file pada perubahan data.

Data lake mentah Anda terdiri dari kontainer pendaratan dan kesuaian Anda. Setiap kontainer menggunakan struktur folder wajib 100% khusus untuk tujuannya.

Tata letak kontainer pendaratan

Kontainer pendaratan Anda dicadangkan untuk data mentah yang berasal dari sistem sumber yang dikenali. Mesin penyerapan agnostik data Anda atau aplikasi data yang selaras dengan sumber memuat data, yang tidak diubah dan dalam format aslinya yang didukung.

.

|-Landing

|--Log

|---{Application Name}

|--Master and Reference

|---{Source System}

|--Telemetry

|---{Source System}

|----{Application}

|--Transactional

|---{Source System}

|----{Entity}

|-----{Version}

|------Delta

|-------{date (ex. rundate=2019-08-22)}

|------Full

Kontainer kesuaian lapisan mentah

Lapisan mentah Anda berisi data yang sesuai dengan kualitas data. Saat data disalin ke kontainer pendaratan, pemrosesan dan komputasi data dipicu untuk menyalin data dari kontainer pendaratan ke kontainer kesesuaian. Pada tahap pertama ini, data dikonversi menjadi format delta lake dan mendarat di folder input. Saat kualitas data berjalan, rekaman yang lolos disalin ke folder output. Rekaman yang gagal mendarat di folder kesalahan.

.

|-Conformance

|--Log

|---{Application Name}

|--Master and Reference

|---{Source System}

|--Telemetry

|---{Source System}

|----{Application}

|--Transactional

|---{Source System}

|----{Entity}

|-----{Version}

|------Delta

|-------Input

|--------{date (ex. rundate=2019-08-22)}

|-------Output

|--------{date (ex. rundate=2019-08-22)}

|-------Error

|--------{date (ex. rundate=2019-08-22)}

|------Full

|-------Input

|--------{date (ex. rundate=2019-08-22)}

|-------Output

|--------{date (ex. rundate=2019-08-22)}

|-------Error

|--------{date (ex. rundate=2019-08-22)}

Tip

Pikirkan tentang skenario di mana Anda mungkin perlu membangun kembali platform analitik dari awal. Pertimbangkan data paling terperinci yang Anda butuhkan untuk membangun kembali penyimpanan data baca hilir. Pastikan Anda memiliki rencana kelangsungan bisnis dan pemulihan bencana untuk komponen utama Anda.

Lapisan yang diperkaya atau data lake dua

Anggap lapisan yang diperkaya sebagai lapisan filtrasi. Ini menghilangkan kotoran dan juga dapat melibatkan pengayaan.

Kontainer standardisasi Anda menyimpan sistem rekaman dan master. Folder disegmentasi terlebih dahulu menurut area subjek, lalu menurut entitas. Data tersedia dalam tabel gabungan yang dipartisi yang dioptimalkan untuk konsumsi analitik.

Kontainer standar

.

|-Standardized

|--Log

|---{Application Name}

|--Master and Reference

|---{Source System}

|--Telemetry

|---{Source System}

|----{Application}

|--Transactional

|---{Source System}

|----{Entity}

|-----{Version}

|------General

|--------{date (ex. rundate=2019-08-22)}

|-------Sensitive

|--------{date (ex. rundate=2019-08-22)}

Catatan

Lapisan data ini dianggap sebagai lapisan perak atau sumber data baca. Data dalam lapisan ini tidak memiliki transformasi yang diterapkan selain kualitas data, konversi delta lake, dan perataan jenis data.

Diagram berikut menunjukkan aliran data lake dan kontainer dari data sumber ke kontainer standar.

Lapisan yang dikumpulkan atau data lake dua

Lapisan yang dikumpulkan adalah lapisan konsumsi Anda. Ini dioptimalkan untuk analitik daripada penyerapan atau pemrosesan data. Lapisan yang dikumpulkan mungkin menyimpan data dalam mart data yang didenormalisasi atau skema bintang.

Data dari kontainer standar Anda diubah menjadi produk data bernilai tinggi yang disajikan kepada konsumen data Anda. Data ini memiliki struktur. Ini dapat disajikan kepada konsumen apa adanya, seperti buku catatan ilmu data, atau melalui penyimpanan data baca lain, seperti Azure SQL Database.

Gunakan alat, seperti Spark atau Data Factory, untuk melakukan pemodelan dimensi alih-alih melakukannya di dalam mesin database Anda. Penggunaan alat ini menjadi titik kunci jika Anda ingin menjadikan danau Anda sebagai satu-satunya sumber kebenaran.

Jika Anda melakukan pemodelan dimensi di luar danau, Anda mungkin ingin menerbitkan model kembali ke danau Anda untuk konsistensi. Lapisan ini bukan pengganti gudang data. Performanya biasanya tidak memadai untuk dasbor responsif atau analitik interaktif pengguna akhir dan konsumen. Lapisan ini paling cocok untuk analis internal dan ilmuwan data yang menjalankan kueri atau analisis berskala besar, improvisasi, atau untuk analis tingkat lanjut yang tidak memiliki kebutuhan pelaporan sensitif waktu. Karena biaya penyimpanan lebih rendah di data lake Anda daripada gudang data Anda, biaya dapat hemat biaya untuk menjaga data tingkat terperinci dan rendah di lake Anda. Simpan data agregat di gudang Anda. Hasilkan agregasi ini dengan menggunakan Spark atau Azure Data Factory. Pertahankan ke data lake Anda sebelum memuatnya ke gudang data Anda.

Aset data di zona ini biasanya sangat diatur dan didokumenkan dengan baik. Tetapkan izin menurut departemen atau menurut fungsi, dan atur izin menurut grup konsumen atau data mart.

Kontainer produk data

.

|-{Data Product}

|---{Entity}

|----{Version}

|-----General

|-------{date (ex. rundate=2019-08-22)}

|------Sensitive

|-------{date (ex. rundate=2019-08-22)}

Tip

Saat Anda mendaratkan data di penyimpanan data baca lain, seperti Azure SQL Database, pastikan Anda memiliki salinan data tersebut yang terletak di data yang dikumpulkan. Pengguna produk data Anda dipandu ke penyimpanan data baca utama atau instans Azure SQL Database Anda, tetapi mereka juga dapat menjelajahi data dengan alat tambahan jika Anda membuat data tersedia di data lake Anda.

Lapisan pengembangan atau data lake tiga

Konsumen data Anda dapat membawa produk data berguna lainnya bersama dengan data yang diserap ke dalam kontainer standar Anda.

Dalam skenario ini, platform data Anda dapat mengalokasikan area kotak pasir analitik untuk konsumen ini. Di kotak pasir, mereka dapat menghasilkan wawasan berharga dengan menggunakan data yang dikumpulkan dan produk data yang mereka bawa. Misalnya, jika tim ilmu data ingin menentukan strategi penempatan produk terbaik untuk wilayah baru, mereka dapat membawa produk data lain, seperti demografi pelanggan dan data penggunaan, dari produk serupa di wilayah tersebut. Tim dapat menggunakan wawasan penjualan bernilai tinggi dari data ini untuk menganalisis strategi kecocokan dan penawaran pasar produk.

Catatan

Area kotak pasir analitik adalah area kerja untuk individu atau sekelompok kecil kolaborator. Folder area kotak pasir memiliki serangkaian kebijakan khusus yang mencegah upaya untuk menggunakan area ini sebagai bagian dari solusi produksi. Kebijakan ini membatasi total penyimpanan yang tersedia dan berapa lama data dapat disimpan.

Produk data ini biasanya memiliki kualitas dan akurasi yang tidak diketahui. Mereka masih dikategorikan sebagai produk data, tetapi bersifat sementara dan hanya relevan dengan grup pengguna yang menggunakan data.

Ketika produk data ini matang, perusahaan Anda dapat mempromosikan produk data ini ke lapisan data yang dikumpulkan. Untuk menjaga tim produk data Anda bertanggung jawab atas produk data baru, berikan folder khusus kepada tim di zona data yang dikumpulkan. Mereka dapat menyimpan hasil baru di folder dan membagikannya dengan tim lain di seluruh organisasi Anda.

Catatan

Untuk setiap ruang kerja Azure Synapse yang Anda buat, gunakan data lake tiga untuk membuat kontainer untuk digunakan sebagai penyimpanan utama. Kontainer ini menghentikan ruang kerja Azure Synapse mengganggu batas throughput zona yang dikumpulkan dan diperkaya.

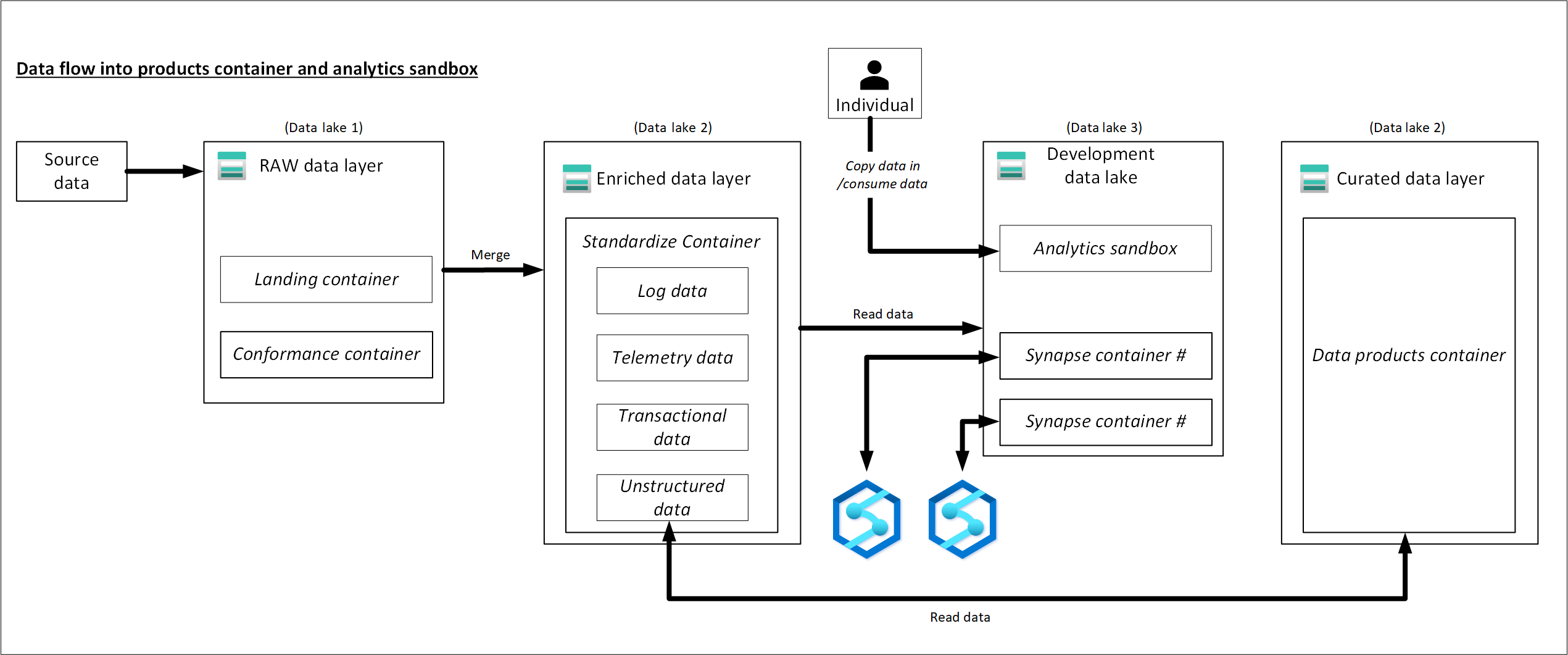

Contoh aliran data ke produk dan kotak pasir analitik

Diagram berikut mengkompilasi informasi dalam artikel ini dan memperlihatkan bagaimana data mengalir ke produk data dan kotak pasir analitik.