Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Azure Container Apps menyediakan akses ke GPU sesuai permintaan tanpa Anda harus mengelola infrastruktur yang mendasar. Sebagai fitur tanpa server, Anda hanya membayar GPU yang digunakan. Saat diaktifkan, jumlah GPU yang digunakan untuk aplikasi Anda naik dan turun untuk memenuhi tuntutan beban aplikasi Anda. GPU tanpa server memungkinkan Anda menjalankan beban kerja dengan mulus dengan penskalakan otomatis, mulai dingin yang dioptimalkan, penagihan per detik dengan menurunkan skala menjadi nol saat tidak digunakan, dan mengurangi overhead operasional.

GPU serverless hanya didukung untuk profil beban kerja konsumsi. Fitur ini tidak didukung untuk lingkungan yang hanya digunakan untuk Konsumsi.

Catatan

Anda harus meminta kuota GPU untuk mengakses GPU. Anda dapat mengirimkan permintaan kuota GPU Anda melalui kasus dukungan pelanggan.

Keuntungan

GPU tanpa server mempercepat pengembangan AI dengan memungkinkan Anda untuk fokus pada kode AI inti Anda dan kurang mengelola infrastruktur saat menggunakan GPU. Fitur ini menyediakan opsi lapisan tengah antara API tanpa server dari katalog model Azure AI dan model hosting di komputasi yang terkelola.

Dukungan GPU tanpa server Container Apps menyediakan tata kelola data penuh karena data Anda tidak pernah meninggalkan batas kontainer Anda sambil tetap menyediakan platform tanpa server terkelola untuk membangun aplikasi Anda.

Saat Anda menggunakan GPU tanpa server di Container Apps, aplikasi Anda mendapatkan:

Skala ke nol GPU: Dukungan untuk penskalaan tanpa server otomatis GPU NVIDIA A100 dan NVIDIA T4.

Penagihan per detik: Bayar hanya untuk komputasi GPU yang Anda gunakan.

Tata kelola data bawaan: Data Anda tidak pernah meninggalkan batas kontainer.

Opsi komputasi fleksibel: Anda dapat memilih antara jenis GPU NVIDIA A100 atau T4.

Lapisan tengah untuk pengembangan AI: Bawa model Anda sendiri pada platform komputasi tanpa server terkelola.

Skenario umum

Skenario berikut menjelaskan kasus penggunaan umum untuk GPU tanpa server.

Inferensi real-time dan batch: Gunakan model sumber terbuka kustom dengan waktu mulai yang cepat, skala otomatis, dan model penagihan per detik. GPU tanpa server sangat ideal untuk aplikasi dinamis. Anda hanya membayar untuk pemrosesan yang Anda gunakan, dan aplikasi Anda secara otomatis meningkatkan dan menurunkan skala untuk memenuhi permintaan.

Skenario pembelajaran mesin: Secara signifikan mempercepat aplikasi yang menerapkan model AI generatif kustom yang disempurnakan, pembelajaran mendalam, jaringan neural, atau analisis data skala besar.

High-Performance Computing (HPC): Gunakan GPU sebagai sumber daya untuk tuntutan komputasi tinggi dalam aplikasi yang memerlukan perhitungan dan simulasi kompleks, seperti komputasi ilmiah, pemodelan keuangan, atau prakiraan cuaca.

Rendering dan Visualisasi: Gunakan GPU untuk mempercepat proses penyajian dan mengaktifkan visualisasi real-time dalam aplikasi yang melibatkan penyajian 3D, pemrosesan gambar, atau transcoding video.

Big Data Analytics: GPU dapat mempercepat pemrosesan dan analisis data di antara himpunan data besar- besaran.

Pertimbangan

Ingatlah item berikut saat Anda menggunakan GPU tanpa server:

Versi CUDA: GPU Tanpa Server mendukung versi CUDA terbaru.

Batasan dukungan:

- Hanya satu kontainer dalam aplikasi yang dapat menggunakan GPU pada satu waktu. Jika Anda memiliki beberapa kontainer dalam aplikasi, kontainer pertama mendapatkan akses ke GPU.

- Beberapa aplikasi dapat berbagi profil beban kerja GPU yang sama tetapi masing-masing memerlukan replika mereka sendiri.

- Replika GPU multi dan fraksional tidak didukung.

- Kontainer pertama dalam aplikasi Anda mendapatkan akses ke GPU.

Alamat IP: GPU konsumsi menggunakan satu alamat IP per replika saat Anda menyiapkan integrasi dengan jaringan virtual Anda sendiri.

Wilayah yang didukung

GPU tanpa server tersedia di wilayah berikut:

| Wilayah | A100 | T4 |

|---|---|---|

| Australia Timur | Ya | Ya |

| Brasil Selatan | Ya | Ya |

| India Tengah | Tidak. | Ya |

| US Timur | Ya | Ya |

| Prancis Tengah | Tidak. | Ya |

| Italia Utara | Ya | Ya |

| Jepang Timur | Tidak. | Ya |

| US Tengah Utara | Tidak. | Ya |

| US Tengah Selatan | Tidak. | Ya |

| Asia Tenggara | Tidak. | Ya |

| India Selatan | Tidak. | Ya |

| Swedia Tengah | Ya | Ya |

| Eropa Barat1 | Tidak. | Ya |

| US Barat | Ya | Ya |

| Barat AS 2 | Tidak. | Ya |

| Barat AS 3 | Ya | Ya |

1 Untuk menambahkan profil beban kerja GPU tanpa server T4 di Eropa Barat, Anda harus membuat lingkungan profil beban kerja baru di wilayah tersebut.

Menggunakan GPU tanpa server

Saat membuat aplikasi kontainer melalui portal Azure, Anda dapat menyiapkan kontainer untuk menggunakan sumber daya GPU.

Di tab Kontainer dari proses pembuatan, atur pengaturan berikut:

Di bawah bagian Alokasi sumber daya kontainer , pilih kotak centang GPU .

Untuk Jenis GPU, pilih opsi NVIDIA A100 atau NVIDIA T4.

Mengelola profil beban kerja GPU tanpa server

GPU serverless dioperasikan berdasarkan profil beban kerja GPU berbasis konsumsi. Anda mengelola profil beban kerja GPU konsumsi dengan cara yang sama seperti profil beban kerja lainnya. Anda dapat mengelola profil beban kerja dengan menggunakan CLI atau portal Microsoft Azure.

Meminta kuota GPU tanpa server

Catatan

Pelanggan dengan perjanjian perusahaan dan pelanggan bayar sesuai penggunaan memiliki kuota A100 dan T4 yang diaktifkan secara default.

Anda memerlukan kuota GPU tanpa server untuk mengakses fitur ini. Anda dapat mengirimkan permintaan kuota GPU Anda melalui kasus dukungan pelanggan. Saat membuka kasus dukungan untuk permintaan kuota GPU, pilih opsi berikut:

Buka formulir Permintaan dukungan baru di portal Microsoft Azure.

Masukkan nilai berikut ke dalam formulir:

Harta benda Nilai Jenis masalah Pilih Batas layanan dan langganan (kuota) Subscription Pilih langganan Anda. Jenis kuota Pilih Aplikasi Kontainer. Pilih Selanjutnya.

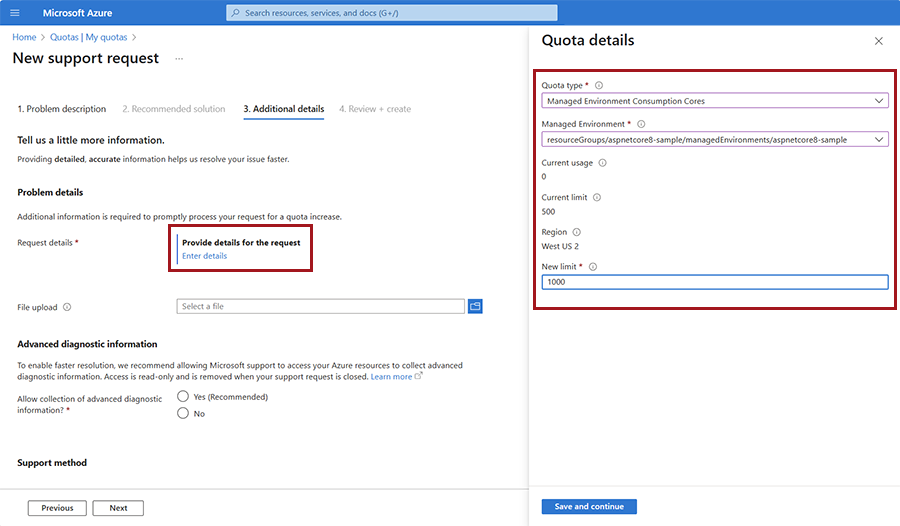

Di jendela Detail tambahan , pilih Masukkan detail untuk membuka jendela detail permintaan.

Untuk Jenis kuota, pilih Konsumsi Lingkungan Terkelola Gpu NCA100 atau Gpu T4 Konsumsi Lingkungan Terkelola. Masukkan nilai Anda yang lain.

Pilih Simpan dan lanjutkan.

Isi detail yang relevan lainnya di jendela Detail tambahan .

Pilih Selanjutnya.

Pilih Buat.

Meningkatkan awal dingin GPU

Anda dapat secara signifikan meningkatkan waktu startup dengan mengaktifkan aliran artefak dan menemukan file besar, seperti model bahasa besar, dalam mount penyimpanan.

Streaming artefak: Azure Container Registry menawarkan streaming gambar, yang dapat mempercepat waktu mulai gambar secara signifikan. Untuk menggunakan streaming artefak, Anda harus menghosting gambar kontainer Anda di Azure Container Registry premium.

Pemasangan penyimpanan: Kurangi efek latensi jaringan dengan menyimpan file besar di akun penyimpanan Azure yang terkait dengan aplikasi kontainer Anda.

Menyebarkan model Foundry ke GPU tanpa server (pratinjau)

GPU tanpa server dalam Azure Container Apps sekarang mendukung model Azure AI Foundry dalam pratinjau publik. Model Foundry Azure AI memiliki dua opsi penyebaran:

API tanpa server yang menyediakan penagihan bayar sesuai penggunaan untuk beberapa model paling populer.

Komputasi terkelola yang memungkinkan Anda menyebarkan pilihan lengkap model Foundry dengan harga bayar per GPU.

GPU tanpa server Azure Container Apps menawarkan opsi penyebaran seimbang antara API tanpa server dan komputasi terkelola bagi Anda untuk menyebarkan model Foundry. Opsi ini sesuai permintaan dengan penskalaan tanpa server yang menskalakan ke nol saat tidak digunakan dan mematuhi kebutuhan residensi data Anda. Dengan GPU tanpa server, menggunakan model Foundry memberi Anda fleksibilitas untuk menjalankan model apa pun yang didukung dengan penskalaan otomatis, harga bayar per detik, tata kelola data penuh, jaringan perusahaan siap pakai, dan dukungan keamanan.

Model bahasa jenis MLFLOW didukung. Untuk melihat daftar MLFLOW model, buka daftar model yang tersedia di registri azureml. Untuk menemukan model, tambahkan filter untuk MLFLOW model menggunakan langkah-langkah berikut:

Pilih Filter.

Pilih Tambahkan filter.

Untuk aturan filter, masukkan Jenis = MLFLOW.

Untuk model yang tercantum di sini di repositori Azure Container Apps, Anda dapat menyebarkannya langsung ke GPU tanpa server tanpa perlu membangun gambar Anda sendiri dengan menggunakan perintah CLI berikut:

az containerapp up \

--name <CONTAINER_APP_NAME> \

--location <LOCATION> \

--resource-group <RESOURCE_GROUP_NAME> \

--model-registry <MODEL_REGISTRY_NAME> \

--model-name <MODEL_NAME> \

--model-version <MODEL_VERSION>

Untuk model apa pun yang tidak ada dalam daftar ini, Anda perlu:

Unduh templat GitHub untuk gambar model dari repositori Azure Container Apps.

Ubah file score.py agar sesuai dengan jenis model Anda. Skrip penilaian (bernama score.py) menentukan cara Anda berinteraksi dengan model. Contoh berikut menunjukkan cara menggunakan file score.py kustom.

Buat gambar dan sebarkan ke registri kontainer.

Gunakan perintah CLI sebelumnya untuk menyebarkan model ke GPU tanpa server, tetapi tentukan

--image. Saat Anda menggunakan parameter--model-registry,--model-name, dan--model-version, variabel lingkungan utama diatur untuk mengoptimalkan cold start aplikasi Anda.

Kirim umpan balik

Kirim masalah ke repositori GitHub Azure Container Apps.