AI yang bertanggung jawab dan terpercaya

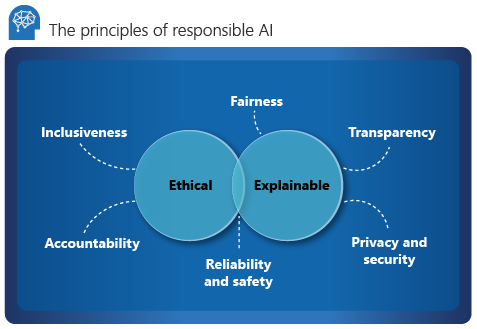

Microsoft menguraikan enam prinsip utama untuk AI yang bertanggung jawab: akuntabilitas, inklusivitas, keandalan dan keamanan, keadilan, transparansi, serta privasi dan keamanan. Prinsip-prinsip ini sangat penting untuk menciptakan AI yang bertanggung jawab dan dapat dipercaya saat berpindah ke produk dan layanan mainstream. Mereka dipandu oleh dua perspektif: etis dan dapat dijelaskan.

Etis

Dari perspektif etika, AI harus:

- Bersikaplah adil dan inklusif dalam pernyataannya.

- Bertanggung jawab atas keputusannya.

- Tidak membeda-bedakan atau menghambat ras, disabilitas, atau latar belakang yang berbeda.

Pada tahun 2017, Microsoft mendirikan komite penasihat untuk AI, etika, dan efek dalam teknik dan penelitian (Aether). Tanggung jawab inti komite adalah untuk memberi saran tentang masalah, teknologi, proses, dan praktik terbaik untuk AI yang bertanggung jawab. Untuk mempelajari selengkapnya, lihat Memahami model tata kelola Microsoft - Aether + Office of Responsible AI.

Akuntabilitas

Akuntabilitas adalah pilar penting dari AI yang bertanggung jawab. Orang-orang yang merancang dan menyebarkan sistem AI perlu bertanggung jawab atas tindakan dan keputusannya, terutama saat kita maju menuju sistem yang lebih otonom.

Organisasi harus mempertimbangkan untuk membentuk badan peninjau internal yang memberikan pengawasan, wawasan, dan panduan tentang pengembangan dan penyebaran sistem AI. Panduan ini mungkin bervariasi tergantung pada perusahaan dan wilayah, dan itu harus mencerminkan perjalanan AI organisasi.

Inklusivitas

Inklusivitas mengamanatkan bahwa AI harus mempertimbangkan semua ras dan pengalaman manusia. Praktik desain inklusif dapat membantu pengembang memahami dan mengatasi potensi hambatan yang secara tidak sengaja dapat mengecualikan orang. Jika memungkinkan, organisasi harus menggunakan teknologi ucapan ke teks, teks ke ucapan, dan pengenalan visual untuk memberdayakan orang yang memiliki pendengaran, visual, dan gangguan lainnya.

Keandalan dan keamanan

Agar sistem AI dapat dipercaya, sistem harus dapat diandalkan dan aman. Penting bagi sistem untuk melakukan seperti yang awalnya dirancang dan merespons situasi baru dengan aman. Ketahanan inherennya harus mampu menghadapi manipulasi yang disengaja atau tidak disengaja.

Organisasi harus menetapkan pengujian dan validasi yang ketat untuk kondisi operasi untuk memastikan bahwa sistem merespons kasus tepi dengan aman. Ini harus mengintegrasikan metode pengujian A/B dan juara/penantang ke dalam proses evaluasi.

Performa sistem AI dapat terdegradasi dari waktu ke waktu. Sebuah organisasi perlu membangun proses pemantauan dan pelacakan model yang kuat untuk secara reaktif dan proaktif mengukur performa model (dan melatinanya kembali untuk modernisasi, seperlunya).

Dijelaskan

Kemampuan penjelasan membantu ilmuwan data, auditor, dan pembuat keputusan bisnis memastikan bahwa sistem AI dapat membenarkan keputusan mereka dan bagaimana mereka mencapai kesimpulan mereka. Penjelasan juga membantu memastikan kepatuhan terhadap kebijakan perusahaan, standar industri, dan peraturan pemerintah.

Seorang ilmuwan data harus dapat menjelaskan kepada pemangku kepentingan bagaimana mereka mencapai tingkat akurasi tertentu dan apa yang memengaruhi hasilnya. Demikian juga, untuk mematuhi kebijakan perusahaan, auditor membutuhkan alat yang memvalidasi model. Pembuat keputusan bisnis perlu mendapatkan kepercayaan dengan menyediakan model transparan.

Alat kemampuan menjelaskan

Microsoft telah mengembangkan InterpretML, toolkit sumber terbuka yang membantu organisasi mencapai kemampuan penjelasan model. Ini mendukung model kotak kaca dan kotak hitam:

Model kotak kaca dapat diinterpretasikan karena strukturnya. Untuk model ini, Explainable Boosting Machine (EBM) menyediakan status algoritma berdasarkan pohon keputusan atau model linier. EBM memberikan penjelasan tanpa kerugian dan dapat diedit oleh pakar domain.

Model kotak hitam lebih menantang untuk diinterpretasikan karena struktur internal yang kompleks, yakni jaringan saraf. Penjelas seperti penjelasan model-agnostik lokal yang dapat ditafsirkan (LIME) atau SHapley Additive exPlanations (SHAP) menafsirkan model ini dengan menganalisis hubungan antara input dan output.

Fairlearn adalah integrasi Azure Machine Learning dan toolkit sumber terbuka untuk antarmuka pengguna grafis AutoML dan SDK. Ini menggunakan penjelas untuk memahami apa yang terutama memengaruhi model, dan menggunakan pakar domain untuk memvalidasi pengaruh ini.

Untuk mempelajari selengkapnya tentang kemampuan penjelasan, jelajahi interpretabilitas model di Azure Machine Learning.

Keadilan

Keadilan adalah prinsip etika inti yang ingin dipahami dan diterapkan oleh semua manusia. Prinsip ini bahkan menjadi lebih penting ketika sistem AI sedang dikembangkan. Pemeriksaan dan keseimbangan utama perlu memastikan bahwa keputusan sistem tidak membeda-bedakan, atau mengekspresikan bias terhadap, kelompok atau individu berdasarkan jenis kelamin, ras, orientasi seksual, atau agama.

Microsoft menyediakan daftar periksa keadilan AI yang menawarkan panduan dan solusi untuk sistem AI. Solusi ini secara longgar dikategorikan ke dalam lima tahap: membayangkan, prototipe, membangun, meluncurkan, dan berkembang. Setiap tahap mencantumkan aktivitas uji kelayakan yang direkomendasikan yang membantu meminimalkan dampak ketidakwajaran dalam sistem.

Fairlearn terintegrasi dengan Azure Machine Learning dan mendukung ilmuwan data dan pengembang untuk menilai dan meningkatkan keadilan sistem AI mereka. Ini memberikan algoritma mitigasi ketidakadilan dan dasbor interaktif yang memvisualisasikan kewajaran model. Organisasi harus menggunakan toolkit dan menilai dengan ceratkan kewajaran model saat sedang dibangun. Kegiatan ini harus menjadi bagian integral dari proses ilmu data.

Pelajari cara mengurangi ketidakwajaran dalam model pembelajaran mesin.

Transparansi

Mencapai transparansi membantu tim memahami:

- Data dan algoritma yang digunakan untuk melatih model.

- Logika transformasi yang diterapkan ke data.

- Model akhir yang dihasilkan.

- Aset terkait model.

Informasi ini menawarkan wawasan tentang bagaimana model dibuat, sehingga tim dapat mereproduksinya dengan cara yang transparan. Snapshot dalam ruang kerja Azure Machine Learning mendukung transparansi dengan merekam atau melatih ulang semua aset dan metrik terkait pelatihan yang terlibat dalam eksperimen.

Privasi dan keamanan

Pemegang data diwajibkan untuk melindungi data dalam sistem AI. Privasi dan keamanan adalah bagian integral dari sistem ini.

Data pribadi perlu diamankan, dan akses ke data tersebut seharusnya tidak membahayakan privasi seseorang. Privasi diferensial Azure membantu melindungi dan menjaga privasi dengan mengacak data dan menambahkan kebisingan untuk menyembunyikan informasi pribadi dari ilmuwan data.

Pedoman AI manusia

Pedoman desain AI manusia terdiri dari 18 prinsip yang terjadi dalam empat periode: di awal, selama interaksi, saat salah, dan seiring waktu. Prinsip-prinsip ini membantu organisasi menghasilkan sistem AI yang lebih inklusif dan berpusat pada manusia.

Di awal

Klarifikasi apa yang dapat dilakukan sistem. Jika sistem AI menggunakan atau menghasilkan metrik, penting untuk menunjukkan semuanya dan bagaimana metrik tersebut dilacak.

Klarifikasi seberapa baik sistem dapat melakukan apa yang dilakukannya. Membantu pengguna memahami bahwa AI tidak sepenuhnya akurat. Tetapkan ekspektasi kapan sistem AI mungkin membuat kesalahan.

Selama interaksi

Tampilkan informasi yang relevan secara kontekstual. Berikan informasi visual yang terkait dengan konteks dan lingkungan pengguna saat ini, seperti hotel terdekat. Mengembalikan detail yang dekat dengan tujuan dan tanggal target.

Mengurangi bias sosial. Pastikan bahwa bahasa dan perilaku tidak memperkenalkan stereotip atau bias yang tidak diinginkan. Misalnya, fitur pelengkapan otomatis harus inklusif dari identitas gender.

Ketika salah

- Mendukung pemecatan yang efisien. Berikan mekanisme mudah untuk mengabaikan atau mematikan fitur atau layanan yang tidak diinginkan.

- Mendukung koreksi yang efisien. Berikan cara intuitif untuk mempermudah pengeditan, penyempurnaan, atau pemulihan.

- Perjelas mengapa sistem melakukan apa yang dilakukannya. Optimalkan AI yang dapat dijelaskan untuk menawarkan insight tentang pernyataan sistem AI.

Dari waktu ke waktu

- Ingat interaksi terbaru. Simpan riwayat interaksi untuk referensi di masa mendatang.

- Belajar dari perilaku pengguna. Personalisasi interaksi berdasarkan perilaku pengguna.

- Perbarui dan adaptasi dengan hati-hati. Batasi perubahan yang mengganggu, dan perbarui berdasarkan profil pengguna.

- Mendorong umpan balik terperinci. Kumpulkan umpan balik pengguna dari interaksi mereka dengan sistem AI.

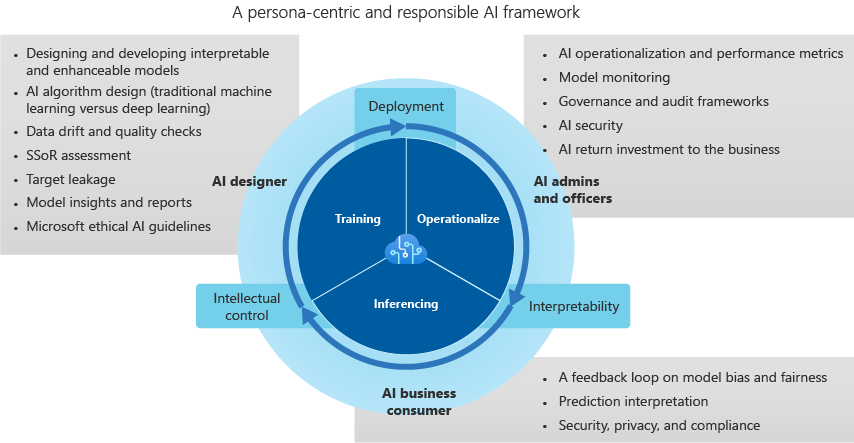

Kerangka kerja AI tepercaya

Perancang AI

Perancang AI membangun model dan bertanggung jawab untuk:

Memeriksa kualitas dan penyimpangan data. Perancang mendeteksi outlier dan melakukan pemeriksaan kualitas data untuk mengidentifikasi nilai yang hilang. Perancang juga menstandarkan distribusi, meneliti data, dan menghasilkan kasus penggunaan dan laporan proyek.

Menilai data dalam sumber sistem untuk mengidentifikasi potensi bias.

Merancang algoritma AI untuk meminimalkan bias data. Upaya ini termasuk menemukan bagaimana pengikatan, pengelompokan, dan normalisasi (terutama dalam model pembelajaran mesin tradisional seperti yang berbasis pohon) dapat menghilangkan grup minoritas dari data. Desain AI kategoris mengulangi bias data dengan mengelompokkan kelas sosial, ras, dan gender dalam vertikal industri yang bergantung pada informasi kesehatan yang dilindungi (PHI) dan data pribadi.

Mengoptimalkan pemantauan dan peringatan untuk mengidentifikasi kebocoran target dan memperkuat pengembangan model.

Menetapkan praktik terbaik untuk pelaporan dan wawasan yang menawarkan pemahaman terperinci tentang model. Perancang menghindari pendekatan kotak hitam yang menggunakan fitur atau kepentingan vektor, pengklusteran Uniform Manifold Approximation and Projection (UMAP), statistik H Friedman, efek fitur, dan teknik terkait. Metrik identifikasi membantu menentukan pengaruh prediktif, hubungan, dan dependensi antara korelasi dalam himpunan data yang kompleks dan modern.

Administrator dan pejabat AI

Administrator dan pejabat AI mengawasi operasi kerangka kerja AI, tata kelola, dan audit serta metrik performa. Mereka juga mengawasi bagaimana keamanan AI diterapkan dan pengembalian investasi bisnis. Tugas mereka meliputi:

Memantau dasbor pelacakan yang membantu pemantauan model dan menggabungkan metrik model untuk model produksi. Dasbor berfokus pada akurasi, degradasi model, penyimpangan data, penyimpangan, dan perubahan kecepatan/kesalahan inferensi.

Menerapkan penyebaran dan penyebaran ulang yang fleksibel (sebaiknya, melalui REST API) yang memungkinkan model diimplementasikan ke dalam arsitektur agnostik terbuka. Arsitektur mengintegrasikan model dengan proses bisnis dan menghasilkan nilai untuk perulangan umpan balik.

Bekerja untuk membangun tata kelola model dan akses untuk menetapkan batasan dan mengurangi dampak bisnis dan operasional yang negatif. Standar kontrol akses berbasis peran (RBAC) menentukan kontrol keamanan, yang mempertahankan lingkungan produksi terbatas dan IP.

Menggunakan kerangka kerja kepatuhan dan audit AI untuk melacak bagaimana model berkembang dan berubah untuk menegakkan standar khusus industri. AI yang dapat diinterpretasikan dan bertanggung jawab didasarkan pada langkah-langkah kemampuan menjelaskan, fitur ringkas, visualisasi model, dan bahasa vertikal industri.

Konsumen bisnis AI

Konsumen bisnis AI (pakar bisnis) menutup perulangan umpan balik dan memberikan masukan untuk perancang AI. Pengambilan keputusan prediktif dan implikasi potensi bias seperti keadilan dan tindakan etis, privasi dan kepatuhan, serta efisiensi bisnis membantu mengevaluasi sistem AI. Berikut adalah beberapa pertimbangan untuk konsumen bisnis:

Perulangan umpan balik milik ekosistem bisnis. Data yang menunjukkan bias, kesalahan, kecepatan prediksi, dan keadilan model membangun kepercayaan dan keseimbangan antara perancang, administrator, dan petugas AI. Penilaian yang ber sentris pada manusia harus secara bertahap meningkatkan AI dari waktu ke waktu.

Meminimalkan pembelajaran AI dari data multidimensi dan kompleks dapat membantu mencegah pembelajaran yang bias. Teknik ini disebut pembelajaran less-than-one-shot (LO-shot).

Menggunakan desain dan alat interpretasi menyimpan sistem AI yang bertanggung jawab atas potensi bias. Masalah bias dan keadilan model harus diberi bendera dan dimasukkan ke sistem deteksi peringatan dan anomali yang belajar dari perilaku ini dan secara otomatis mengatasi bias.

Setiap nilai prediktif harus dipecah menjadi fitur individual atau vektor berdasarkan kepentingan atau dampak. Ini harus memberikan penjelasan prediksi menyeluruh yang dapat diekspor ke dalam laporan bisnis untuk tinjauan audit dan kepatuhan, transparansi pelanggan, dan kesiapan bisnis.

Karena meningkatnya risiko keamanan dan privasi global, praktik terbaik untuk menyelesaikan pelanggaran data selama inferensi mengharuskan mematuhi peraturan dalam vertikal industri individu. Contohnya termasuk pemberitahuan tentang ketidakpatuhan terhadap PHI dan data pribadi, atau pemberitahuan tentang pelanggaran undang-undang keamanan nasional/regional.

Langkah berikutnya

Jelajahi pedoman AI manusia untuk mempelajari selengkapnya tentang AI yang bertanggung jawab.

Saran dan Komentar

Segera hadir: Sepanjang tahun 2024 kami akan menghentikan penggunaan GitHub Issues sebagai mekanisme umpan balik untuk konten dan menggantinya dengan sistem umpan balik baru. Untuk mengetahui informasi selengkapnya, lihat: https://aka.ms/ContentUserFeedback.

Kirim dan lihat umpan balik untuk