Mengelola kluster

Artikel ini menguraikan cara mengelola kluster Azure Databricks, termasuk menampilkan, mengedit, memulai, menghentikan, menghapus, mengontrol akses, serta memantau performa dan log.

Tampilkan kluster

Untuk melihat kluster di ruang kerja Anda, klik ![]() Komputasi di bar samping.

Komputasi di bar samping.

Di sisi kiri ada dua kolom yang menunjukkan apakah kluster telah disematkan dan status kluster. Arahkan mouse ke atas status untuk mendapatkan informasi selengkapnya.

Menyematkan kluster

30 hari setelah kluster dihentikan, itu dihapus secara permanen. Untuk mempertahankan konfigurasi kluster tujuan semua setelah kluster dihentikan selama lebih dari 30 hari, administrator dapat menyematkan kluster. Hingga 100 kluster dapat disematkan.

Admin dapat menyematkan kluster dari daftar kluster atau halaman detail kluster dengan mengklik ikon sematkan.

Anda juga dapat memanggil titik akhir Clusters API untuk menyematkan kluster secara terprogram.

Melihat konfigurasi kluster sebagai file JSON

Terkadang akan sangat berguna untuk melihat konfigurasi kluster Anda sebagai JSON. Ini sangat berguna ketika Anda ingin membuat kluster serupa menggunakan API Kluster. Saat Anda melihat kluster yang ada, buka tab Konfigurasi , klik JSON di kanan atas tab, salin JSON, dan tempelkan ke panggilan API Anda. Tampilan JSON bersifat baca-saja.

Mengedit kluster

Anda dapat mengedit konfigurasi kluster dari antarmuka pengguna detail kluster. Anda juga dapat memanggil titik akhir Clusters API untuk mengedit kluster secara terprogram.

Catatan

- Notebook dan pekerjaan yang dilampirkan ke kluster tetap terlampir setelah pengeditan.

- Pustaka yang diinstal pada kluster tetap terinstal setelah pengeditan.

- Jika Anda mengedit atribut apa pun dari kluster yang sedang berjalan (kecuali untuk ukuran dan izin kluster), Anda harus memulai ulang. Hal ini dapat mengganggu pengguna yang saat ini menggunakan kluster.

- Anda hanya dapat mengedit kluster yang sedang berjalan atau dihentikan. Namun, Anda dapat memperbarui izin untuk kluster yang tidak berada dalam status tersebut, pada halaman detail kluster.

Mengkloning kluster

Untuk mengkloning kluster yang ada, pilih Kloning dari menu kebab kluster  (juga dikenal sebagai menu tiga titik).

(juga dikenal sebagai menu tiga titik).

Setelah Anda memilih kloning, UI pembuatan kluster terbuka yang telah diisi sebelumnya dengan konfigurasi kluster. Atribut berikut tidak disertakan dalam kloning:

- Izin kluster

- Pustaka terinstal

- Notebook terlampir

Mengontrol akses ke kluster

Kontrol akses kluster dalam halaman pengaturan admin memungkinkan admin ruang kerja untuk memberikan akses kluster yang menenangkan kepada pengguna lain. Ada dua jenis kontrol akses kluster:

- Izin pembuatan kluster: Admin ruang kerja dapat memilih pengguna mana yang diizinkan untuk membuat kluster.

- Izin tingkat kluster: Pengguna yang memiliki izin Dapat mengelola untuk kluster dapat mengonfigurasi apakah pengguna lain dapat melampirkan, memulai ulang, mengubah ukuran, dan mengelola kluster tersebut.

Untuk mengedit izin untuk kluster, pilih Edit Izin dari menu kebab kluster tersebut  .

.

Untuk informasi selengkapnya tentang kontrol akses kluster dan izin tingkat kluster, lihat Kontrol akses kluster.

Menghentikan kluster

Untuk menyimpan sumber daya kluster, Anda dapat menghentikan kluster. Konfigurasi kluster yang dihentikan disimpan sehingga dapat digunakan kembali (atau, dalam kasus pekerjaan, autostarted) di lain waktu. Anda dapat menghentikan kluster secara manual atau mengonfigurasi kluster untuk dihentikan secara otomatis setelah periode tidak aktif yang ditentukan. Jika jumlah kluster yang dihentikan melebihi 150, kluster terlama dihapus.

Kecuali kluster disematkan atau dimulai ulang, kluster akan dihapus secara otomatis dan permanen 30 hari setelah penghentian.

Kluster yang dihentikan muncul dalam daftar kluster dengan lingkaran abu-abu di sebelah kiri nama kluster.

Catatan

Ketika Anda menjalankan pekerjaan di Kluster Pekerjaan Baru (yang biasanya direkomendasikan), kluster berhenti dan tidak dapat dimulai ulang ketika pekerjaan selesai. Di sisi lain, jika Anda menjadwalkan pekerjaan untuk dijalankan pada Kluster Serba Guna yang Ada yang telah dihentikan, kluster tersebut akan dimulai secara otomatis.

Penting

Jika Anda menggunakan ruang kerja Coba Gratis Premium, semua kluster yang sedang berjalan dihentikan:

- Saat Anda meningkatkan ruang kerja ke Premium lengkap.

- Jika ruang kerja tidak ditingkatkan dan coba gratis kedaluwarsa.

Penghentian manual

Anda dapat mengakhiri kluster secara manual dari daftar kluster (dengan mengklik kuadrat pada baris kluster) atau halaman detail kluster (dengan mengklik Hentikan).

Penghentian otomatis

Anda juga dapat mengatur penghentian otomatis untuk kluster. Selama pembuatan kluster, Anda dapat menentukan periode tidak aktif dalam hitungan menit setelah Anda ingin kluster dihentikan.

Jika perbedaan antara waktu saat ini dan perintah terakhir yang dijalankan pada kluster lebih dari periode tidak aktif yang ditentukan, Azure Databricks secara otomatis menghentikan kluster tersebut.

Kluster dianggap tidak aktif ketika semua perintah pada kluster, termasuk pekerjaan Spark, Streaming Terstruktur, dan panggilan JDBC, telah selesai dieksekusi.

Peringatan

- Kluster tidak melaporkan aktivitas yang dihasilkan dari penggunaan DStreams. Ini berarti bahwa kluster penghentian otomatis dapat dihentikan saat menjalankan D Aliran. Nonaktifkan penghentian otomatis untuk kluster yang menjalankan DStreams atau pertimbangkan untuk menggunakan Streaming Terstruktur.

- Fitur penghentian otomatis hanya memantau pekerjaan Spark, bukan proses lokal yang ditentukan pengguna. Oleh karena itu, jika semua pekerjaan Spark telah selesai, kluster dapat dihentikan, bahkan jika proses lokal sedang berjalan.

- Kluster diam terus mengakumulasi biaya instans DBU dan cloud selama periode tidak aktif sebelum penghentian.

Mengonfigurasi penghentian otomatis

Anda dapat mengonfigurasi penghentian otomatis di UI buat kluster. Pastikan bahwa kotak dicentang, dan masukkan jumlah menit dalam pengaturan Hentikan setelah ___ menit tidak aktif .

Anda dapat memilih keluar dari penghentian otomatis dengan menghapus kotak centang Penghentian Otomatis atau dengan menentukan periode tidak aktif 0.

Catatan

Penghentian otomatis paling baik didukung dalam versi Spark terbaru. Versi Spark yang lebih lama memiliki batasan yang diketahui yang dapat menyebabkan pelaporan aktivitas kluster yang tidak akurat. Misalnya, kluster yang menjalankan perintah JDBC, R, atau streaming dapat melaporkan waktu aktivitas kedaluwarsa yang menyebabkan penghentian kluster lebih awal. Silakan tingkatkan ke versi Spark terbaru untuk mendapatkan keuntungan dari perbaikan bug dan peningkatan penghentian otomatis.

Penghentian tak terduga

Terkadang kluster dihentikan secara tak terduga, bukan sebagai akibat dari penghentian manual atau penghentian otomatis yang dikonfigurasi.

Untuk daftar alasan penghentian dan langkah-langkah remediasi, lihat Pangkalan Pengetahuan.

Menghapus kluster

Menghapus kluster akan menghentikan kluster dan menghapus konfigurasinya. Untuk menghapus kluster, pilih Hapus dari menu kluster .

.

Peringatan

Anda tidak dapat membatalkan tindakan ini.

Untuk menghapus kluster yang disematkan, kluster tersebut harus terlebih dahulu tidak disematkan oleh administrator.

Anda juga dapat memanggil titik akhir Clusters API untuk menghapus kluster secara terprogram.

Menghidupkan ulang kluster

Anda dapat memulai ulang kluster yang dihentikan sebelumnya dari daftar kluster, halaman detail kluster, atau buku catatan. Anda juga dapat memanggil titik akhir Clusters API untuk memulai kluster secara terprogram.

Azure Databricks mengidentifikasi kluster menggunakan ID kluster uniknya. Saat Anda memulai kluster yang dihentikan, Databricks membuat ulang kluster dengan ID yang sama, secara otomatis menginstal semua pustaka, dan memasang ulang notebook.

Catatan

Jika Anda menggunakan ruang kerja Coba Gratis dan coba gratis telah kedaluwarsa, Anda tidak akan dapat memulai kluster.

Menghidupkan ulang kluster untuk memperbaruinya dengan gambar terbaru

Saat Anda menghidupkan ulang kluster, kluster mendapatkan gambar terbaru untuk kontainer sumber daya komputasi dan host VM. Penting untuk menjadwalkan mulai ulang reguler untuk kluster yang berjalan lama seperti yang digunakan untuk memproses data streaming.

Anda bertanggung jawab untuk menghidupkan ulang semua sumber daya komputasi secara teratur untuk menjaga gambar tetap terbaru dengan versi gambar terbaru.

Penting

Jika Anda mengaktifkan profil keamanan kepatuhan untuk akun atau ruang kerja Anda, kluster yang berjalan lama secara otomatis dimulai ulang setelah 25 hari. Databricks merekomendasikan agar admin ruang kerja memulai ulang kluster secara manual selama jendela pemeliharaan terjadwal. Ini mengurangi risiko hidupkan ulang otomatis yang mengganggu pekerjaan terjadwal.

Contoh buku catatan: Menemukan kluster yang berjalan lama

Jika Anda adalah admin ruang kerja, Anda dapat menjalankan skrip yang menentukan berapa lama setiap kluster Anda telah berjalan, dan secara opsional, hidupkan ulang jika lebih lama dari jumlah hari yang ditentukan. Azure Databricks menyediakan skrip ini sebagai buku catatan.

Baris pertama skrip menentukan parameter konfigurasi:

min_age_output: Jumlah hari maksimum kluster dapat berjalan. Defaultnya adalah 1.perform_restart: JikaTrue, skrip memulai ulang kluster dengan usia lebih besar dari jumlah hari yang ditentukan olehmin_age_output. Defaultnya adalahFalse, yang mengidentifikasi kluster yang berjalan lama tetapi tidak memulai ulang kluster.secret_configuration: GantiREPLACE_WITH_SCOPEdanREPLACE_WITH_KEYdengan cakupan rahasia dan nama kunci. Untuk detail selengkapnya tentang menyiapkan rahasia, lihat notebook.

Peringatan

Jika Anda mengatur perform_restart ke True, skrip secara otomatis memulai ulang kluster yang memenuhi syarat, yang dapat menyebabkan pekerjaan aktif gagal dan mengatur ulang notebook terbuka. Untuk mengurangi risiko mengganggu pekerjaan penting bagi bisnis ruang kerja Anda, rencanakan jendela pemeliharaan terjadwal dan pastikan untuk memberi tahu pengguna ruang kerja.

Mengidentifikasi dan secara opsional menghidupkan ulang buku catatan kluster yang berjalan lama

Mulai otomatis kluster untuk pekerjaan dan kueri JDBC/ODBC

Ketika pekerjaan yang ditetapkan ke kluster yang dihentikan dijadwalkan untuk dijalankan, atau Anda terhubung ke kluster yang dihentikan dari antarmuka JDBC/ODBC, kluster secara otomatis dimulai ulang. Lihat Membuat pekerjaan dan JDBC connect.

Mulai otomatis kluster memungkinkan Anda mengonfigurasi kluster untuk mengakhiri secara otomatis tanpa memerlukan intervensi manual untuk memulai ulang kluster untuk pekerjaan terjadwal. Selain itu, Anda dapat menjadwalkan inisialisasi kluster dengan menjadwalkan pekerjaan untuk dijalankan pada kluster yang dihentikan.

Sebelum kluster dimulai ulang secara otomatis, izin kontrol akses kluster dan pekerjaan diperiksa.

Catatan

Jika kluster Anda dibuat di platform Azure Databricks versi 2.70 atau versi lebih lama, tidak ada mulai otomatis: pekerjaan yang dijadwalkan berjalan pada kluster yang dihentikan akan gagal.

Melihat informasi kluster di UI Apache Spark

Anda dapat melihat informasi terperinci tentang pekerjaan Spark dengan memilih tab UI Spark di halaman detail kluster.

Jika Anda memulai ulang kluster yang dihentikan, UI Spark menampilkan informasi untuk kluster yang dimulai ulang, bukan informasi historis untuk kluster yang dihentikan.

Melihat log kluster

Azure Databricks menyediakan tiga jenis pencatatan aktivitas terkait kluster:

- Log peristiwa kluster, yang menangkap peristiwa siklus hidup kluster seperti pembuatan, penghentian, dan pengeditan konfigurasi.

- Driver Apache Spark dan log pekerja, yang dapat Anda gunakan untuk penelusuran kesalahan.

- Log skrip init kluster, yang berharga untuk men-debug skrip init.

Bagian ini membahas log peristiwa kluster dan log driver dan pekerja. Untuk detail tentang log init-script, lihat Pengelogan skrip init.

Log peristiwa kluster

Log peristiwa kluster menampilkan peristiwa siklus kluster penting yang dipicu secara manual oleh tindakan pengguna atau secara otomatis oleh Azure Databricks. Peristiwa tersebut mempengaruhi operasi kluster secara keseluruhan dan pekerjaan yang berjalan dalam kluster.

Untuk jenis peristiwa yang didukung, lihat struktur data Clusters API .

Peristiwa disimpan selama 60 hari, yang sebanding dengan waktu retensi data lainnya di Azure Databricks.

Melihat log peristiwa kluster

Untuk melihat log peristiwa kluster, pilih tab Log peristiwa pada halaman detail kluster.

Untuk informasi selengkapnya tentang suatu peristiwa, klik barisnya di log, lalu klik tab JSON untuk detailnya.

Log driver dan pekerja kluster

Pernyataan log dan cetak langsung dari notebook, pekerjaan, dan pustaka Anda masuk ke log driver Spark. Anda dapat mengakses file log ini dari tab Log driver di halaman detail kluster. Klik nama file log untuk mengunduhnya.

Log ini memiliki tiga output:

- Output standar

- Kesalahan standar

- Log log4j

Untuk melihat log pekerja Spark, gunakan tab UI Spark. Anda juga dapat mengonfigurasi lokasi pengiriman log untuk kluster. Log pekerja dan kluster dikirim ke lokasi yang Anda tentukan.

Memantau performa

Untuk membantu Anda memantau performa kluster Azure Databricks, Azure Databricks menyediakan akses ke metrik dari halaman detail kluster. Untuk Databricks Runtime 12.2 ke bawah, Azure Databricks menyediakan akses ke metrik Ganglia . Untuk Databricks Runtime 13.0 ke atas, metrik kluster disediakan oleh Azure Databricks.

Selain itu, Anda dapat mengonfigurasi kluster Azure Databricks untuk mengirim metrik ke ruang kerja Analitik Log di Azure Monitor, platform pemantauan untuk Azure.

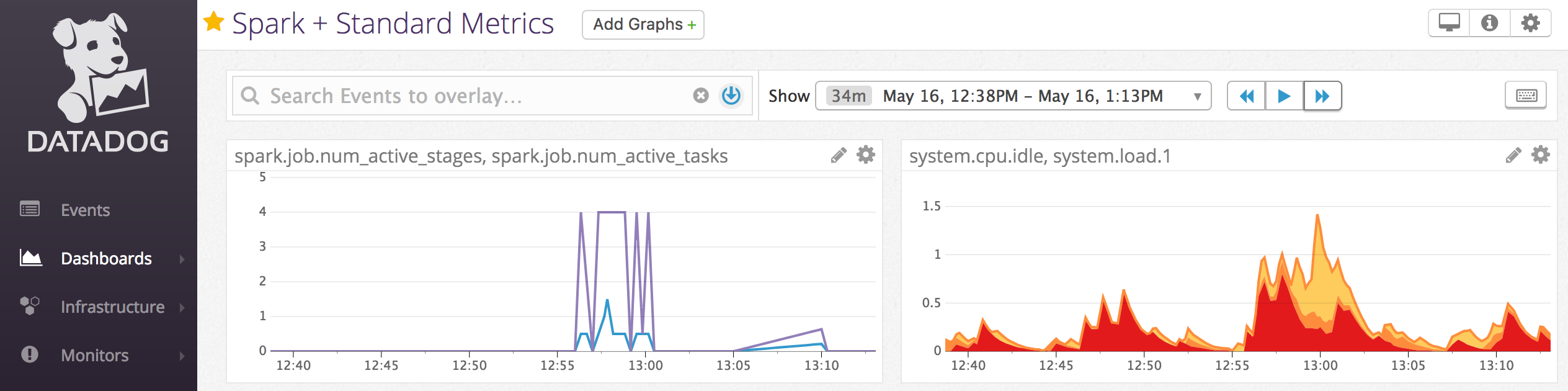

Anda juga dapat menginstal agen Datadog pada node kluster untuk mengirim metrik Datadog ke akun Datadog Anda.

Metrik kluster

Metrik kluster adalah alat pemantauan default untuk Databricks Runtime 13.0 ke atas. Untuk mengakses antarmuka pengguna metrik kluster, navigasikan ke tab Metrik pada halaman detail kluster.

Anda dapat melihat metrik historis dengan memilih rentang waktu menggunakan filter pemilih tanggal. Metrik dikumpulkan setiap menit. Anda juga bisa mendapatkan metrik terbaru dengan mengklik tombol Refresh . Untuk informasi selengkapnya, lihat Melihat metrik kluster langsung dan historis.

Metrik Ganglia

Catatan

Metrik Ganglia hanya tersedia untuk Databricks Runtime 12.2 ke bawah.

Untuk mengakses UI Ganglia, navigasikan ke tab Metrik di halaman detail kluster. Metrik CPU tersedia di UI Ganglia untuk semua Databricks runtime. Metrik GPU tersedia untuk kluster berkemampuan GPU.

Untuk melihat metrik langsung, klik link UI Ganglia.

Untuk melihat metrik historis, klik file snapshot. Snapshot berisi metrik gabungan untuk jam sebelum waktu yang dipilih.

Catatan

Ganglia tidak didukung dengan kontainer Docker. Jika Anda menggunakan kontainer Docker dengan kluster Anda, metrik Ganglia tidak akan tersedia.

Mengonfigurasi koleksi metrik Ganglia

Secara default, Azure Databricks mengumpulkan metrik Ganglia setiap 15 menit. Untuk mengonfigurasi periode pengumpulan, atur DATABRICKS_GANGLIA_SNAPSHOT_PERIOD_MINUTES variabel lingkungan menggunakan skrip init atau di spark_env_vars bidang di Buat API kluster baru.

Azure Monitor

Anda dapat mengonfigurasi kluster Azure Databricks untuk mengirim metrik ke ruang kerja Analitik Log di Azure Monitor, platform pemantauan untuk Azure. Untuk petunjuk lengkapnya, lihat Memantau Azure Databricks.

Catatan

Jika Anda telah menyebarkan ruang kerja Azure Databricks di jaringan virtual Anda sendiri dan Anda telah mengonfigurasi grup keamanan jaringan (NSG) untuk menolak semua lalu lintas keluar yang tidak diperlukan oleh Azure Databricks, maka Anda harus mengonfigurasi aturan keluar tambahan untuk tag layanan "AzureMonitor".

Contoh buku catatan: Metrik Datadog

Anda dapat menginstal agen Datadog di node kluster untuk mengirim metrik Datadog ke akun Datadog Anda. Notebook berikut menunjukkan cara menginstal agen Datadog pada kluster menggunakan skrip init yang tercakup kluster.

Untuk menginstal agen Datadog di semua kluster, kelola skrip init yang terlingkup kluster menggunakan kebijakan kluster.

Menginstal notebook skrip init agen Datadog

Instans spot penonaktifan

Karena instans spot dapat mengurangi biaya, membuat kluster menggunakan instans spot daripada instans atas permintaan adalah cara umum untuk menjalankan pekerjaan. Namun, instans spot dapat didahului oleh mekanisme penjadwalan penyedia cloud. Preemption instans spot dapat menyebabkan masalah pada pekerjaan yang sedang berjalan, termasuk:

- Kegagalan pengambilan acak

- Kehilangan data acak

- Kehilangan data RDD

- Kegagalan pekerjaan

Anda dapat mengaktifkan penonaktifan untuk membantu mengatasi masalah ini. Penonaktifan memanfaatkan pemberitahuan yang biasanya dikirim oleh penyedia cloud sebelum instans spot dinonaktifkan. Ketika instans spot yang berisi eksekutor menerima pemberitahuan preemption, proses penonaktifan akan mencoba memigrasikan data RDD dan acak ke eksekutor yang sehat. Durasi sebelum preemption akhir biasanya 30 detik hingga 2 menit, tergantung pada penyedia cloud.

Databricks merekomendasikan untuk mengaktifkan migrasi data saat penonaktifan juga diaktifkan. Umumnya, kemungkinan kesalahan menurun seiring dengan lebih banyak data yang dimigrasikan, termasuk kegagalan pengambilan acak, kehilangan data acak, dan kehilangan data RDD. Migrasi data juga dapat menyebabkan lebih sedikit komputasi ulang dan menghemat biaya.

Catatan

Penonaktifan adalah upaya terbaik dan tidak menjamin bahwa semua data dapat dimigrasikan sebelum pemindahan akhir. Penonaktifan tidak dapat menjamin terhadap kegagalan pengambilan acak saat menjalankan tugas mengambil data acak dari eksekutor.

Dengan penonaktifan yang aktif, kegagalan tugas yang disebabkan oleh preemption instans spot tidak ditambahkan ke jumlah total upaya yang gagal. Kegagalan tugas yang disebabkan oleh preemption tidak dihitung sebagai upaya yang gagal karena penyebab kegagalan adalah hal di luar tugas dan tidak akan mengakibatkan kegagalan pekerjaan.

Aktifkan penonaktifan

Untuk mengaktifkan penonaktifan pada kluster, masukkan properti berikut di tab Spark di bawah Opsi Tingkat Lanjut di antarmuka pengguna konfigurasi kluster. Untuk informasi tentang properti ini, lihat Konfigurasi Spark.

Untuk mengaktifkan penonaktifan aplikasi, masukkan properti ini di bidang konfigurasi Spark:

spark.decommission.enabled trueUntuk mengaktifkan migrasi data acak selama penonaktifan, masukkan properti ini di bidang konfigurasi Spark:

spark.storage.decommission.enabled true spark.storage.decommission.shuffleBlocks.enabled trueUntuk mengaktifkan migrasi data cache RDD selama penonaktifan, masukkan properti ini di bidang konfigurasi Spark:

spark.storage.decommission.enabled true spark.storage.decommission.rddBlocks.enabled trueCatatan

Ketika replikasi RDD StorageLevel ditetapkan menjadi lebih dari 1, Databricks tidak merekomendasikan mengaktifkan migrasi data RDD karena replika memastikan RDD tidak akan kehilangan data.

Untuk mengaktifkan penonaktifan untuk pekerja, masukkan properti ini di bidang Variabel Lingkungan:

SPARK_WORKER_OPTS="-Dspark.decommission.enabled=true"

Melihat status penonaktifan dan alasan kehilangan di UI

Untuk mengakses status penonaktifan pekerja dari UI, navigasikan ke tab Spark Cluster UI - Master .

Ketika penonaktifan selesai, Anda dapat melihat alasan kehilangan pelaksana di tab Pelaksana Spark UI > pada halaman detail kluster.