Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Penting

Fitur ini ada di Pratinjau Umum.

Artikel ini menjelaskan cara menggunakan buku catatan di Alur Deklaratif Lakeflow Spark untuk mengembangkan dan men-debug alur ETL.

Nota

Halaman ini menjelaskan pengalaman pengeditan buku catatan warisan. Pengalaman default yang direkomendasikan adalah Editor Pipeline Lakeflow. Anda dapat menggunakan Editor Alur Lakeflow untuk mengedit buku catatan, atau file kode Python atau SQL untuk alur. Untuk informasi selengkapnya, lihat Mengembangkan dan men-debug alur ETL dengan Editor Alur Lakeflow.

Untuk mengonfigurasi pengalaman buku catatan yang dijelaskan di halaman ini, Anda harus menonaktifkan Editor Alur Lakeflow. Lihat Mengaktifkan Editor Alur Lakeflow dan pemantauan yang diperbarui.

Gambaran umum buku catatan di Alur Deklaratif Lakeflow Spark

Saat Anda mengerjakan buku catatan Python atau SQL yang dikonfigurasi sebagai kode sumber untuk alur yang sudah ada, Anda bisa menyambungkan buku catatan langsung ke alur. Saat buku catatan tersambung ke alur, fitur berikut ini tersedia:

- Mulai dan validasi alur dari buku catatan.

- Tampilkan grafik aliran data alur dan log peristiwa untuk pembaruan terbaru di buku catatan.

- Lihat diagnostik pipeline di editor notebook.

- Lihat status kluster pipeline di notebook.

- Akses UI Lakeflow Spark Declarative Pipelines dari buku catatan.

Prasyarat

- Anda harus memiliki alur yang sudah ada dengan notebook Python atau SQL yang dikonfigurasi sebagai kode sumber.

- Anda harus menjadi pemilik jalur atau memiliki hak istimewa

CAN_MANAGE.

Keterbatasan

- Fitur yang tercakup dalam artikel ini hanya tersedia di notebook Azure Databricks. File ruang kerja tidak didukung.

- Terminal web tidak tersedia ketika dilampirkan ke alur kerja. Akibatnya, itu tidak terlihat sebagai tab di panel bawah.

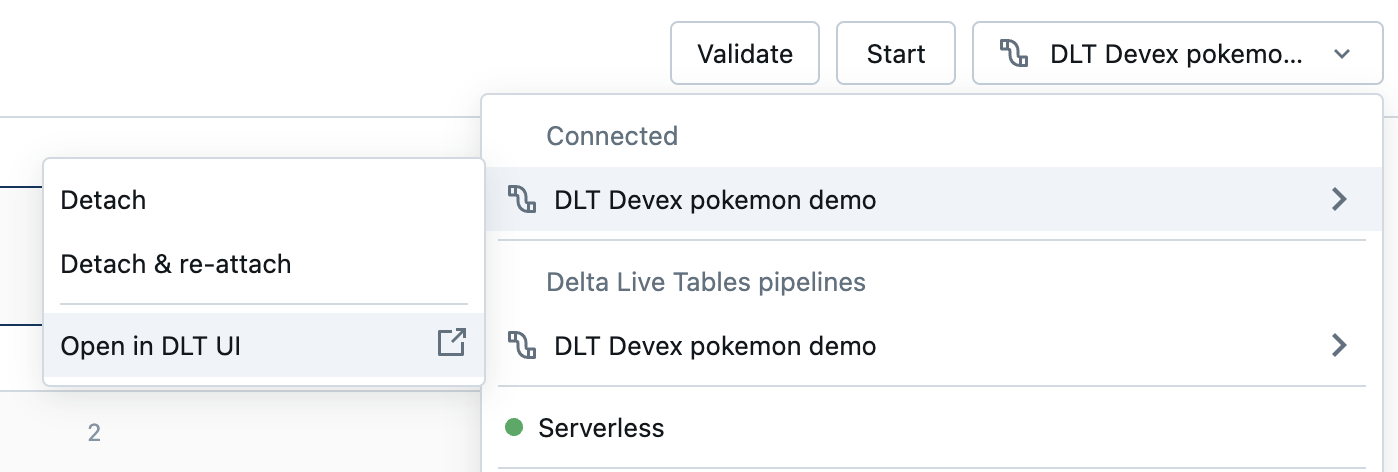

Menghubungkan laptop ke pipeline

Di dalam buku catatan, klik menu drop-down yang digunakan untuk memilih komputasi. Menu drop-down memperlihatkan semua Alur Deklaratif Lakeflow Spark Anda dengan buku catatan ini sebagai kode sumber. Untuk menyambungkan buku catatan ke rangkaian data, pilih buku catatan dari daftar.

Lihat status kluster alur

Untuk memahami dengan mudah keadaan kluster alur Anda, statusnya ditampilkan di menu drop-down komputasi dengan warna hijau yang mengindikasikan bahwa kluster sedang berjalan.

Validasi kode pipeline

Anda dapat memvalidasi pipeline untuk memeriksa kesalahan sintaks dalam kode sumber Anda tanpa memproses data apa pun.

Untuk memvalidasi alur, lakukan salah satu hal berikut ini:

- Di sudut kanan atas notebook, klik Validate.

- Tekan

Shift+Enterdi setiap sel notebook. - Di menu dropdown sel, klik Validasi Alur.

Nota

Jika Anda mencoba memvalidasi alur saat pembaruan yang ada sudah berjalan, kotak dialog akan menampilkan pertanyaan apakah Anda ingin mengakhiri pembaruan yang ada. Jika Anda mengklik Ya, pembaruan yang ada berhenti, dan memvalidasi pembaruan secara otomatis dimulai.

Mulai pembaruan pipeline

Untuk memulai pembaruan alur Anda, klik tombol Mulai di sudut kanan atas buku catatan. Lihat Menjalankan pembaruan alur.

Menampilkan status pembaruan

Panel atas di notebook menampilkan apakah pembaruan pipeline adalah:

- Mulai

- Memvalidasi

- Berhenti

Tampilkan kesalahan dan diagnosis

Setelah Anda memulai pembaruan atau validasi alur, kesalahan apa pun ditampilkan sebaris dengan garis bawah merah. Gerakkan kursor ke atas kesalahan untuk melihat informasi lebih lanjut.

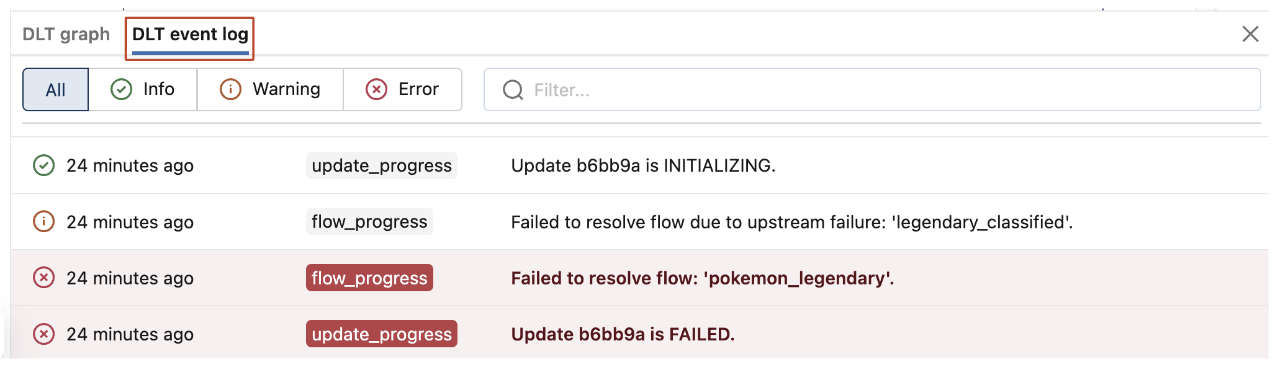

Lihat acara pipeline

Saat dilampirkan ke alur, ada tab log peristiwa Lakeflow Spark Declarative Pipelines di bagian bawah buku catatan.

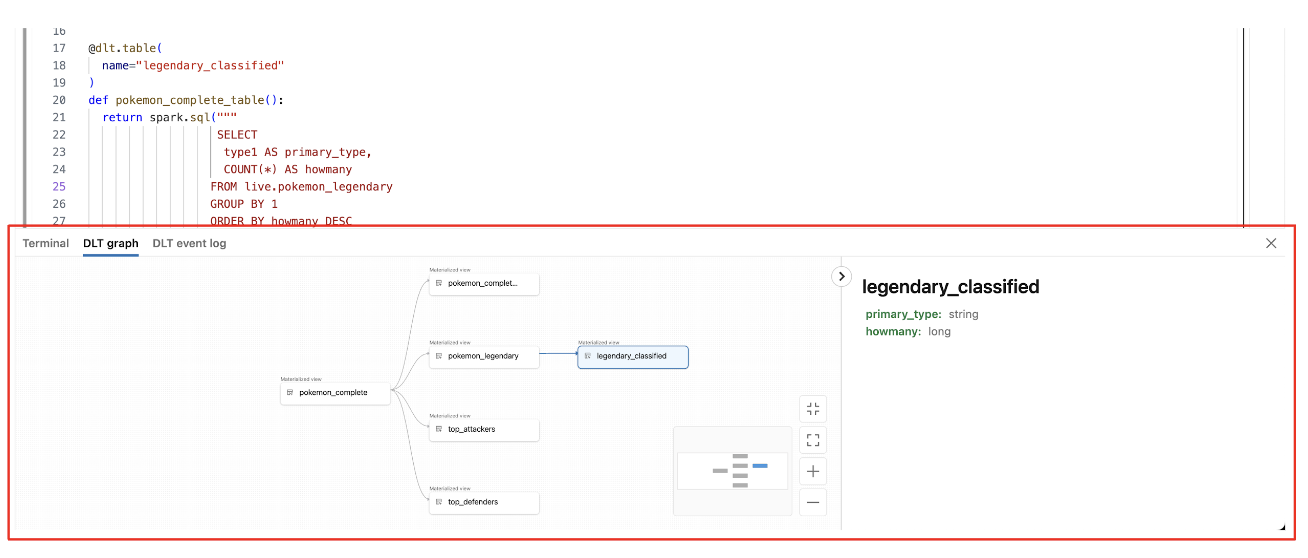

Melihat Grafik Jalur Aliran Data

Untuk menampilkan grafik aliran data alur, gunakan tab grafik Alur Deklaratif Lakeflow Spark di bagian bawah buku catatan. Memilih simpul dalam grafik menampilkan skemanya di panel kanan.

Cara mengakses UI Alur Deklaratif Lakeflow Spark dari buku catatan

Untuk melompat dengan mudah ke UI Alur Deklaratif Lakeflow Spark, gunakan menu di sudut kanan atas buku catatan.

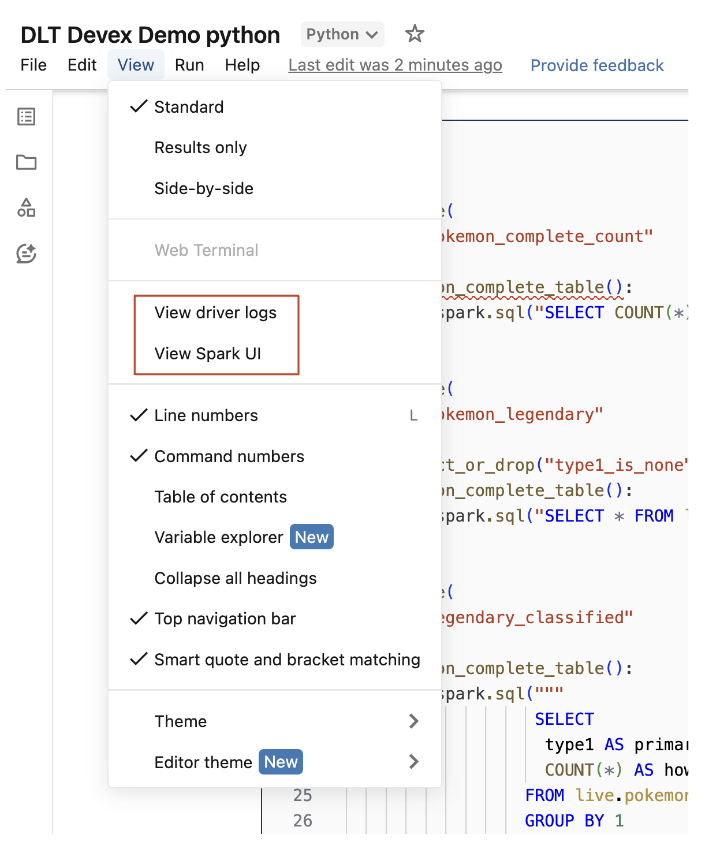

Mengakses log driver dan UI Spark dari buku catatan

Log driver dan antarmuka pengguna Spark yang terkait dengan alur yang sedang dikembangkan dapat dengan mudah diakses dari menu Tampilan buku catatan.