Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Pelajari cara menambahkan penyeimbangan beban ke aplikasi Anda untuk memperluas aplikasi obrolan di luar batas token Layanan Azure OpenAI dan kuota model. Pendekatan ini menggunakan Azure Container Apps untuk membuat tiga titik akhir Azure OpenAI dan kontainer utama untuk mengarahkan lalu lintas masuk ke salah satu dari tiga titik akhir.

Artikel ini mengharuskan Anda untuk menyebarkan dua sampel terpisah:

Aplikasi obrolan

Jika Anda belum menyebarkan aplikasi obrolan, tunggu hingga contoh penyeimbang beban disebarkan.

Jika Anda sudah menyebarkan aplikasi obrolan sekali, ubah variabel lingkungan untuk mendukung titik akhir kustom untuk load balancer dan sebarkan ulang lagi.

Aplikasi obrolan tersedia dalam bahasa berikut:

Aplikasi load balancer

Nota

Artikel ini menggunakan satu atau beberapa templat aplikasi AI sebagai dasar untuk contoh dan panduan dalam artikel. Templat aplikasi AI memberi Anda implementasi referensi yang terawat dengan baik yang mudah disebarkan. Ini membantu memastikan titik awal berkualitas tinggi untuk aplikasi AI Anda.

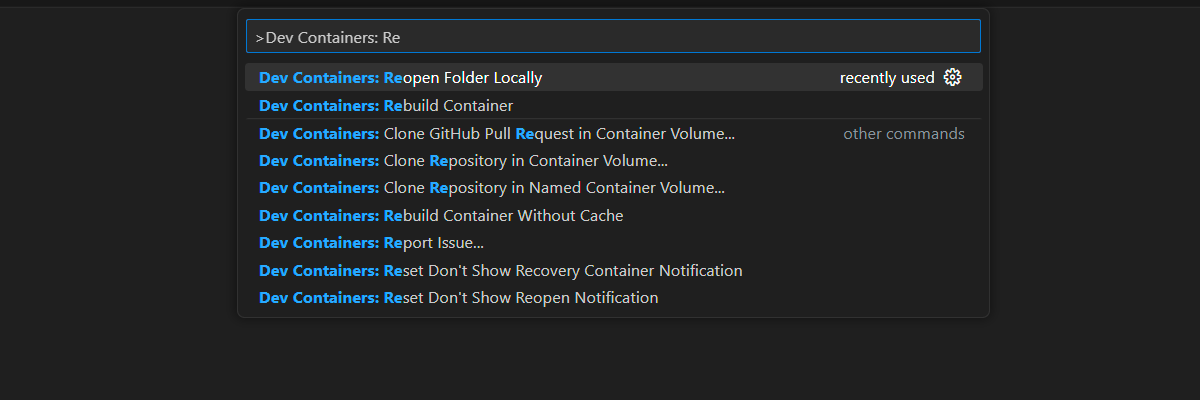

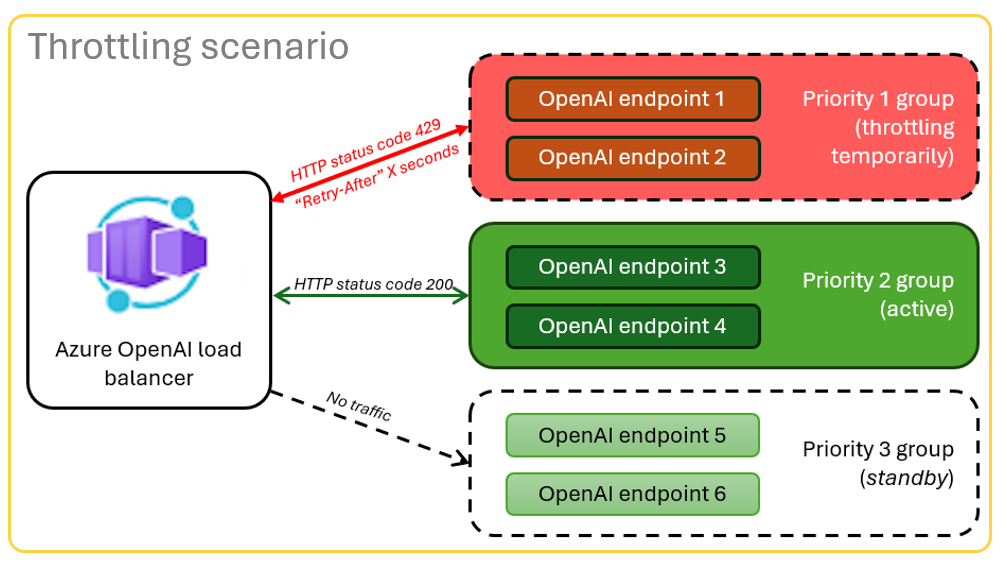

Arsitektur untuk penyeimbangan beban Azure OpenAI dengan Azure Container Apps

Karena sumber daya Azure OpenAI memiliki batas token dan kuota model tertentu, aplikasi obrolan yang menggunakan satu sumber daya Azure OpenAI rentan mengalami kegagalan percakapan karena batas tersebut.

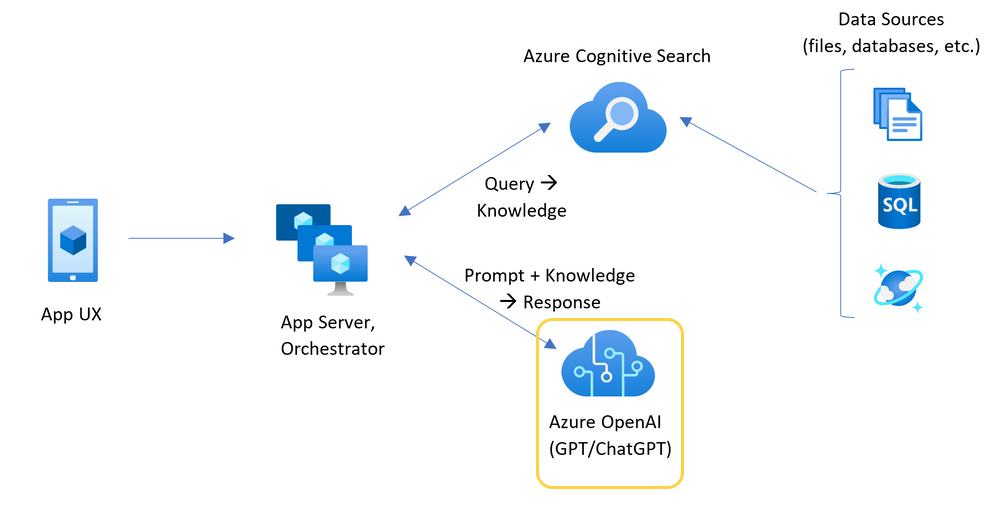

Untuk menggunakan aplikasi obrolan tanpa mencapai batas tersebut, gunakan solusi penyeimbang beban dengan Aplikasi Kontainer. Solusi ini dengan lancar mengekspos satu endpoint dari Container Apps ke server aplikasi chat Anda.

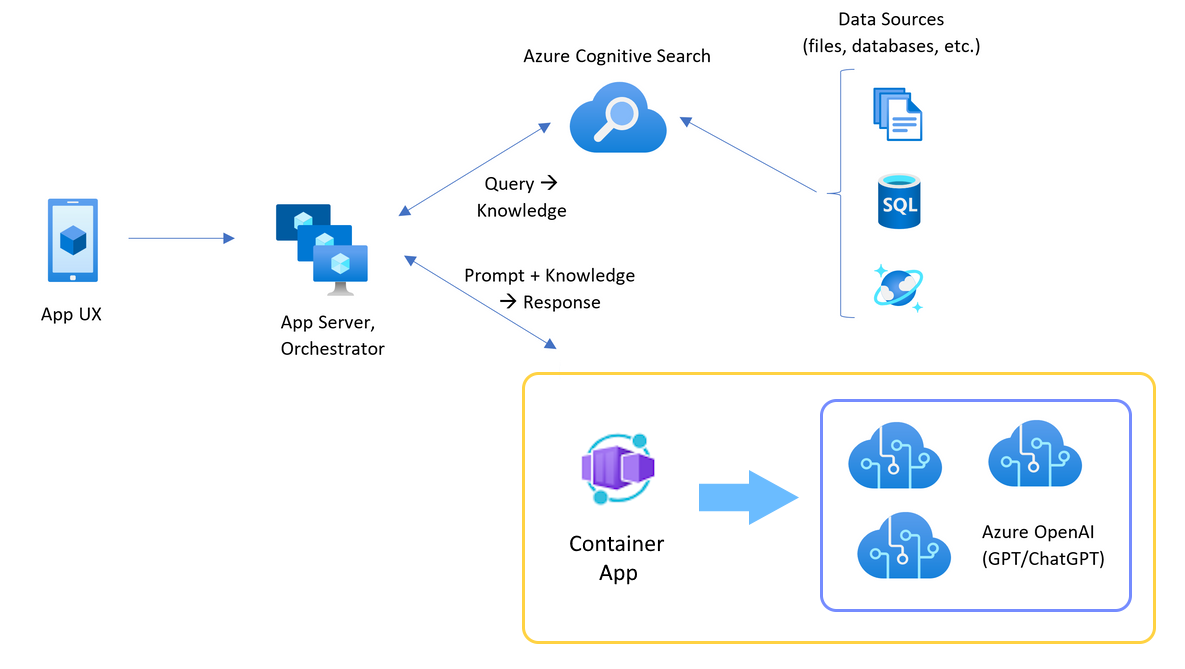

Aplikasi kontainer berada di depan sekumpulan sumber daya Azure OpenAI. Aplikasi kontainer menangani dua skenario: normal dan terkendali. Dalam skenario normal di mana token dan kuota model tersedia, sumber daya Azure OpenAI mengirimkan respon 200 melalui aplikasi kontainer dan server aplikasi.

Saat sumber daya berada dalam skenario dibatasi karena pembatasan kuota, aplikasi kontainer dapat segera mencoba sumber daya Azure OpenAI yang berbeda untuk memenuhi permintaan aplikasi obrolan asli.

Prasyarat

Sebuah langganan Azure. Buat satu secara gratis

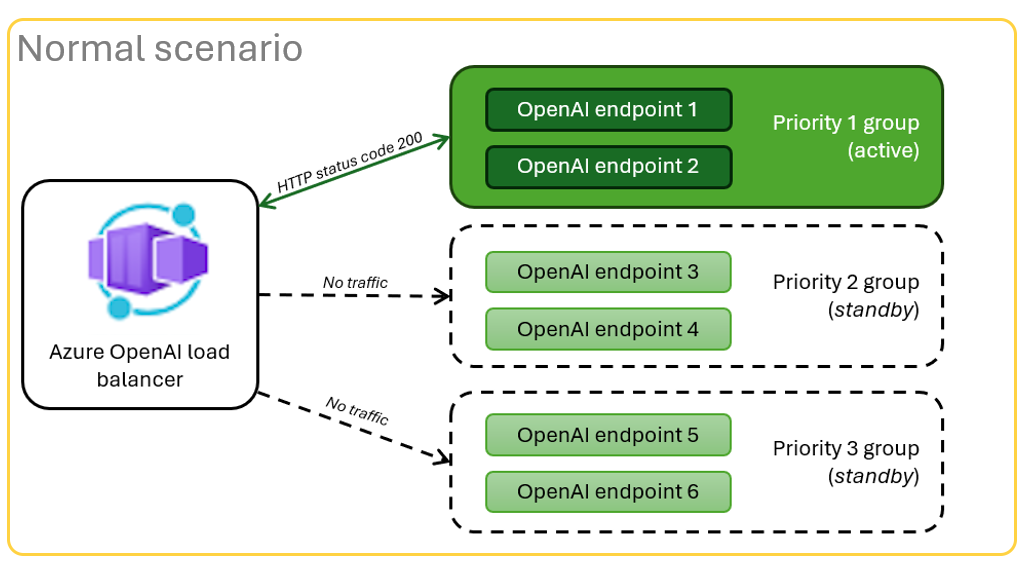

Kontainer pengembangan tersedia untuk kedua contoh, beserta semua dependensi yang diperlukan untuk menyelesaikan artikel ini. Anda dapat menjalankan kontainer dev di GitHub Codespaces di browser, atau secara lokal menggunakan Visual Studio Code.

- «Codespaces (disarankan)»

- Visual Studio Code

- Akun GitHub.

Buka aplikasi contoh penyeimbang beban Container Apps

- GitHub Codespaces (disarankan)

- Visual Studio Code

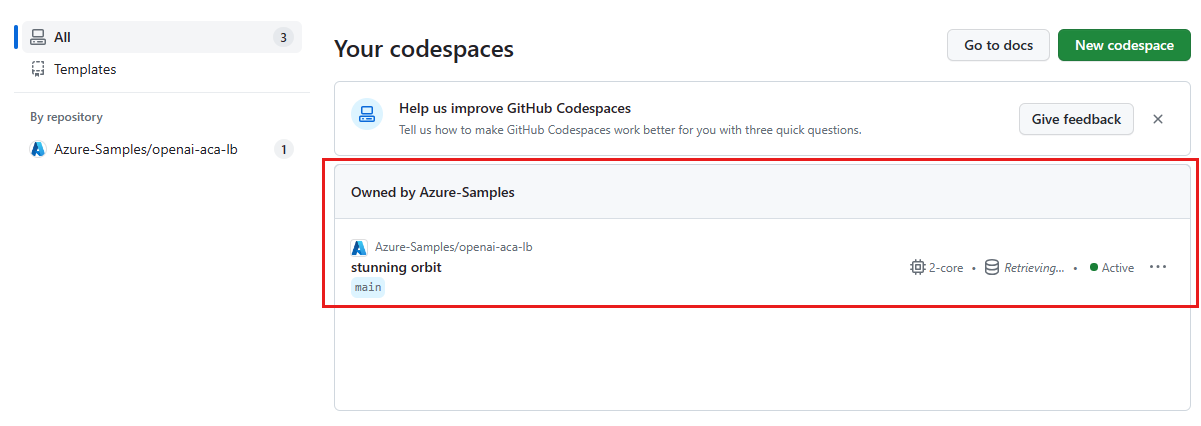

GitHub Codespaces menjalankan kontainer pengembangan yang dikelola oleh GitHub dengan Visual Studio Code untuk Web sebagai antarmuka pengguna. Untuk lingkungan pengembangan yang paling mudah, gunakan GitHub Codespaces sehingga Anda memiliki alat dan dependensi pengembang yang benar yang telah diinstal sebelumnya untuk menyelesaikan artikel ini.

Penting

Semua akun GitHub dapat menggunakan GitHub Codespaces hingga 60 jam gratis setiap bulan dengan dua instans inti. Untuk informasi selengkapnya, lihat penyimpanan dan jam inti yang disertakan setiap bulan di GitHub Codespaces.

Mendistribusikan penyeimbang beban Azure Container Apps

Masuk ke Azure Developer CLI untuk menyediakan autentikasi ke langkah-langkah provisi dan penyebaran:

azd auth login --use-device-codeAtur variabel lingkungan untuk menggunakan autentikasi Azure CLI untuk langkah setelah penyediaan:

azd config set auth.useAzCliAuth "true"Sebarkan aplikasi load balancer:

azd upPilih langganan dan wilayah untuk penyebaran. Mereka tidak harus berlangganan dan berada di wilayah yang sama dengan aplikasi obrolan.

Tunggu sampai proses penyebaran selesai sebelum Anda melanjutkan.

Dapatkan titik akhir penyebaran

Gunakan perintah berikut untuk menampilkan titik akhir yang disebarkan untuk aplikasi kontainer:

azd env get-valuesSalin nilai

CONTAINER_APP_URL. Anda akan menggunakannya di bagian selanjutnya.

Menyebarkan ulang aplikasi obrolan dengan titik akhir penyeimbang beban

Contoh-contoh ini diselesaikan pada sampel aplikasi obrolan.

- Penyebaran awal

- Penyebaran Ulang

Buka kontainer pengembangan sampel aplikasi obrolan dengan menggunakan salah satu pilihan berikut.

Bahasa GitHub Codespaces Visual Studio Code .NET JavaScript Phyton Masuk ke Azure Developer CLI (

AZD):azd auth loginSelesaikan instruksi masuk.

Buat lingkungan

AZDdengan nama sepertichat-app:azd env new <name>Tambahkan variabel lingkungan berikut, yang memberi tahu backend aplikasi obrolan untuk menggunakan URL kustom untuk permintaan Azure OpenAI:

azd env set OPENAI_HOST azure_customTambahkan variabel lingkungan berikut. Ganti

<CONTAINER_APP_URL>untuk URL dari bagian sebelumnya. Tindakan ini memberi tahu backend aplikasi obrolan berapa nilai URL kustom untuk permintaan Azure OpenAI.azd env set AZURE_OPENAI_CUSTOM_URL <CONTAINER_APP_URL>Sebarkan aplikasi obrolan:

azd up

Gunakan aplikasi obrolan dengan keyakinan bahwa aplikasi tersebut dapat menampung banyak pengguna tanpa menghabiskan kuota.

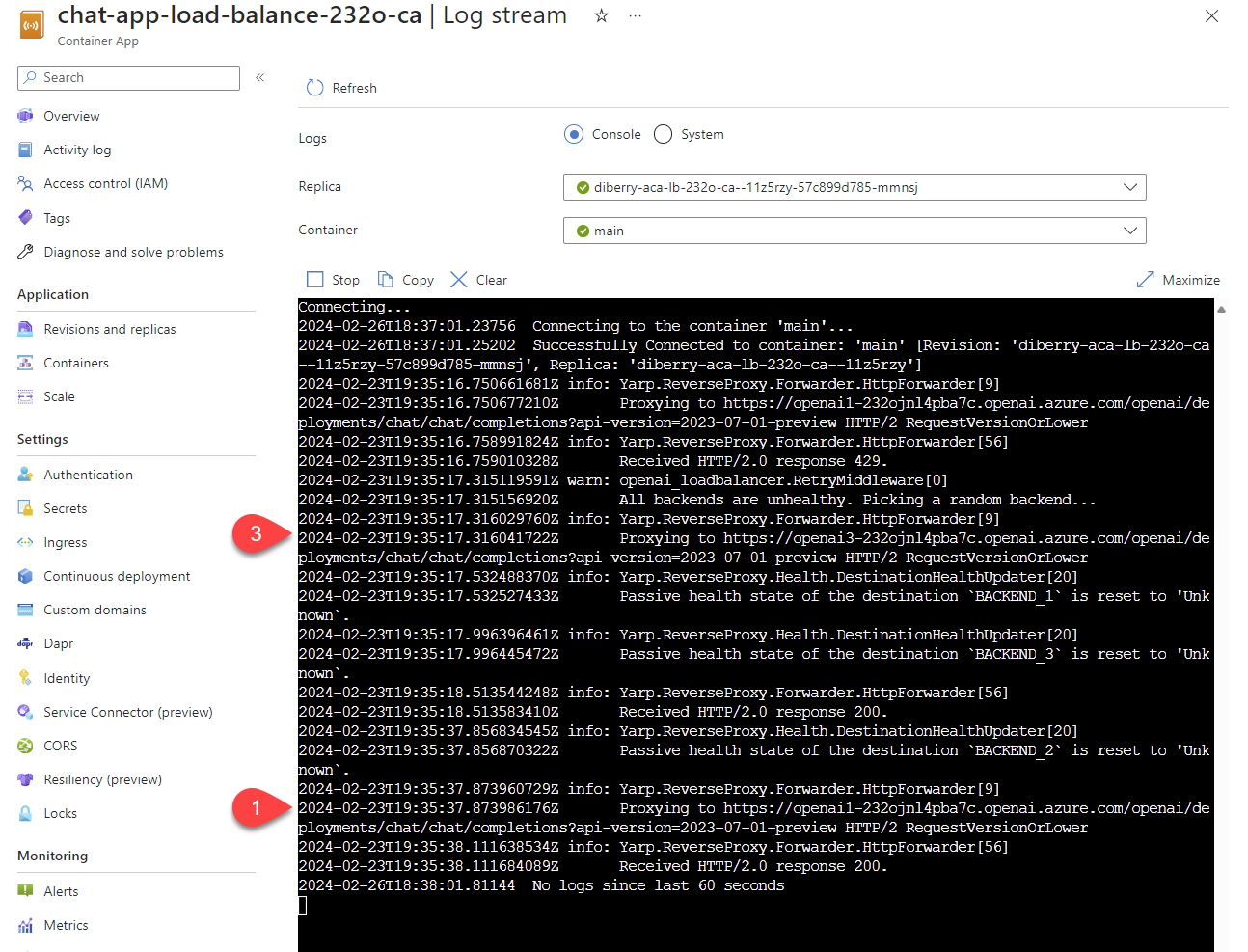

Mentransmisikan log untuk melihat hasil dari penyeimbang beban

Dalam Azure portal, cari grup sumber daya Anda.

Dari daftar sumber daya dalam grup, pilih sumber daya Azure Container Apps.

Pilih Pemantauan>Aliran log untuk melihat log.

Gunakan aplikasi obrolan untuk menghasilkan lalu lintas di log.

Cari log, yang mereferensikan sumber daya Azure OpenAI. Masing-masing dari tiga sumber daya memiliki identitas numeriknya dalam komentar log yang dimulai dengan

Proxying to https://openai3, di mana3menunjukkan sumber daya Azure OpenAI ketiga.

Ketika load balancer menerima status bahwa permintaan melebihi kuota, load balancer secara otomatis berputar ke sumber daya lain.

Mengonfigurasi kuota TPM

Secara default, masing-masing instans Azure OpenAI di load balancer disebarkan dengan kapasitas 30.000 token per menit (TPM). Anda dapat menggunakan aplikasi obrolan dengan keyakinan bahwa aplikasi tersebut dapat mengakomodasi banyak pengguna tanpa batasan kuota. Ubah nilai ini ketika:

- Terjadi kesalahan kapasitas penerapan: Kurangi nilainya.

- Anda memerlukan kapasitas yang lebih tinggi: Naikkan nilai.

Gunakan perintah berikut untuk mengubah nilai:

azd env set OPENAI_CAPACITY 50Konfigurasikan ulang penyeimbang beban.

azd up

Membersihkan sumber daya

Setelah Anda selesai dengan aplikasi obrolan dan penyeimbang muatan, bersihkan sumber daya. Sumber daya Azure yang dibuat dalam artikel ini ditagihkan ke langganan Azure Anda. Jika Anda tidak mengharapkan untuk membutuhkan sumber daya ini di masa mendatang, hapus sumber daya tersebut untuk menghindari dikenakan lebih banyak biaya.

Membersihkan sumber daya aplikasi obrolan

Kembali ke artikel aplikasi obrolan untuk membersihkan sumber daya:

Bersihkan sumber daya penyeimbang unggahan

Hapus sumber daya Azure dan hapus kode sumber:

azd down --purge --force

Sakelar memberikan fungsi:

-

purge: Sumber daya yang dihapus segera dibersihkan sehingga Anda dapat menggunakan kembali token Layanan Azure OpenAI setiap menit. -

force: Penghapusan dilakukan secara diam-diam, tanpa memerlukan persetujuan pengguna.

Membersihkan GitHub Codespaces dan Visual Studio Code

Menghapus lingkungan GitHub Codespaces memastikan bahwa Anda dapat memaksimalkan kuota jam penggunaan inti gratis yang Anda dapatkan untuk akun Anda.

Penting

Untuk informasi lebih lanjut tentang hak akun GitHub Anda, lihat penyimpanan dan jam inti bulanan yang sudah termasuk dalam GitHub Codespaces.

Masuk ke dasbor GitHub Codespaces.

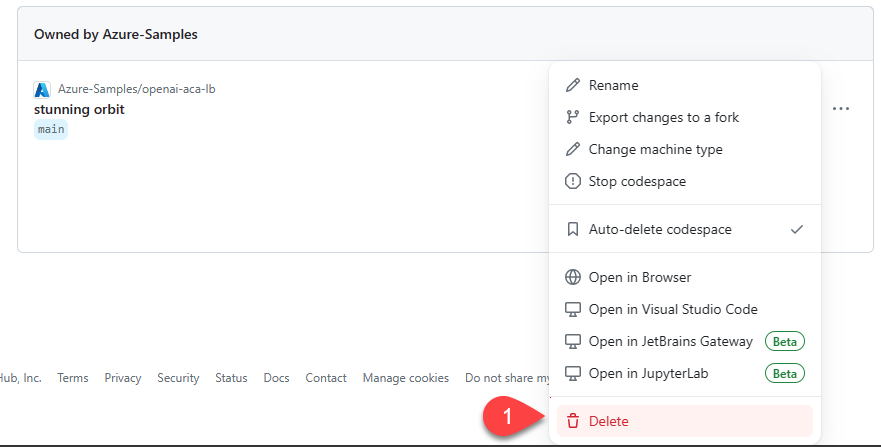

Temukan codespace yang Anda miliki yang sedang berjalan dan bersumber dari repositori GitHub azure-samples/openai-aca-lb.

Buka menu konteks untuk codespace, lalu pilih Hapus.

Dapatkan bantuan

Jika Anda mengalami masalah saat menerapkan load balancer Azure Container Apps, tambahkan masalah Anda ke halaman web Issues repositori.

Contoh kode

Sampel berikut digunakan dalam artikel ini:

Langkah berikutnya

- Gunakan Azure Load Testing untuk memuat pengujian aplikasi obrolan Anda.