Membuat tabel Apache Kafka® di Apache Flink® di HDInsight di AKS

Penting

Azure HDInsight di AKS dihentikan pada 31 Januari 2025. Pelajari lebih lanjut melalui pengumuman ini.

Anda perlu memigrasikan beban kerja Anda untuk Microsoft Fabric atau produk Azure yang setara untuk menghindari penghentian beban kerja Anda yang mendadak.

Penting

Fitur ini saat ini dalam pratinjau. Ketentuan Penggunaan Tambahan untuk Pratinjau Microsoft Azure menyertakan lebih banyak persyaratan hukum yang berlaku untuk fitur Azure yang dalam versi beta, dalam pratinjau, atau belum dirilis ke ketersediaan umum. Untuk informasi tentang pratinjau khusus ini, lihat Azure HDInsight pada informasi pratinjau AKS. Untuk pertanyaan atau saran fitur, kirimkan permintaan di AskHDInsight dengan detailnya dan ikuti kami untuk mendapatkan pembaruan lebih lanjut mengenai Azure HDInsight Community .

Dengan menggunakan contoh ini, pelajari cara Membuat tabel Kafka di Apache FlinkSQL.

Prasyarat

Konektor Kafka SQL di Apache Flink

Konektor Kafka memungkinkan membaca data dari dan menulis data ke dalam topik Kafka. Untuk informasi selengkapnya, lihat Apache Kafka SQL Connector.

Membuat tabel Kafka di Flink SQL

Menyiapkan topik dan data tentang HDInsight Kafka

Menyiapkan pesan dengan weblog.py

import random

import json

import time

from datetime import datetime

user_set = [

'John',

'XiaoMing',

'Mike',

'Tom',

'Machael',

'Zheng Hu',

'Zark',

'Tim',

'Andrew',

'Pick',

'Sean',

'Luke',

'Chunck'

]

web_set = [

'https://google.com',

'https://facebook.com?id=1',

'https://tmall.com',

'https://baidu.com',

'https://taobao.com',

'https://aliyun.com',

'https://apache.com',

'https://flink.apache.com',

'https://hbase.apache.com',

'https://github.com',

'https://gmail.com',

'https://stackoverflow.com',

'https://python.org'

]

def main():

while True:

if random.randrange(10) < 4:

url = random.choice(web_set[:3])

else:

url = random.choice(web_set)

log_entry = {

'userName': random.choice(user_set),

'visitURL': url,

'ts': datetime.now().strftime("%m/%d/%Y %H:%M:%S")

}

print(json.dumps(log_entry))

time.sleep(0.05)

if __name__ == "__main__":

main()

alur ke topik Kafka

sshuser@hn0-contsk:~$ python weblog.py | /usr/hdp/current/kafka-broker/bin/kafka-console-producer.sh --bootstrap-server wn0-contsk:9092 --topic click_events

Perintah lainnya:

-- create topic

/usr/hdp/current/kafka-broker/bin/kafka-topics.sh --create --replication-factor 2 --partitions 3 --topic click_events --bootstrap-server wn0-contsk:9092

-- delete topic

/usr/hdp/current/kafka-broker/bin/kafka-topics.sh --delete --topic click_events --bootstrap-server wn0-contsk:9092

-- consume topic

sshuser@hn0-contsk:~$ /usr/hdp/current/kafka-broker/bin/kafka-console-consumer.sh --bootstrap-server wn0-contsk:9092 --topic click_events --from-beginning

{"userName": "Luke", "visitURL": "https://flink.apache.com", "ts": "06/26/2023 14:33:43"}

{"userName": "Tom", "visitURL": "https://stackoverflow.com", "ts": "06/26/2023 14:33:43"}

{"userName": "Chunck", "visitURL": "https://google.com", "ts": "06/26/2023 14:33:44"}

{"userName": "Chunck", "visitURL": "https://facebook.com?id=1", "ts": "06/26/2023 14:33:44"}

{"userName": "John", "visitURL": "https://tmall.com", "ts": "06/26/2023 14:33:44"}

{"userName": "Andrew", "visitURL": "https://facebook.com?id=1", "ts": "06/26/2023 14:33:44"}

{"userName": "John", "visitURL": "https://tmall.com", "ts": "06/26/2023 14:33:44"}

{"userName": "Pick", "visitURL": "https://google.com", "ts": "06/26/2023 14:33:44"}

{"userName": "Mike", "visitURL": "https://tmall.com", "ts": "06/26/2023 14:33:44"}

{"userName": "Zheng Hu", "visitURL": "https://tmall.com", "ts": "06/26/2023 14:33:44"}

{"userName": "Luke", "visitURL": "https://facebook.com?id=1", "ts": "06/26/2023 14:33:44"}

{"userName": "John", "visitURL": "https://flink.apache.com", "ts": "06/26/2023 14:33:44"}

Klien Apache Flink SQL

Instruksi terperinci diberikan tentang cara menggunakan Secure Shell untuk klien Flink SQL .

Unduh Konektor Kafka SQL & komponen yang dibutuhkan melalui SSH

Kami menggunakan dependensi Kafka 3.2.0 pada langkah di bawah ini, Anda diharuskan memperbarui perintah berdasarkan versi Kafka Anda pada kluster HDInsight.

wget https://repo1.maven.org/maven2/org/apache/kafka/kafka-clients/3.2.0/kafka-clients-3.2.0.jar

wget https://repo1.maven.org/maven2/org/apache/flink/flink-connector-kafka/1.17.0/flink-connector-kafka-1.17.0.jar

Menyambungkan ke Klien Apache Flink SQL

Sekarang mari kita sambungkan ke Klien Flink SQL dengan jar klien Kafka SQL.

msdata@pod-0 [ /opt/flink-webssh ]$ bin/sql-client.sh -j flink-connector-kafka-1.17.0.jar -j kafka-clients-3.2.0.jar

Membuat tabel Kafka di Apache Flink SQL

Mari kita buat tabel Kafka di Flink SQL, dan pilih tabel Kafka di Flink SQL.

Anda diharuskan untuk memperbarui IP server bootstrap Kafka Anda di cuplikan di bawah ini.

CREATE TABLE KafkaTable (

`userName` STRING,

`visitURL` STRING,

`ts` TIMESTAMP(3) METADATA FROM 'timestamp'

) WITH (

'connector' = 'kafka',

'topic' = 'click_events',

'properties.bootstrap.servers' = '<update-kafka-bootstrapserver-ip>:9092,<update-kafka-bootstrapserver-ip>:9092,<update-kafka-bootstrapserver-ip>:9092',

'properties.group.id' = 'my_group',

'scan.startup.mode' = 'earliest-offset',

'format' = 'json'

);

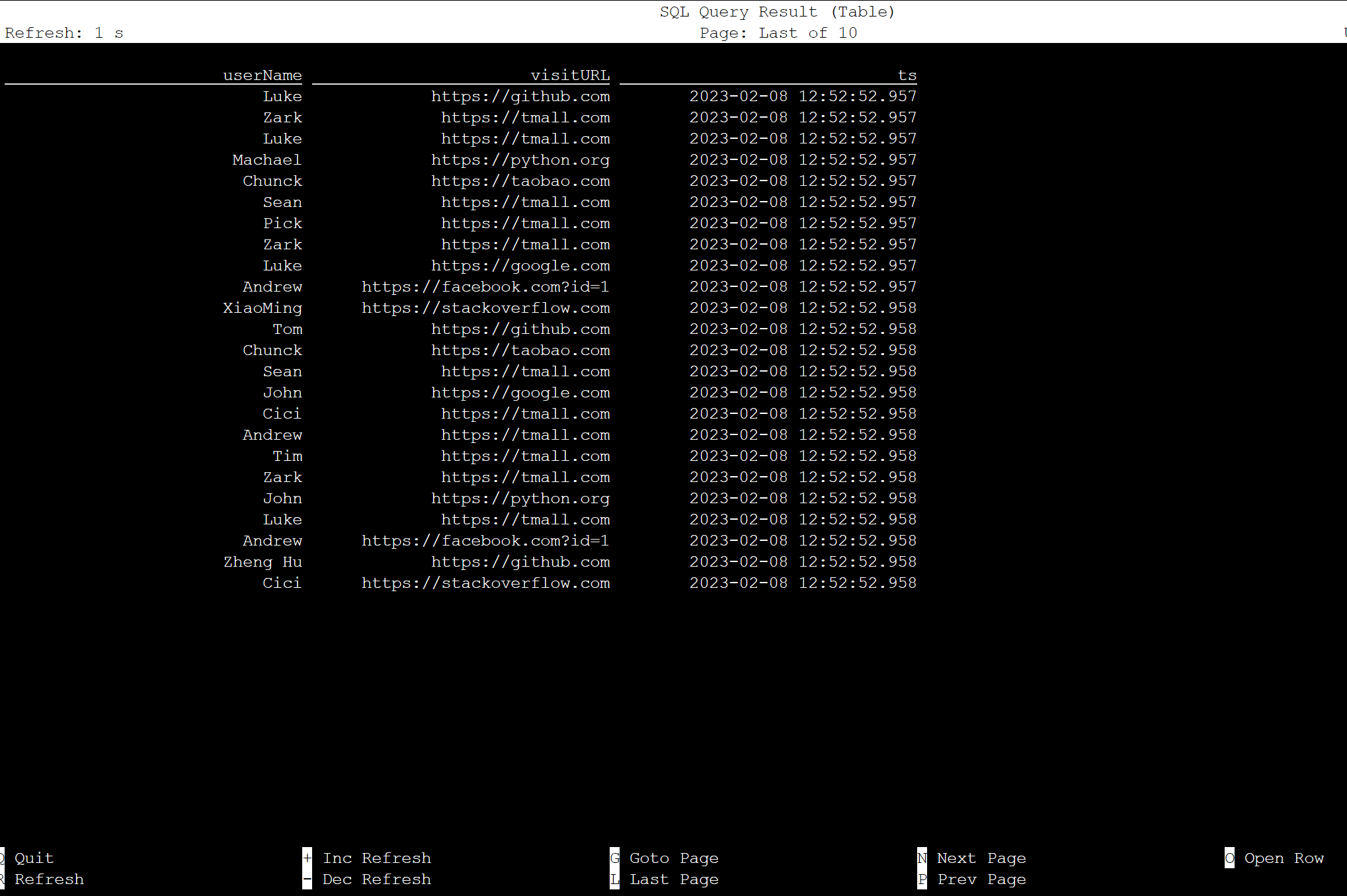

select * from KafkaTable;

Menghasilkan pesan Kafka

Mari sekarang kita hasilkan pesan Kafka ke topik yang sama dengan menggunakan HDInsight Kafka.

python weblog.py | /usr/hdp/current/kafka-broker/bin/kafka-console-producer.sh --bootstrap-server wn0-contsk:9092 --topic click_events

Tabel pada Apache Flink SQL

Anda dapat memantau tabel di Flink SQL.

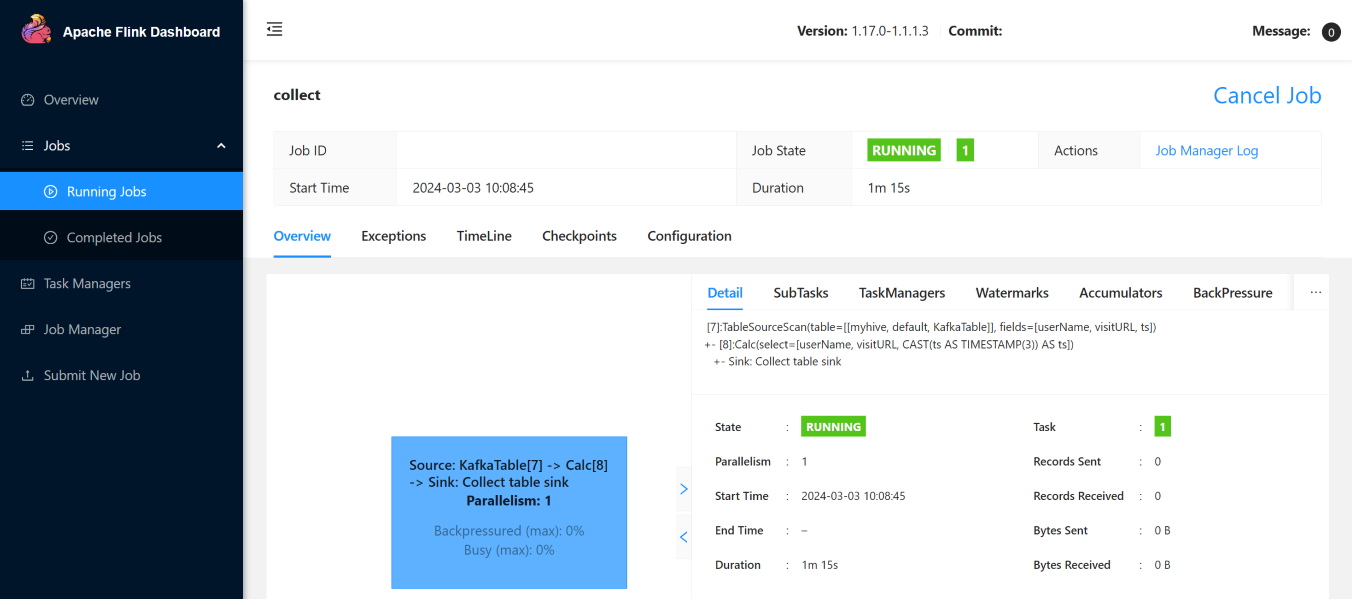

Berikut adalah tugas streaming di Flink Web UI.

Referensi

- Konektor Apache Kafka SQL

- Apache, Apache Kafka, Kafka, Apache Flink, Flink, dan nama proyek sumber terbuka terkait adalah merek dagang Apache Software Foundation (ASF).