Mengirimkan eksekusi batch dan mengevaluasi alur

Untuk mengevaluasi seberapa baik performa alur Anda dengan himpunan data besar, Anda dapat mengirimkan eksekusi batch dan menggunakan metode evaluasi bawaan dalam alur perintah.

Dalam artikel ini Anda belajar untuk:

- Mengirimkan Batch Run dan Menggunakan Metode Evaluasi Bawaan

- Menampilkan hasil evaluasi dan metrik

- Mulai Babak Baru Evaluasi

- Periksa Riwayat Eksekusi Batch dan Bandingkan Metrik

- Memahami Metrik Evaluasi Bawaan

- Cara Meningkatkan Performa Alur

- Bacaan lebih lanjut: Panduan untuk membuat Himpunan Data Emas yang digunakan untuk jaminan kualitas Copilot

Anda dapat dengan cepat mulai menguji dan mengevaluasi alur Anda dengan mengikuti tutorial video ini mengirimkan eksekusi batch dan mengevaluasi tutorial video alur.

Prasyarat

Untuk menjalankan eksekusi batch dan menggunakan metode evaluasi, Anda harus menyiapkan hal berikut:

- Himpunan data pengujian untuk eksekusi batch. Himpunan data Anda harus dalam salah satu format berikut:

.csv, ,.tsvatau.jsonl. Data Anda juga harus menyertakan header yang cocok dengan nama input alur Anda. Bacaan Lebih Lanjut: Jika Anda membangun salinan anda sendiri, sebaiknya lihat Panduan untuk membuat Golden Datasets yang digunakan untuk jaminan kualitas Copilot.

Mengirimkan eksekusi batch dan menggunakan metode evaluasi bawaan

Eksekusi batch memungkinkan Anda menjalankan alur dengan himpunan data besar dan menghasilkan output untuk setiap baris data. Anda juga dapat memilih metode evaluasi untuk membandingkan output alur Anda dengan kriteria dan tujuan tertentu. Metode evaluasi adalah jenis alur khusus yang menghitung metrik untuk output alur Anda berdasarkan aspek yang berbeda. Eksekusi evaluasi dijalankan untuk menghitung metrik saat dikirimkan dengan eksekusi batch.

Untuk memulai eksekusi batch dengan evaluasi, Anda dapat memilih tombol "Evaluasi" di sudut kanan atas halaman alur Anda.

Untuk mengirimkan eksekusi batch, Anda dapat memilih himpunan data untuk menguji alur Anda. Anda juga dapat memilih metode evaluasi untuk menghitung metrik untuk output alur Anda. Jika Anda tidak ingin menggunakan metode evaluasi, Anda dapat melewati langkah ini dan menjalankan eksekusi batch tanpa menghitung metrik apa pun. Anda juga dapat memulai babak evaluasi baru nanti.

Pertama, Anda diminta untuk memberi batch Anda menjalankan nama yang deskriptif dan dapat dikenali. Anda juga dapat menulis deskripsi dan menambahkan tag (pasangan kunci-nilai) ke eksekusi batch Anda. Setelah Anda menyelesaikan konfigurasi, pilih "Berikutnya" untuk melanjutkan.

Kedua, Anda perlu memilih atau mengunggah himpunan data yang ingin Anda uji alurnya.

Alur perintah juga mendukung pemetaan input alur Anda ke kolom data tertentu di himpunan data Anda. Ini berarti Anda dapat menetapkan kolom ke input tertentu. Anda dapat menetapkan kolom ke input dengan mereferensikan dengan ${data.XXX} format. Jika Anda ingin menetapkan nilai konstanta ke input, Anda dapat langsung mengetikkan nilai tersebut.

Kemudian, pada langkah berikutnya, Anda dapat memutuskan untuk menggunakan metode evaluasi untuk memvalidasi performa eksekusi ini baik segera atau lambat. Untuk eksekusi batch yang selesai, putaran evaluasi baru masih dapat ditambahkan.

Anda dapat langsung memilih tombol "Berikutnya" untuk melewati langkah ini dan menjalankan eksekusi batch tanpa menggunakan metode evaluasi apa pun untuk menghitung metrik. Dengan cara ini, eksekusi batch ini hanya menghasilkan output untuk himpunan data Anda. Anda dapat memeriksa output secara manual atau mengekspornya untuk analisis lebih lanjut dengan metode lain.

Jika tidak, jika Anda ingin menjalankan eksekusi batch dengan evaluasi sekarang, Anda dapat memilih satu atau beberapa metode evaluasi berdasarkan deskripsi yang disediakan. Anda dapat memilih tombol "Detail selengkapnya" untuk melihat informasi selengkapnya tentang metode evaluasi, seperti metrik yang dihasilkannya dan koneksi dan input yang diperlukannya.

Buka langkah berikutnya dan konfigurasikan pengaturan evaluasi. Di bagian "Pemetaan input evaluasi" , Anda perlu menentukan sumber data input yang diperlukan untuk metode evaluasi. Misalnya, kolom kebenaran dasar mungkin berasal dari himpunan data. Secara default, evaluasi menggunakan himpunan data yang sama dengan himpunan data pengujian yang disediakan untuk eksekusi yang diuji. Namun, jika label yang sesuai atau nilai kebenaran dasar target berada dalam himpunan data yang berbeda, Anda dapat dengan mudah beralih ke yang itu.

Oleh karena itu, untuk menjalankan evaluasi, Anda perlu menunjukkan sumber input yang diperlukan ini. Untuk melakukannya, saat mengirimkan evaluasi, Anda akan melihat bagian "Pemetaan input evaluasi" .

- Jika sumber data berasal dari output eksekusi Anda, sumber ditunjukkan sebagai "${run.output.[ OutputName]}"

- Jika sumber data berasal dari himpunan data pengujian Anda, sumber ditunjukkan sebagai "${data.[ ColumnName]}"

Catatan

Jika evaluasi Anda tidak memerlukan data dari himpunan data, Anda tidak perlu mereferensikan kolom himpunan data apa pun di bagian pemetaan input, yang menunjukkan pemilihan himpunan data adalah konfigurasi opsional. Pemilihan himpunan data tidak akan memengaruhi hasil evaluasi.

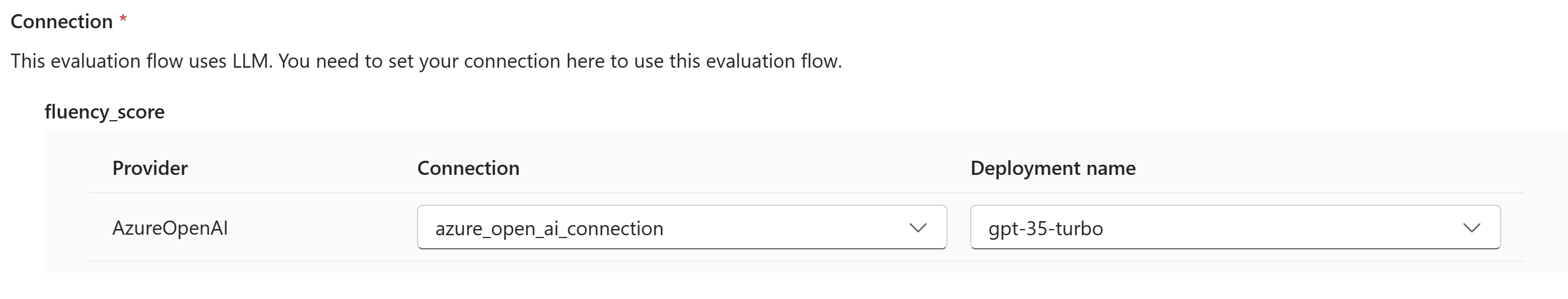

Jika metode evaluasi menggunakan Model Bahasa Besar (LLM) untuk mengukur performa respons alur, Anda juga diharuskan mengatur koneksi untuk node LLM dalam metode evaluasi.

Catatan

Beberapa metode evaluasi mengharuskan GPT-4 atau GPT-3 untuk dijalankan. Anda harus menyediakan koneksi yang valid untuk metode evaluasi ini sebelum menggunakannya. Beberapa proses evaluasi mungkin memakan banyak token, jadi disarankan untuk menggunakan model yang dapat mendukung >token =16k.

Setelah Anda menyelesaikan pemetaan input, pilih "Berikutnya" untuk meninjau pengaturan Anda dan pilih "Kirim" untuk memulai eksekusi batch dengan evaluasi.

Catatan

Eksekusi batch memiliki durasi maksimum 10 jam. Jika eksekusi batch melebihi batas ini, batch akan dihentikan dan ditandai sebagai gagal. Kami menyarankan untuk memantau kapasitas Model Bahasa Besar (LLM) Anda untuk menghindari pembatasan. Jika perlu, pertimbangkan untuk mengurangi ukuran data Anda. Jika Anda terus mengalami masalah atau memerlukan bantuan lebih lanjut, jangan ragu untuk menghubungi tim produk kami melalui formulir umpan balik atau permintaan dukungan.

Menampilkan hasil evaluasi dan metrik

Setelah pengiriman, Anda dapat menemukan eksekusi batch yang dikirimkan di tab daftar eksekusi di halaman alur perintah.

Pilih eksekusi untuk menavigasi ke halaman Jalankan hasil , untuk memeriksa hasil eksekusi batch ini.

Output

Hasil dan jejak dasar

Ini pertama-tama akan mengarahkan Anda ke tab Output untuk melihat input dan output baris demi baris. Halaman tab output menampilkan daftar tabel hasil, termasuk ID baris, input, output, status, metrik sistem, dan waktu yang dibuat.

Untuk setiap baris, memilih Lihat jejak memungkinkan Anda mengamati dan men-debug kasus pengujian tertentu di halaman terperinci jejaknya.

Menambahkan hasil evaluasi dan jejak

Memilih Tambahkan output evaluasi memungkinkan Anda memilih eksekusi evaluasi terkait dan Anda melihat kolom yang ditambahkan di akhir tabel yang memperlihatkan hasil evaluasi untuk setiap baris data. Beberapa output evaluasi dapat ditambahkan untuk perbandingan.

Anda dapat melihat metrik evaluasi terbaru di panel Gambaran Umum kiri.

Gambaran umum penting

Di sisi kanan, Gambaran Umum menawarkan informasi keseluruhan tentang eksekusi, seperti jumlah per eksekusi titik data, token total, dan durasi eksekusi.

Metrik agregat eksekusi evaluasi terbaru diperlihatkan di sini secara default, Anda dapat memilih Lihat eksekusi evaluasi untuk melompat untuk melihat eksekusi evaluasi itu sendiri.

Gambaran umum dapat diperluas dan diciutkan di sini, dan Anda dapat memilih Lihat informasi lengkap, yang akan mengarahkan Anda ke tab Gambaran Umum di samping tab Output, di mana berisi informasi yang lebih rinci dari eksekusi ini.

Memulai babak baru evaluasi

Jika Anda telah menyelesaikan eksekusi batch, Anda dapat memulai putaran evaluasi lain untuk mengirimkan eksekusi evaluasi baru untuk menghitung metrik untuk output tanpa menjalankan alur Anda lagi. Ini berguna dan dapat menghemat biaya Anda untuk menjalankan ulang alur Anda saat:

- Anda tidak memilih metode evaluasi untuk menghitung metrik saat mengirimkan eksekusi batch, dan memutuskan untuk melakukannya sekarang.

- Anda telah menggunakan metode evaluasi untuk menghitung metrik. Anda dapat memulai putaran evaluasi lain untuk menghitung metrik lain.

- Eksekusi evaluasi Anda gagal tetapi alur Anda berhasil menghasilkan output. Anda dapat mengirimkan evaluasi Anda lagi.

Anda dapat memilih Evaluasi untuk memulai putaran evaluasi lain.

Setelah menyiapkan konfigurasi, Anda dapat memilih "Kirim" untuk putaran evaluasi baru ini. Setelah pengiriman, Anda akan dapat melihat rekaman baru di daftar eksekusi alur perintah. Setelah proses evaluasi selesai, demikian pula, Anda dapat memeriksa hasil evaluasi di tab "Output" dari panel detail eksekusi batch. Anda perlu memilih eksekusi evaluasi baru untuk melihat hasilnya.

Untuk mempelajari selengkapnya tentang metrik yang dihitung oleh metode evaluasi bawaan, navigasikan untuk memahami metrik evaluasi bawaan.

Gambaran Umum

Memilih tab Gambaran Umum memperlihatkan informasi komprehensif tentang eksekusi, termasuk properti eksekusi, himpunan data input, himpunan data output, tag, dan deskripsi.

Log

Memilih tab Log memungkinkan Anda melihat log eksekusi, yang dapat berguna untuk penelusuran kesalahan eksekusi secara mendetail. Anda dapat mengunduh file log ke komputer lokal Anda.

Snapshot

Memilih tab Rekam Jepret memperlihatkan kepada Anda rekam jepret yang dijalankan. Anda dapat melihat DAG alur Anda. Selain itu, Anda memiliki opsi untuk Mengkloningnya untuk membuat alur baru. Anda juga dapat Menyebarkannya sebagai titik akhir online.

Memeriksa riwayat eksekusi batch dan membandingkan metrik

Dalam beberapa skenario, Anda memodifikasi alur untuk meningkatkan performanya. Anda dapat mengirimkan beberapa batch yang dijalankan untuk membandingkan performa alur Anda dengan versi yang berbeda. Anda juga dapat membandingkan metrik yang dihitung dengan metode evaluasi yang berbeda untuk melihat mana yang lebih cocok untuk alur Anda.

Untuk memeriksa riwayat eksekusi batch alur Anda, Anda dapat memilih tombol "Lihat batch run" di sudut kanan atas halaman alur Anda. Anda melihat daftar eksekusi batch yang telah Anda kirimkan untuk alur ini.

Anda dapat memilih pada setiap eksekusi batch untuk memeriksa detailnya. Anda juga dapat memilih beberapa eksekusi batch dan memilih " Visualisasikan output" untuk membandingkan metrik dan output dari eksekusi batch ini.

Di panel "Visualisasikan output" tabel Jalankan & metrik memperlihatkan informasi eksekusi yang dipilih dengan sorotan. Eksekusi lain yang mengambil output dari eksekusi yang dipilih sebagai input juga tercantum.

Dalam tabel "Output", Anda dapat membandingkan eksekusi batch yang dipilih dengan setiap baris sampel. Dengan memilih ikon "visualisasi mata" di tabel "Jalankan & metrik", output dari eksekusi tersebut akan ditambahkan ke eksekusi dasar yang sesuai.

Memahami metrik evaluasi bawaan

Dalam alur perintah, kami menyediakan beberapa metode evaluasi bawaan untuk membantu Anda mengukur performa output alur Anda. Setiap metode evaluasi menghitung metrik yang berbeda. Sekarang kami menyediakan sembilan metode evaluasi bawaan yang tersedia. Anda bisa memeriksa tabel berikut untuk referensi cepat:

| Metode Evaluasi | Metrik | Deskripsi | Koneksi Diperlukan | Input yang Diperlukan | Nilai Skor |

|---|---|---|---|---|---|

| Evaluasi Akurasi Klasifikasi | Akurasi | Mengukur performa sistem klasifikasi dengan membandingkan outputnya dengan kebenaran dasar. | No | prediksi, kebenaran dasar | dalam rentang [0, 1]. |

| Evaluasi Pairwise Skor Relevansi QnA | Skor, menang/kalah | Menilai kualitas jawaban yang dihasilkan oleh sistem jawaban atas pertanyaan. Ini melibatkan penetapan skor relevansi untuk setiap jawaban berdasarkan seberapa baik cocok dengan pertanyaan pengguna, membandingkan jawaban yang berbeda dengan jawaban dasar, dan menggabungkan hasil untuk menghasilkan metrik seperti tingkat kemenangan rata-rata dan skor relevansi. | Ya | pertanyaan, jawaban (tidak ada kebenaran dasar atau konteks) | Skor: 0-100, menang/kalah: 1/0 |

| Evaluasi Groundedness QnA | Groundedness | Mengukur cara membumikan prediksi jawaban model di sumber input. Bahkan jika respons LLM benar, jika tidak dapat diverifikasi terhadap sumber, maka tidak teralihkan. | Ya | pertanyaan, jawaban, konteks (tidak ada kebenaran dasar) | 1 sampai 5, dengan 1 menjadi yang terburuk dan 5 menjadi yang terbaik. |

| Evaluasi Kesamaan GPT QnA | Kesamaan GPT | Mengukur kesamaan antara jawaban kebenaran dasar yang disediakan pengguna dan jawaban yang diprediksi model menggunakan Model GPT. | Ya | pertanyaan, jawaban, kebenaran dasar (konteks tidak diperlukan) | 1 sampai 5, dengan 1 menjadi yang terburuk dan 5 menjadi yang terbaik. |

| Evaluasi Relevansi QnA | Relevansi | Mengukur seberapa relevan jawaban yang diprediksi model terhadap pertanyaan yang diajukan. | Ya | pertanyaan, jawaban, konteks (tidak ada kebenaran dasar) | 1 sampai 5, dengan 1 menjadi yang terburuk dan 5 menjadi yang terbaik. |

| Evaluasi Koherensi QnA | Koherensi | Mengukur kualitas semua kalimat dalam jawaban model yang diprediksi dan bagaimana kalimat tersebut cocok secara alami. | Ya | pertanyaan, jawaban (tidak ada kebenaran dasar atau konteks) | 1 sampai 5, dengan 1 menjadi yang terburuk dan 5 menjadi yang terbaik. |

| Evaluasi Kefasihan QnA | Kelancaran | Mengukur seberapa terprogram dan linguistik memperbaiki prediksi jawaban model. | Ya | pertanyaan, jawaban (tidak ada kebenaran dasar atau konteks) | 1 hingga 5, dengan 1 menjadi yang terburuk dan 5 menjadi yang terbaik |

| Evaluasi skor QnA f1 | f-measure | Mengukur rasio jumlah kata bersama antara prediksi model dan kebenaran dasar. | No | pertanyaan, jawaban, kebenaran dasar (konteks tidak diperlukan) | dalam rentang [0, 1]. |

| Evaluasi Kesamaan QnA Ada | Ada Kesamaan | Menghitung penyematan tingkat kalimat (dokumen) menggunakan ADA embeddings API untuk kebenaran dasar dan prediksi. Kemudian menghitung kesamaan kosinus di antara mereka (satu angka titik mengambang) | Ya | pertanyaan, jawaban, kebenaran dasar (konteks tidak diperlukan) | dalam rentang [0, 1]. |

Cara untuk meningkatkan performa alur

Setelah memeriksa metrik bawaan dari evaluasi, Anda dapat mencoba meningkatkan performa alur Anda dengan:

- Periksa data output untuk men-debug potensi kegagalan alur Anda.

- Ubah alur Anda untuk meningkatkan performanya. Ini termasuk tetapi tidak terbatas pada:

- Ubah perintah

- Mengubah pesan sistem

- Mengubah parameter alur

- Mengubah logika alur

Konstruksi prompt bisa sulit. Kami menyediakan Pengantar untuk meminta rekayasa untuk membantu Anda mempelajari konsep membangun permintaan yang dapat mencapai tujuan Anda. Lihat teknik rekayasa yang tepat untuk mempelajari selengkapnya tentang cara membuat perintah yang dapat mencapai tujuan Anda.

Pesan sistem, terkadang disebut sebagai metaprompt atau permintaan sistem yang dapat digunakan untuk memandu perilaku sistem AI dan meningkatkan performa sistem. Baca dokumen ini tentang Kerangka kerja pesan sistem dan rekomendasi templat untuk Model Bahasa Besar (LLM) untuk mempelajari cara meningkatkan performa alur Anda dengan pesan sistem.

Bacaan lebih lanjut: Panduan untuk membuat Himpunan Data Emas yang digunakan untuk jaminan kualitas Copilot

Pembuatan salinan yang menggunakan Model Bahasa Besar (LLM) biasanya melibatkan grounding model pada kenyataannya menggunakan himpunan data sumber. Namun, untuk memastikan bahwa LLM memberikan respons yang paling akurat dan berguna terhadap kueri pelanggan, diperlukan "Golden Dataset".

Golden Dataset adalah kumpulan pertanyaan pelanggan yang realistis dan jawaban yang dibuat secara ahli. Ini berfungsi sebagai alat Jaminan Kualitas untuk LLM yang digunakan oleh salinan Anda. Himpunan Data Emas tidak digunakan untuk melatih LLM atau menyuntikkan konteks ke dalam prompt LLM. Sebaliknya, mereka digunakan untuk menilai kualitas jawaban yang dihasilkan oleh LLM.

Jika skenario Anda melibatkan salinan atau jika Anda sedang dalam proses membangun salinan Anda sendiri, kami sarankan untuk merujuk ke dokumen khusus ini: Memproduksi Golden Datasets: Panduan untuk membuat Golden Datasets yang digunakan untuk jaminan kualitas Copilot untuk panduan dan praktik terbaik yang lebih terperinci.

Langkah berikutnya

Dalam dokumen ini, Anda mempelajari cara mengirimkan eksekusi batch dan menggunakan metode evaluasi bawaan untuk mengukur kualitas output alur Anda. Anda juga mempelajari cara melihat hasil evaluasi dan metrik, dan cara memulai putaran evaluasi baru dengan metode atau subset varian yang berbeda. Kami berharap dokumen ini membantu Anda meningkatkan performa alur dan mencapai tujuan Anda dengan alur Prompt.