Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Dengan Microsoft Fabric, Anda dapat menggunakan Apache Spark untuk menjalankan notebook, pekerjaan, dan jenis aplikasi lainnya di ruang kerja Anda. Artikel ini menjelaskan cara memantau aplikasi Apache Spark Anda, memungkinkan Anda untuk mengawasi status eksekusi, masalah, dan kemajuan pekerjaan Anda baru-baru ini.

Tampilan aplikasi Apache Spark

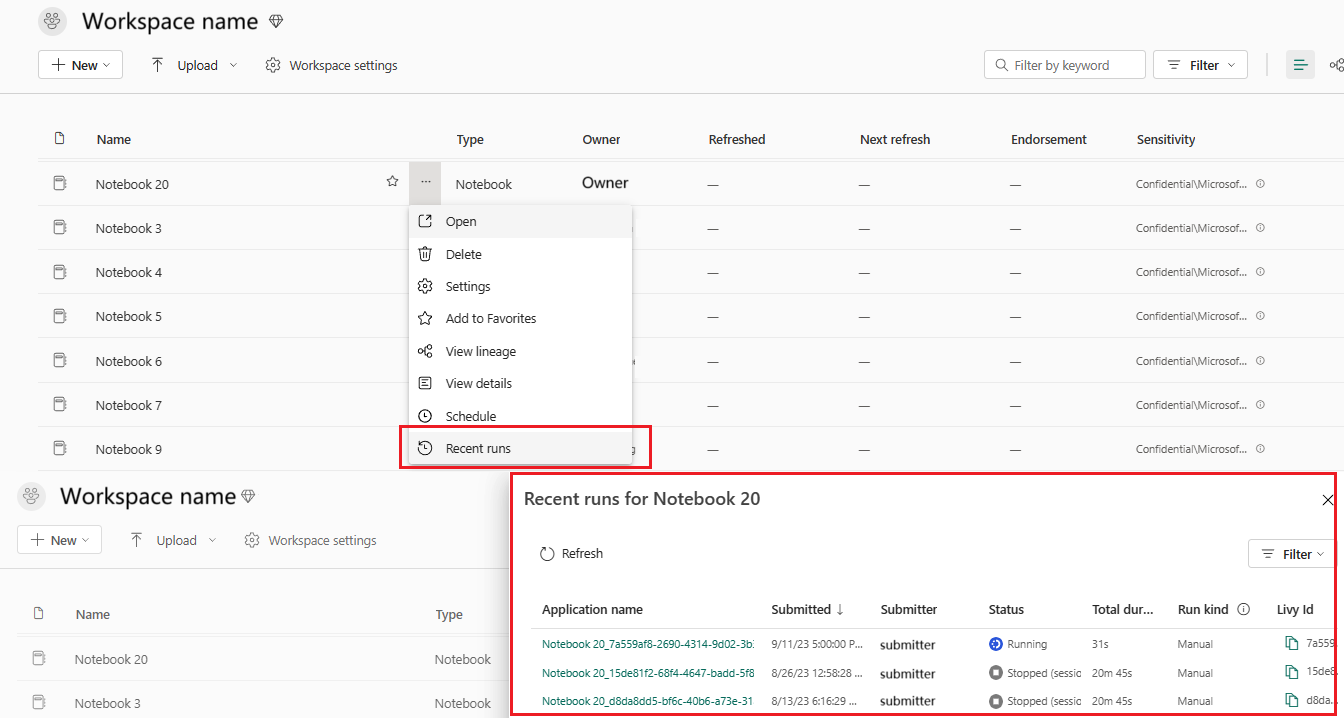

Anda dapat melihat semua aplikasi Apache Spark dari definisi kerja Spark, atau menu konteks item buku catatan memperlihatkan opsi eksekusi terbaru ->Eksekusi terbaru.

Anda dapat memilih nama aplikasi yang ingin Anda lihat di daftar aplikasi, di halaman detail aplikasi, Anda dapat melihat detail aplikasi.

Memantau status aplikasi Apache Spark

Buka halaman Eksekusi terbaru dari notebook atau definisi kerja Spark, Anda bisa menampilkan status aplikasi Apache.

- Berhasil

- Dalam antrean

- Dihentikan

- Dibatalkan

- Gagal

Pekerjaan

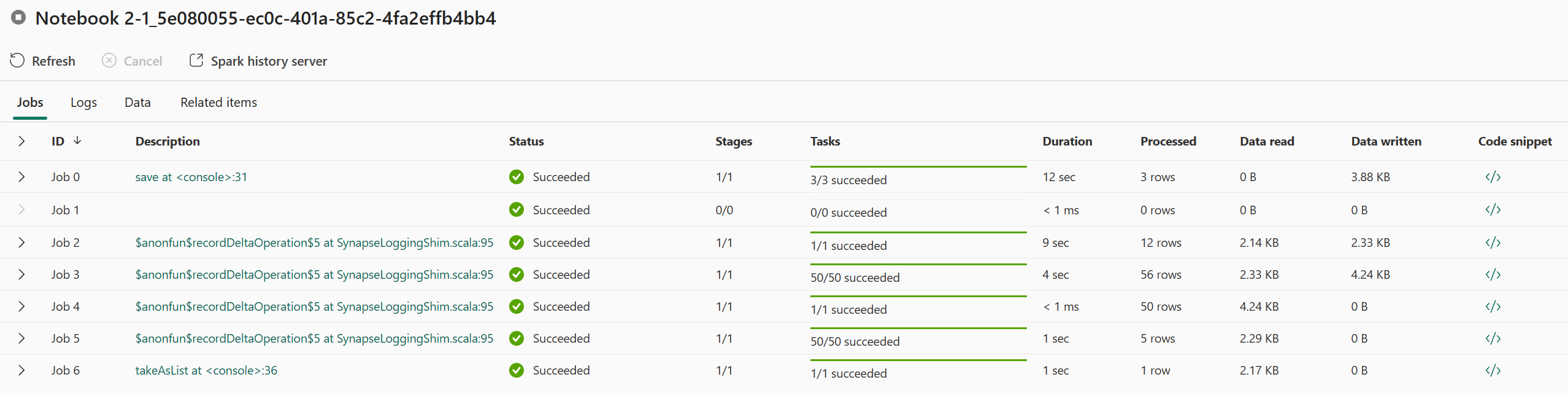

Buka pekerjaan aplikasi Apache Spark dari definisi kerja Spark atau menu konteks item buku catatan memperlihatkan opsi Eksekusi terbaru ->Eksekusi terbaru -> pilih pekerjaan di halaman eksekusi terbaru.

Di halaman detail pemantauan aplikasi Apache Spark, daftar eksekusi pekerjaan ditampilkan di tab Pekerjaan, Anda dapat melihat detail setiap pekerjaan di sini, termasuk ID Pekerjaan, Deskripsi, Status, Tahapan, Tugas, Durasi, Diproses, Bacaan data, Cuplikan data ditulis dan Kode.

- Mengklik ID Pekerjaan dapat memperluas/menciutkan pekerjaan.

- Klik deskripsi pekerjaan, Anda dapat melompat ke halaman pekerjaan atau panggung di antarmuka pengguna spark.

- Klik cuplikan Kode pekerjaan, Anda dapat memeriksa dan menyalin kode yang terkait dengan pekerjaan ini.

Sumber daya

Grafik penggunaan pelaksana di bawah tab Sumber Daya memvisualisasikan alokasi dan pemanfaatan pelaksana Spark untuk aplikasi Spark saat ini dalam waktu hampir nyata selama eksekusi Spark. Anda dapat merujuk ke: Memantau Pemanfaatan Sumber Daya Aplikasi Apache Spark.

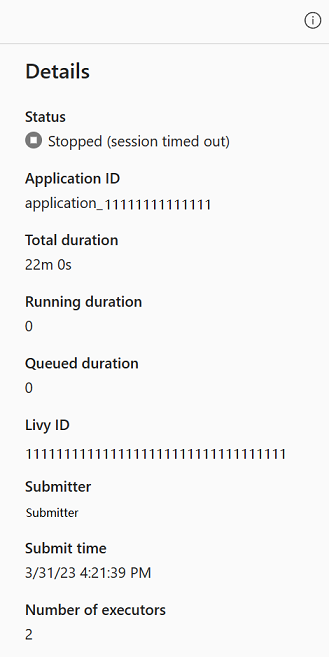

Panel ringkasan

Di halaman pemantauan aplikasi Apache Spark, klik tombol Properti untuk membuka/menciutkan panel ringkasan. Anda dapat melihat detail untuk aplikasi ini di Detail.

- Status untuk aplikasi spark ini.

- ID aplikasi Spark ini.

- Total durasi.

- Durasi berjalan untuk aplikasi spark ini.

- Durasi antrean untuk aplikasi spark ini.

- ID Livy

- Pengirim untuk aplikasi spark ini.

- Kirim waktu untuk aplikasi spark ini.

- Jumlah pelaksana.

Log

Untuk tab Log , Anda dapat melihat log lengkap Livy, Prelaunch, Log driver dengan opsi berbeda yang dipilih di panel kiri. Dan Anda dapat langsung mengambil informasi log yang diperlukan dengan mencari kata kunci dan melihat log dengan memfilter status log. Klik Unduh Log untuk mengunduh informasi log ke lokal.

Terkadang tidak ada log yang tersedia, seperti status pekerjaan diantrekan dan pembuatan kluster gagal.

Log langsung hanya tersedia saat pengiriman aplikasi gagal, dan log driver juga disediakan.

Data Informasi

Untuk tab Data , Anda dapat menyalin daftar data di clipboard, mengunduh daftar data dan data tunggal, dan memeriksa properti untuk setiap data.

- Panel kiri dapat diperluas atau diciutkan.

- Nama, format baca, ukuran, sumber, dan jalur file input dan output akan ditampilkan dalam daftar ini.

- File dalam input dan output dapat diunduh, menyalin jalur, dan melihat properti.

Rekam jepret item

Tab Rekam jepret Item memungkinkan Anda menelusuri dan melihat item yang terkait dengan aplikasi Apache Spark, termasuk Notebook, definisi pekerjaan Spark, dan/atau Alur. Halaman rekam jepret item menampilkan rekam jepret nilai kode dan parameter pada saat eksekusi untuk Notebook. Ini juga menunjukkan rekam jepret semua pengaturan dan parameter pada saat pengiriman untuk definisi pekerjaan Spark. Jika aplikasi Apache Spark dikaitkan dengan alur, halaman item terkait juga menyajikan alur yang sesuai dan aktivitas Spark.

Di layar Rekam jepret Item, Anda dapat:

- Telusuri dan navigasi item terkait di pohon hierarkis.

- Klik ikon elips 'Daftar tindakan lainnya' untuk setiap item untuk mengambil tindakan yang berbeda.

- Klik item rekam jepret untuk melihat kontennya.

- Lihat Breadcrumb untuk melihat jalur dari item yang dipilih ke akar.

Diagnostik

Panel diagnostik memberi pengguna rekomendasi real time dan analisis kesalahan, yang dihasilkan oleh Spark Advisor melalui analisis kode pengguna. Dengan pola bawaan, Apache Spark Advisor membantu pengguna menghindari kesalahan umum dan menganalisis kegagalan untuk mengidentifikasi akar penyebabnya.

Konten terkait

Langkah selanjutnya setelah menampilkan detail aplikasi Apache Spark adalah melihat kemajuan pekerjaan Spark di bawah sel Notebook. Anda dapat merujuk ke: