Menyerap data ke OneLake dan menganalisis dengan Azure Databricks

Dalam panduan ini, Anda akan:

Buat alur di ruang kerja dan serap data ke dalam OneLake Anda dalam format Delta.

Membaca dan memodifikasi tabel Delta di OneLake dengan Azure Databricks.

Prasyarat

Sebelum memulai, Anda harus memiliki:

Ruang kerja dengan item Lakehouse.

Ruang kerja Azure Databricks premium. Hanya ruang kerja Azure Databricks premium yang mendukung passthrough kredensial Microsoft Entra. Saat membuat kluster Anda, aktifkan passthrough kredensial Azure Data Lake Storage di Opsi Tingkat Lanjut.

Himpunan data sampel.

Menyerap data dan mengubah tabel Delta

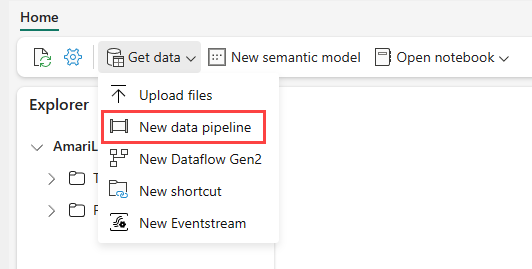

Navigasi ke lakehouse Anda di layanan Power BI dan pilih Dapatkan data lalu pilih Alur data baru.

Di perintah Alur Baru, masukkan nama untuk alur baru lalu pilih Buat.

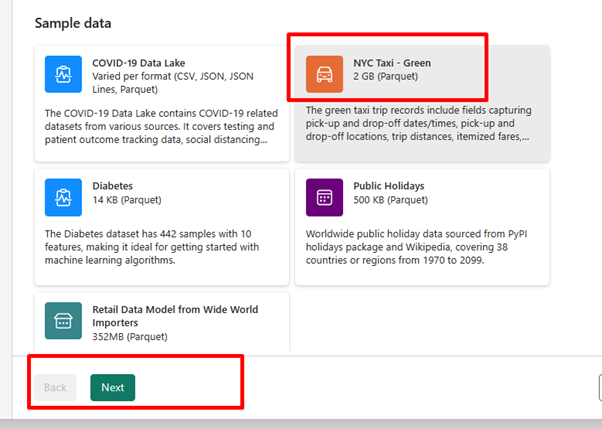

Untuk latihan ini, pilih data sampel Taksi - Hijau NYC sebagai sumber data lalu pilih Berikutnya.

Pada layar pratinjau, pilih Berikutnya.

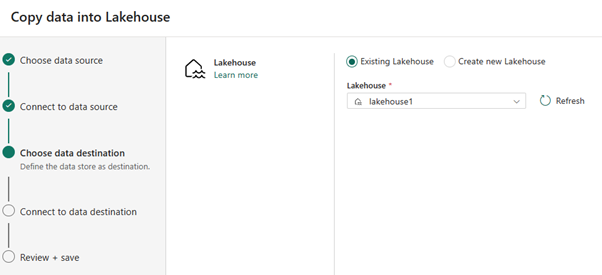

Untuk tujuan data, pilih nama lakehouse yang ingin Anda gunakan untuk menyimpan data tabel OneLake Delta. Anda dapat memilih lakehouse yang ada atau membuat yang baru.

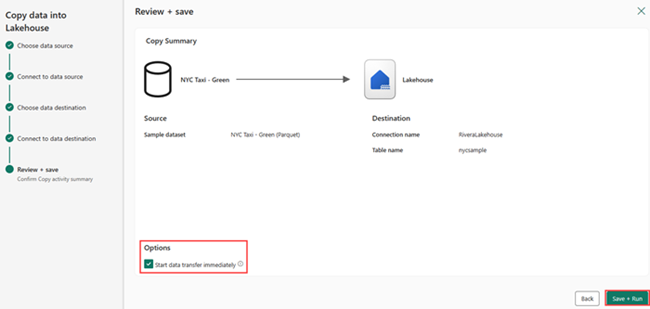

Pilih tempat Anda ingin menyimpan output. Pilih Tabel sebagai folder Akar dan masukkan "nycsample" sebagai nama tabel.

Pada layar Tinjau + Simpan, pilih Mulai transfer data segera lalu pilih Simpan + Jalankan.

Saat pekerjaan selesai, navigasikan ke lakehouse Anda dan lihat tabel delta yang tercantum di bawah /Tabel.

Salin jalur Azure Blob Filesystem (ABFS) ke tabel delta Anda dengan mengklik kanan nama tabel dalam tampilan Explorer dan memilih Properti.

Buka buku catatan Azure Databricks Anda. Baca tabel Delta di OneLake.

olsPath = "abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample" df=spark.read.format('delta').option("inferSchema","true").load(olsPath) df.show(5)Perbarui data tabel Delta dengan mengubah nilai bidang.

%sql update delta.`abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample` set vendorID = 99999 where vendorID = 1;

Konten terkait

Saran dan Komentar

Segera hadir: Sepanjang tahun 2024 kami akan menghentikan penggunaan GitHub Issues sebagai mekanisme umpan balik untuk konten dan menggantinya dengan sistem umpan balik baru. Untuk mengetahui informasi selengkapnya, lihat: https://aka.ms/ContentUserFeedback.

Kirim dan lihat umpan balik untuk