Catatan

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba masuk atau mengubah direktori.

Akses ke halaman ini memerlukan otorisasi. Anda dapat mencoba mengubah direktori.

Sekilas

Tujuan: Menyimulasikan Azure OpenAI menggunakan LLM lokal

Waktu: 15 menit

Plugins:OpenAIMockResponsePlugin

Prasyarat:Menyiapkan Proksi Dev, Model bahasa lokal

Saat Anda membangun aplikasi yang terhubung ke Azure OpenAI, sering kali, hanya sebagian aplikasi yang berinteraksi dengan Azure OpenAI API. Saat Anda mengerjakan bagian aplikasi yang tidak memerlukan balasan nyata dari Azure OpenAI API, Anda dapat mensimulasikan respons menggunakan Dev Proxy. Menggunakan respons yang disimulasikan memungkinkan Anda untuk menghindari timbulnya biaya yang tidak perlu. Menggunakan OpenAIMockResponsePlugin model bahasa lokal yang berjalan di komputer Anda untuk mensimulasikan respons dari Azure OpenAI API.

Sebelum memulai

Untuk mensimulasikan respons API Azure OpenAI menggunakan Proksi Dev, Anda memerlukan klien model bahasa yang didukung yang diinstal di komputer Anda.

Secara default, Dev Proxy menggunakan model bahasa llama3.2 yang berjalan di Ollama. Untuk menggunakan klien atau model yang berbeda, perbarui pengaturan model bahasa di file konfigurasi Dev Proxy.

Mengonfigurasi Dev Proxy untuk mensimulasikan respons Azure OpenAI API

Petunjuk / Saran

Langkah-langkah yang dijelaskan dalam tutorial ini tersedia dalam preset Proksi Dev yang siap digunakan. Untuk menggunakan preset, di baris perintah, jalankan devproxy config get simulate-azure-openai, dan ikuti instruksinya.

Untuk mensimulasikan respons Azure OpenAI API menggunakan Dev Proxy, Anda perlu mengaktifkan OpenAIMockResponsePlugin di dalam file devproxyrc.json.

File:devproxyrc.json

{

"$schema": "https://raw.githubusercontent.com/dotnet/dev-proxy/main/schemas/v2.1.0/rc.schema.json",

"plugins": [

{

"name": "OpenAIMockResponsePlugin",

"enabled": true,

"pluginPath": "~appFolder/plugins/DevProxy.Plugins.dll"

}

]

}

Selanjutnya, konfigurasikan Dev Proxy untuk mencegat permintaan ke Azure OpenAI API. Untuk kesederhanaan, gunakan wildcard untuk mencegat permintaan ke semua penyebaran.

File: devproxyrc.json

{

// [...] trimmed for brevity

"urlsToWatch": [

"https://*.openai.azure.com/openai/deployments/*/completions*"

]

}

Terakhir, konfigurasikan Dev Proxy untuk menggunakan model bahasa lokal.

File: devproxyrc.json

{

// [...] trimmed for brevity

"languageModel": {

"enabled": true

}

}

File konfigurasi lengkap terlihat seperti ini.

File: devproxyrc.json

{

"$schema": "https://raw.githubusercontent.com/dotnet/dev-proxy/main/schemas/v2.1.0/rc.schema.json",

"plugins": [

{

"name": "OpenAIMockResponsePlugin",

"enabled": true,

"pluginPath": "~appFolder/plugins/DevProxy.Plugins.dll"

}

],

"urlsToWatch": [

"https://*.openai.azure.com/openai/deployments/*/completions*"

],

"languageModel": {

"enabled": true

}

}

Mensimulasikan respons Azure OpenAI API

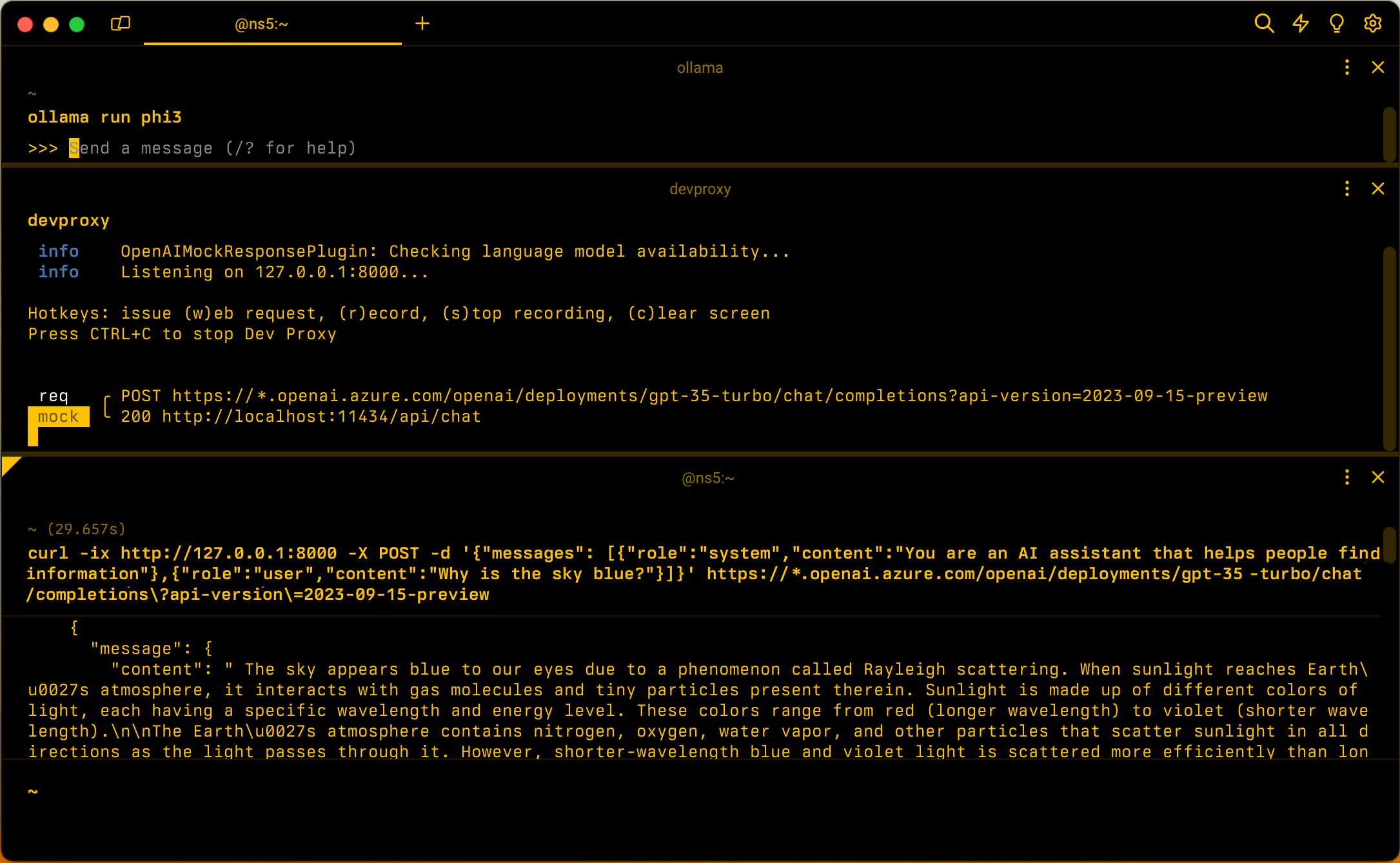

Dengan asumsi konfigurasi default, mulai Ollama dengan model bahasa llama3.2. Di baris perintah, jalankan ollama run llama3.2.

Selanjutnya mulai Dev Proxy. Jika Anda menggunakan prasetel, jalankan devproxy -c "~appFolder/config/simulate-azure-openai/simulate-azure-openai.json. Jika Anda menggunakan file konfigurasi kustom bernama devproxyrc.json, disimpan di direktori kerja saat ini, jalankan devproxy. Proksi Pengembang memeriksa bahwa ia dapat mengakses model bahasa di Ollama dan mengonfirmasi bahwa ia siap untuk mensimulasikan respons API Azure OpenAI.

info OpenAIMockResponsePlugin: Checking language model availability...

info Listening on 127.0.0.1:8000...

Hotkeys: issue (w)eb request, (r)ecord, (s)top recording, (c)lear screen

Press CTRL+C to stop Dev Proxy

Jalankan aplikasi Anda dan buat permintaan ke Azure OpenAI API. Dev Proxy mencegat permintaan dan mensimulasikan respons menggunakan model bahasa lokal.

Langkah selanjutnya

Pelajari selengkapnya tentang OpenAIMockResponsePlugin.

Sampel

Lihat juga sampel Proksi Dev terkait: