Menjelajahi Event Hubs Capture

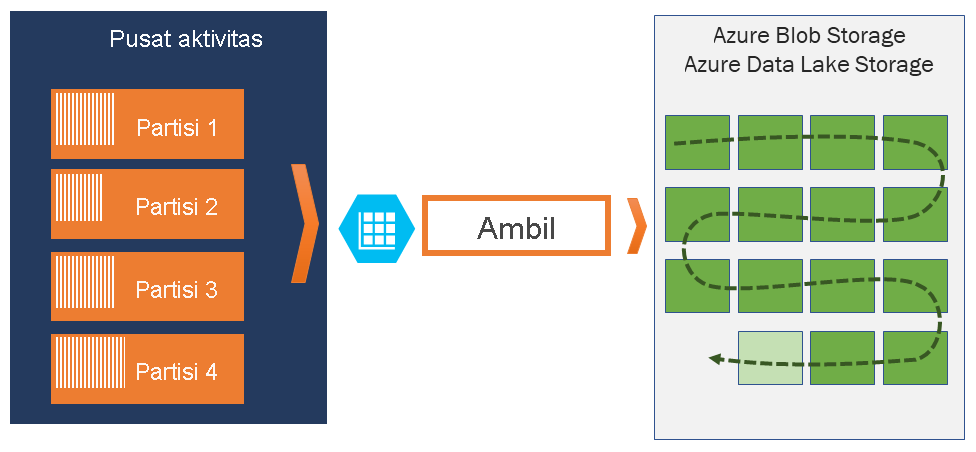

Dengan Azure Event Hubs, Anda dapat secara otomatis menangkap data streaming di Event Hubs dalam penyimpanan Azure Blob atau akun Azure Data Lake Storage pilihan Anda, yang juga memberi Anda fleksibilitas untuk menentukan interval waktu atau ukuran. Menyiapkan Capture cepat, tidak ada biaya administratif untuk menjalankannya, dan diskalakan secara otomatis dengan unit throughput Azure Event Hubs di tingkat standar atau unit pemrosesan di tingkat premium.

Event Hubs Capture memungkinkan Anda memproses alur berbasis real-time dan batch pada stream yang sama. Ini berarti Anda dapat membangun solusi yang berkembang sesuai kebutuhan Anda dari waktu ke waktu.

Cara kerja Azure Event Hubs Capture

Azure Event Hubs adalah buffer tahan lama atas retensi waktu untuk ingress telemetri, mirip dengan log terdistribusi. Kunci untuk penskalaan di Azure Event Hubs adalah model konsumen yang dipartisi. Setiap partisi adalah segmen data independen dan dikonsumsi secara independen. Seiring waktu, data ini menua, berdasarkan periode retensi yang dapat dikonfigurasi. Akibatnya, hub acara tertentu tidak pernah "terlalu penuh."

Event Hubs Capture memungkinkan Anda menentukan akun dan kontainer penyimpanan Azure Blob Anda sendiri, atau akun Azure Data Lake Store, yang digunakan untuk menyimpan data yang diambil. Akun-akun ini dapat berada di wilayah yang sama dengan hub acara Anda atau di wilayah lain, menambah fleksibilitas fitur Azure Event Hubs Capture.

Data yang diambil ditulis dalam format Apache Avro: format biner yang ringkas, cepat, yang menyediakan struktur data yang kaya dengan skema sebaris. Format ini banyak digunakan dalam ekosistem Hadoop, Azure Stream Analytics, dan Azure Data Factory. Informasi lebih lanjut tentang bekerja dengan Avro tersedia nanti di artikel ini.

Mengambil jendela

Azure Event Hubs Capture memungkinkan Anda menyiapkan jendela untuk mengontrol pengambilan. Jendela ini adalah konfigurasi ukuran dan waktu minimum dengan "kebijakan kemenangan pertama," yang berarti bahwa pemicu pertama yang ditemui menyebabkan operasi pengambilan. Setiap partisi mengambil secara independen dan menulis blob blok yang sudah selesai pada saat pengambilan, dinamai sesuai waktu saat interval pengambilan ditemukan. Konvensi penamaan penyimpanan adalah sebagai berikut:

{Namespace}/{EventHub}/{PartitionId}/{Year}/{Month}/{Day}/{Hour}/{Minute}/{Second}

Perhatikan bahwa nilai tanggal diisi dengan nol; contoh nama file mungkin:

https://mystorageaccount.blob.core.windows.net/mycontainer/mynamespace/myeventhub/0/2017/12/08/03/03/17.avro

Penskalaan ke unit throughput

Lalu lintas Azure Event Hubs dikendalikan oleh unit throughput. Satu unit throughput memungkinkan 1 MB per detik atau 1000 peristiwa per detik masuk dan dua kali jumlah egress. Azure Event Hubs Standar dapat dikonfigurasi dengan 1-20 unit throughput, dan Anda dapat membeli lebih banyak dengan permintaan dukungan peningkatan kuota. Penggunaan di luar unit throughput yang Anda beli dibatasi. Azure Event Hubs Capture menyalin data langsung dari penyimpanan Azure Event Hubs internal, melewati kuota egress unit throughput, dan menyimpan egress Anda untuk pembaca pemrosesan lainnya, seperti Azure Stream Analytics atau Spark.

Setelah dikonfigurasi, Azure Event Hubs Capture berjalan secara otomatis saat Anda mengirim peristiwa pertama, dan terus berjalan. Untuk memudahkan pemrosesan downstream Anda mengetahui bahwa prosesnya berfungsi, Azure Event Hubs menulis file kosong saat tidak ada data. Proses ini menyediakan irama dan penanda yang dapat diprediksi yang dapat memberi umpan prosesor batch Anda.