Analisis teks statistik.

Nota

Lihat tab Teks dan gambar untuk detail selengkapnya!

Setelah memecah korpus teks menjadi token konstituennya, dan menyiapkannya untuk analisis; ada beberapa teknik analisis statistik umum yang dapat Anda gunakan untuk menyimpulkan arti dari teks.

Analisis Frekuensi

Mungkin cara paling jelas untuk memastikan topik yang dibahas dalam dokumen adalah dengan menghitung berapa kali setiap token yang dinormalisasi muncul. Asumsinya adalah bahwa istilah yang lebih sering digunakan dalam dokumen dapat membantu mengidentifikasi subjek atau tema yang dibahas. Sederhananya, jika Anda dapat menentukan kata-kata yang paling umum digunakan dalam dokumen tertentu, Anda sering kali bisa mendapatkan gambaran yang baik tentang apa dokumen tersebut.

Misalnya, pertimbangkan teks berikut:

AI in modern business delivers transformative benefits by enhancing efficiency, decision-making, and customer experiences. Businesses can leverage AI to automate repetitive tasks, freeing employees to focus on strategic work, while predictive analytics and machine learning models enable data-driven decisions that improve accuracy and speed. AI-powered tools like Copilot streamline workflows across marketing, finance, and operations, reducing costs and boosting productivity. Additionally, intelligent applications personalize customer interactions, driving engagement and loyalty. By embedding AI into core processes, businesses benefit from the ability to innovate faster, adapt to market changes, and maintain a competitive edge in an increasingly digital economy.

Setelah tokenisasi, normalisasi, dan penerapan lemmatisasi ke teks, frekuensi setiap istilah dapat dihitung dan ditaulatasikan; menghasilkan hasil parsial berikut:

| Istilah | Frekuensi |

|---|---|

ai |

4 |

business |

3 |

benefit |

2 |

customer |

2 |

decision |

2 |

market |

2 |

ability |

1 |

accuracy |

1 |

| ... | ... |

Dari hasil ini, istilah yang paling sering terjadi menunjukkan bahwa teks membahas AI dan manfaat bisnisnya.

Frekuensi Istilah - Frekuensi Dokumen Terbalik (TF-IDF)

Analisis frekuensi sederhana di mana Anda menghitung jumlah kemunculan setiap token dapat menjadi cara yang efektif untuk menganalisis satu dokumen, tetapi ketika Anda perlu membedakan di beberapa dokumen dalam korpus yang sama, Anda memerlukan cara untuk menentukan token mana yang paling relevan dalam setiap dokumen individu.

Misalnya, pertimbangkan dua sampel teks berikut:

Sampel A:

Microsoft Copilot Studio enables declarative AI agent creation using natural language, prompts, and templates. With this declarative approach, an AI agent is configured rather than programmed: makers define intents, actions, and data connections, then publish the agent to channels. Microsoft Copilot Studio simplifies agent orchestration, governance, and lifecycles so an AI agent can be iterated quickly. Using Microsoft Copilot Studio helps modern businesses deploy Microsoft AI agent solutions fast.

Sampel B:

Microsoft Foundry enables code‑based AI agent development with SDKs and APIs. Developers write code to implement agent conversations, tool calling, state management, and custom pipelines. In Microsoft Foundry, engineers can use Python or Microsoft C#, integrate Microsoft AI services, and manage CI/CD to deploy the AI agent. This code-first development model supports extensibility and performance while building Microsoft Foundry AI agent applications.

Tiga istilah teratas yang paling sering dalam sampel ini diperlihatkan dalam tabel berikut:

Sampel A:

| Istilah | Frekuensi |

|---|---|

agent |

6 |

ai |

4 |

microsoft |

4 |

Sampel B:

| Istilah | Frekuensi |

|---|---|

microsoft |

5 |

agent |

4 |

ai |

4 |

Seperti yang Anda lihat dari hasilnya, kata yang paling umum dalam kedua sampel sama ("agent", "Microsoft", dan "AI"). Ini memberi tahu kami bahwa kedua dokumen mencakup tema keseluruhan yang serupa, tetapi tidak membantu kami mendiskriminasi antara dokumen individual. Memeriksa jumlah istilah yang kurang sering digunakan mungkin membantu, tetapi Anda dapat dengan mudah membayangkan analisis korpus berdasarkan dokumentasi AI Microsoft, yang akan menghasilkan sejumlah besar istilah yang umum di semua dokumen; sehingga sulit untuk menentukan topik tertentu yang tercakup dalam setiap dokumen.

Untuk mengatasi masalah ini, Frekuensi Istilah - Frekuensi Dokumen Terbalik (TF-IDF) adalah teknik yang menghitung skor berdasarkan seberapa sering kata atau istilah muncul dalam satu dokumen dibandingkan dengan frekuensinya yang lebih umum di seluruh kumpulan dokumen. Menggunakan teknik ini, tingkat relevansi tinggi diasumsikan untuk kata-kata yang sering muncul dalam dokumen tertentu, tetapi relatif jarang di berbagai dokumen lain. Untuk menghitung TF-IDF istilah pada dokumen tertentu, Anda bisa menggunakan tiga langkah berikut:

Hitung Frekuensi Istilah (TF): Ini hanya berapa kali kata muncul dalam dokumen. Misalnya, jika kata

"agent"muncul 6 kali dalam dokumen, makatf(agent) = 6.Hitung Frekuensi Dokumen Terbalik (IDF): Ini memeriksa seberapa umum atau langka kata di semua dokumen. Jika kata muncul di setiap dokumen, itu tidak istimewa. Rumus yang digunakan untuk menghitung IDF adalah

idf(t) = log(N / df(t))(di manaNjumlah total dokumen dandf(t)merupakan jumlah dokumen yang berisi katat)Gabungkan untuk menghitung TF-IDF: Kalikan TF dan IDF untuk mendapatkan skor:

tfidf(t, d) = tf(t, d) * log(N / df(t))

Skor TF-IDF tinggi menunjukkan bahwa kata sering muncul dalam satu dokumen tetapi jarang di dokumen lain. Skor rendah menunjukkan bahwa kata tersebut umum dalam banyak dokumen. Dalam dua sampel tentang agen AI, karena "AI", "Microsoft", dan "agent" muncul di kedua sampel (N = 2, df(t) = 2), IDF mereka adalah log(2/2) = 0, sehingga mereka tidak membawa berat diskriminatif dalam TF-IDF. Tiga hasil TF-IDF teratas untuk sampel adalah:

Sampel A:

| Istilah | TF-IDF |

|---|---|

copilot |

2.0794 |

studio |

2.0794 |

declarative |

1.3863 |

Sampel B:

| Istilah | TF-IDF |

|---|---|

code |

2.0794 |

develop |

2.0794 |

foundry |

2.0794 |

Dari hasil ini, lebih jelas bahwa sampel A adalah tentang pembuatan agen deklaratif dengan Copilot Studio, sementara sampel B adalah tentang pengembangan agen berbasis kode dengan Microsoft Foundry.

Teknik pembelajaran mesin "Bag-of-words"

Bag-of-words adalah nama yang diberikan untuk teknik ekstraksi fitur yang mewakili token teks sebagai vektor frekuensi atau kemunculan kata, mengabaikan tata bahasa dan urutan kata. Representasi ini menjadi input untuk algoritma pembelajaran mesin seperti Naive Bayes, pengklasifikasi probabilistik yang menerapkan teori Bayes untuk memprediksi kelas dokumen yang mungkin berdasarkan frekuensi kata.

Misalnya, Anda dapat menggunakan teknik ini untuk melatih model pembelajaran mesin yang melakukan pemfilteran spam email. Kata "miracle cure", "lose weight fast", dan "anti-penuaan" mungkin lebih sering muncul dalam email spam tentang produk kesehatan yang meragukan daripada dalam email reguler Anda, dan model terlatih mungkin menandai pesan yang berisi kata-kata ini sebagai potensi spam.

Anda dapat menerapkan analisis sentimen dengan menggunakan metode yang sama untuk mengklasifikasikan teks dengan nada emosional. Kantong kata-kata menyediakan fitur, dan model menggunakan fitur-fitur tersebut untuk memperkirakan probabilitas dan menetapkan label sentimen seperti "positif" atau "negatif".

TextRank

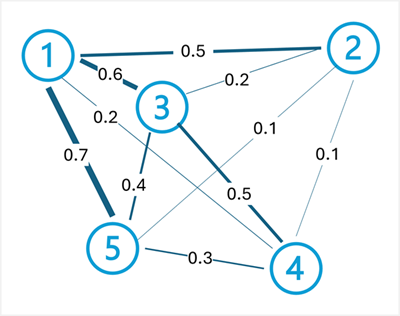

TextRank adalah algoritma berbasis grafik yang tidak diawasi yang memodelkan teks sebagai jaringan simpul yang terhubung. Misalnya, setiap kalimat dalam dokumen dapat dianggap sebagai simpul, dan koneksi (tepi) di antaranya dinilai berdasarkan kesamaan kata yang dikandungnya. TextRank umumnya digunakan untuk meringkas teks berdasarkan mengidentifikasi subset kalimat dalam dokumen yang paling mewakili subjek keseluruhannya.

Algoritma TextRank menerapkan prinsip yang sama dengan algoritma PageRank Google (yang memberi peringkat halaman web berdasarkan tautan di antaranya) ke teks. Ide utamanya adalah bahwa kalimat penting jika mirip dengan banyak kalimat penting lainnya. Algoritma bekerja melalui langkah-langkah berikut:

Buat grafik: Setiap kalimat menjadi simpul, dan tepi yang menghubungkannya ditimbang oleh kesamaan (sering diukur menggunakan tumpang tindih kata atau kesamaan kosinus antara vektor kalimat).

Hitung peringkat secara berulang: Setiap skor simpul dihitung berdasarkan skor simpul yang terhubung ke dalamnya. Rumusnya adalah:

TextRank(Sᵢ) = (1-d) + d * Σ(wⱼᵢ / Σwⱼₖ) * TextRank(Sⱼ)(di manadadalah faktor peredam, biasanya 0,85,wⱼᵢadalah berat tepi dari kalimatjke kalimati, dan jumlah iterasi atas semua kalimat yang terhubung kei).Ekstrak kalimat peringkat teratas: Setelah konvergensi, kalimat dengan skor tertinggi dipilih sebagai ringkasan.

Misalnya, pertimbangkan dokumen berikut tentang komputasi cloud:

Cloud computing provides on-demand access to computing resources. Computing resources include servers, storage, and networking. Azure is Microsoft's cloud computing platform. Organizations use cloud platforms to reduce infrastructure costs. Cloud computing enables scalability and flexibility.

Untuk menghasilkan ringkasan dokumen ini, proses TextRank dimulai dengan memisahkan dokumen ini menjadi kalimat:

Cloud computing provides on-demand access to computing resources.Computing resources include servers, storage, and networking.Azure is Microsoft's cloud computing platform.Organizations use cloud platforms to reduce infrastructure costs.Cloud computing enables scalability and flexibility.

Selanjutnya, tepi dibuat di antara kalimat dengan bobot berdasarkan kesamaan (tumpang tindih kata). Untuk contoh ini, bobot tepi mungkin:

- Kalimat 1 <-> Kalimat 2: 0,5 (berbagi

"computing resources") - Kalimat 1 <-> Kalimat 3: 0.6 (berbagi

"cloud computing") - Kalimat 1 <-> Kalimat 4: 0.2 (berbagi

"cloud") - Kalimat 1 <-> Kalimat 5: 0.7 (berbagi

"cloud computing") - Kalimat 2 <-> Kalimat 3: 0.2 (tumpang tindih terbatas)

- Kalimat 2 <-> Kalimat 4: 0.1 (tumpang tindih terbatas)

- Kalimat 2 <-> Kalimat 5: 0.1 (berbagi

"computing") - Kalimat 3 <-> Kalimat 4: 0,5 (berbagi

"cloud platforms") - Kalimat 3 <-> Kalimat 5: 0.4 (berbagi

"cloud computing") - Kalimat 4 <-> Kalimat 5: 0,3 (tumpang tindih terbatas)

Setelah menghitung skor TextRank secara berulang menggunakan bobot ini, kalimat 1, 3, dan 5 mungkin menerima skor tertinggi karena terhubung dengan baik ke kalimat lain melalui terminologi dan konsep bersama. Kalimat ini akan dipilih untuk membentuk ringkasan ringkasan: "Cloud computing provides on-demand access to computing resources. Azure is Microsoft's cloud computing platform. Cloud computing enables scalability and flexibility."

Nota

Membuat ringkasan dokumen dengan memilih kalimat yang paling relevan adalah bentuk ringkasan ekstraktif . Dalam pendekatan ini, tidak ada teks baru yang dihasilkan - ringkasan terdiri dari subset teks asli. Perkembangan terbaru dalam pemodelan semantik juga memungkinkan ringkasan abstraktif , di mana bahasa baru yang meringkas tema utama dokumen sumber dihasilkan.

TextRank juga dapat diterapkan pada tingkat kata untuk ekstraksi kata kunci, di mana kata (daripada kalimat) menjadi simpul, dan tepi mewakili kemunculan bersama dalam jendela tetap. Kata-kata berpangkat tertinggi diekstrak sebagai istilah kunci yang mewakili topik utama dokumen.