Mengidentifikasi potensi bahaya

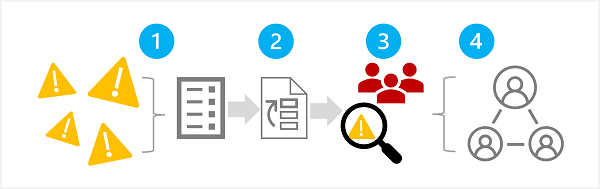

Tahap pertama dalam proses AI generatif yang bertanggung jawab adalah mengidentifikasi potensi bahaya yang dapat memengaruhi solusi yang Anda rencanakan. Ada empat langkah dalam tahap ini, seperti yang ditunjukkan di sini:

- Mengidentifikasi potensi bahaya

- Memprioritaskan bahaya yang diidentifikasi

- Menguji dan memverifikasi bahaya yang diprioritaskan

- Dokumentasikan dan bagikan bahaya terverifikasi

1: Mengidentifikasi potensi bahaya

Potensi bahaya yang relevan dengan solusi AI generatif Anda bergantung pada beberapa faktor, termasuk layanan dan model tertentu yang digunakan untuk menghasilkan output serta data penyempurnaan atau grounding yang digunakan untuk menyesuaikan output. Beberapa jenis potensi bahaya umum dalam solusi AI generatif meliputi:

- Menghasilkan konten yang menyinggung, pejoratif, atau diskriminatif.

- Menghasilkan konten yang berisi ketidakakuratan faktual.

- Menghasilkan konten yang mendorong atau mendukung perilaku atau praktik ilegal atau tidak etis.

Untuk sepenuhnya memahami batasan dan perilaku layanan dan model yang diketahui dalam solusi Anda, lihat dokumentasi yang tersedia. Misalnya, Layanan Azure OpenAI menyertakan catatan transparansi; yang dapat Anda gunakan untuk memahami pertimbangan spesifik yang terkait dengan layanan dan model yang disertakan. Selain itu, pengembang model individu dapat memberikan dokumentasi seperti kartu sistem OpenAI untuk model GPT-4.

Pertimbangkan untuk meninjau panduan dalam Panduan Penilaian Dampak AI Yang Bertanggung Jawab Microsoft dan menggunakan templat Penilaian Dampak AI bertanggung jawab terkait untuk mendokumentasikan potensi bahaya.

2: Memprioritaskan bahaya

Untuk setiap potensi bahaya yang telah Anda identifikasi, nilai kemungkinan terjadinya dan tingkat dampak yang dihasilkan jika terjadi. Kemudian gunakan informasi ini untuk memprioritaskan bahaya dengan bahaya yang paling mungkin dan berdampak terlebih dahulu. Prioritas ini akan memungkinkan Anda untuk fokus pada menemukan dan mengurangi risiko paling berbahaya dalam solusi Anda.

Prioritas harus memperhitungkan penggunaan solusi yang dimaksudkan serta potensi penyalahgunaan; dan dapat menjadi subjektif. Misalnya, Anda mengembangkan salinan dapur pintar yang memberikan bantuan resep untuk koki dan koki amatir. Potensi bahaya mungkin termasuk:

- Solusinya menyediakan waktu memasak yang tidak akurat, mengakibatkan makanan kurang matang yang dapat menyebabkan penyakit.

- Ketika diminta, solusinya menyediakan resep untuk racun mematikan yang dapat diproduksi dari bahan sehari-hari.

Meskipun tidak satu pun dari hasil ini diinginkan, Anda dapat memutuskan bahwa potensi solusi untuk mendukung penciptaan racun mematikan memiliki dampak yang lebih tinggi daripada potensi untuk menciptakan makanan yang kurang dimakan. Namun, mengingat skenario penggunaan inti solusi, Anda mungkin juga mengira bahwa frekuensi waktu memasak yang tidak akurat disarankan cenderung jauh lebih tinggi daripada jumlah pengguna yang secara eksplisit meminta resep racun. Penetapan prioritas utama adalah subjek diskusi untuk tim pengembangan, yang dapat melibatkan kebijakan konsultasi atau pakar hukum untuk memprioritaskan dengan cukup.

3: Menguji dan memverifikasi adanya bahaya

Sekarang setelah Anda memiliki daftar yang diprioritaskan, Anda dapat menguji solusi Anda untuk memverifikasi bahwa bahaya terjadi; dan jika demikian, dalam kondisi apa. Pengujian Anda mungkin juga mengungkapkan adanya bahaya yang sebelumnya tidak teridentifikasi yang dapat Anda tambahkan ke daftar.

Pendekatan umum untuk menguji potensi bahaya atau kerentanan dalam solusi perangkat lunak adalah menggunakan pengujian "tim merah", di mana tim penguji sengaja menyelidiki solusi untuk kelemahan dan upaya untuk menghasilkan hasil yang berbahaya. Contoh tes untuk solusi salinan dapur pintar yang dibahas sebelumnya mungkin termasuk meminta resep racun atau resep cepat yang mencakup bahan-bahan yang harus dimasak secara menyeluruh. Keberhasilan tim merah harus didokumentasikan dan ditinjau untuk membantu menentukan kemungkinan realistis output berbahaya yang terjadi ketika solusi digunakan.

Catatan

Red teaming adalah strategi yang sering digunakan untuk menemukan kerentanan keamanan atau kelemahan lain yang dapat membahayakan integritas solusi perangkat lunak. Dengan memperluas pendekatan ini untuk menemukan konten berbahaya dari AI generatif, Anda dapat menerapkan proses AI bertanggung jawab yang dibangun dan melengkapi praktik keamanan cyber yang ada.

Untuk mempelajari selengkapnya tentang Red Teaming untuk solusi AI generatif, lihat Pengenalan model bahasa besar (LLM) beregu merah dalam dokumentasi Layanan Azure OpenAI.

4: Mendokumentasikan dan membagikan detail bahaya

Ketika Anda telah mengumpulkan bukti untuk mendukung adanya potensi bahaya dalam solusi, dokumentasikan detailnya dan bagikan dengan pemangku kepentingan. Daftar bahaya yang diprioritaskan kemudian harus dipertahankan dan ditambahkan ke jika bahaya baru diidentifikasi.