Caricare dati da Microsoft 365 (Office 365) usando Azure Data Factory

SI APPLICA A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Suggerimento

Provare Data Factory in Microsoft Fabric, una soluzione di analisi all-in-one per le aziende. Microsoft Fabric copre tutto, dallo spostamento dati al data science, all'analisi in tempo reale, alla business intelligence e alla creazione di report. Vedere le informazioni su come iniziare una nuova prova gratuita!

Questo articolo illustra come usare Data Factory per caricare i dati da Microsoft 365 (Office 365) nell'archivio BLOB di Azure. È possibile seguire una procedura simile per copiare i dati in Azure Data Lake Gen1 o Gen2. Vedere l'articolo connettore Microsoft 365 (Office 365) sulla copia dei dati da Microsoft 365 (Office 365) in generale.

Creare una data factory

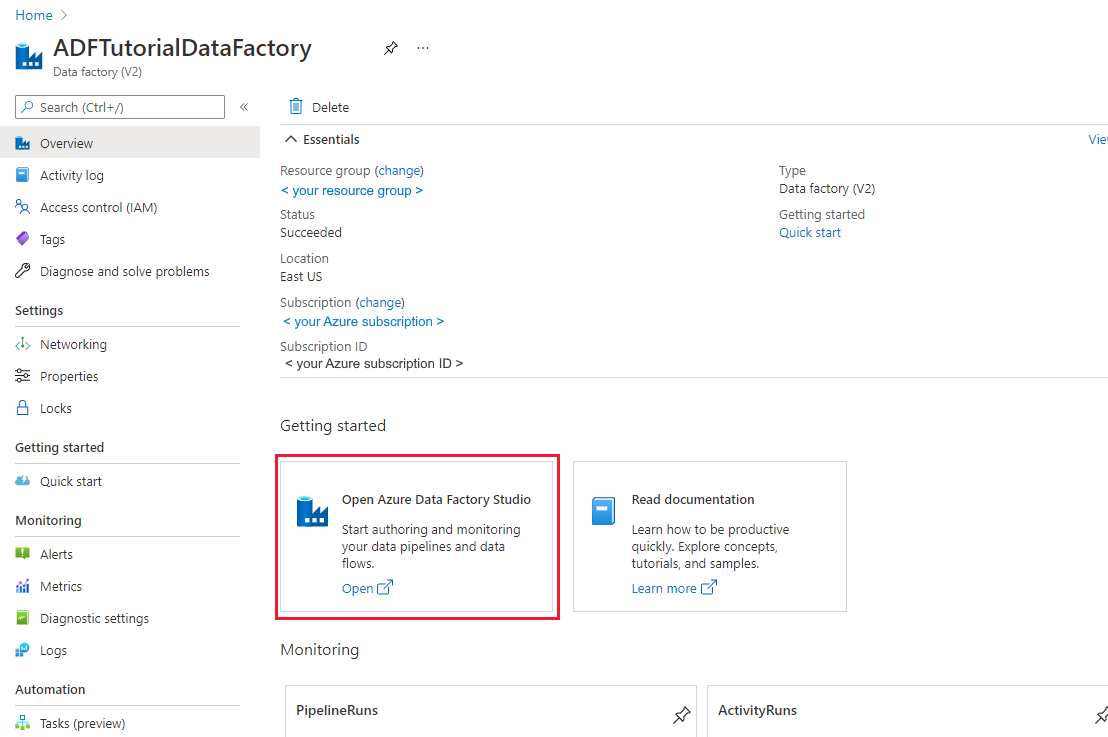

Se non è ancora stato creato il data factory, seguire la procedura descritta in Avvio rapido: creare un data factory usando il portale di Azure e Azure Data Factory Studio per crearne uno. Dopo averlo creato, passare alla data factory nel portale di Azure.

Selezionare Apri nel riquadro Apri Azure Data Factory Studio per avviare l'applicazione Integrazione dei dati in una scheda separata.

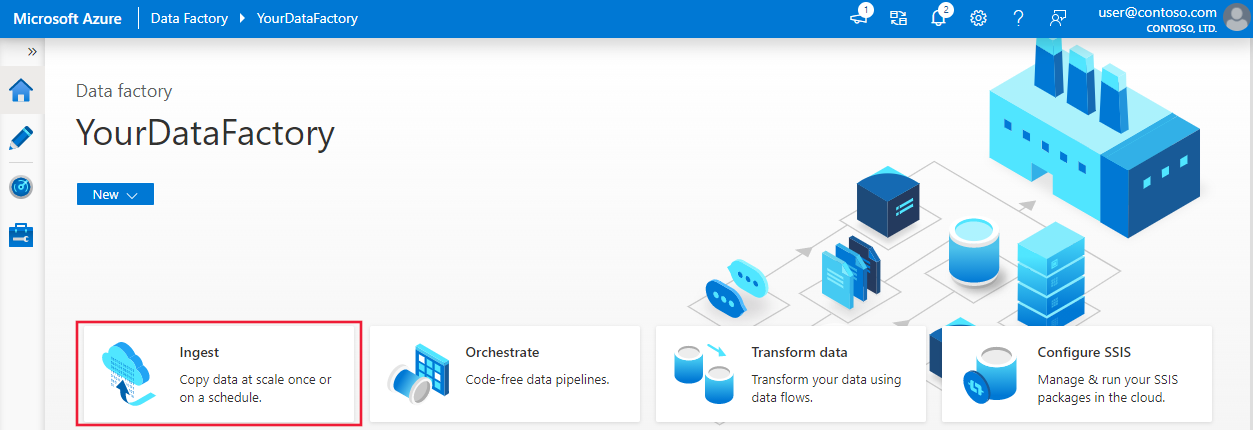

Creare una pipeline

Nella home page selezionare Orchestrate.On the home page, select Orchestrate.

Nella scheda Generale della pipeline immettere "CopyPipeline" nel campo Nome della pipeline.

Nella casella > dello strumento Attività Spostare e trasformare categoria > trascinare e rilasciare il attività Copy dalla casella degli strumenti all'area di progettazione della pipeline. Specificare "CopyFromOffice365ToBlob" come nome dell'attività.

Nota

Usare il runtime di integrazione di Azure nei servizi collegati di origine e sink. Il runtime di integrazione self-hosted e il runtime di integrazione della rete virtuale gestita non sono supportati.

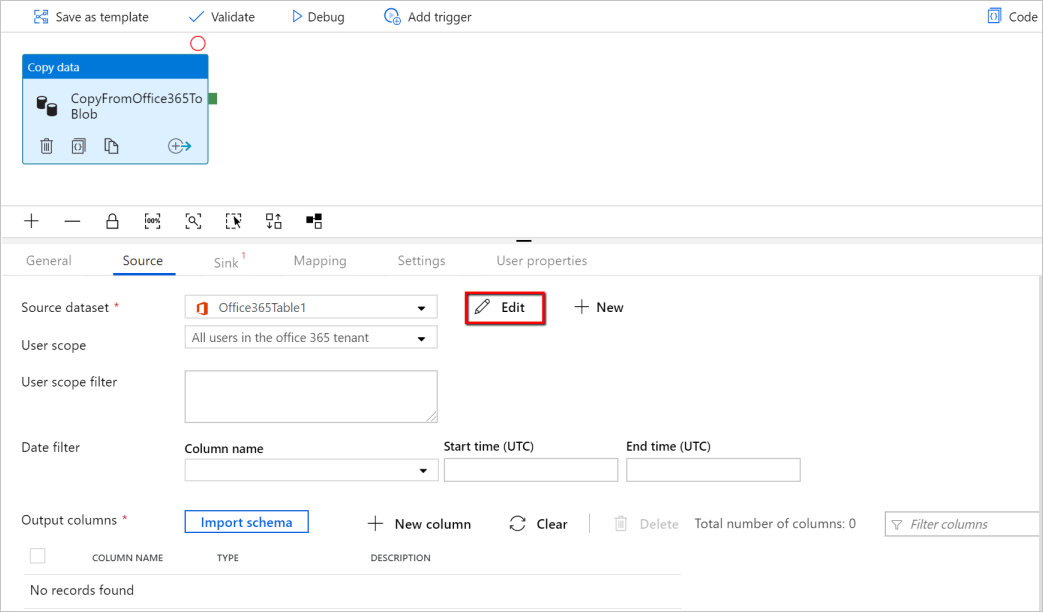

Configurare l'origine

Passare alla scheda Origine pipeline>, selezionare + Nuovo per creare un set di dati di origine.

Nella finestra Nuovo set di dati selezionare Microsoft 365 (Office 365) e quindi selezionare Continua.

Si è ora nella scheda di configurazione dell'attività di copia. Selezionare il pulsante Modifica accanto al set di dati di Microsoft 365 (Office 365) per continuare la configurazione dei dati.

Viene visualizzata una nuova scheda aperta per il set di dati di Microsoft 365 (Office 365). Nella scheda Generale nella parte inferiore della Finestra Proprietà immettere "SourceOffice365Dataset" per Nome.

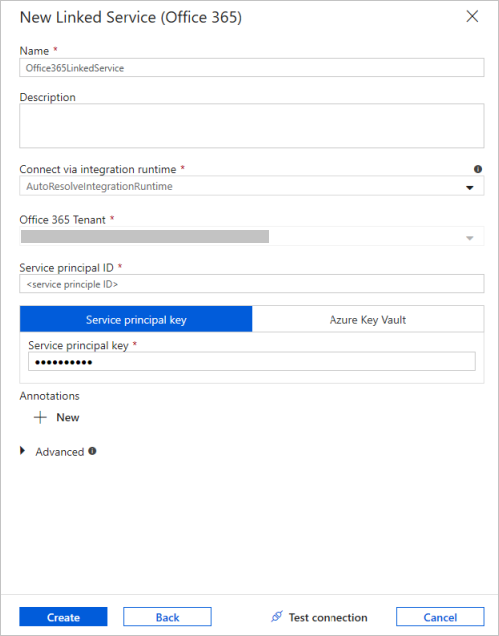

Passare alla scheda Connessione della Finestra Proprietà. Selezionare + Nuovo accanto alla casella di testo Servizio collegato.

Nella finestra Nuovo servizio collegato immettere "Office365LinkedService" come nome, immettere l'ID entità servizio e la chiave dell'entità servizio, quindi testare la connessione e selezionare Crea per distribuire il servizio collegato.

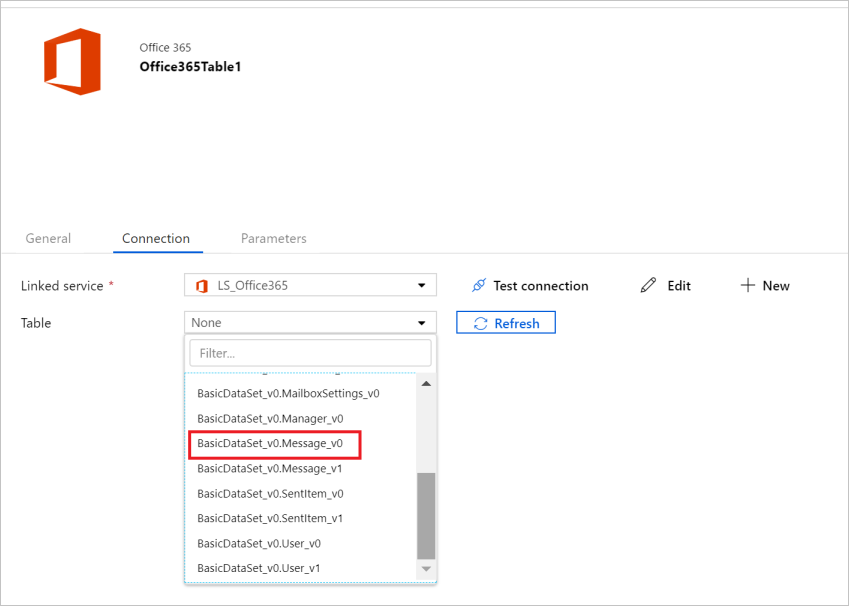

Dopo aver creato il servizio collegato, si torna alle impostazioni del set di dati. Accanto a Tabella scegliere la freccia giù per espandere l'elenco dei set di dati di Microsoft 365 (Office 365) disponibili e scegliere "BasicDataSet_v0. Message_v0" dall'elenco a discesa:

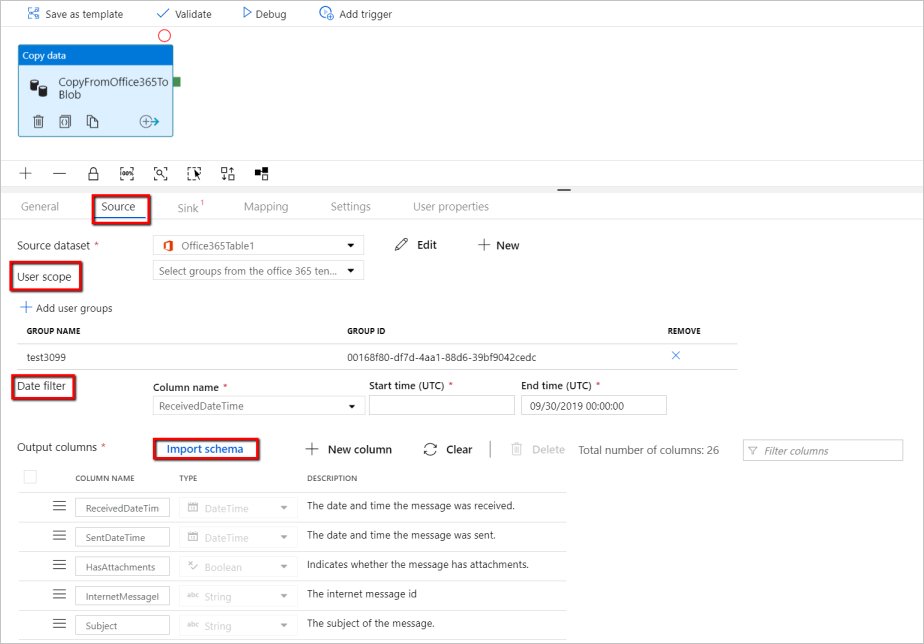

Tornare ora alla scheda Origine pipeline>per continuare a configurare proprietà aggiuntive per l'estrazione dei dati di Microsoft 365 (Office 365). L'ambito utente e il filtro ambito utente sono predicati facoltativi che è possibile definire per limitare i dati da estrarre da Microsoft 365 (Office 365). Per informazioni su come configurare queste impostazioni, vedere la sezione proprietà del set di dati di Microsoft 365 (Office 365).

È necessario scegliere uno dei filtri di data e specificare i valori di ora di inizio e ora di fine.

Selezionare la scheda Importa schema per importare lo schema per il set di dati Message.

Configurare il sink

Passare alla scheda Sink della pipeline >e selezionare + Nuovo per creare un set di dati sink.

Nella finestra Nuovo set di dati si noti che solo le destinazioni supportate vengono selezionate durante la copia da Microsoft 365 (Office 365). Selezionare Archiviazione BLOB di Azure, selezionare Formato binario e quindi Continua. In questa esercitazione si copiano i dati di Microsoft 365 (Office 365) in un Archiviazione BLOB di Azure.

Selezionare il pulsante Modifica accanto al set di dati Archiviazione BLOB di Azure per continuare la configurazione dei dati.

Nella scheda Generale della Finestra Proprietà immettere "OutputBlobDataset" in Nome.

Passare alla scheda Connessione della Finestra Proprietà. Selezionare + Nuovo accanto alla casella di testo Servizio collegato.

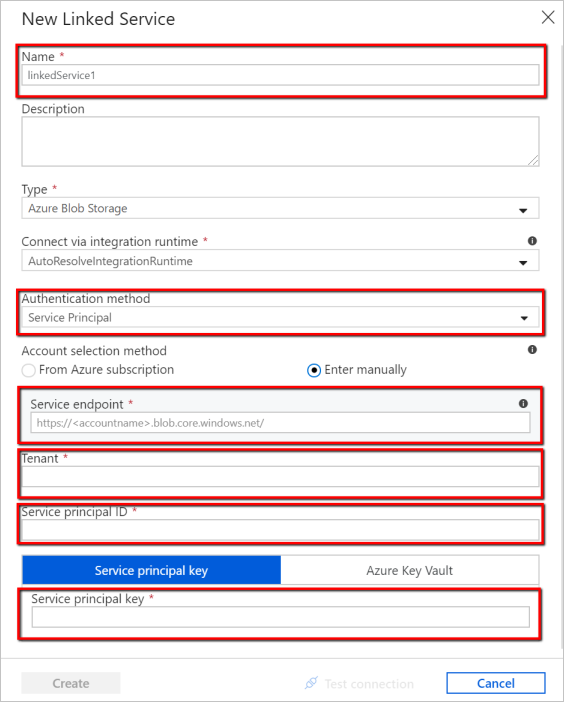

Nella finestra Nuovo servizio collegato immettere "AzureStorageLinkedService" come nome, selezionare "Entità servizio" nell'elenco a discesa dei metodi di autenticazione, compilare l'endpoint servizio, il tenant, l'ID entità servizio e la chiave dell'entità servizio, quindi selezionare Salva per distribuire il servizio collegato. Fare riferimento qui per informazioni su come configurare l'autenticazione dell'entità servizio per Archiviazione BLOB di Azure.

Convalidare la pipeline

Per convalidare la pipeline, selezionare Convalida dalla barra degli strumenti.

È possibile visualizzare il codice JSON associato alla pipeline facendo clic su Codice in alto a destra.

Pubblicare la pipeline

Nella barra degli strumenti superiore selezionare l'azione Publish All (Pubblica tutto). Questa azione pubblica le entità create (set di dati e pipeline) in Data Factory.

Attivare manualmente la pipeline

Selezionare Aggiungi trigger nella barra degli strumenti, quindi selezionare Attiva adesso. Nella pagina Pipeline Run (Esecuzione pipeline) selezionare Fine.

Monitorare la pipeline

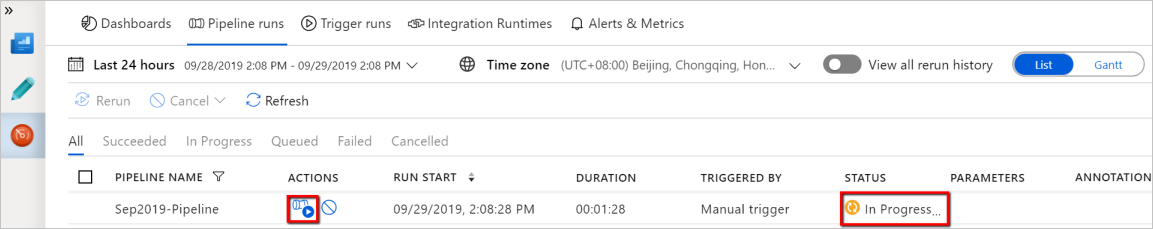

Passare alla scheda Monitoraggio a sinistra. Viene visualizzata un'esecuzione della pipeline attivata da un trigger manuale. È possibile usare i collegamenti nella colonna Azioni per visualizzare i dettagli delle attività ed eseguire di nuovo la pipeline.

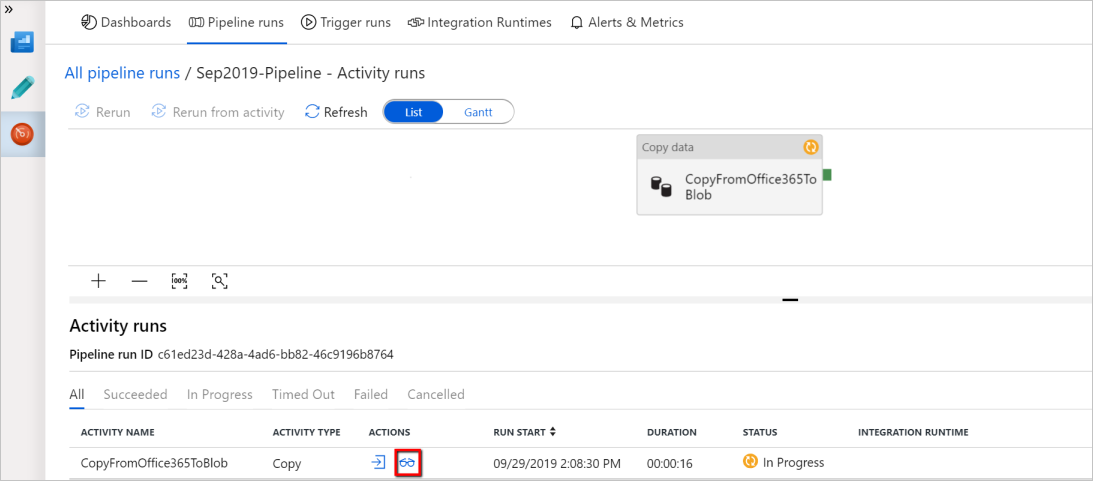

Per visualizzare le esecuzioni di attività associate all'esecuzione della pipeline, selezionare il collegamento View Activity Runs (Visualizza le esecuzioni di attività) nella colonna Azioni. In questo esempio è presente una sola attività, quindi nell'elenco viene visualizzata una sola voce. Per informazioni dettagliate sull'operazione di copia, selezionare il collegamento Dettagli (icona a forma di occhiali) nella colonna Azioni.

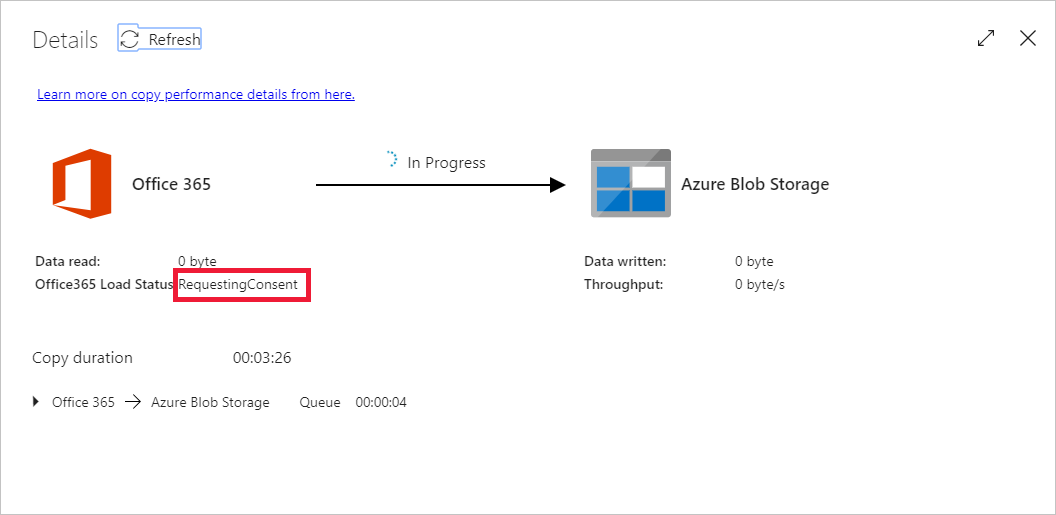

Se questa è la prima volta che si richiedono dati per questo contesto (una combinazione della tabella dati a cui si accede, quale account di destinazione è i dati caricati e in quale identità utente effettua la richiesta di accesso ai dati), verrà visualizzato lo stato dell'attività di copia come In corso e solo quando si seleziona il collegamento "Dettagli" in Azioni verrà visualizzato lo stato RequesetingConsent. Un membro del gruppo dei responsabili dell'approvazione dell'accesso ai dati deve approvare la richiesta in Privileged Access Management prima che l'estrazione dei dati prosegua.

Stato come richiesta di consenso:

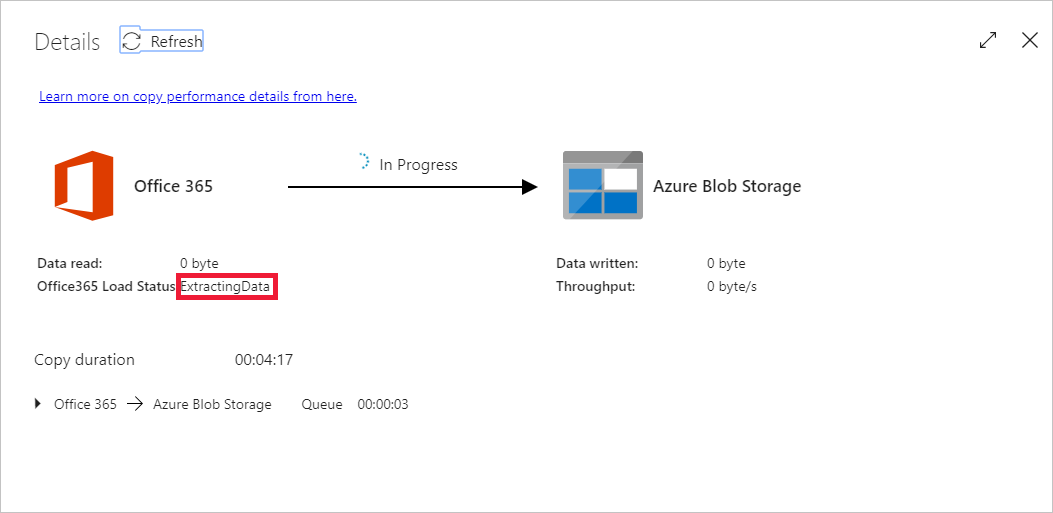

Stato come estrazione dati:

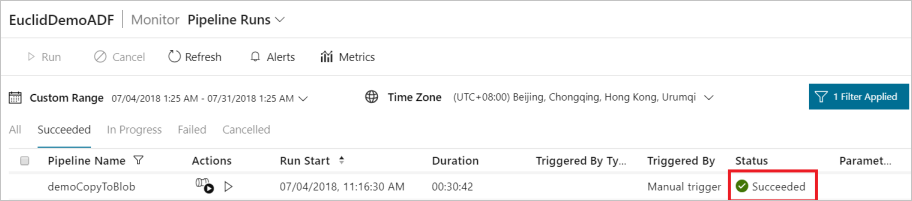

Dopo aver fornito il consenso, l'estrazione dei dati continuerà e, dopo qualche tempo, l'esecuzione della pipeline verrà visualizzata come completata.

Passare ora al Archiviazione BLOB di Azure di destinazione e verificare che i dati di Microsoft 365 (Office 365) siano stati estratti in formato binario.

Contenuto correlato

Leggere gli articoli seguenti per altre informazioni sul supporto di Azure Synapse Analytics:

Commenti e suggerimenti

Presto disponibile: Nel corso del 2024 verranno gradualmente disattivati i problemi di GitHub come meccanismo di feedback per il contenuto e ciò verrà sostituito con un nuovo sistema di feedback. Per altre informazioni, vedere https://aka.ms/ContentUserFeedback.

Invia e visualizza il feedback per