Calcola carichi di lavoro di applicazioni HPC su larga scala nelle macchine virtuali di Azure

Il termine big compute (usato in riferimento a HPC) descrive carichi di lavoro su larga scala che richiedono un numero elevato di core, spesso numerati in centinaia o migliaia. Gli scenari includono il rendering delle immagini, la dinamica dei fluidi, la modellazione dei rischi finanziari, la ricerca del petrolio, la creazione di farmaci e l'analisi delle sollecitazioni ingegneristiche, tra gli altri.

Di seguito sono riportate le caratteristiche tipiche delle applicazioni big compute:

- È possibile dividere il lavoro in attività separate, che possono essere eseguite contemporaneamente su più core.

- Ogni attività è finita. Accetta l'input, esegue alcune operazioni di elaborazione e produce un output. Tutta l'applicazione viene eseguita per un periodo di tempo limitato, che può andare da minuti a giorni. Un modello comune consiste nel configurare molti core in un burst e quindi ruotare fino a zero al termine dell'applicazione.

- L'applicazione non deve rimanere aggiornata 24/7. Tuttavia, il sistema deve gestire gli errori del nodo o gli arresti anomali dell'applicazione.

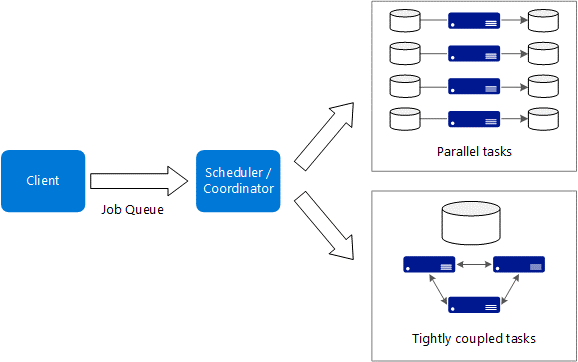

- Per alcune applicazioni, le attività sono indipendenti e possono essere eseguite in parallelo. In altri casi, le attività sono strettamente collegate, vale a dire che devono interagire o scambiarsi i risultati intermedi. In questo caso considerare l'uso di tecnologie di rete ad alta velocità, come InfiniBand e l'accesso diretto a memoria remota.

- A seconda del carico di lavoro, è possibile usare macchine virtuali con dimensioni per elevati livelli di calcolo, ad esempio H16r, H16mr e A9.

Azure offre un'ampia gamma di istanze di macchine virtuali ottimizzate per carichi di lavoro a elevato utilizzo di CPU e GPU (sia calcolo che visualizzazione). Le macchine virtuali sono ideali per l'esecuzione di carichi di lavoro di petrolio e gas.

Azure è l'unica piattaforma cloud che offre istanze di macchina virtuale con hardware abilitato per InfiniBand. Questa funzionalità offre un vantaggio significativo in termini di prestazioni per l'esecuzione di carichi di lavoro sismici e di simulazione del serbatoio. Le prestazioni migliorate limitano il divario di prestazioni e comportano prestazioni quasi o migliori rispetto alle infrastrutture locali correnti.

Le macchine virtuali di Azure hanno molte opzioni diverse, note come dimensioni delle macchine virtuali. Esistono diverse serie di dimensioni delle macchine virtuali per HPC e per il calcolo ottimizzato per GPU. Selezionare le dimensioni della macchina virtuale appropriate per il carico di lavoro che si vuole usare. Per altre informazioni sulla selezione delle dimensioni delle macchine virtuali, vedere lo strumento Dimensioni per le macchine virtuali nel selettore di Azure.

Non tutti i prodotti Azure sono disponibili in tutte le aree di Azure. Per altre informazioni, vedere l'elenco corrente dei prodotti disponibili in base all'area.

Per le procedure consigliate sulle scelte disponibili nel calcolo di Azure, vedere il blog di calcolo di Azure o vedere il contenuto del servizio di calcolo di Azure per scegliere un servizio.

Macchine virtuali basate su CPU

Macchine virtuali abilitate per GPU

Le MACCHINE virtuali serie N includono GPU NVIDIA progettate per applicazioni a elevato utilizzo di calcolo o a elevato utilizzo di grafica, tra cui intelligenza artificiale (IA), apprendimento e visualizzazione.

Gli SKU HPC vengono creati appositamente per scenari a prestazioni elevate. Azure offre anche altri SKU che potrebbero essere adatti per determinati carichi di lavoro eseguiti nell'infrastruttura HPC. È possibile eseguire questi SKU in modo efficace su hardware meno costoso. Alcuni SKU di calcolo comunemente usati sono la serie E e F.

Considerazioni sulla progettazione HPC

L'Utilità di pianificazione dei processi è un servizio specializzato per la pianificazione del lavoro a elevato utilizzo di calcolo da eseguire in un pool gestito di macchine virtuali. È possibile ridimensionare automaticamente le risorse di calcolo per soddisfare le esigenze dei processi.

Azure Batch è un servizio gestito per l'esecuzione di applicazioni HPC su larga scala. Usando Azure Batch, si configura un pool di macchine virtuali e quindi si caricano le applicazioni e i file di dati. Il servizio Batch configura quindi le macchine virtuali, assegna le attività alle macchine virtuali, esegue le attività e monitora lo stato di avanzamento. Batch può aumentare e ridurre automaticamente le macchine virtuali in risposta alla modifica dei carichi di lavoro. Batch offre anche una funzionalità di pianificazione dei processi.

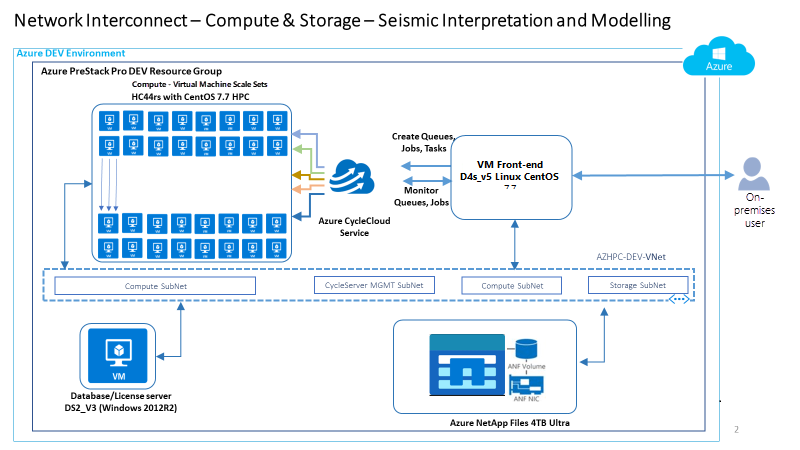

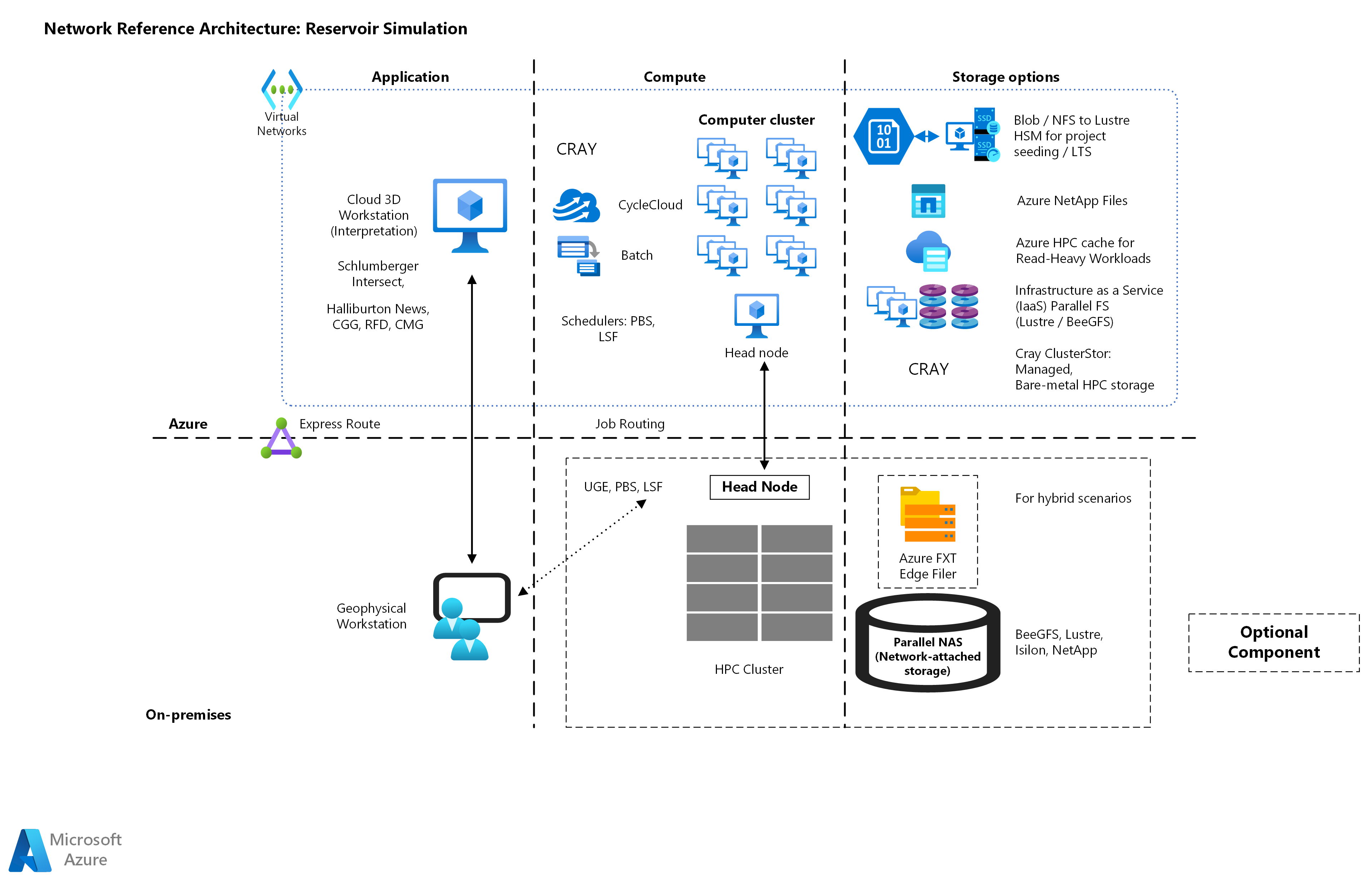

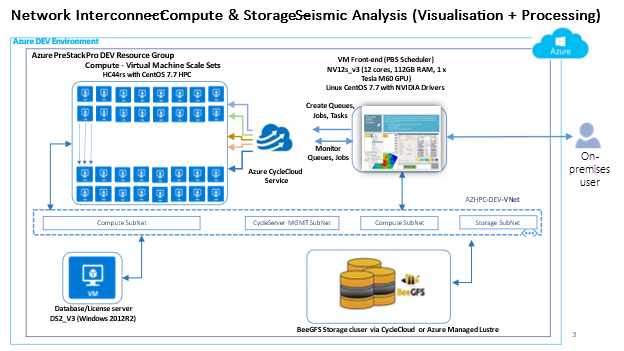

Azure CycleCloud è uno strumento per la creazione, la gestione, il funzionamento e l'ottimizzazione di cluster HPC e Big Compute in Azure. Con Azure CycleCloud, gli utenti possono configurare in modo dinamico i cluster HPC di Azure e orchestrare i dati e i processi per i flussi di lavoro ibridi e cloud. Azure CycleCloud offre il modo più semplice per gestire i carichi di lavoro HPC, usando vari gestori di carico di lavoro (ad esempio, Motore griglia, HPC Pack, HTCondor, LSF, PBS Pro, Slurm o Symphony) in Azure.

Raccomandazioni per la progettazione HPC

- I flussi di lavoro sia per il serbatoio che per i flussi di lavoro sismici hanno in genere requisiti simili per la pianificazione dei processi e di calcolo.

- Anche se si considerano le esigenze di rete, per le simulazioni di immagini sismiche e serbatoi a elevato utilizzo di memoria, Azure HPC offre dimensioni di VM HBv2 e HBv3.

- Usare macchine virtuali HB per applicazioni con larghezza di banda di memoria e macchine virtuali HC per le simulazioni di serbatoi associati al calcolo.

- Usa le VM della serie NV per modellazioni 3D dei giacimenti e la visualizzazione di dati sismici.

- Per l'analisi sismica accelerata della GPU, NCv4 è la soluzione consigliata. Per un'elaborazione RTM più intensa dei dati, lo SKU NDv4 è l'opzione migliore grazie alla disponibilità di unità NVMe con una capacità cumulativa di 7 TB. Per ottenere prestazioni ottimali nelle macchine virtuali serie HB con carichi di lavoro MPI, eseguire l'aggiunta ottimale dei processi ai core dei processori. Per altre informazioni, vedere il post di blog Relativo al posizionamento ottimale dei processi MPI per le macchine virtuali della serie HB di Azure. Vengono inoltre forniti strumenti dedicati per garantire l'aggiunta corretta dei processi di applicazione paralleli, come descritto qui.

- A causa dell'architettura complessa delle macchine virtuali serie NDv4, prestare particolare attenzione durante la configurazione delle macchine virtuali per garantire l'avvio ottimale delle applicazioni con accelerazione GPU. Per altre informazioni sul calcolo ad alte prestazioni di Azure, vedere il post di blog della macchina virtuale GPU scalabile di Azure.

Architettura di riferimento HPC

Di seguito sono riportate le architetture di riferimento e del caso d'uso per gli ambienti HPC per l'energia.

Casi d'uso dell'architettura di riferimento per la simulazione di petrolio e gas e gas

In genere, sia i flussi di lavoro del serbatoio che i flussi di lavoro sismici hanno requisiti simili per la pianificazione dei processi e di calcolo. Tuttavia, i carichi di lavoro sismici sfidano l'infrastruttura nell'archiviazione con requisiti di archiviazione e velocità effettiva potenzialmente multi-PB che potrebbero essere misurati in centinaia di GB. Ad esempio, un singolo progetto di elaborazione sismica potrebbe iniziare con 500 TB di dati non elaborati, che richiede potenzialmente diversi PB di archiviazione a lungo termine. Di seguito sono riportate alcune architetture di riferimento attualmente disponibili che consentono di soddisfare correttamente gli obiettivi per l'esecuzione dell'applicazione in Azure.

Caso d'uso e architettura di riferimento per l'elaborazione sismica

L'elaborazione sismica e l'imaging sono fondamentali per l'attività petrolifera e del gas perché creano un modello della sottossurface dai dati di esplorazione. Il processo di qualificazione e quantificare ciò che potrebbe trovarsi nella sottossurface è in genere condotto da geoscientisti. I geoscientisti usano software che è spesso associato al data center e al cloud. Occasionalmente accedono al software usando la tecnologia desktop virtuale in remoto o nel cloud.

La qualità del modello subsurface e la qualità e la risoluzione dei dati è fondamentale per prendere le giuste decisioni aziendali riguardanti l'offerta sui lease o decidere dove eseguire il drill-through. Le immagini di interpretazione dell'immagine sismica possono migliorare la posizione dei pozzi e ridurre il rischio di forare un "foro secco". Per le aziende petrolifere e del gas, avere una migliore comprensione delle strutture subsurface si traduce direttamente nella riduzione del rischio di esplorazione. Fondamentalmente, più alto è l'accuratezza della visione dell'azienda dell'area geologica, migliore è la sua probabilità di colpire l'olio quando esegue il drill-down.

Questo processo è a elevato utilizzo di dati e calcolo. L'azienda deve elaborare terabyte di dati, richiedendo una potenza di calcolo elevata e veloce, che include una rete veloce. A causa della natura a elevato utilizzo di dati e calcolo dell'imaging sismico, le aziende usano il calcolo parallelo per elaborare i dati e ridurre il tempo di compilazione e completamento. Le aziende elaborano senza sosta grandi volumi di dati sull'acquisizione sismica per individuare, quantificare accuratamente e qualificare il contenuto di idrocarburo nei serbatoi individuati nel sottosuolo prima dell'inizio delle operazioni di recupero. Poiché i dati di acquisizione non sono strutturati e possono raggiungere facilmente i livelli di petabyte per un potenziale campo petrolifero e di gas, l'attività di elaborazione sismica può essere completata solo entro una scala temporale significativa usando HPC e strategie di gestione dei dati appropriate.

Architettura dei casi d'uso e di riferimento per la simulazione e la modellazione dei serbatoi

La modellazione del serbatoio inserisce anche valori sulle caratteristiche fisiche del sottosurface, come la saturazione dell'acqua, la logicità e l'integrità. Questi dati sono importanti per determinare il tipo di approccio di ripristino e le apparecchiature da distribuire e, in ultima analisi, dove posizionare meglio i pozzi.

Un carico di lavoro di modellazione del serbatoio è anche un'area di progettazione del serbatoio. Il carico di lavoro combina fisica, matematica e programmazione informatica in un modello di serbatoio per analizzare e stimare il comportamento fluido nel serbatoio nel tempo. Questa analisi richiede una potenza di calcolo elevata e in genere richiede un carico di lavoro di calcolo di grandi dimensioni, inclusa la rete veloce.

Per altre informazioni sull'architettura di riferimento o sui cookbook per le applicazioni ISV HPC pertinenti che supportano HPC per i casi d'uso dell'energia, vedere:

- Azure HPC certification.github.io

- Piattaforma Microsoft Azure HPC OnDemand. L'architettura di riferimento autonoma potrebbe non essere conforme al paradigma ALZ.

Passaggi successivi

Gli articoli seguenti forniscono indicazioni su ogni passaggio del percorso di adozione del cloud per gli ambienti HPC energetici.

- Fatturazione di Azure e tenant di Microsoft Entra per HPC per l'energia

- Gestione delle identità e degli accessi per Azure HPC in energia

- Gestione per Azure HPC in energia

- Topologia di rete e connettività per Azure HPC in energia

- Automazione della piattaforma e DevOps per Azure HPC in energia

- Organizzazione delle risorse per HPC nel settore energetico

- Governance per HPC nei settori energetici

- Sicurezza per Azure HPC in energia

- Archiviazione per ambienti di energia HPC

- Acceleratore di zona di destinazione HPC (High Performance Computing) di Azure

Commenti e suggerimenti

Presto disponibile: Nel corso del 2024 verranno gradualmente disattivati i problemi di GitHub come meccanismo di feedback per il contenuto e ciò verrà sostituito con un nuovo sistema di feedback. Per altre informazioni, vedere https://aka.ms/ContentUserFeedback.

Invia e visualizza il feedback per