Testare l'accuratezza di un modello di riconoscimento vocale personalizzato

In questo articolo si apprenderà come misurare in modo quantitativo e migliorare l'accuratezza della voce di base nel modello di testo o nei propri modelli personalizzati. I dati di trascrizione audio e con etichetta umana sono necessari per testare l'accuratezza. Devi fornire da 30 minuti a 5 ore di audio rappresentativo.

Importante

Durante il test, il sistema eseguirà una trascrizione. Questo aspetto è importante da tenere presente, in quanto i prezzi variano in base all'offerta di servizio e al livello di sottoscrizione. Per i dettagli più recenti, vedere sempre i prezzi ufficiali dei servizi di intelligenza artificiale di Azure.

Creazione di un test

È possibile testare l'accuratezza del modello personalizzato creando un test. Un test richiede una raccolta di file audio e le trascrizioni corrispondenti. È possibile confrontare l'accuratezza di un modello personalizzato con un modello di base di riconoscimento vocale o un altro modello personalizzato. Dopo aver restituito i risultati del test, valutare la percentuale di errori delle parole (WER) rispetto ai risultati del riconoscimento vocale.

Per creare un test, seguire questa procedura:

Accedere a Speech Studio.

Selezionare Riconoscimento vocale> personalizzato Il nome >del progetto Modelli di test.

Selezionare Crea nuovo test.

Selezionare Valuta accuratezza>Avanti.

Selezionare un set di dati di trascrizione con etichetta umana e audio e quindi selezionare Avanti. Se non sono disponibili set di dati, annullare la configurazione e quindi passare al menu Set di dati voce per caricare i set di dati.

Nota

È importante selezionare un set di dati acustico diverso da quello usato con il modello. Questo approccio può offrire un senso più realistico delle prestazioni del modello.

Selezionare fino a due modelli da valutare e quindi selezionare Avanti.

Immettere il nome e la descrizione del test e quindi selezionare Avanti.

Esaminare i dettagli del test e quindi selezionare Salva e chiudi.

Per creare un test, usare il spx csr evaluation create comando . Creare i parametri della richiesta in base alle istruzioni seguenti:

- Impostare il

projectparametro sull'ID di un progetto esistente. Questo parametro è consigliato in modo da poter anche visualizzare il test in Speech Studio. È possibile eseguire ilspx csr project listcomando per ottenere i progetti disponibili. - Impostare il parametro obbligatorio

model1sull'ID di un modello da testare. - Impostare il parametro obbligatorio

model2sull'ID di un altro modello da testare. Se non si vogliono confrontare due modelli, usare lo stesso modello per emodel1model2. - Impostare il parametro obbligatorio

datasetsull'ID di un set di dati da usare per il test. - Impostare il

languageparametro; in caso contrario, l'interfaccia della riga di comando di Voce imposta "en-US" per impostazione predefinita. Questo parametro deve corrispondere alle impostazioni locali del contenuto del set di dati. Le impostazioni locali non possono essere modificate in un secondo momento. Il parametro dell'interfaccia dellalocaleriga di comandolanguagedi Voce corrisponde alla proprietà nella richiesta e nella risposta JSON. - Impostare il parametro obbligatorio

name. Questo parametro è il nome visualizzato in Speech Studio. Il parametro dell'interfaccia delladisplayNameriga di comandonamedi Voce corrisponde alla proprietà nella richiesta e nella risposta JSON.

Ecco un esempio di comando dell'interfaccia della riga di comando di Voce che crea un test:

spx csr evaluation create --api-version v3.1 --project 9f8c4cbb-f9a5-4ec1-8bb0-53cfa9221226 --dataset be378d9d-a9d7-4d4a-820a-e0432e8678c7 --model1 ff43e922-e3e6-4bf0-8473-55c08fd68048 --model2 1aae1070-7972-47e9-a977-87e3b05c457d --name "My Evaluation" --description "My Evaluation Description"

Dovrebbe essere visualizzato un corpo della risposta nel formato seguente:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca",

"model1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/ff43e922-e3e6-4bf0-8473-55c08fd68048"

},

"model2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/1aae1070-7972-47e9-a977-87e3b05c457d"

},

"dataset": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/datasets/be378d9d-a9d7-4d4a-820a-e0432e8678c7"

},

"transcription2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/6eaf6a15-6076-466a-83d4-a30dba78ca63"

},

"transcription1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/0c5b1630-fadf-444d-827f-d6da9c0cf0c3"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/9f8c4cbb-f9a5-4ec1-8bb0-53cfa9221226"

},

"links": {

"files": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca/files"

},

"properties": {

"wordErrorRate2": -1.0,

"wordErrorRate1": -1.0,

"sentenceErrorRate2": -1.0,

"sentenceCount2": -1,

"wordCount2": -1,

"correctWordCount2": -1,

"wordSubstitutionCount2": -1,

"wordDeletionCount2": -1,

"wordInsertionCount2": -1,

"sentenceErrorRate1": -1.0,

"sentenceCount1": -1,

"wordCount1": -1,

"correctWordCount1": -1,

"wordSubstitutionCount1": -1,

"wordDeletionCount1": -1,

"wordInsertionCount1": -1

},

"lastActionDateTime": "2022-05-20T16:42:43Z",

"status": "NotStarted",

"createdDateTime": "2022-05-20T16:42:43Z",

"locale": "en-US",

"displayName": "My Evaluation",

"description": "My Evaluation Description"

}

La proprietà di primo livello self nel corpo della risposta è l'URI della valutazione. Usare questo URI per ottenere informazioni dettagliate sul progetto e sui risultati dei test. È anche possibile usare questo URI per aggiornare o eliminare la valutazione.

Per informazioni sull'interfaccia della riga di comando di Voce con le valutazioni, eseguire il comando seguente:

spx help csr evaluation

Per creare un test, usare l'operazione Evaluations_Create dell'API REST Riconoscimento vocale. Costruire il corpo della richiesta in base alle istruzioni seguenti:

- Impostare la

projectproprietà sull'URI di un progetto esistente. Questa proprietà è consigliata in modo da poter anche visualizzare il test in Speech Studio. È possibile effettuare una richiesta di Projects_List per ottenere i progetti disponibili. - Impostare la

testingKindproprietà suEvaluationall'internocustomPropertiesdi . Se non si specificaEvaluation, il test viene considerato come test di ispezione della qualità. Indipendentemente dal fatto che latestingKindproprietà sia impostata su oInspectiono non sia impostataEvaluation, è possibile accedere ai punteggi di accuratezza tramite l'API, ma non in Speech Studio. - Impostare la proprietà obbligatoria

model1sull'URI di un modello da testare. - Impostare la proprietà obbligatoria

model2sull'URI di un altro modello da testare. Se non si vogliono confrontare due modelli, usare lo stesso modello per emodel1model2. - Impostare la proprietà obbligatoria

datasetsull'URI di un set di dati da usare per il test. - Impostare la proprietà obbligatoria

locale. Questa proprietà deve essere le impostazioni locali del contenuto del set di dati. Le impostazioni locali non possono essere modificate in un secondo momento. - Impostare la proprietà obbligatoria

displayName. Questa proprietà è il nome visualizzato in Speech Studio.

Effettuare una richiesta HTTP POST usando l'URI, come illustrato nell'esempio seguente. Sostituire YourSubscriptionKey con la chiave della risorsa Voce, sostituire YourServiceRegion con l'area della risorsa Voce e impostare le proprietà del corpo della richiesta come descritto in precedenza.

curl -v -X POST -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey" -H "Content-Type: application/json" -d '{

"model1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/ff43e922-e3e6-4bf0-8473-55c08fd68048"

},

"model2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/1aae1070-7972-47e9-a977-87e3b05c457d"

},

"dataset": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/datasets/be378d9d-a9d7-4d4a-820a-e0432e8678c7"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/9f8c4cbb-f9a5-4ec1-8bb0-53cfa9221226"

},

"displayName": "My Evaluation",

"description": "My Evaluation Description",

"customProperties": {

"testingKind": "Evaluation"

},

"locale": "en-US"

}' "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations"

Dovrebbe essere visualizzato un corpo della risposta nel formato seguente:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca",

"model1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/ff43e922-e3e6-4bf0-8473-55c08fd68048"

},

"model2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/1aae1070-7972-47e9-a977-87e3b05c457d"

},

"dataset": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/datasets/be378d9d-a9d7-4d4a-820a-e0432e8678c7"

},

"transcription2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/6eaf6a15-6076-466a-83d4-a30dba78ca63"

},

"transcription1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/0c5b1630-fadf-444d-827f-d6da9c0cf0c3"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/9f8c4cbb-f9a5-4ec1-8bb0-53cfa9221226"

},

"links": {

"files": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca/files"

},

"properties": {

"wordErrorRate2": -1.0,

"wordErrorRate1": -1.0,

"sentenceErrorRate2": -1.0,

"sentenceCount2": -1,

"wordCount2": -1,

"correctWordCount2": -1,

"wordSubstitutionCount2": -1,

"wordDeletionCount2": -1,

"wordInsertionCount2": -1,

"sentenceErrorRate1": -1.0,

"sentenceCount1": -1,

"wordCount1": -1,

"correctWordCount1": -1,

"wordSubstitutionCount1": -1,

"wordDeletionCount1": -1,

"wordInsertionCount1": -1

},

"lastActionDateTime": "2022-05-20T16:42:43Z",

"status": "NotStarted",

"createdDateTime": "2022-05-20T16:42:43Z",

"locale": "en-US",

"displayName": "My Evaluation",

"description": "My Evaluation Description",

"customProperties": {

"testingKind": "Evaluation"

}

}

La proprietà di primo livello self nel corpo della risposta è l'URI della valutazione. Usare questo URI per ottenere informazioni dettagliate sul progetto e sui risultati del test della valutazione. È anche possibile usare questo URI per aggiornare o eliminare la valutazione.

Ottenere i risultati dei test

È necessario ottenere i risultati del test e valutare la percentuale di errori delle parole (WER) rispetto ai risultati del riconoscimento vocale.

Per ottenere i risultati dei test, seguire questa procedura:

- Accedere a Speech Studio.

- Selezionare Riconoscimento vocale> personalizzato Il nome >del progetto Modelli di test.

- Selezionare il collegamento in base al nome del test.

- Al termine del test, come indicato dallo stato impostato su Succeeded, verranno visualizzati i risultati che includono il numero WER per ogni modello testato.

Questa pagina elenca tutte le espressioni nel set di dati e i risultati del riconoscimento, insieme alla trascrizione dal set di dati inviato. È possibile attivare o disattivare vari tipi di errore, tra cui inserimento, eliminazione e sostituzione. Ascoltando l'audio e confrontando i risultati di riconoscimento in ogni colonna, è possibile decidere quale modello soddisfa le proprie esigenze e determinare dove sono necessari più training e miglioramenti.

Per ottenere i risultati dei test, usare il spx csr evaluation status comando . Creare i parametri della richiesta in base alle istruzioni seguenti:

- Impostare il parametro obbligatorio

evaluationsull'ID della valutazione che si desidera ottenere i risultati del test.

Ecco un esempio di comando dell'interfaccia della riga di comando di Voce che ottiene i risultati del test:

spx csr evaluation status --api-version v3.1 --evaluation 8bfe6b05-f093-4ab4-be7d-180374b751ca

La parola error rate e altri dettagli vengono restituiti nel corpo della risposta.

Dovrebbe essere visualizzato un corpo della risposta nel formato seguente:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca",

"model1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/ff43e922-e3e6-4bf0-8473-55c08fd68048"

},

"model2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/1aae1070-7972-47e9-a977-87e3b05c457d"

},

"dataset": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/datasets/be378d9d-a9d7-4d4a-820a-e0432e8678c7"

},

"transcription2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/6eaf6a15-6076-466a-83d4-a30dba78ca63"

},

"transcription1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/0c5b1630-fadf-444d-827f-d6da9c0cf0c3"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/9f8c4cbb-f9a5-4ec1-8bb0-53cfa9221226"

},

"links": {

"files": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca/files"

},

"properties": {

"wordErrorRate2": 4.62,

"wordErrorRate1": 4.6,

"sentenceErrorRate2": 66.7,

"sentenceCount2": 3,

"wordCount2": 173,

"correctWordCount2": 166,

"wordSubstitutionCount2": 7,

"wordDeletionCount2": 0,

"wordInsertionCount2": 1,

"sentenceErrorRate1": 66.7,

"sentenceCount1": 3,

"wordCount1": 174,

"correctWordCount1": 166,

"wordSubstitutionCount1": 7,

"wordDeletionCount1": 1,

"wordInsertionCount1": 0

},

"lastActionDateTime": "2022-05-20T16:42:56Z",

"status": "Succeeded",

"createdDateTime": "2022-05-20T16:42:43Z",

"locale": "en-US",

"displayName": "My Evaluation",

"description": "My Evaluation Description",

"customProperties": {

"testingKind": "Evaluation"

}

}

Per informazioni sull'interfaccia della riga di comando di Voce con le valutazioni, eseguire il comando seguente:

spx help csr evaluation

Per ottenere i risultati dei test, iniziare usando l'operazione Evaluations_Get dell'API REST Riconoscimento vocale in testo.

Effettuare una richiesta HTTP GET usando l'URI, come illustrato nell'esempio seguente. Sostituire YourEvaluationId con l'ID di valutazione, sostituire YourSubscriptionKey con la chiave della risorsa Voce e sostituire YourServiceRegion con l'area della risorsa Voce.

curl -v -X GET "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/YourEvaluationId" -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey"

La parola error rate e altri dettagli vengono restituiti nel corpo della risposta.

Dovrebbe essere visualizzato un corpo della risposta nel formato seguente:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca",

"model1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/ff43e922-e3e6-4bf0-8473-55c08fd68048"

},

"model2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/models/base/1aae1070-7972-47e9-a977-87e3b05c457d"

},

"dataset": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/datasets/be378d9d-a9d7-4d4a-820a-e0432e8678c7"

},

"transcription2": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/6eaf6a15-6076-466a-83d4-a30dba78ca63"

},

"transcription1": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/transcriptions/0c5b1630-fadf-444d-827f-d6da9c0cf0c3"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/projects/9f8c4cbb-f9a5-4ec1-8bb0-53cfa9221226"

},

"links": {

"files": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.1/evaluations/8bfe6b05-f093-4ab4-be7d-180374b751ca/files"

},

"properties": {

"wordErrorRate2": 4.62,

"wordErrorRate1": 4.6,

"sentenceErrorRate2": 66.7,

"sentenceCount2": 3,

"wordCount2": 173,

"correctWordCount2": 166,

"wordSubstitutionCount2": 7,

"wordDeletionCount2": 0,

"wordInsertionCount2": 1,

"sentenceErrorRate1": 66.7,

"sentenceCount1": 3,

"wordCount1": 174,

"correctWordCount1": 166,

"wordSubstitutionCount1": 7,

"wordDeletionCount1": 1,

"wordInsertionCount1": 0

},

"lastActionDateTime": "2022-05-20T16:42:56Z",

"status": "Succeeded",

"createdDateTime": "2022-05-20T16:42:43Z",

"locale": "en-US",

"displayName": "My Evaluation",

"description": "My Evaluation Description",

"customProperties": {

"testingKind": "Evaluation"

}

}

Valutare la frequenza degli errori delle parole (WER)

Lo standard di settore per misurare l'accuratezza del modello è la percentuale di errori delle parole (WER). WeR conta il numero di parole non corrette identificate durante il riconoscimento e divide la somma per il numero totale di parole fornite nella trascrizione con etichetta umana (N).

Le parole identificate in modo errato rientrano in tre categorie:

- Inserimento (I): parole aggiunte erroneamente nella trascrizione dell'ipotesi

- Eliminazione (D): parole non rilevate nella trascrizione dell'ipotesi

- Sostituzione (S): parole sostituite tra riferimento e ipotesi

In Speech Studio il quoziente viene moltiplicato per 100 e visualizzato come percentuale. I risultati dell'interfaccia della riga di comando di Riconoscimento vocale e dell'API REST non vengono moltiplicati per 100.

$$ WER = {{I+D+S} N}\over\times 100 $$

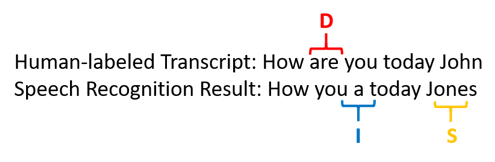

Ecco un esempio che mostra parole identificate in modo non corretto, rispetto alla trascrizione con etichetta umana:

Il risultato del riconoscimento vocale non è corretto nel modo seguente:

- Inserimento (I): Aggiunta della parola "a"

- Eliminazione (D): eliminata la parola "are"

- Sostituzione (S): sostituito la parola "Jones" per "John"

La percentuale di errori delle parole dell'esempio precedente è del 60%.

Se si desidera replicare le misurazioni WER in locale, è possibile usare lo strumento sclite di NIST Scoring Toolkit (SCTK).

Risolvere gli errori e migliorare la risoluzione dei problemi

È possibile usare il calcolo WER dai risultati del riconoscimento automatico per valutare la qualità del modello in uso con l'app, lo strumento o il prodotto. Un WER del 5-10% è considerato di buona qualità ed è pronto per l'uso. Un WER del 20% è accettabile, ma è consigliabile prendere in considerazione un maggior training. Un WER del 30% o più segnala una scarsa qualità e richiede personalizzazione e formazione.

La modalità di distribuzione degli errori è importante. Quando vengono rilevati molti errori di eliminazione, è in genere a causa della potenza debole del segnale audio. Per risolvere questo problema, è necessario raccogliere dati audio più vicini all'origine. Gli errori di inserimento indicano che l'audio è stato registrato in un ambiente rumoroso e il crosstalk potrebbe essere presente, causando problemi di riconoscimento. Gli errori di sostituzione vengono spesso rilevati quando viene fornito un campione insufficiente di termini specifici del dominio come trascrizioni con etichetta umana o testo correlato.

Analizzando singoli file, è possibile determinare il tipo di errori esistenti e quali errori sono univoci per un file specifico. La comprensione dei problemi a livello di file consente di raggiungere i miglioramenti.

Valutare la frequenza degli errori dei token (TER)

Oltre alla frequenza degli errori delle parole, è anche possibile usare la misurazione estesa della frequenza degli errori del token (TER) per valutare la qualità nel formato di visualizzazione end-to-end finale finale. Oltre al formato lessicale (That will cost $900. invece di that will cost nine hundred dollars), TER tiene conto degli aspetti del formato di visualizzazione, ad esempio punteggiatura, maiuscola e ITN. Altre informazioni su Visualizzare la formattazione dell'output con il riconoscimento vocale.

TER conta il numero di token non corretti identificati durante il riconoscimento e divide la somma per il numero totale di token forniti nella trascrizione con etichetta umana (N).

$$ TER = {{I+D+S}\over N} \times 100 $$

Anche la formula del calcolo TER è simile a WER. L'unica differenza è che IL TER viene calcolato in base al livello del token anziché al livello di parola.

- Inserimento (I): token aggiunti erroneamente nella trascrizione dell'ipotesi

- Eliminazione (D): token non rilevati nella trascrizione dell'ipotesi

- Sostituzione (S): token sostituiti tra riferimento e ipotesi

In un caso reale, è possibile analizzare sia i risultati di WER che TER per ottenere i miglioramenti desiderati.

Nota

Per misurare TER, è necessario assicurarsi che i dati di test audio e trascrizione includano trascrizioni con formattazione visualizzata, ad esempio punteggiatura, maiuscola e ITN.

Risultati dello scenario di esempio

Gli scenari di riconoscimento vocale variano in base alla qualità audio e alla lingua (vocabolario e stile di pronuncia). La tabella seguente esamina quattro scenari comuni:

| Scenario | Qualità audio | Vocabolario | Modo di parlare |

|---|---|---|---|

| Call center | Basso, 8 kHz, potrebbe essere due persone su un canale audio, potrebbe essere compresso | Narrow, unique to domain and products | Conversazionale, strutturata in modo libero |

| Assistente vocale, ad esempio Cortana o una finestra drive-through | Alta, 16 kHz | Entity Heavy (titoli, prodotti, località) | Parole e frasi chiaramente dichiarate |

| Dettatura (messaggio istantaneo, note, ricerca) | Alta, 16 kHz | Vario | Prendere nota |

| Video chiuso didascalia | Vari, tra cui vari usi microfoni, musica aggiunta | Varia, dalle riunioni, dal discorso recitato, dai testi musicali | Lettura, preparazione o strutturata in modo libero |

Diversi scenari producono risultati di qualità diversi. Nella tabella seguente viene esaminato il modo in cui il contenuto di questi quattro scenari prevede la frequenza di segnalazione dei dati. La tabella mostra quali tipi di errore sono più comuni in ogni scenario. Le percentuali di errore di inserimento, sostituzione ed eliminazione consentono di determinare il tipo di dati da aggiungere per migliorare il modello.

| Scenario | Qualità del riconoscimento vocale | Errori di inserimento | Errori di eliminazione | Errori di sostituzione |

|---|---|---|---|---|

| Call center | Medio (< 30% WER) |

Basso, tranne quando altre persone parlano in background | Può essere alto. I call center possono essere rumorosi e gli altoparlanti sovrapposti possono confondere il modello | Medio. I nomi di prodotti e persone possono causare questi errori |

| Assistente vocale | Alto (può essere < 10% WER) |

Basso | Basso | Medio, a causa dei titoli delle canzoni, dei nomi dei prodotti o delle località |

| Dettatura | Alto (può essere < 10% WER) |

Basso | Ridotto | Elevato |

| Video chiuso didascalia | Dipende dal tipo di video (può essere < il 50% wer) | Basso | Può essere alta a causa di musica, rumori, qualità del microfono | Il gergo potrebbe causare questi errori |