Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

L’ambiente di calcolo di Azure Databricks fa riferimento alla selezione delle risorse di calcolo disponibili nell'area di lavoro di Azure Databricks. Gli utenti hanno bisogno di accedere all’ambiente calcolo per eseguire carichi di lavoro di ingegneria dei dati, data science e analisi dei dati, ad esempio pipeline ETL di produzione, analisi di flusso, analisi ad hoc e Machine Learning.

Gli utenti possono connettersi a risorse di calcolo esistenti o creare nuove risorse di calcolo se dispongono delle autorizzazioni appropriate.

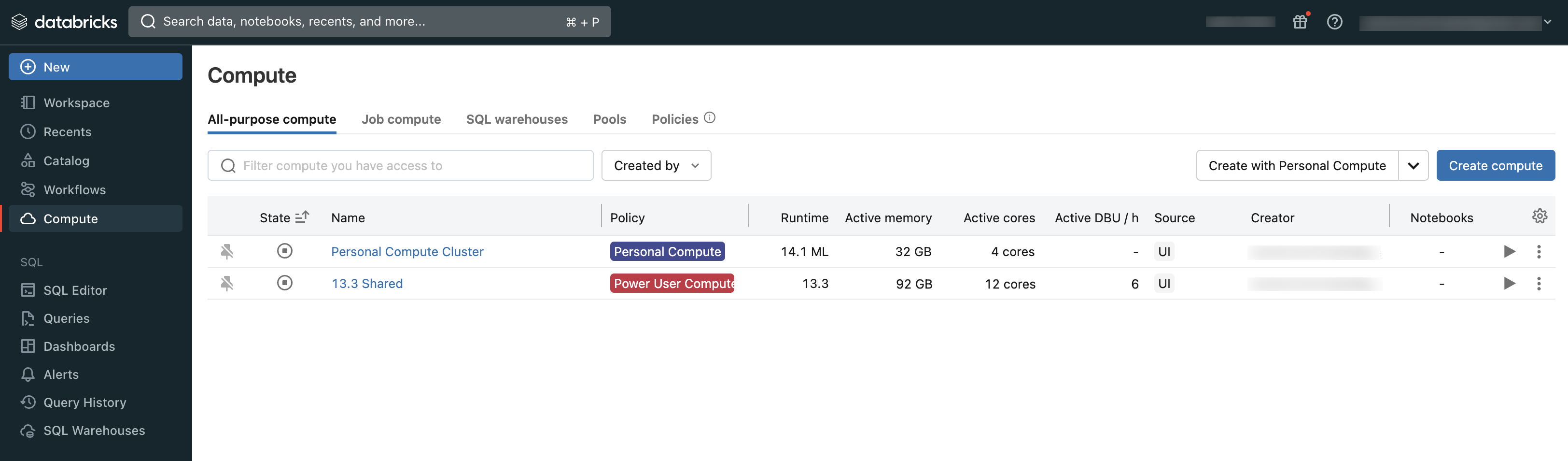

È possibile visualizzare il calcolo a cui si ha accesso usando la sezione Ambiente di Calcolo dell'area di lavoro:

Tipi di calcolo

Questi sono i tipi di ambiente di calcolo disponibili in Azure Databricks:

- Calcolo serverless per notebook: Calcolo scalabile e su richiesta per l'esecuzione di codice SQL e Python nei notebook.

- Calcolo serverless per i processi: calcolo scalabile su richiesta usato per eseguire i processi Lakeflow senza configurare e distribuire l'infrastruttura.

- Elaborazione universale: risorse di calcolo fornite per analizzare i dati nei notebook. È possibile creare, terminare e riavviare questo calcolo usando l'interfaccia utente, l'interfaccia della riga di comando o l'API REST.

- Calcolo per i lavori: calcolo con risorse fornite usato per eseguire lavori automatizzati. L'utilità di pianificazione dei processi di Azure Databricks crea automaticamente un calcolo del processo ogni volta che un processo è configurato per l'esecuzione in un nuovo ambiente di calcolo. L'elaborazione termina quando il lavoro è completato. Non puoi riavviare un processo di calcolo. Vedere Configurare il calcolo per i processi.

- Pool di istanze: computazione con istanze inattive, pronte all'uso, utilizzate per ridurre i tempi di avvio e di autoscaling. È possibile creare questo calcolo usando l'interfaccia utente, l'interfaccia della riga di comando o l'API REST.

- Serverless SQL warehouses: sistemi di calcolo elastico su richiesta utilizzati per eseguire comandi SQL sugli oggetti dati nell'editor SQL o nei notebook interattivi. È possibile creare warehouse SQL usando l'interfaccia utente, l'interfaccia della riga di comando o l'API REST.

- SQL Warehouses classici: utilizzati per eseguire comandi SQL sugli oggetti dati nell'editor SQL o nei notebook interattivi. È possibile creare warehouse SQL usando l'interfaccia utente, l'interfaccia della riga di comando o l'API REST.

Gli articoli di questa sezione descrivono come usare le risorse di calcolo con l'interfaccia utente di Azure Databricks. Per altri metodi, si veda Informazioni sull'interfaccia della riga di comando di Databricks e informazioni di riferimento sull'API REST di Databricks.

Databricks Runtime

Databricks Runtime è il set di componenti di base eseguiti sul tuo sistema di calcolo. Databricks Runtime è un'impostazione configurabile in tutti gli scopi di calcolo dei processi, ma selezionata automaticamente in SQL Warehouse.

Ogni versione di Databricks Runtime include aggiornamenti che migliorano l' utilizzabilità, le prestazioni e la sicurezza dell'analisi dei big data. Databricks Runtime nell'ambiente di calcolo aggiunge molte funzionalità, tra cui:

- Delta Lake, un livello di archiviazione di nuova generazione basato su Apache Spark che fornisce transazioni ACID, layout e indici ottimizzati e miglioramenti del motore di esecuzione per la creazione di pipeline di dati. Vedere Che cos'è Delta Lake in Azure Databricks?.

- Librerie Java, Scala, Python e R installate.

- Ubuntu e le librerie di sistema abbinate.

- Librerie GPU per cluster abilitati all'uso di GPU.

- Servizi di Azure Databricks che si integrano con altri componenti della piattaforma, ad esempio notebook, processi e gestione del cluster.

Per informazioni sul contenuto di ogni versione di runtime, vedere le note sulla versione.

Versione di runtime

Le versioni di Databricks Runtime vengono rilasciate periodicamente:

- Le versioni di supporto a lungo termine sono rappresentate da un qualificatore LTS (ad esempio, 3.5 LTS). Per ogni versione principale, dichiariamo una versione della funzionalità "canonica", per cui forniamo tre anni completi di supporto. Per altre informazioni, si veda Cicli di vita del supporto di Databricks.

- Le versioni principali sono rappresentate da un incremento al numero di versione che precede il separatore decimale (ad esempio il passaggio da 3.5 a 4.0). Vengono rilasciati quando sono presenti modifiche importanti, alcune delle quali potrebbero non essere compatibili con le versioni precedenti.

- Le versioni delle funzionalità sono rappresentate da un incremento del numero di versione che segue il separatore decimale (ad esempio il passaggio da 3.4 a 3.5). Ogni versione principale include più versioni delle funzionalità. Le release di funzionalità sono sempre compatibili con le versioni precedenti all'interno della versione principale.