Che cos'è Databricks Connessione?

Nota

Questo articolo illustra databricks Connessione per Databricks Runtime 13.0 e versioni successive.

Per informazioni sulla versione legacy di Databricks Connessione, vedere Databricks Connessione for Databricks Runtime 12.2 LTS e versioni successive.

- Per ignorare questo articolo e iniziare subito a usare Databricks Connessione per Python, vedere Databricks Connessione per Python.

- Per ignorare questo articolo e iniziare subito a usare databricks Connessione per R, vedere Databricks Connessione per R.

- Per ignorare questo articolo e iniziare subito a usare Databricks Connessione per Scala, vedere Databricks Connessione for Scala.

Panoramica

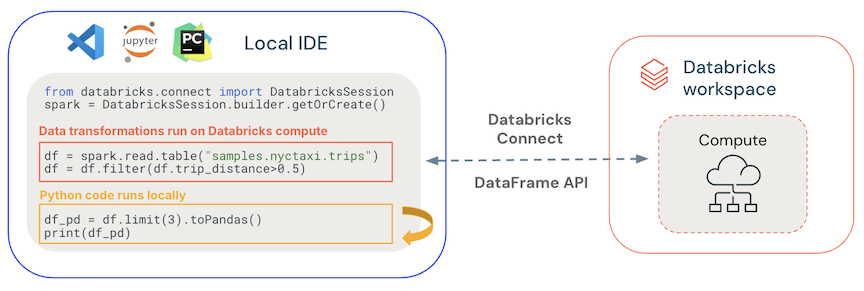

Databricks Connessione consente di connettere gli IDE più diffusi, ad esempio Visual Studio Code, PyCharm, RStudio Desktop, IntelliJ IDEA, server notebook e altre applicazioni personalizzate ai cluster Azure Databricks. Questo articolo illustra il funzionamento di Databricks Connessione.

Databricks Connessione è una libreria client per Databricks Runtime. Consente di scrivere codice usando le API Spark ed eseguirle in remoto in un cluster Azure Databricks anziché nella sessione Spark locale.

Ad esempio, quando si esegue il comando spark.read.format(...).load(...).groupBy(...).agg(...).show() DataFrame usando Databricks Connessione, la rappresentazione logica del comando viene inviata al server Spark in esecuzione in Azure Databricks per l'esecuzione nel cluster remoto.

Con Databricks Connessione, è possibile:

Eseguire codice Spark su larga scala da qualsiasi applicazione Python, R o Scala. Ovunque sia possibile

import pysparkper Python,library(sparklyr)per R oimport org.apache.sparkper Scala, è ora possibile eseguire il codice Spark direttamente dall'applicazione, senza dover installare plug-in IDE o usare script di invio spark.Nota

Databricks Connessione per Databricks Runtime 13.0 e versioni successive supportano l'esecuzione di applicazioni Python. R e Scala sono supportati solo in Databricks Connessione per Databricks Runtime 13.3 LTS e versioni successive.

Eseguire il debug del codice nell'IDE anche quando si usa un cluster remoto.

Scorrere rapidamente quando si sviluppano librerie. Non è necessario riavviare il cluster dopo aver modificato le dipendenze della libreria Python o Scala in Databricks Connessione, perché ogni sessione client è isolata l'una dall'altra nel cluster.

Arrestare i cluster inattive senza perdere il lavoro. Poiché l'applicazione client è disaccoppiata dal cluster, non è interessata dai riavvii o dagli aggiornamenti del cluster, che normalmente causa la perdita di tutte le variabili, rdd e gli oggetti DataFrame definiti in un notebook.

Per Databricks Runtime 13.3 LTS e versioni successive, Databricks Connessione è ora basato su Connessione Spark open source. Spark Connessione introduce un'architettura client-server disaccoppiata per Apache Spark che consente la connettività remota ai cluster Spark usando l'API DataFrame e i piani logici non risolti come protocollo. Con questa architettura "V2" basata su Spark Connessione, Databricks Connessione diventa un thin client semplice e facile da usare. Spark Connessione può essere incorporato ovunque per connettersi ad Azure Databricks: in IDE, notebook e applicazioni, consentendo a singoli utenti e partner di creare nuove esperienze utente (interattive) basate sulla piattaforma Databricks. Per altre informazioni su Spark Connessione, vedere Introduzione a Spark Connessione.

Databricks Connessione determina dove viene eseguito il codice ed esegue il debug, come illustrato nella figura seguente.

Per l'esecuzione del codice: tutto il codice viene eseguito localmente, mentre tutto il codice che coinvolge le operazioni del dataframe viene eseguito nel cluster nell'area di lavoro remota di Azure Databricks e le risposte vengono inviate al chiamante locale.

Per il debug del codice: tutto il codice viene sottoposto a debug in locale, mentre tutto il codice Spark continua a essere eseguito nel cluster nell'area di lavoro remota di Azure Databricks. Il codice principale del motore Spark non può essere sottoposto a debug direttamente dal client.

Passaggi successivi

- Per iniziare a sviluppare soluzioni Connessione Databricks con Python, iniziare con l'esercitazione databricks Connessione per Python.

- Per iniziare a sviluppare soluzioni di databricks Connessione con R, iniziare con l'esercitazione databricks Connessione per R.

- Per iniziare a sviluppare soluzioni di databricks Connessione con Scala, iniziare con l'esercitazione databricks Connessione per Scala.