Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Questo articolo offre una panoramica di Mosaic AI Vector Search, tra cui cosa è e come funziona.

Che cos'è Mosaic AI Vector Search?

Mosaic AI Vector Search è una soluzione di ricerca vettoriale integrata in Databricks Data Intelligence Platform e integrata con i relativi strumenti di governance e produttività. La ricerca vettoriale è un tipo di ricerca ottimizzata per il recupero di incorporamenti. Gli incorporamenti sono rappresentazioni matematiche del contenuto semantico dei dati, in genere dati di testo o immagine. Gli incorporamenti vengono generati da un modello linguistico di grandi dimensioni e sono un componente chiave di molte applicazioni di intelligenza artificiale generative che dipendono dalla ricerca di documenti o immagini simili tra loro. Esempi ne sono i sistemi RAG, i sistemi di raccomandazione e il riconoscimento di immagini e video.

Con Mosaic AI Vector Search si crea un indice di ricerca vettoriale da una tabella Delta. L'indice include dati incorporati con i metadati. È quindi possibile eseguire query sull'indice usando un'API REST per identificare i vettori più simili e restituire i documenti associati. È possibile strutturare l'indice da sincronizzare automaticamente quando viene aggiornata la tabella Delta sottostante.

Mosaic AI Vector Search supporta quanto segue:

- Ricerca ibrida di somiglianza tra parole chiave.

- Filtro.

- Elenchi di controllo di accesso (ACL) per gestire gli endpoint di ricerca vettoriali.

- Sincronizza solo le colonne selezionate.

- Salvare e sincronizzare gli incorporamenti generati.

Come funziona La ricerca vettoriale di Mosaic AI Vector?

Mosaic AI Vector Search usa l'algoritmo HNSW (Hierarchical Navigable Small World) per le ricerche approssimative più vicine e la metrica di distanza L2 per misurare la somiglianza del vettore di incorporamento. Se vuoi utilizzare la similarità coseno, devi normalizzare le tue rappresentazioni dei punti dati prima di inserirle nella ricerca vettoriale. Quando i punti dati vengono normalizzati, la classificazione prodotta dalla distanza L2 corrisponde alla classificazione prodotta dalla somiglianza del coseno.

Mosaic AI Vector Search supporta anche la ricerca ibrida di somiglianza delle parole chiave, che combina la ricerca di incorporamento basata su vettori con tecniche di ricerca tradizionali basate su parole chiave. Questo approccio corrisponde a parole esatte nella query, usando anche una ricerca di somiglianza basata su vettori per acquisire le relazioni semantiche e il contesto della query.

Integrando queste due tecniche, la ricerca ibrida di somiglianza tra parole chiave recupera i documenti che contengono non solo le parole chiave esatte, ma anche quelle concettualmente simili, fornendo risultati di ricerca più completi e pertinenti. Questo metodo è particolarmente utile nelle applicazioni RAG in cui i dati di origine hanno parole chiave univoche, ad esempio SKU o identificatori non adatti alla ricerca di somiglianza pura.

Per informazioni dettagliate sull'API, vedere le informazioni di riferimento sull’SDK Python e Eseguire query su un endpoint di ricerca vettoriale.

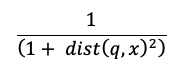

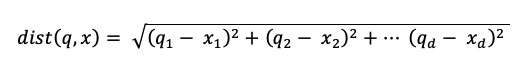

Calcolo della ricerca di somiglianza

Il calcolo della ricerca di somiglianza impiega la formula seguente:

dove dist è la distanza euclidea tra la query q e la voce di indice x:

Algoritmo di ricerca delle parole chiave

I punteggi di rilevanza vengono calcolati usando Okapi BM25. Tutte le colonne di testo o stringa sono oggetto di ricerca, incluse le colonne di testo incorporato e i metadati di origine in formato testo o stringa. La funzione di tokenizzazione divide in corrispondenza dei limiti delle parole, rimuove la punteggiatura e converte tutto il testo in minuscolo.

In che modo vengono combinate la ricerca di somiglianza e la ricerca di parole chiave

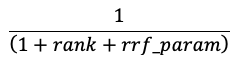

I risultati della ricerca di somiglianza e della ricerca delle parole chiave vengono combinati usando la funzione RRF (Reciprocal Rank Fusion).

L'RRF riassegna a ciascun documento il punteggio di ogni metodo:

Nell'equazione precedente, la classificazione inizia a 0, somma i punteggi per ciascun documento e restituisce i documenti di punteggio più alti.

rrf_param controlla l'importanza relativa dei documenti di priorità superiore e inferiore. Sulla base della letteratura, rrf_param è impostato su 60.

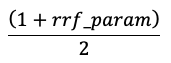

I punteggi vengono normalizzati in modo che il punteggio più alto sia 1 e il punteggio più basso sia 0 usando l'equazione seguente:

Opzioni per fornire incorporamenti vettoriali

Per creare un indice di ricerca vettoriale in Databricks, è prima necessario decidere come fornire incorporamenti vettoriali. Databricks supporta tre opzioni:

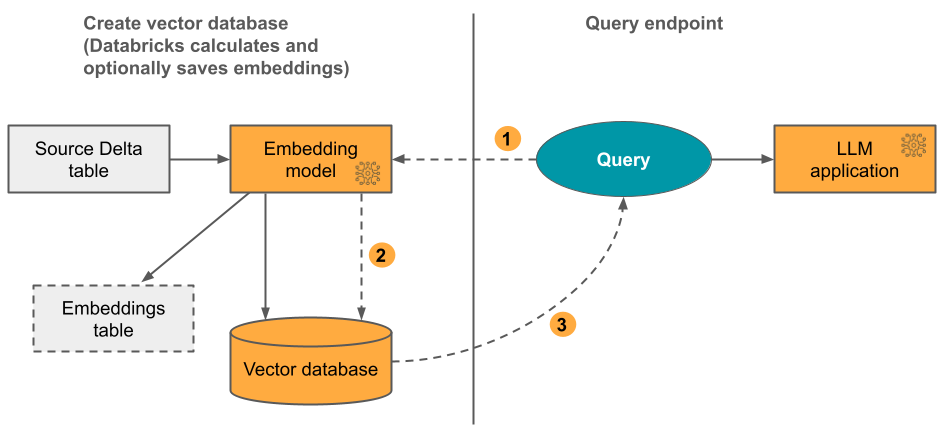

opzione 1: indice di sincronizzazione delta con incorporamenti calcolati da Databricks Viene fornita una tabella Delta di origine che contiene dati in formato testo. Databricks calcola gli incorporamenti, usando un modello specificato e, facoltativamente, salva gli incorporamenti in una tabella in Unity Catalog. Quando la tabella Delta viene aggiornata, l'indice rimane sincronizzato con la tabella Delta.

Il diagramma seguente illustra il processo:

- Calcolare gli embeddings delle query. La query può includere filtri di metadati.

- Eseguire ricerche di somiglianza per identificare i documenti più rilevanti.

- Restituire i documenti più rilevanti e aggiungerli alla query.

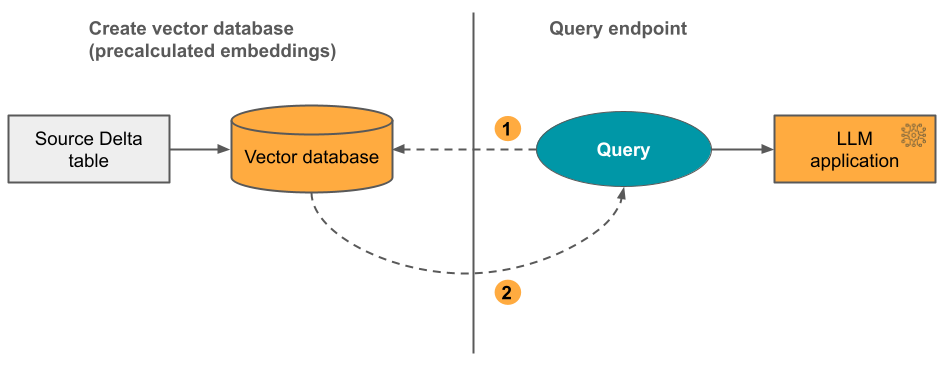

Opzione 2: Indice di sincronizzazione Delta con incorporamenti autogestiti Viene fornita una tabella Delta di origine che contiene incorporamenti precalcolati. Quando la tabella Delta viene aggiornata, l'indice rimane sincronizzato con la tabella Delta.

Il diagramma seguente illustra il processo:

- La query è costituita da incorporamenti e può includere filtri di metadati.

- Eseguire ricerche di somiglianza per identificare i documenti più rilevanti. Restituire i documenti più rilevanti e aggiungerli alla query.

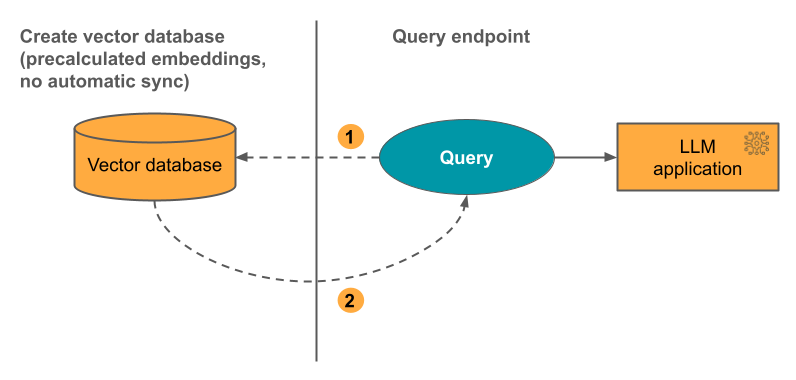

opzione 3: Direct Vector Access Index È necessario aggiornare manualmente l'indice usando l'API REST quando cambia la tabella di incorporamento.

Il diagramma seguente illustra il processo:

Opzioni endpoint

Mosaic AI Vector Search offre le opzioni seguenti per poter selezionare la configurazione dell'endpoint che soddisfi le esigenze dell'applicazione.

Annotazioni

Gli endpoint ottimizzati per l'archiviazione sono disponibili in anteprima pubblica e sono disponibili nelle aree seguenti: eastus, eastus2westus, westus2westeurope.

- Gli endpoint standard hanno una capacità di 320 milioni di vettori alla dimensione 768.

- Gli endpoint ottimizzati per l'archiviazione hanno una capacità maggiore (oltre un miliardo di vettori alla dimensione 768) e offrono indicizzazione 10-20 volte più veloce. Le query sugli endpoint ottimizzati per l'archiviazione hanno una latenza leggermente aumentata di circa 250 msec. I prezzi per questa opzione sono ottimizzati per il maggior numero di vettori. Per informazioni dettagliate sui prezzi, vedere la pagina dei prezzi di ricerca vettoriale. Per informazioni sulla gestione dei costi di ricerca vettoriale, vedere Mosaic AI Vector Search: Guida alla gestione dei costi.

Si specifica il tipo di endpoint quando si crea l'endpoint.

Vedere anche Limitazioni degli endpoint ottimizzati per l'archiviazione.

Come configurare La ricerca vettoriale di Mosaic AI

Per usare Mosaic AI Vector Search, è necessario creare quanto segue:

Un endpoint di ricerca vettoriale. Questo endpoint serve l'indice di ricerca vettoriale. È possibile eseguire query e aggiornare l'endpoint usando l'API REST o l'SDK. Per istruzioni, vedere Creare un endpoint di ricerca vettoriale.

Gli endpoint aumentano automaticamente per supportare le dimensioni dell'indice o il numero di richieste simultanee. Gli endpoint ottimizzati per l'archiviazione vengono ridimensionati automaticamente quando viene eliminato un indice. Gli endpoint standard non vengono ridimensionati automaticamente.

Un indice di ricerca vettoriale. L'indice di ricerca vettoriale viene creato da una tabella Delta ed è ottimizzato per fornire ricerche vicine approssimative in tempo reale. L'obiettivo della ricerca è identificare i documenti simili alla query. Gli indici di ricerca vettoriali vengono visualizzati in e sono regolati da Unity Catalog. Per istruzioni, vedere Creare un indice di ricerca vettoriale.

Inoltre, se si sceglie di usare Databricks per calcolare gli incorporamenti, è possibile usare un endpoint delle API del modello di base preconfigurato o creare un endpoint di servizio del modello per gestire il modello di incorporamento preferito. Per istruzioni, vedere API modello di base con pagamento in base al token o Creare un modello di base che gestisce gli endpoint.

Per eseguire query sull'endpoint di servizio del modello, usare l'API REST o l’SDK Python. La query può definire filtri in base a qualsiasi colonna della tabella Delta. Per informazioni dettagliate, vedere Usare filtri per le query, le Informazioni di riferimento sull'API o le Informazioni di riferimento sull’SDK Python.

Requisiti

- Area di lavoro con Unity Catalog abilitato.

- Calcolo serverless attivato. Per le istruzioni, consulta Connetti al calcolo senza server.

- Per gli endpoint standard, la tabella di origine deve avere il feed di dati delle modifiche abilitato. Consulta Utilizzare il feed di dati delle modifiche di Delta Lake su Azure Databricks.

- Per creare un indice di ricerca vettoriale, è necessario disporre di CREATE TABLE privilegi sullo schema del catalogo in cui verrà creato l'indice.

L'autorizzazione per creare e gestire gli endpoint di ricerca vettoriali viene configurata usando gli elenchi di controllo di accesso. Vedere ACL dell'endpoint di ricerca vettoriale.

protezione e autenticazione dei dati

Databricks implementa i controlli di sicurezza seguenti per proteggere i dati:

- Ogni richiesta del cliente a Mosaic AI Vector Search è isolata, autenticata e autorizzata logicamente.

- Mosaic AI Vector Search crittografa tutti i dati inattivi (AES-256) e in transito (TLS 1.2+).

Mosaic AI Vector Search offre due modalità di autenticazione, principali del servizio e token di accesso personale (PAT). Per le applicazioni di produzione, Databricks consiglia di usare principali di servizio, che possono avere prestazioni per ogni query fino a 100 msec più rapide rispetto ai token di accesso personali.

Token del principal di servizio. Un amministratore può generare un token dell'entità servizio e passarlo all'SDK o all'API. Vedi utilizzare i principali del servizio. Per i casi d'uso di produzione, Databricks consiglia di usare un token del servizio principale.

# Pass in a service principal vsc = VectorSearchClient(workspace_url="...", service_principal_client_id="...", service_principal_client_secret="..." )Token di accesso personale. È possibile usare un token di accesso personale per eseguire l'autenticazione con Mosaic AI Vector Search. Vedere Autenticazione con token di accesso personale. Se si usa l'SDK in un ambiente notebook, l'SDK genera automaticamente un token PAT per l'autenticazione.

# Pass in the PAT token client = VectorSearchClient(workspace_url="...", personal_access_token="...")

Le chiavi gestite dal cliente (CMK) sono supportate sugli endpoint creati a partire dell'8 maggio 2024.

Monitorare l'utilizzo e i costi

La tabella del sistema di utilizzo fatturabile consente di monitorare l'utilizzo e i costi associati agli indici e agli endpoint di ricerca vettoriali. Di seguito è fornito un esempio di query:

WITH all_vector_search_usage (

SELECT *,

CASE WHEN usage_metadata.endpoint_name IS NULL THEN 'ingest'

WHEN usage_type = "STORAGE_SPACE" THEN 'storage'

ELSE 'serving'

END as workload_type

FROM system.billing.usage

WHERE billing_origin_product = 'VECTOR_SEARCH'

),

daily_dbus AS (

SELECT workspace_id,

cloud,

usage_date,

workload_type,

usage_metadata.endpoint_name as vector_search_endpoint,

CASE WHEN workload_type = 'serving' THEN SUM(usage_quantity)

WHEN workload_type = 'ingest' THEN SUM(usage_quantity)

ELSE null

END as dbus,

CASE WHEN workload_type = 'storage' THEN SUM(usage_quantity)

ELSE null

END as dsus

FROM all_vector_search_usage

GROUP BY all

ORDER BY 1,2,3,4,5 DESC

)

SELECT * FROM daily_dbus

È possibile anche interrogare l'uso in base alla politica di bilancio. Vedi Mosaic AI Vector Search: Politiche di bilancio.

Per dettagli sul contenuto della tabella di utilizzo della fatturazione, vedere Riferimento alla tabella di sistema per l'utilizzo fatturabile. Nel Notebook di esempio seguente, sono disponibili query aggiuntive.

Taccuino delle query delle tabelle del sistema di ricerca vettoriale

Limiti relativi alle dimensioni delle risorse e dei dati

La tabella seguente riepiloga i limiti delle dimensioni delle risorse e dei dati per gli endpoint e gli indici di ricerca vettoriali:

| Conto risorse | Granularità | Limite |

|---|---|---|

| Endpoint di ricerca vettoriale | Per area di lavoro | 100 |

| Integrazioni | Per terminale | ~ 320.000.000 alla dimensione di incorporamento 768 ~ 160.000.000 alla dimensione di incorporamento 1536 ~ 80.000.000 alla dimensione di incorporamento 3072 (scala approssimativamente lineare) |

| Dimensione di incorporazione | Per indice | 4096 |

| Indici | Per terminale | 50 |

| Colonne | Per indice | 50 |

| Colonne | Tipi supportati: Byte, Short, Integer, Long, Float, Double, Boolean, String, Timestamp, Date | |

| Campi dei metadati | Per indice | 50 |

| Nome dell'indice | Per indice | 128 caratteri |

I limiti seguenti si applicano alla creazione e all'aggiornamento degli indici di ricerca vettoriale:

| Conto risorse | Granularità | Limite |

|---|---|---|

| Dimensioni delle righe per l'indice di sincronizzazione delta | Per indice | 100 KB |

| Integrazione delle dimensioni delle colonne di origine per l'indice Delta Sync | Per Indice | 32764 byte |

| Limite delle dimensioni delle richieste di upsert in blocco per l'indice Direct Vector | Per Indice | 10 MB |

| Limite di dimensione per le richieste di eliminazione in blocco per l'indice Direct Vector | Per Indice | 10 MB |

I limiti seguenti si applicano all'API della query.

| Conto risorse | Granularità | Limite |

|---|---|---|

| Lunghezza del testo della query | Per richiesta | 32764 byte |

| Numero massimo di risultati restituiti (ricerca del vicino più prossimo approssimativa) | Per richiesta | 10.000 |

| Numero massimo di risultati restituiti (ricerca ibrida di somiglianza con parole chiave) | Per richiesta | 200 |

Limitazioni

- Il nome

_iddella colonna è riservato. Se la tabella di origine contiene una colonna denominata_id, rinominarla prima di creare un indice di ricerca vettoriale. - Le autorizzazioni a livello di riga e colonna non sono supportate. Tuttavia, è possibile implementare elenchi di controllo di accesso a livello di applicazione personalizzati usando l'API di filtro.

Limitazioni degli endpoint ottimizzati per l'archiviazione

Le limitazioni in questa sezione si applicano solo agli endpoint ottimizzati per l'archiviazione. Gli endpoint ottimizzati per l'archiviazione sono disponibili in anteprima pubblica.

- La modalità di sincronizzazione continua non è supportata.

- La sincronizzazione delle colonne non è supportata.

- La dimensione di incorporamento deve essere divisibile per 16.

- L'aggiornamento incrementale non è supportato. Ogni sincronizzazione ricompila completamente l'indice di ricerca vettoriale.

- Dovresti prevedere una riduzione complessiva significativa del tempo necessario per una sincronizzazione rispetto agli endpoint standard. I set di dati con 1 miliardo di incorporamenti devono completare una sincronizzazione in meno di 8 ore. I set di dati più piccoli richiedono meno tempo per la sincronizzazione.

- Le aree di lavoro conformi a HIPAA, PCI e FedRAMP non sono supportate.

- Le chiavi gestite dal cliente non sono supportate.

- Gli endpoint ottimizzati per l'archiviazione supportano fino a 1 miliardo di incorporamenti di vettori di 768 dimensioni. Se hai un caso d'uso su larga scala, contatta il tuo team di account.