Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Importante

La scalabilità automatica di Lakebase si trova in Beta nelle aree seguenti: eastus2, westeurope, westus.

Lakebase Autoscaling è la versione più recente di Lakebase con calcolo autoscalante, riduzione a zero, ramificazione e ripristino istantaneo. Per il confronto delle funzionalità con Lakebase Provisioned, vedere scegliere tra le versioni.

Iniziare a usare Lakebase Postgres in pochi minuti. Creare il primo progetto, connettersi al database ed esplorare le funzionalità principali, tra cui l'integrazione del catalogo Unity.

Creare il primo progetto

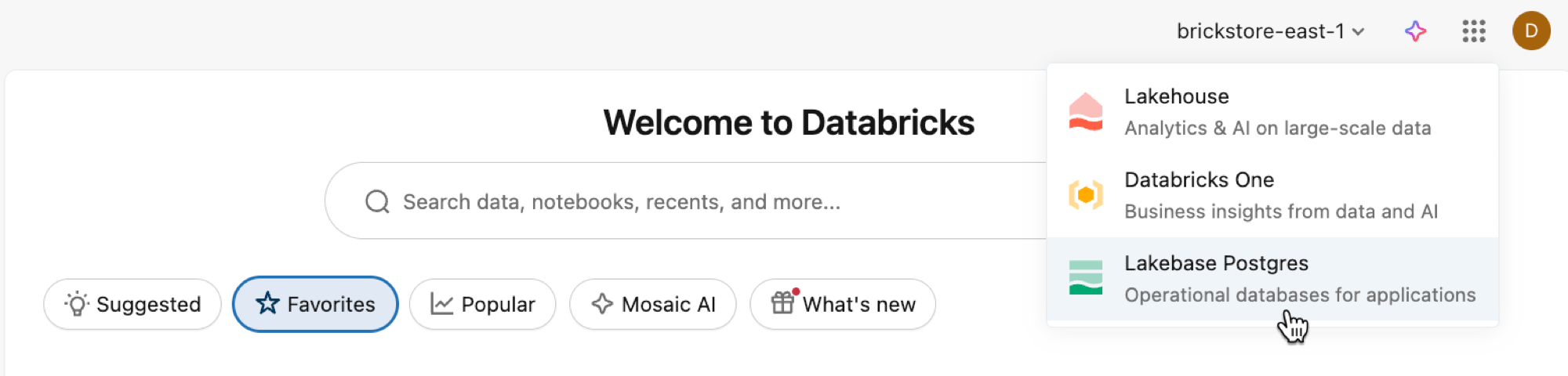

Aprire l'app Lakebase dal commutatore delle app.

Selezionare Scalabilità automatica per accedere all'interfaccia utente di scalabilità automatica di Lakebase.

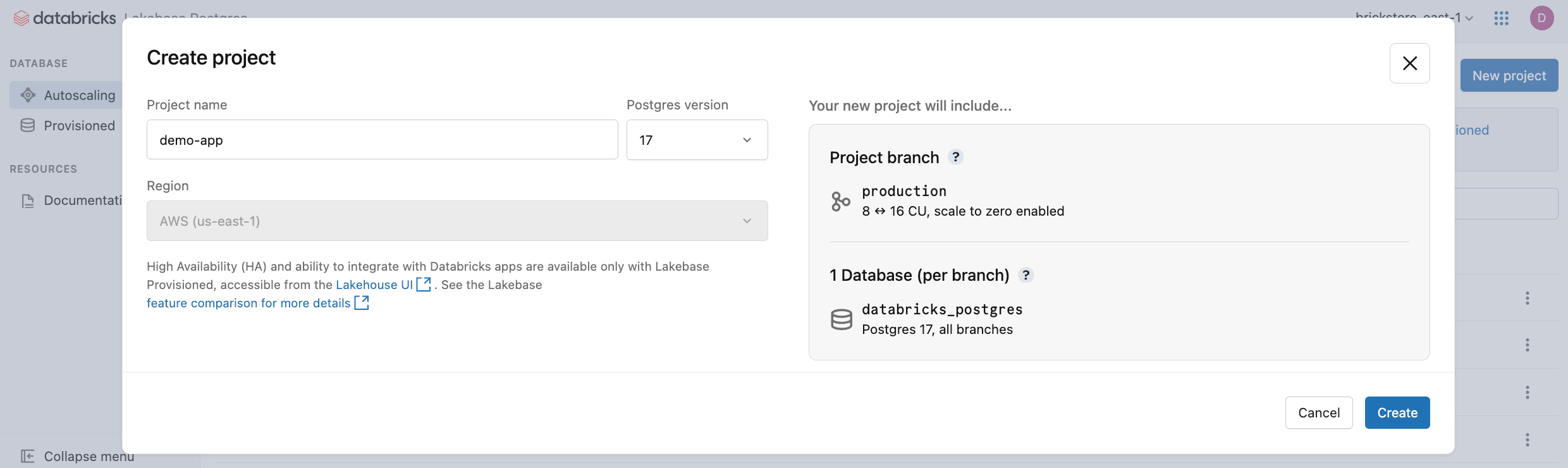

Fare clic su Nuovo progetto. Assegnare un nome al progetto e selezionare la versione di Postgres. Il progetto viene creato con un singolo production ramo, un database predefinito databricks_postgres e risorse di calcolo configurate per il ramo.

Potrebbe essere necessario attendere alcuni momenti per l'attivazione del computer. Il calcolo per il production ramo è sempre attivo per impostazione predefinita (la scalabilità a zero è disabilitata), ma è possibile configurare questa impostazione, se necessario.

La regione per il tuo progetto viene impostata automaticamente sulla regione della tua area di lavoro. Per le opzioni di configurazione dettagliate, vedere Creare un progetto.

Connettersi al database

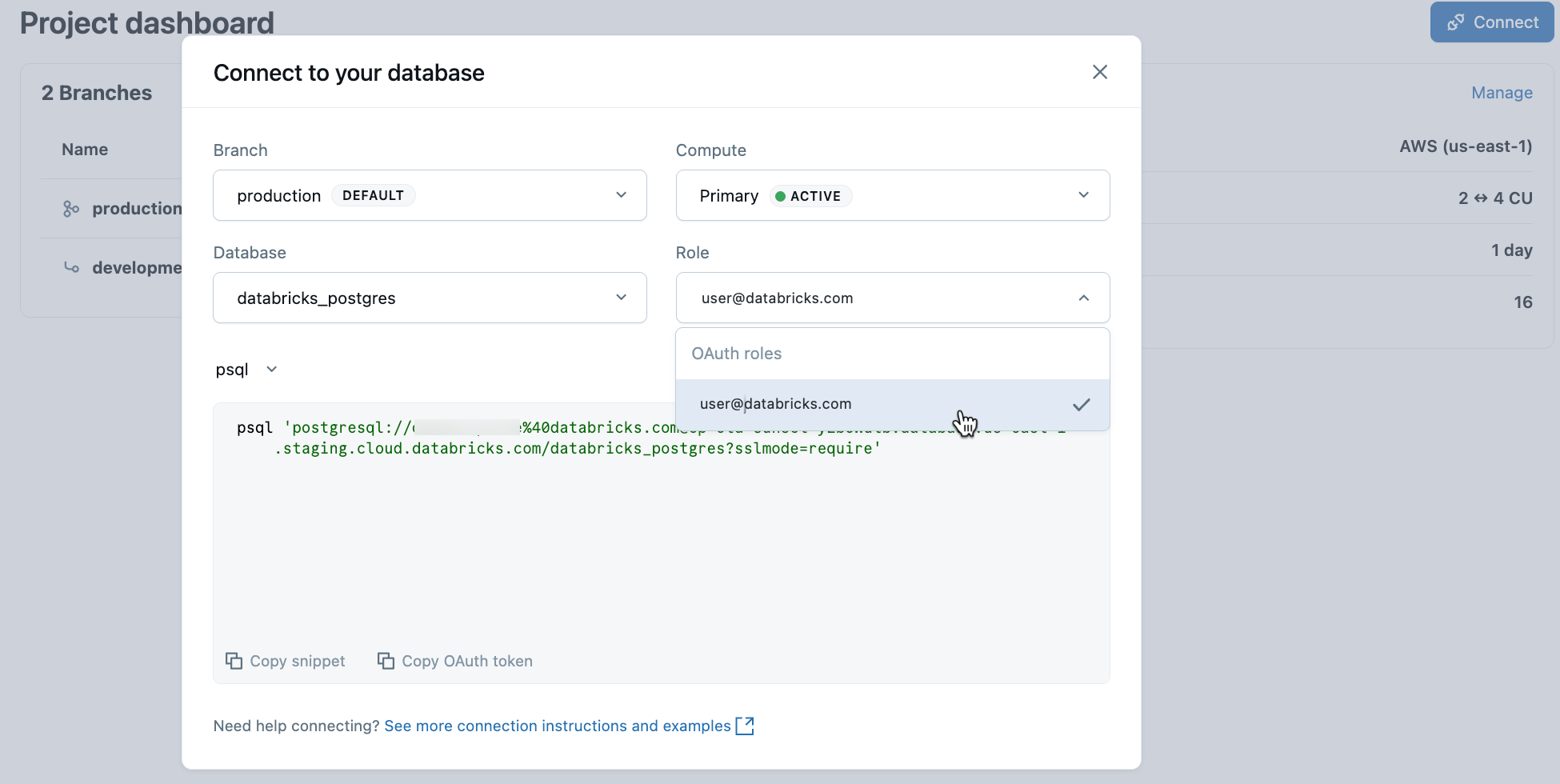

Nel progetto selezionare il ramo di produzione e fare clic su Connetti. È possibile connettersi usando l'identità di Databricks con l'autenticazione OAuth o creare un ruolo di password Postgres nativo. Le stringhe di connessione funzionano con client Postgres standard come psql, pgAdmin o qualsiasi strumento compatibile con Postgres.

Quando si crea un progetto, viene creato automaticamente un ruolo Postgres per l'identità di Databricks ( ad esempio , user@databricks.com). Questo ruolo è proprietario del database predefinito databricks_postgres ed è membro di databricks_superuser, concedendo privilegi generali per gestire gli oggetti di database.

Per connettersi usando l'identità di Databricks con OAuth, copiare il psql frammento di connessione dalla finestra di dialogo di connessione.

psql 'postgresql://your-email@databricks.com@ep-abc-123.databricks.com/databricks_postgres?sslmode=require'

Dopo aver inserito il comando di psql connessione nel terminale, ti viene richiesto di fornire un token OAuth. Ottenere il token facendo clic sull'opzione Copia token OAuth nella finestra di dialogo di connessione.

Per informazioni dettagliate sulla connessione e opzioni di autenticazione, vedere Avvio rapido.

Creare la prima tabella

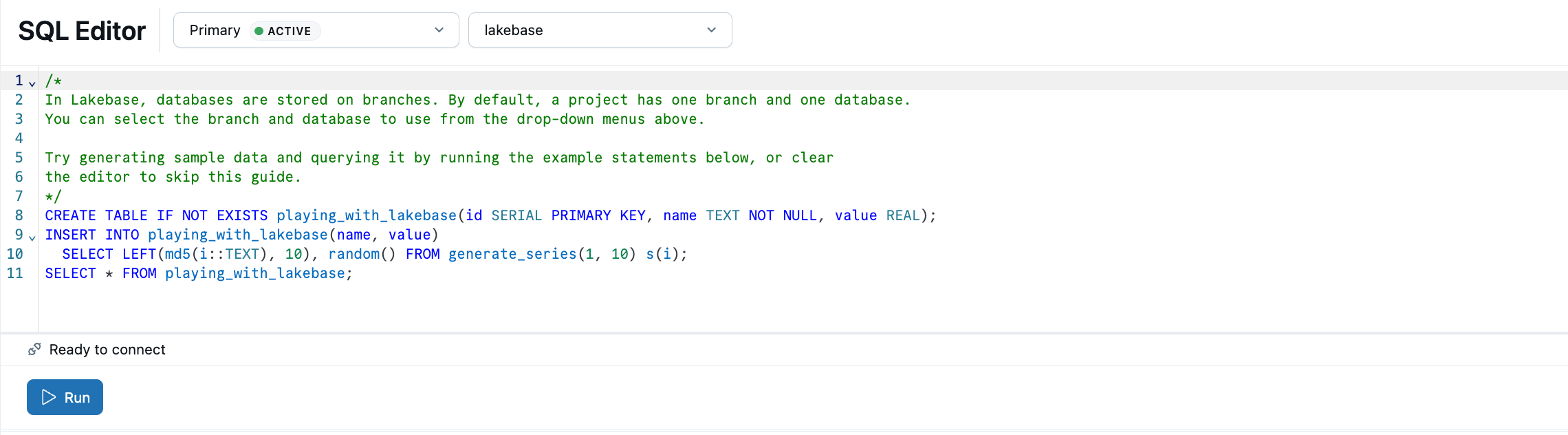

L'editor SQL di Lakebase è precaricato con SQL di esempio per aiutarti a iniziare. Nel progetto selezionare il ramo di produzione , aprire l'editor SQL ed eseguire le istruzioni fornite per creare una playing_with_lakebase tabella e inserire dati di esempio. È anche possibile usare l'editor tabelle per la gestione dei dati visivi o connettersi con client Postgres esterni.

Altre informazioni sulle opzioni di query: Editor SQL | Editor Tabelle | Client Postgres

Eseguire la registrazione nel catalogo unity

Dopo aver creato una tabella nel ramo di produzione, è possibile registrare il database in Unity Catalog in modo da poter eseguire query sui dati dall'editor SQL di Databricks.

- Usare il commutatore delle app per passare a Lakehouse.

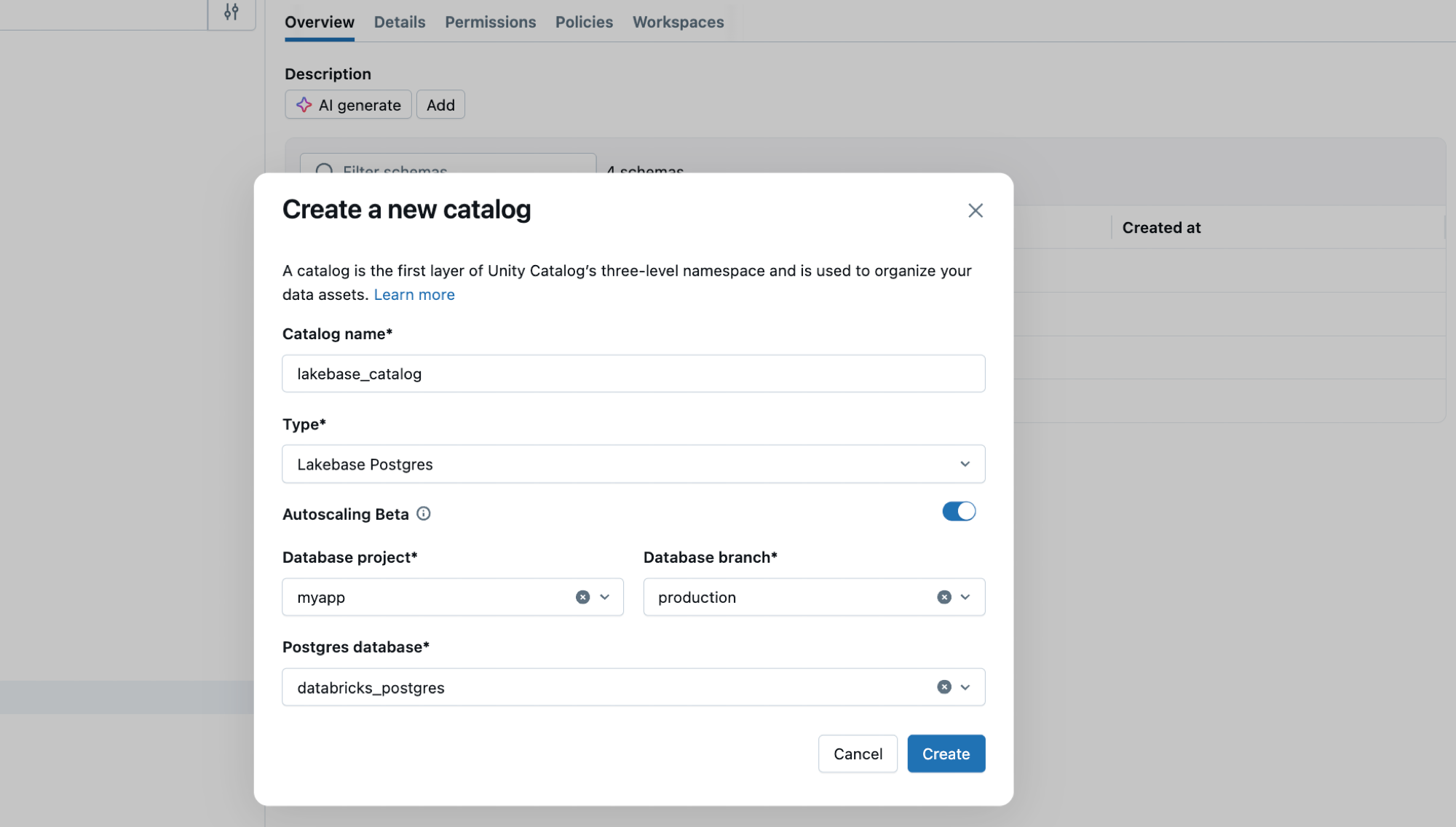

- In Esplora cataloghi fare clic sull'icona con il segno più e creare un catalogo.

- Immettere un nome di catalogo , ad esempio

lakebase_catalog. - Selezionare Lakebase Postgres come tipo di catalogo e abilitare l'opzione Scalabilità automatica .

- Selezionare il progetto, il

productionramo e ildatabricks_postgresdatabase. - Clicca su Crea.

È ora possibile eseguire una query sulla playing_with_lakebase tabella appena creata dall'editor SQL di Databricks usando un'istanza di SQL Warehouse:

SELECT * FROM lakebase_catalog.public.playing_with_lakebase;

Questo consente di eseguire query federate che uniscono i dati transazionali di LakeBase con le analisi del lakehouse. Per informazioni dettagliate, vedere Registrare nel catalogo unity.

Sincronizzare i dati con ETL inverso

Si è appena visto come rendere i dati di Lakebase eseguibili in Unity Catalog. Lakebase funziona anche nella direzione inversa: portare dati analitici curati FROM Unity Catalog nel database Lakebase. Ciò è utile quando si dispone di dati arricchiti, funzionalità di Machine Learning o metriche aggregate calcolate nel lakehouse che devono essere gestite dalle applicazioni con query transazionali a bassa latenza.

Creare prima di tutto una tabella in Unity Catalog che rappresenta i dati analitici. Aprire un'istanza di SQL Warehouse o notebook ed eseguire:

CREATE TABLE main.default.user_segments AS

SELECT * FROM VALUES

(1001, 'premium', 2500.00, 'high'),

(1002, 'standard', 450.00, 'medium'),

(1003, 'premium', 3200.00, 'high'),

(1004, 'basic', 120.00, 'low')

AS segments(user_id, tier, lifetime_value, engagement);

Sincronizzare ora questa tabella con il database Lakebase:

- In Lakehouse Catalog Explorer passare allauser_segments>>.

- Fare clic su Crea>tabella sincronizzata.

- Configurare la sincronizzazione:

-

Nome tabella: immettere

user_segments_synced. - Tipo di database: selezionare Lakebase Serverless (scalabilità automatica).

- Modalità di sincronizzazione: scegliere Snapshot per una sincronizzazione dati monouso.

- Selezionare il progetto, il ramo di produzione e il

databricks_postgresdatabase.

-

Nome tabella: immettere

- Clicca su Crea.

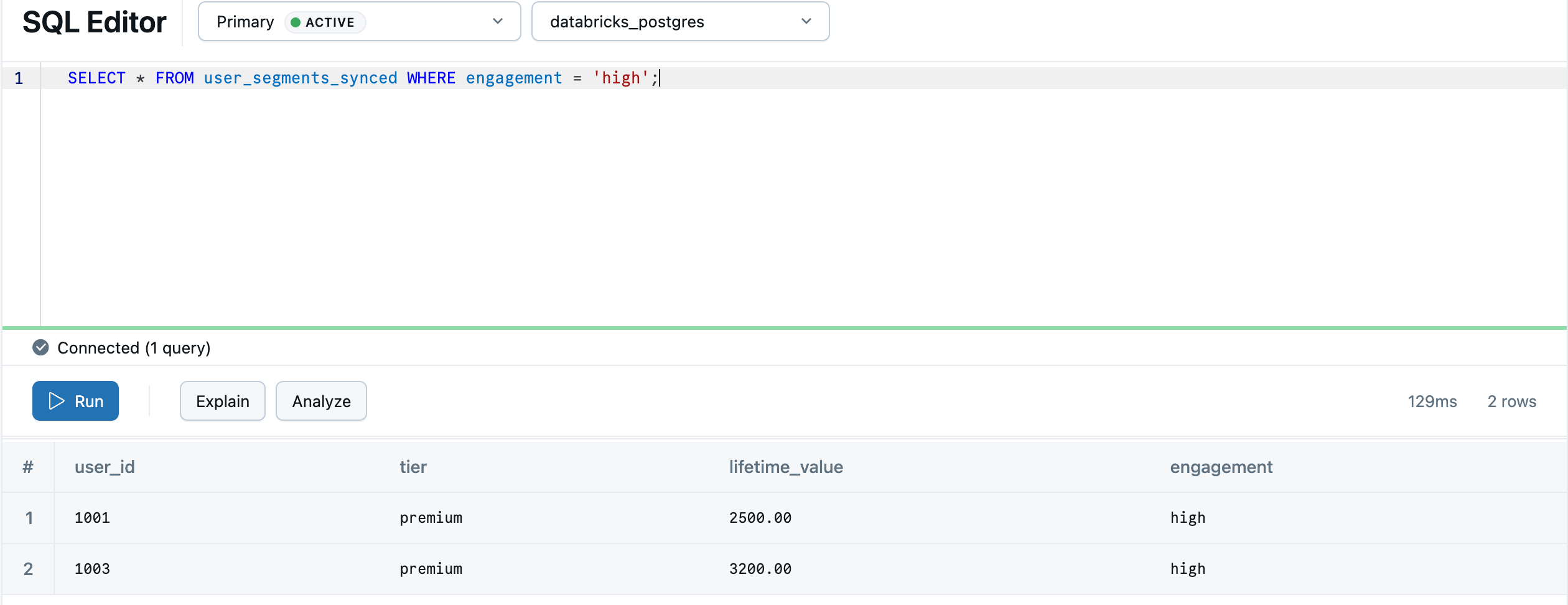

Al termine della sincronizzazione, la tabella viene visualizzata nel database Lakebase. Il processo di sincronizzazione crea uno default schema in Postgres in modo che corrisponda allo schema del catalogo Unity, quindi main.default.user_segments_synced diventa default.user_segments_synced. Torna a Lakebase usando il selettore delle applicazioni e fai una query nel SQL Editor di Lakebase.

SELECT * FROM "default"."user_segments_synced" WHERE "engagement" = 'high';

L'analisi lakehouse è ora disponibile per la gestione in tempo reale nel database transazionale. Per la sincronizzazione continua, le configurazioni avanzate e i mapping dei tipi di dati, vedere ETL inverso.