Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

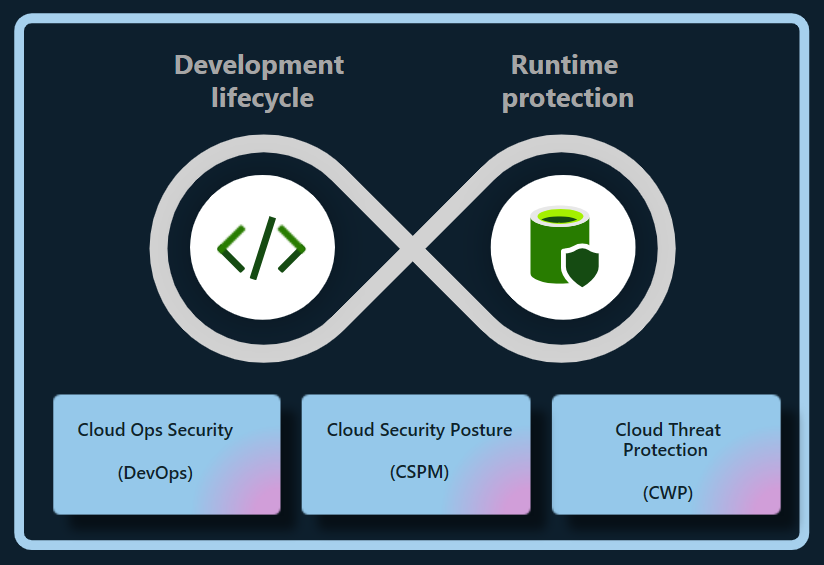

Il piano CsPM (Defender Cloud Security Posture Management) in Microsoft Defender for Cloud protegge gli ambienti cloud, multicloud o cloud ibridi creati dall'organizzazione. Questi ambienti includono Azure, Amazon Web Services (AWS) e Google Cloud Platform (GCP) Vertex AI (anteprima). Il piano CSPM protegge le applicazioni di intelligenza artificiale generative durante l'intero ciclo di vita. Defender per il cloud riduce i rischi per i carichi di lavoro di intelligenza artificiale tra cloud:

- Individuare la distinta base per l'intelligenza artificiale generativa, che include componenti dell'applicazione, dati e artefatti di intelligenza artificiale dal codice al cloud.

- Rafforzamento della postura di sicurezza delle applicazioni di IA generativa con raccomandazioni predefinite e tramite l'esplorazione e la correzione dei rischi per la sicurezza.

- Uso dell'analisi del percorso di attacco per identificare e correggere i rischi.

Importante

Per abilitare le funzionalità di gestione del comportamento di sicurezza dell'intelligenza artificiale in un account AWS che già:

- Connessione all'account Azure.

- Abilitazione di Defender CSPM.

- Tipo di autorizzazioni impostato come Accesso con privilegi minimi.

È necessario riconfigurare le autorizzazioni per tale connettore per abilitare le autorizzazioni pertinenti seguendo questa procedura:

- Nella portale di Azure passare alla pagina Impostazioni ambiente e selezionare il connettore AWS appropriato.

- Selezionare Configura accesso.

- Verificare che il tipo di autorizzazioni sia impostato su Accesso con privilegi minimi.

- Seguire i passaggi da 5 a 8 per completare la configurazione.

Individuare le app di intelligenza artificiale generative

Defender per il cloud individua i carichi di lavoro di intelligenza artificiale e identifica i dettagli della distinta base dell'intelligenza artificiale dell'organizzazione. Questa visibilità consente di identificare e risolvere le vulnerabilità e proteggere le applicazioni di IA generativa da potenziali minacce.

Defender per il cloud individua automaticamente e continuamente i carichi di lavoro di intelligenza artificiale distribuiti nei servizi seguenti:

- Servizio OpenAI di Azure

- Officina di Intelligenza Artificiale di Azure

- Azure Machine Learning (Apprendimento Automatico di Azure)

- Amazon Bedrock

- Google Vertex AI (anteprima)

Defender per il cloud può anche individuare vulnerabilità all'interno di dipendenze generative della libreria di intelligenza artificiale, ad esempio TensorFlow, PyTorch e Langchain analizzando il codice sorgente per errori di configurazione dell'infrastruttura come codice (IaC) e immagini del contenitore per le vulnerabilità. L'aggiornamento o l'applicazione regolare di patch alle librerie possono impedire exploit, proteggere le applicazioni di IA generativa e mantenerne l'integrità.

Grazie a queste funzionalità, Defender per il cloud offre visibilità completa dei carichi di lavoro di intelligenza artificiale dal codice al cloud.

Ridurre i rischi per la generazione di app di intelligenza artificiale

Defender CSPM fornisce informazioni contestuali sul comportamento di sicurezza dell'intelligenza artificiale dell'organizzazione. È possibile ridurre i rischi all'interno dei carichi di lavoro di intelligenza artificiale usando raccomandazioni sulla sicurezza e le analisi dei percorsi di attacco.

Esplorare i rischi usando le raccomandazioni

Defender per il cloud valuta i carichi di lavoro di intelligenza artificiale. Vengono fornite raccomandazioni sull'identità, la sicurezza dei dati e l'esposizione a Internet per identificare e classificare in ordine di priorità i problemi di sicurezza critici.

Rilevare errori di configurazione IaC

La sicurezza di DevOps rileva errori di configurazione per IaC, che possono esporre applicazioni di IA generativa a vulnerabilità di sicurezza, ad esempio controlli di accesso sovraesposti o servizi esposti pubblicamente accidentalmente. Queste configurazioni errate potrebbero causare violazioni dei dati, accessi non autorizzati e problemi di conformità, soprattutto quando si gestiscono normative rigorose sulla privacy dei dati.

Defender per il cloud valuta la configurazione delle app di IA generativa e fornisce raccomandazioni sulla sicurezza per migliorare la postura di sicurezza basata su intelligenza artificiale.

Per evitare problemi complessi in un secondo momento, correggere le configurazioni non corrette rilevate all'inizio del ciclo di sviluppo.

I controlli di sicurezza dell'intelligenza artificiale per IaC correnti includono:

- Usare endpoint privati del servizio Azure per intelligenza artificiale

- Limitare gli endpoint del servizio Azure per intelligenza artificiale

- Usare l'identità gestita per gli account del servizio Azure per intelligenza artificiale

- Usare l'autenticazione basata su identità per gli account del servizio Azure per intelligenza artificiale

Esplorare i rischi con l'analisi del percorso di attacco

L'analisi del percorso di attacco rileva e riduce i rischi per i carichi di lavoro di intelligenza artificiale. I modelli di intelligenza artificiale a base di dati specifici e l'ottimizzazione di un modello con training preliminare in un set di dati specifico per migliorare le prestazioni in un'attività correlata sono fasi in cui i dati potrebbero essere esposti.

Monitorando continuamente i carichi di lavoro di intelligenza artificiale, l'analisi del percorso di attacco può identificare punti deboli e potenziali vulnerabilità e fornire raccomandazioni specifiche. Si estende anche ai casi in cui i dati e le risorse di calcolo vengono distribuiti in Azure, AWS e GCP.