Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Questo articolo illustra come valutare le risposte di un'app di chat rispetto a un set di risposte corrette o ideali (note come verità di base). Ogni volta che si modifica l'applicazione di chat in modo che influisca sulle risposte, eseguire una valutazione per confrontare le modifiche. Questa applicazione demo offre strumenti che è possibile usare oggi per semplificare l'esecuzione delle valutazioni.

Seguendo le istruzioni riportate in questo articolo, è possibile:

- Usare richieste di esempio fornite personalizzate per il dominio soggetto. Queste richieste sono già presenti nel repository.

- Generare domande utente di esempio e risposte sulla verità dai propri documenti.

- Eseguire valutazioni usando una richiesta di esempio con le domande dell'utente generate.

- Esaminare l'analisi delle risposte.

Nota

Questo articolo usa uno o più modelli di app di intelligenza artificiale come base per gli esempi e le linee guida nell’articolo. I modelli di app di intelligenza artificiale offrono implementazioni di riferimento ben gestite che sono facili da distribuire. Consentono di garantire un punto di partenza di alta qualità per le app di intelligenza artificiale.

Panoramica dell'architettura

I componenti chiave dell'architettura includono:

- App chat ospitata in Azure: l'app di chat viene eseguita nel servizio app Azure.

- Microsoft AI Chat Protocol: il protocollo fornisce contratti API standardizzati tra soluzioni e linguaggi di intelligenza artificiale. L'app chat è conforme al protocollo Microsoft AI Chat Protocol, che consente l'esecuzione dell'app di valutazione su qualsiasi app di chat conforme al protocollo.

- Ricerca di intelligenza artificiale di Azure: l'app di chat usa Ricerca intelligenza artificiale di Azure per archiviare i dati dai propri documenti.

- Generatore di domande di esempio: lo strumento può generare molte domande per ogni documento insieme alla risposta alla verità di base. Più ci sono domande, più lunghe sono le valutazioni.

- Analizzatore: lo strumento esegue domande e richieste di esempio sull'app di chat e restituisce i risultati.

- Strumento di revisione: lo strumento esamina i risultati delle valutazioni.

- Strumento Diff: lo strumento confronta le risposte tra le valutazioni.

Quando si distribuisce questa valutazione in Azure, viene creato l'endpoint del servizio Azure OpenAI per il GPT-4 modello con la propria capacità. Quando si valutano le applicazioni di chat, è importante che l'analizzatore abbia una propria risorsa OpenAI di Azure usando GPT-4 con la propria capacità.

Prerequisiti

Una sottoscrizione di Azure. Creane uno gratis.

Completare la procedura precedente dell'applicazione di chat per distribuire l'applicazione di chat in Azure. Questa risorsa è necessaria per il funzionamento dell'app di valutazione. Non completare la sezione "Pulire le risorse" della procedura precedente.

Per questa distribuzione, sono necessarie le seguenti informazioni sulle risorse di Azure, riferite come app di chat in questo articolo:

- URI DELL'API Chat. Punto di accesso back-end del servizio visualizzato alla fine del

azd upprocesso. - Ricerca di intelligenza artificiale di Azure. Sono necessari i valori seguenti:

-

Nome risorsa: nome della risorsa di Ricerca di intelligenza artificiale di Azure, indicato come

Search servicedurante ilazd upprocesso. - Nome dell'indice: il nome dell'indice di ricerca AI di Azure in cui sono archiviati i documenti. È possibile trovarla nel portale di Azure per il servizio di ricerca.

-

Nome risorsa: nome della risorsa di Ricerca di intelligenza artificiale di Azure, indicato come

L'URL dell'API Chat consente alle valutazioni di effettuare richieste tramite l'applicazione back-end. Le informazioni di Ricerca intelligenza artificiale di Azure consentono agli script di valutazione di usare la stessa distribuzione del back-end, caricata con i documenti.

Dopo aver raccolto queste informazioni, non è necessario usare di nuovo l'ambiente di sviluppo di app chat. Questo articolo fa riferimento a esso in seguito, più volte, per indicare come l'app per le valutazioni utilizza l'app di chat. Non eliminare le risorse dell'app chat fino a quando non si completa l'intera procedura in questo articolo.

- URI DELL'API Chat. Punto di accesso back-end del servizio visualizzato alla fine del

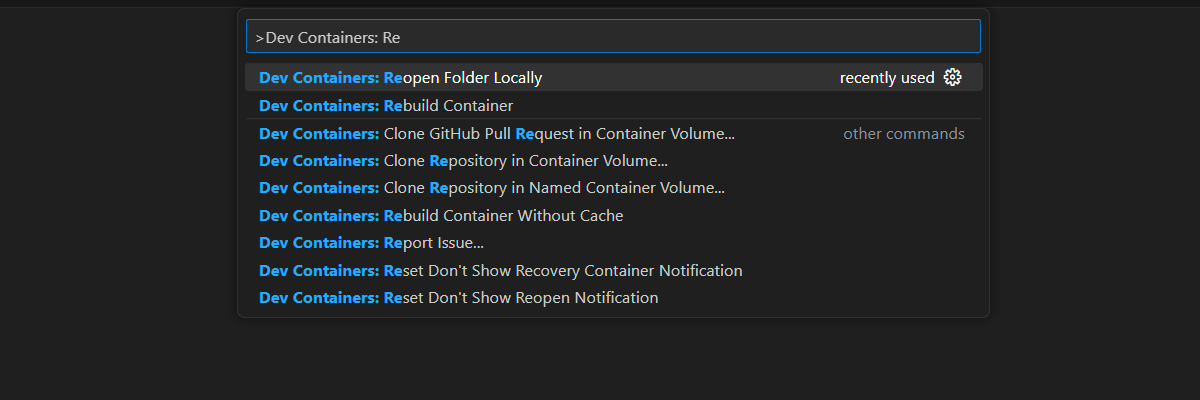

Un ambiente di sviluppo è disponibile con tutte le dipendenze necessarie per completare questo articolo. È possibile eseguire il contenitore di sviluppo in GitHub Codespaces (in un browser) o in locale usando Visual Studio Code.

- Account GitHub

Aprire un ambiente di sviluppo

Seguire queste istruzioni per configurare un ambiente di sviluppo preconfigurato con tutte le dipendenze necessarie per completare questo articolo. Disporre l'area di lavoro di monitoraggio in modo che sia possibile visualizzare la documentazione e l'ambiente di sviluppo contemporaneamente.

Questo articolo è stato testato con l'area per la switzerlandnorth distribuzione di valutazione.

GitHub Codespaces esegue un contenitore di sviluppo gestito da GitHub con Visual Studio Code per il Web come interfaccia utente. Usare GitHub Codespaces per l'ambiente di sviluppo più semplice. Include gli strumenti di sviluppo e le dipendenze appropriati preinstallati per completare questo articolo.

Importante

Tutti gli account GitHub possono usare GitHub Codespaces per un massimo di 60 ore gratuite ogni mese con due istanze principali. Per altre informazioni, vedere Spazio di archiviazione e ore core mensili inclusi in GitHub Codespaces.

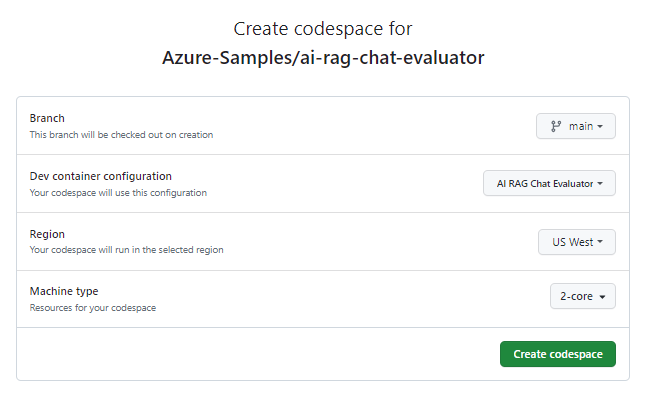

Avviare il processo per creare un nuovo spazio di codice GitHub nel

mainramo del repository GitHub Azure-Samples/ai-rag-chat-evaluator .Per visualizzare l'ambiente di sviluppo e la documentazione disponibile contemporaneamente, fare clic con il pulsante destro del mouse sul pulsante seguente e scegliere Apri collegamento in una nuova finestra.

Nella pagina Crea codespace, esaminare le impostazioni di configurazione del codespace e quindi selezionare Crea nuovo codespace.

Attendere l'avvio del codespace. Questo processo di avvio può richiedere alcuni minuti.

Nel terminale nella parte inferiore della schermata, accedi ad Azure con Azure Developer CLI.

azd auth login --use-device-codeCopia il codice dal terminale e incollalo in un browser. Segui le istruzioni per eseguire l'autenticazione con l'account Azure.

Effettuare il provisioning della risorsa di Azure necessaria, servizio Azure OpenAI, per l'app di valutazione:

azd upQuesto

AZDcomando non distribuisce l'app di valutazione, ma crea la risorsa OpenAI di Azure con una distribuzione necessariaGPT-4per eseguire le valutazioni nell'ambiente di sviluppo locale.

Le attività rimanenti in questo articolo vengono eseguite nel contesto di questo contenitore di sviluppo.

Il nome del repository GitHub viene visualizzato nella barra di ricerca. Questo indicatore visivo consente di distinguere l'app di valutazione dall'app di chat. Questo ai-rag-chat-evaluator repository viene definito app di valutazione in questo articolo.

Preparare i valori e le informazioni di configurazione dell'ambiente

Aggiornare i valori dell'ambiente e le informazioni di configurazione con le informazioni raccolte durante i prerequisiti per l'app di valutazione.

Creare un

.envfile basato su.env.sample.cp .env.sample .envEseguire questo comando per ottenere i valori necessari per

AZURE_OPENAI_EVAL_DEPLOYMENTeAZURE_OPENAI_SERVICEdal gruppo di risorse distribuito. Incollare tali valori nel.envfile.azd env get-value AZURE_OPENAI_EVAL_DEPLOYMENT azd env get-value AZURE_OPENAI_SERVICEAggiungere i seguenti valori dalla chat app per l'istanza di Ricerca AI di Azure nel file

.env, raccolti nella sezione Prerequisiti.AZURE_SEARCH_SERVICE="<service-name>" AZURE_SEARCH_INDEX="<index-name>"

Usare il protocollo Microsoft AI Chat per informazioni di configurazione

L'app chat e l'app di valutazione implementano entrambe la specifica microsoft AI Chat Protocol, un contratto open source, cloud e api endpoint di intelligenza artificiale indipendente dal linguaggio usato per l'utilizzo e la valutazione. Quando gli endpoint client e di livello intermedio rispettano questa specifica api, è possibile usare ed eseguire valutazioni in modo coerente sui back-end di intelligenza artificiale.

Creare un nuovo file denominato

my_config.jsone copiarne il contenuto seguente:{ "testdata_path": "my_input/qa.jsonl", "results_dir": "my_results/experiment<TIMESTAMP>", "target_url": "http://localhost:50505/chat", "target_parameters": { "overrides": { "top": 3, "temperature": 0.3, "retrieval_mode": "hybrid", "semantic_ranker": false, "prompt_template": "<READFILE>my_input/prompt_refined.txt", "seed": 1 } } }Lo script di valutazione crea la

my_resultscartella .L'oggetto

overridescontiene le impostazioni di configurazione necessarie per l'applicazione. Ogni applicazione definisce il proprio set di proprietà delle impostazioni.Usare la tabella seguente per comprendere il significato delle proprietà delle impostazioni inviate all'app di chat.

Proprietà Impostazioni Descrizione semantic_rankerSe usare il ranker semantico, un modello che classifica i risultati della ricerca in base alla somiglianza semantica con la query dell'utente. Questa esercitazione viene disabilitata per ridurre i costi. retrieval_modeModalità di recupero da utilizzare. Il valore predefinito è hybrid.temperatureImpostazione della temperatura per il modello. Il valore predefinito è 0.3.topNumero di risultati di ricerca da restituire. Il valore predefinito è 3.prompt_templateOverride della richiesta usata per generare la risposta in base ai risultati della domanda e della ricerca. seedValore di inizializzazione per tutte le chiamate ai modelli GPT. L'impostazione di un valore di inizializzazione comporta risultati più coerenti tra le valutazioni. Modifica il valore

target_urlcon il valore URI della tua app di chat, raccolto nella sezione Prerequisiti. L'app di chat deve essere conforme al protocollo di chat. L'URI ha il formato seguente:https://CHAT-APP-URL/chat. Assicurarsi che il protocollo e lachatroute facciano parte dell'URI.

Generare dati di esempio

Per valutare nuove risposte, devono essere confrontate con una risposta di verità di riferimento, ovvero la risposta ideale per una domanda specifica. Generare domande e risposte da documenti archiviati in Ricerca di intelligenza artificiale di Azure per l'app di chat.

Copiare la

example_inputcartella in una nuova cartella denominatamy_input.In un terminale eseguire il comando seguente per generare i dati di esempio:

python -m evaltools generate --output=my_input/qa.jsonl --persource=2 --numquestions=14

Le coppie di domande e risposte vengono generate e archiviate in my_input/qa.jsonl (in formato JSONL) come input per l'analizzatore usato nel passaggio successivo. Per una valutazione di produzione, si generano più coppie di domande e risposte. Più di 200 vengono generati per questo set di dati.

Nota

Vengono generate solo alcune domande e risposte per ogni origine, in modo da poter completare rapidamente questa procedura. Non deve essere una valutazione di produzione, che dovrebbe avere più domande e risposte per ciascuna fonte.

Eseguire la prima valutazione con un prompt perfezionato

Modificare le proprietà del

my_config.jsonfile di configurazione.Proprietà Nuovo valore results_dirmy_results/experiment_refinedprompt_template<READFILE>my_input/prompt_refined.txtIl prompt perfezionato è specifico sul dominio soggetto.

If there isn't enough information below, say you don't know. Do not generate answers that don't use the sources below. If asking a clarifying question to the user would help, ask the question. Use clear and concise language and write in a confident yet friendly tone. In your answers, ensure the employee understands how your response connects to the information in the sources and include all citations necessary to help the employee validate the answer provided. For tabular information, return it as an html table. Do not return markdown format. If the question is not in English, answer in the language used in the question. Each source has a name followed by a colon and the actual information. Always include the source name for each fact you use in the response. Use square brackets to reference the source, e.g. [info1.txt]. Don't combine sources, list each source separately, e.g. [info1.txt][info2.pdf].In un terminale eseguire il comando seguente per eseguire la valutazione:

python -m evaltools evaluate --config=my_config.json --numquestions=14Questo script ha creato una nuova cartella dell'esperimento in

my_results/con la valutazione. La cartella contiene i risultati della valutazione.Nome del file Descrizione config.jsonCopia del file di configurazione usato per la valutazione. evaluate_parameters.jsonParametri utilizzati per la valutazione. Analogamente a config.jsonma include altri metadati, ad esempio timestamp.eval_results.jsonlOgni domanda e risposta, insieme alle metriche GPT per ogni coppia di domande e risposte. summary.jsonRisultati complessivi, ad esempio le metriche GPT medie.

Eseguire la seconda valutazione con un prompt debole

Modificare le proprietà del

my_config.jsonfile di configurazione.Proprietà Nuovo valore results_dirmy_results/experiment_weakprompt_template<READFILE>my_input/prompt_weak.txtQuesto prompt debole non ha alcun contesto relativo all'ambito del soggetto.

You are a helpful assistant.In un terminale eseguire il comando seguente per eseguire la valutazione:

python -m evaltools evaluate --config=my_config.json --numquestions=14

Eseguire la terza valutazione con una temperatura specifica

Usa una richiesta che consenta una maggiore creatività.

Modificare le proprietà del

my_config.jsonfile di configurazione.Esistente Proprietà Nuovo valore Esistente results_dirmy_results/experiment_ignoresources_temp09Esistente prompt_template<READFILE>my_input/prompt_ignoresources.txtNuovo temperature0.9Il valore predefinito

temperatureè 0,7. Maggiore è la temperatura, più creative sono le risposte.Il

ignoreprompt è breve.Your job is to answer questions to the best of your ability. You will be given sources but you should IGNORE them. Be creative!L'oggetto di configurazione dovrebbe essere simile all'esempio seguente, ad eccezione del fatto che è stato sostituito

results_dircon il percorso:{ "testdata_path": "my_input/qa.jsonl", "results_dir": "my_results/prompt_ignoresources_temp09", "target_url": "https://YOUR-CHAT-APP/chat", "target_parameters": { "overrides": { "temperature": 0.9, "semantic_ranker": false, "prompt_template": "<READFILE>my_input/prompt_ignoresources.txt" } } }In un terminale eseguire il comando seguente per eseguire la valutazione:

python -m evaltools evaluate --config=my_config.json --numquestions=14

Esaminare i risultati della valutazione

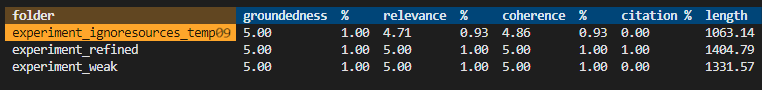

Sono state eseguite tre valutazioni in base a richieste e impostazioni dell'app diverse. I risultati vengono archiviati nella my_results cartella . Esaminare le differenze dei risultati in base alle impostazioni.

Usare lo strumento di revisione per visualizzare i risultati delle valutazioni.

python -m evaltools summary my_resultsI risultati hanno un aspetto simile al seguente:

Ogni valore viene restituito come numero e percentuale.

Usare la tabella seguente per comprendere il significato dei valori.

valore Descrizione Allineamento Verifica l'integrità delle risposte del modello in base a informazioni reali e verificabili. Una risposta viene considerata a terra se è effettivamente accurata e riflette la realtà. Pertinenza Misura il livello di allineamento delle risposte del modello al contesto o al prompt. Una risposta pertinente risolve direttamente la query o l'istruzione dell'utente. Coerenza Verifica la coerenza logica delle risposte del modello. Una risposta coerente mantiene un flusso logico e non si contraddice. Citazione Indica se la risposta è stata restituita nel formato richiesto nel prompt. Durata Misura la lunghezza della risposta. I risultati dovrebbero indicare che tutte e tre le valutazioni hanno avuto una rilevanza elevata, mentre la

experiment_ignoresources_temp09ha avuto la rilevanza più bassa.Selezionare la cartella per visualizzare la configurazione per la valutazione.

Premere CTRL + C per uscire dall'app e tornare al terminale.

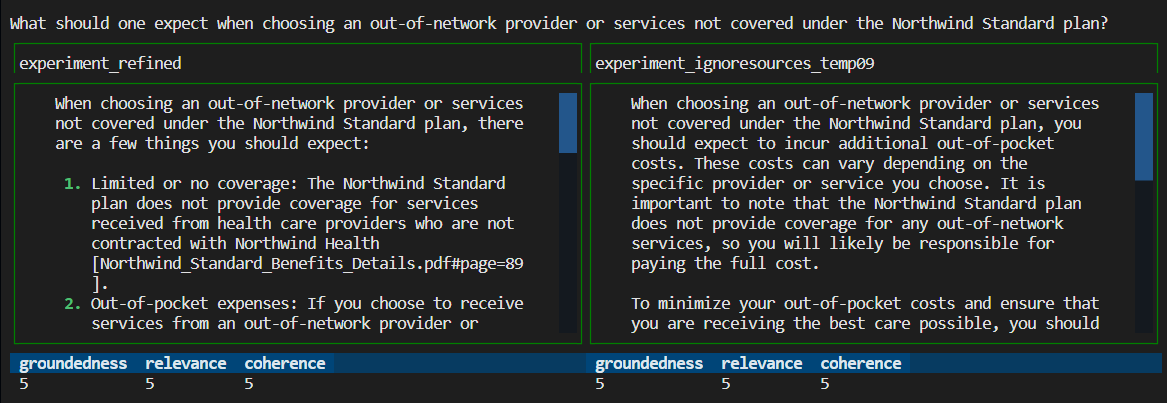

Confrontare le risposte

Confrontare le risposte restituite dalle valutazioni.

Selezionare due delle valutazioni da confrontare e quindi usare lo stesso strumento di revisione per confrontare le risposte.

python -m evaltools diff my_results/experiment_refined my_results/experiment_ignoresources_temp09Esaminare i risultati. I risultati potrebbero variare.

Premere CTRL + C per uscire dall'app e tornare al terminale.

Suggerimenti per ulteriori valutazioni

- Modificare le richieste in

my_inputper personalizzare le risposte, ad esempio dominio soggetto, lunghezza e altri fattori. - Modificare il

my_config.jsonfile per modificare i parametri, adtemperatureesempio , edsemantic_rankereseguire di nuovo gli esperimenti. - Confrontare risposte diverse per comprendere come la richiesta e la domanda influiscono sulla qualità della risposta.

- Generare un set separato di domande e risposte reali per ogni documento nell'indice di Ricerca di intelligenza artificiale di Azure. Eseguire quindi di nuovo le valutazioni per vedere in che modo le risposte differiscono.

- Modificare le richieste per indicare risposte più brevi o più lunghe aggiungendo il requisito alla fine del prompt. Un esempio è

Please answer in about 3 sentences.

Pulire risorse e dipendenze

I passaggi seguenti illustrano il processo di pulizia delle risorse usate.

Pulire le risorse di Azure

Le risorse di Azure create in questo articolo vengono fatturate alla sottoscrizione di Azure. Se prevedi che queste risorse non ti servano in futuro, eliminale per evitare di incorrere in costi aggiuntivi.

Per eliminare le risorse di Azure e rimuovere il codice sorgente, eseguire il comando seguente dell'interfaccia della riga di comando per sviluppatori di Azure:

azd down --purge

Pulire GitHub Codespaces e Visual Studio Code

L'eliminazione dell'ambiente GitHub Codespaces garantisce che sia possibile massimizzare l'ammontare delle ore gratuite per core assegnato al tuo account.

Importante

Per altre informazioni sui diritti dell'account GitHub, vedere Ore di archiviazione e di core mensili incluse in GitHub Codespaces.

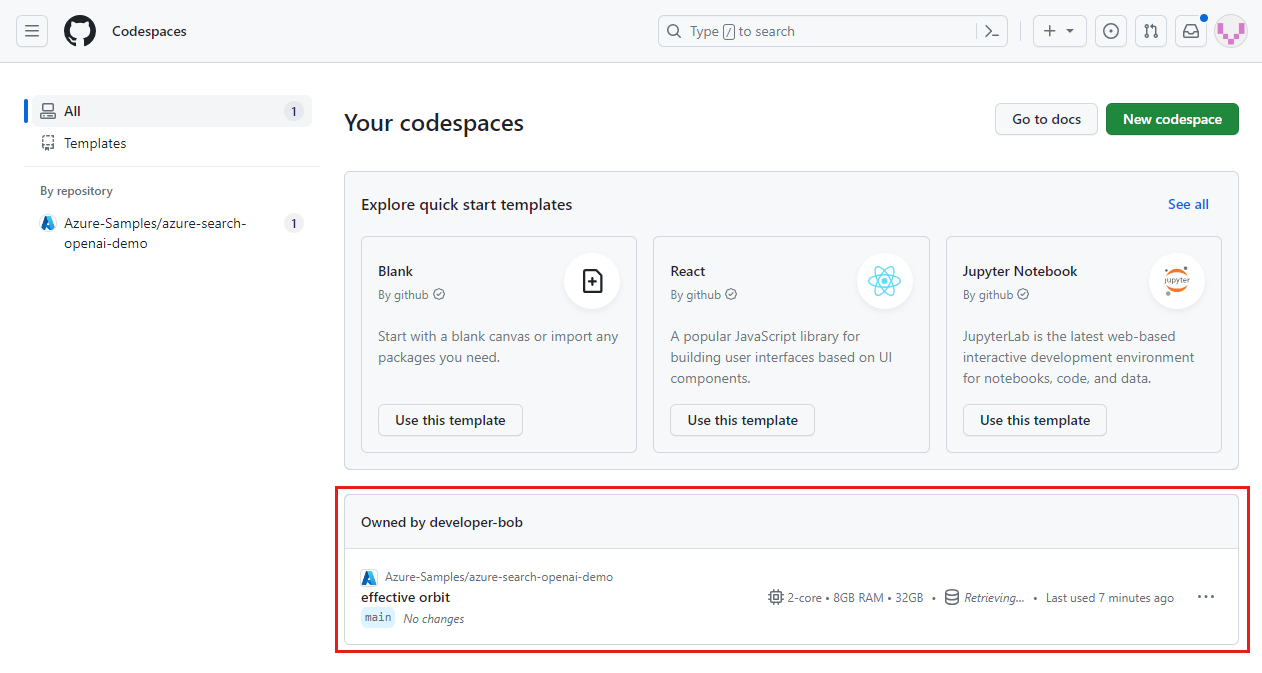

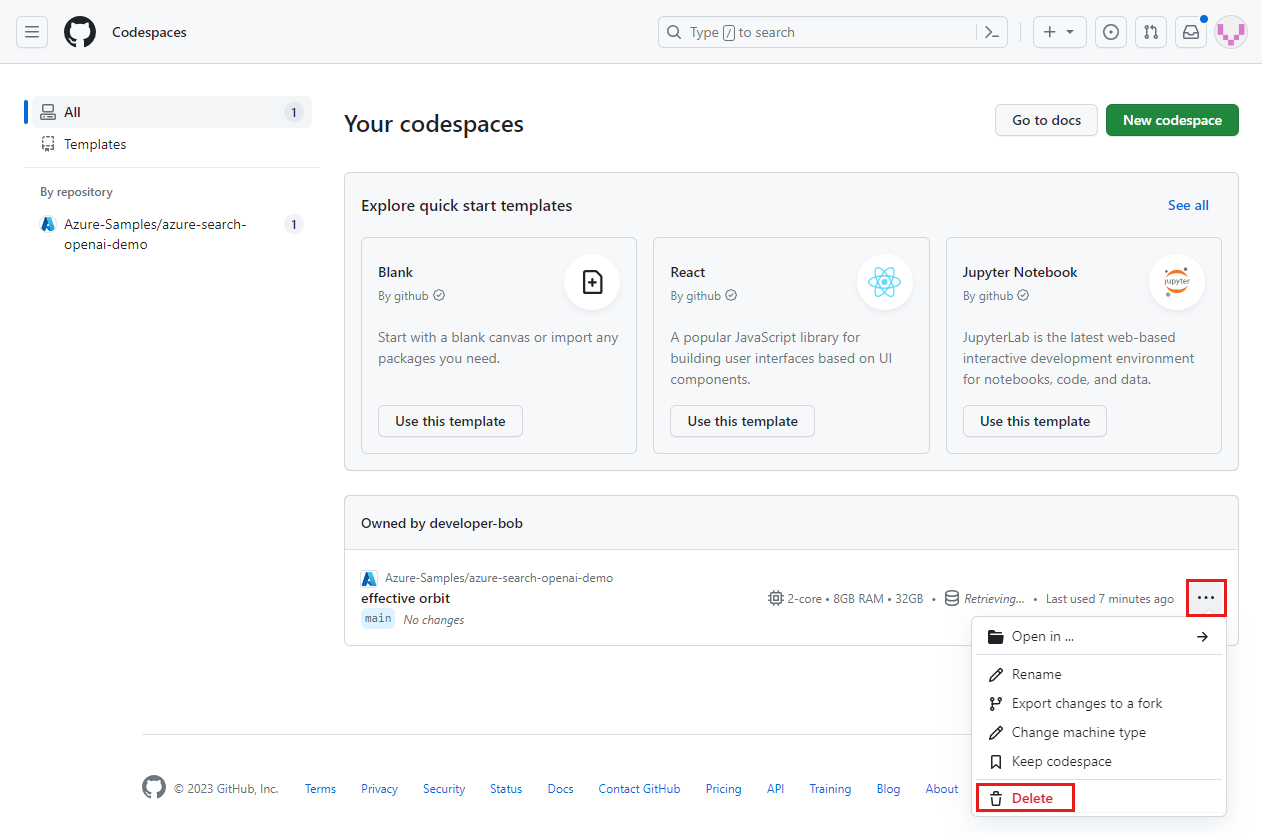

Accedere al dashboard GitHub Codespaces.

Individua i tuoi spazi di codice attualmente in esecuzione provenienti dal repository GitHub Azure-Samples/ai-rag-chat-evaluator.

Aprire il menu contestuale per lo spazio di codice e quindi selezionare Elimina.

Torna all'articolo sull'app di chat per pulire quelle risorse.

Contenuti correlati

- Consulta il repository delle valutazioni.

- Consulta il repository GitHub dell'app chat aziendale.

- Crea un'app di chat con Azure OpenAI architettura delle soluzioni consigliate.

- Scopri il controllo di accesso nelle app di intelligenza artificiale generativa con Azure AI Search.

- Creare una soluzione Azure OpenAI aziendale con Gestione API di Azure.

- Consulta Azure AI Search: supera la ricerca vettoriale con funzionalità ibride di ricerca e classificazione.