Aprire lo strumento LLM del modello

Lo strumento Open Model LLM consente l'utilizzo di vari modelli Open Model e Foundational Models, ad esempio Falcon e Llama 2, per l'elaborazione del linguaggio naturale nel flusso dei prompt di Azure Machine Learning.

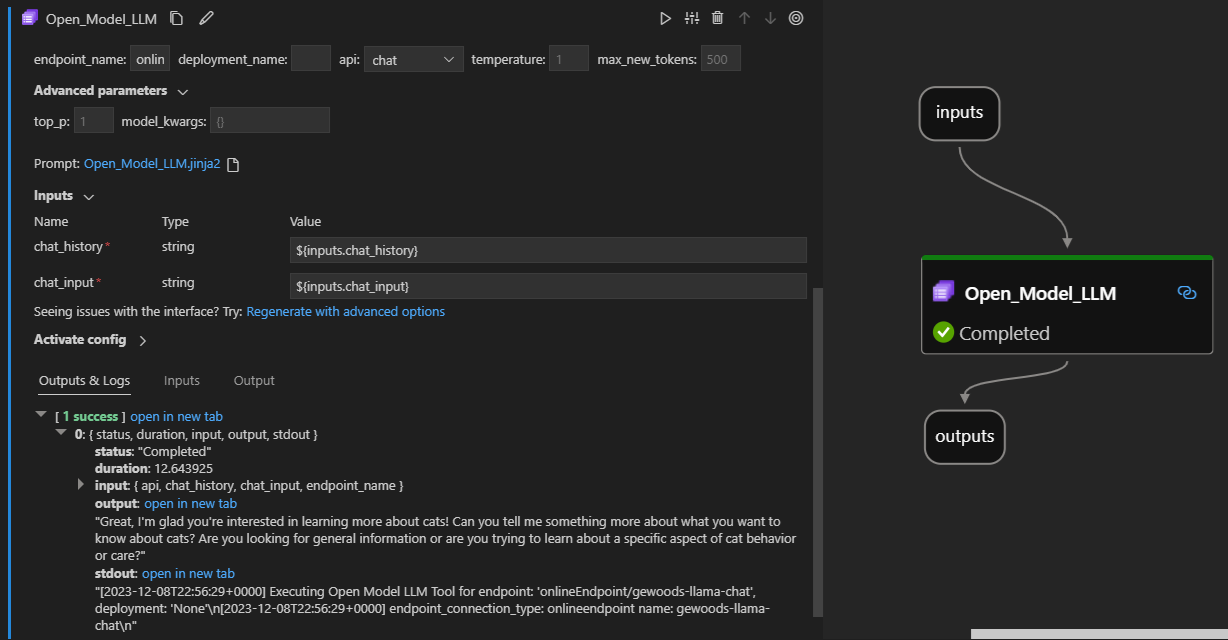

Ecco come appare in azione sull'estensione del flusso del prompt di Visual Studio Code. In questo esempio lo strumento viene usato per chiamare un endpoint di chat LlaMa-2 e chiedere "Che cos'è l'integrazione continua?".

Questo strumento flusso di richiesta supporta due diversi tipi di API LLM:

- Chat: illustrato nell'esempio precedente. Il tipo di API chat facilita le conversazioni interattive con input e risposte basati su testo.

- Completamento: il tipo di API Completamento viene usato per generare completamento di testo a risposta singola in base all'input del prompt specificato.

Panoramica rapida: Ricerca per categorie usare lo strumento Open Model LLM?

- Scegliere un modello dal catalogo dei modelli di Azure Machine Learning e distribuirlo.

- Connessione alla distribuzione del modello.

- Configurare le impostazioni dello strumento open model llm.

- Preparare il prompt.

- Eseguire il flusso.

Prerequisiti: distribuzione del modello

- Selezionare il modello corrispondente allo scenario dal catalogo dei modelli di Azure Machine Learning.

- Usare il pulsante Distribuisci per distribuire il modello in un endpoint di inferenza online di Azure Machine Learning.

- Usare una delle opzioni di distribuzione con pagamento in base al consumo.

Per altre informazioni, vedere Distribuire modelli di base agli endpoint per l'inferenza.

Prerequisiti: Connessione al modello

Per consentire al flusso di prompt di usare il modello distribuito, è necessario connettersi. Esistono due modi per connettersi.

Connessioni endpoint

Dopo aver associato il flusso a un'area di lavoro di Azure Machine Learning o Azure AI Studio, lo strumento Open Model LLM può usare gli endpoint nell'area di lavoro.

Uso di Azure Machine Learning o delle aree di lavoro di Azure AI Studio: se si usa il flusso dei prompt in una delle aree di lavoro basate su browser basati su pagine Web, gli endpoint online disponibili nell'area di lavoro che si attivano automaticamente.

Uso di VS Code o code first: se si usa il flusso di prompt in VS Code o una delle offerte Code First, è necessario connettersi all'area di lavoro. Lo strumento Open Model LLM usa il client Azure.identity DefaultAzureCredential per l'autorizzazione. Un modo consiste nell'impostare i valori delle credenziali dell'ambiente.

Connessioni personalizzate

Lo strumento Open Model LLM usa custom Connessione ion. Il flusso di richiesta supporta due tipi di connessioni:

Connessioni all'area di lavoro: Connessione che vengono archiviate come segreti in un'area di lavoro di Azure Machine Learning. Anche se queste connessioni possono essere usate, in molte posizioni, vengono comunemente create e gestite nell'interfaccia utente di Studio. Per informazioni su come creare una connessione personalizzata nell'interfaccia utente di Studio, vedere come creare una connessione personalizzata.

Connessioni locali: Connessione che vengono archiviate localmente nel computer. Queste connessioni non sono disponibili nell'esperienza utente di Studio, ma possono essere usate con l'estensione VS Code. Per informazioni su come creare un Connessione personalizzato locale, vedere come creare una connessione locale.

Le chiavi necessarie da impostare sono:

- endpoint_url

- Questo valore è disponibile nell'endpoint di inferenza creato in precedenza.

- endpoint_api_key

- Assicurarsi di impostarlo come valore segreto.

- Questo valore è disponibile nell'endpoint di inferenza creato in precedenza.

- model_family

- Valori supportati: LLAMA, DOLLY, GPT2 o FALCON

- Questo valore dipende dal tipo di distribuzione di destinazione.

Esecuzione dello strumento: Input

Lo strumento Open Model LLM include molti parametri, alcuni dei quali sono obbligatori. Per informazioni dettagliate, vedere la tabella seguente per trovare una corrispondenza con questi parametri con lo screenshot precedente per maggiore chiarezza visiva.

| Nome | Tipo | Descrizione | Richiesto |

|---|---|---|---|

| api | string | Modalità API che dipende dal modello usato e dallo scenario selezionato. Valori supportati: (Completamento | Chat) | Sì |

| endpoint_name | string | Nome di un endpoint di inferenza online con un modello supportato distribuito. Ha la priorità sulla connessione. | Sì |

| temperatura | float | Casualità del testo generato. Il valore predefinito è 1. | No |

| max_new_tokens | integer | Numero massimo di token da generare nel completamento. Il valore predefinito è 500. | No |

| top_p | float | Probabilità di usare la scelta principale dai token generati. Il valore predefinito è 1. | No |

| model_kwargs | Dizionario | Questo input viene usato per fornire una configurazione specifica per il modello usato. Ad esempio, il modello Llama-02 può usare {"temperature":0.4}. Predefinito: {} | No |

| deployment_name | string | Nome della distribuzione di destinazione nell'endpoint di inferenza online. Se non viene passato alcun valore, vengono usate le impostazioni del traffico di inferenza del servizio di bilanciamento del carico. | No |

| prompt | string | Richiesta di testo usata dal modello linguistico per generare la risposta. | Sì |

Output

| API | Tipo restituito | Descrizione |

|---|---|---|

| Completion | string | Testo di un completamento previsto |

| Chat | string | Il testo di una risposta int la conversazione |

Distribuzione in un endpoint online

Quando si distribuisce un flusso contenente lo strumento Open Model LLM in un endpoint online, è necessario un passaggio aggiuntivo per configurare le autorizzazioni. Durante la distribuzione tramite le pagine Web, è possibile scegliere tra i tipi di identità assegnati dal sistema e i tipi di identità assegnati dall'utente. In entrambi i casi, usando il portale di Azure (o una funzionalità simile), aggiungere il ruolo della funzione processo "Lettore" all'identità nell'area di lavoro di Azure Machine Learning o nel progetto ai Studio, che ospita l'endpoint. Potrebbe essere necessario aggiornare la distribuzione del flusso di richiesta.

Commenti e suggerimenti

Presto disponibile: Nel corso del 2024 verranno gradualmente disattivati i problemi di GitHub come meccanismo di feedback per il contenuto e ciò verrà sostituito con un nuovo sistema di feedback. Per altre informazioni, vedere https://aka.ms/ContentUserFeedback.

Invia e visualizza il feedback per