Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

La velocità effettiva della rete delle macchine virtuali di Azure determina la larghezza di banda che le applicazioni possono usare per la comunicazione di rete. Azure offre diverse dimensioni e tipi di macchine virtuali, ognuno con diverse funzionalità di prestazioni di rete misurate in megabit al secondo (Mbps). Comprendere il funzionamento dell'allocazione della larghezza di banda consente di ottimizzare le prestazioni dell'applicazione e di scegliere le dimensioni appropriate per le macchine virtuali per i requisiti del carico di lavoro.

Ogni dimensione della macchina virtuale ha una combinazione diversa di funzionalità di prestazioni. Tra queste prestazioni c'è la velocità effettiva (o larghezza di banda) della rete, misurata in megabit al secondo (Mbps). Poiché le macchine virtuali sono ospitate su hardware condiviso, la capacità di rete deve essere condivisa equamente tra le macchine virtuali che condividono lo stesso hardware. Alle macchine virtuali di dimensioni maggiori viene allocata una larghezza di banda relativamente maggiore rispetto alle macchine virtuali più piccole.

La larghezza di banda di rete allocata a ogni macchina virtuale viene misurata in base al traffico in uscita (in uscita) dalla macchina virtuale. Tutto il traffico di rete che esce dalla macchina virtuale viene conteggiato per il limite allocato, indipendentemente dalla destinazione. Ad esempio, se una macchina virtuale ha un limite di 1.000 Mbps, questo limite si applica se il traffico in uscita è destinato a un'altra macchina virtuale nella stessa rete virtuale o al di fuori di Azure.

L'ingresso non viene misurato o limitato direttamente. Esistono tuttavia altri fattori, ad esempio limiti di CPU e archiviazione, che possono influire sulla capacità di una macchina virtuale di elaborare i dati in ingresso.

La rete accelerata è una funzione progettata per migliorare le prestazioni di rete, tra cui la latenza, la velocità effettiva e l'utilizzo della CPU. Anche se la rete accelerata può migliorare la velocità effettiva di una macchina virtuale, può farlo solo fino alla larghezza di banda allocata della macchina virtuale. Sono disponibili altre informazioni sulle rete accelerata per macchine virtuali Windows o Linux.

Le macchine virtuali di Azure devono avere una, ma potrebbero avere diverse interfacce di rete collegate. La larghezza di banda allocata a una macchina virtuale è la somma di tutto il traffico in uscita in tutte le interfacce di rete associate alla macchina virtuale. In altre parole, la larghezza di banda allocata è per macchina virtuale, indipendentemente dal numero di interfacce di rete collegate alla macchina virtuale. Per informazioni su quante interfacce di rete sono supportate dalle diverse dimensioni di macchina virtuale di Azure, vedere le dimensioni delle VM Windows e Linux di Azure.

Velocità effettiva della rete prevista

La velocità effettiva in uscita prevista e il numero di interfacce di rete supportati da ogni dimensione di VM sono descritti in dettaglio nelle informazioni sulle dimensioni delle VM Windows e Linux di Azure. Selezionare un tipo, ad esempio utilizzo generico, quindi selezionare dimensioni e serie nella pagina risultante, ad esempio la serie Dv2. Ciascuna serie dispone di una tabella con specifiche di rete nell'ultima colonna, denominata

Schede di interfaccia di rete max/prestazioni rete previste (Mbps).

Il limite di velocità effettiva si applica alla macchina virtuale. La velocità effettiva è influenzata dai fattori seguenti:

Numero di interfacce di rete: il limite di larghezza di banda è cumulativo per tutto il traffico in uscita dalla macchina virtuale.

Accelerazione di rete: la funzione può essere utile per ottenere il limite pubblicato, ma non modifica il limite.

Destinazione del traffico: tutte le destinazioni contano per il limite in uscita.

Protocollo: tutto il traffico in uscita su tutti i protocolli conta per il limite.

Limiti dei flussi di rete

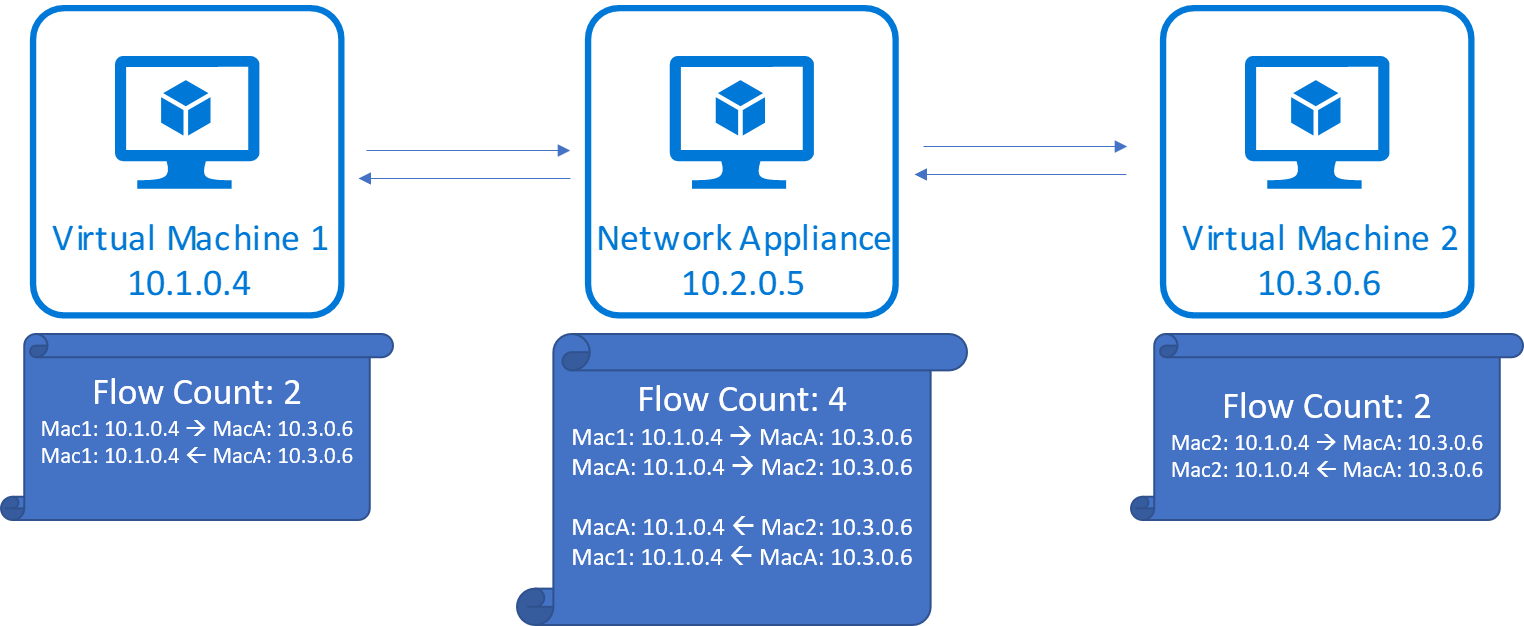

Il numero di connessioni di rete in una macchina virtuale in qualsiasi momento può influire sulle prestazioni della rete. Lo stack di rete di Azure usa strutture di dati denominate flussi per tenere traccia di ogni direzione di una connessione TCP/UDP. Per una connessione TCP/UDP tipica, crea due flussi: uno per il traffico in entrata e un altro per il traffico in uscita. Ogni flusso è costituito da un protocollo composto da protocollo, indirizzo IP locale, indirizzo IP remoto, porta locale e porta remota.

Il trasferimento dei dati tra gli endpoint richiede la creazione di diversi flussi, oltre a quelli che eseguono il trasferimento dei dati. Alcuni esempi sono i flussi creati per la risoluzione DNS e i flussi creati per le probe di integrità di bilanciamento del carico. Le appliance virtuali di rete (NVA), quali gateway, proxy e firewall, vedono i flussi creati per le connessioni terminate nell'appliance e originate dall'appliance stessa.

Limiti di flusso ed elementi consigliati sulle connessioni attive

Attualmente, lo stack di rete di Azure supporta almeno 500.000 connessioni totali (500.000 flussi in ingresso + 500.000 in uscita) per tutte le dimensioni delle macchine virtuali. Per le dimensioni più piccole (2-7 vCPU), raccomandiamo che il carico di lavoro utilizzi 100.000 o meno connessioni totali. I limiti di connessione consigliati variano in base al numero di vCPU della macchina virtuale e sono condivisi di seguito.

Dimensioni delle macchine virtuali di Azure Boost con MANA

| Dimensione della macchina virtuale (#vCPUs) | Limite di connessione consigliato |

|---|---|

| 2-7 | 100,000 |

| 8-15 | 500,000 |

| 16-31 | 700,000 |

| 32-63 | 800,000 |

| 64+ | 2,000,000 |

Altre dimensioni delle macchine virtuali

| Dimensioni della macchina virtuale (#vCPUs) | Limite di connessione consigliato |

|---|---|

| 2-7 | 100,000 |

| 8-15 | 500,000 |

| 16-31 | 700,000 |

| 32-63 | 800,000 |

| 64+ | 1,000,000 |

Le dimensioni delle macchine virtuali ottimizzate per la rete hanno migliorato le prestazioni di connessione di rete che differiscono dai limiti sopra indicati. Per informazioni sui limiti di connessione alle macchine virtuali ottimizzate per la rete, vedere l'articolo seguente

Al di sopra del limite consigliato, le connessioni possono essere eliminate o riscontrare prestazioni ridotte. Anche le velocità di creazione e terminazione delle connessioni possono influire sulle prestazioni di rete, poiché l'attivazione e la terminazione delle connessioni condividono il processore con le routine di elaborazione dei pacchetti. Si consiglia di eseguire un benchmark dei carichi di lavoro rispetto ai modelli di traffico previsti e di scalare i carichi di lavoro in modo appropriato per soddisfare le esigenze delle prestazioni. Microsoft ha rilasciato uno strumento per semplificare questa operazione, vedere Lo strumento NCPS per altri dettagli.

Si noti che le appliance virtuali di rete, ad esempio gateway, proxy, firewall e altre applicazioni che inoltrano il traffico devono usare metà dei limiti di connessione consigliati, perché l'inoltro del traffico utilizza il doppio del numero di flussi rispetto alla tipica comunicazione client-server.

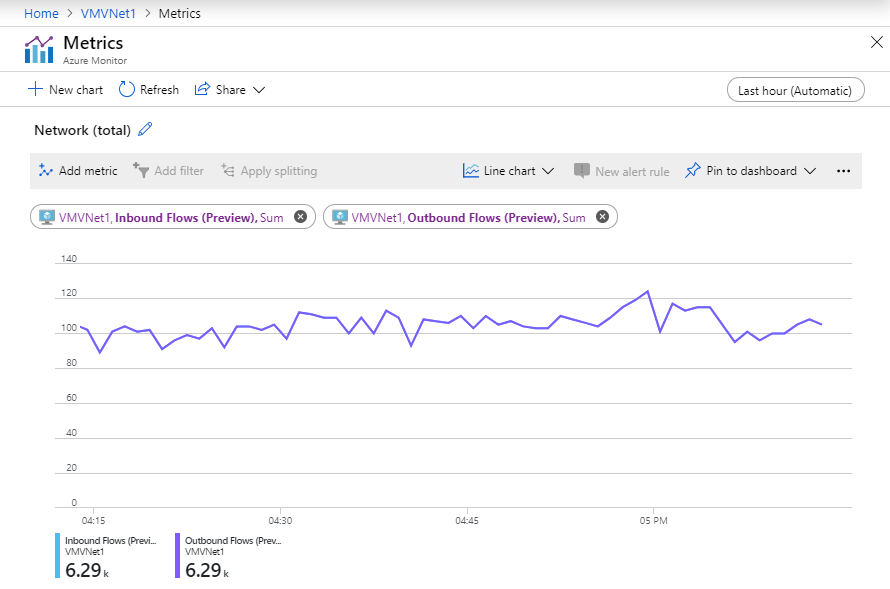

In Monitoraggio di Azure sono disponibili metriche per monitorare il numero di flussi di rete e la velocità di creazione dei flussi sulle istanze delle macchine virtuali o degli esempi dei set di scalabilità di macchine virtuali. È possibile che il numero di flussi rilevati dal sistema operativo guest della macchina virtuale sia diverso dal numero di flussi monitorati dallo stack di rete di Azure per vari motivi. Per assicurarti che le connessioni di rete non vengano interrotte, utilizza la metrica Flussi in entrata e in uscita.