Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

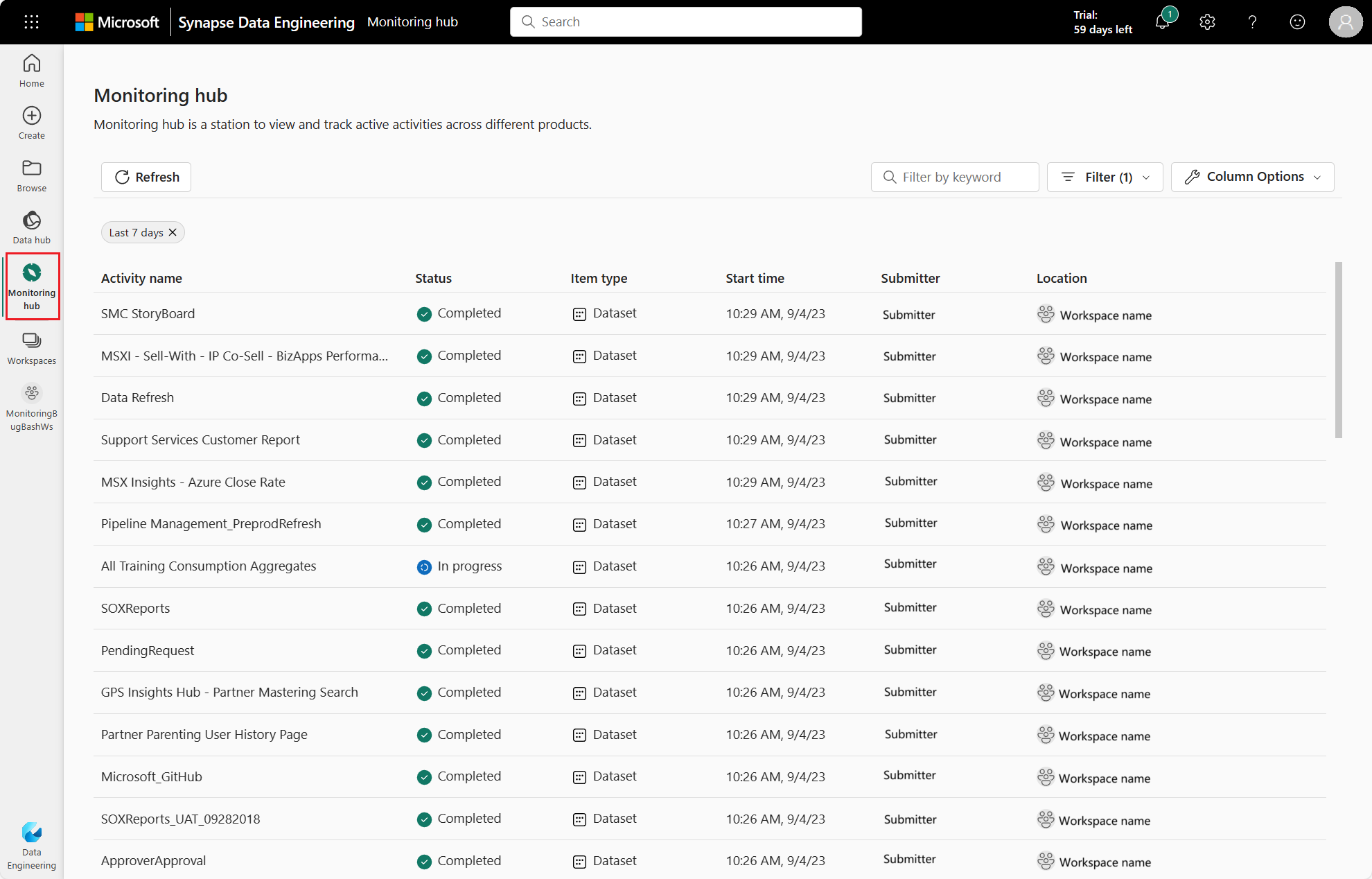

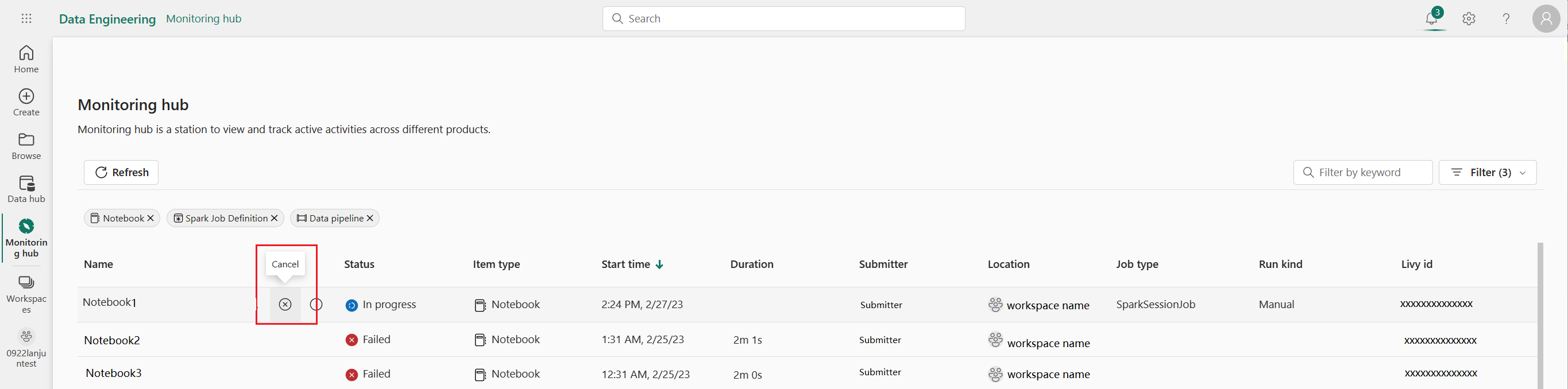

Il riquadro Monitoraggio funge da portale centralizzato per l'esplorazione delle attività di Apache Spark tra gli elementi. Quando ci si trova in Ingegneria dei dati o Data Science, è possibile visualizzare le applicazioni Apache Spark in corso innescate da notebook, definizioni dei processi Apache Spark e pipeline. È anche possibile cercare e filtrare le applicazioni Apache Spark in base a criteri diversi. È anche possibile annullare le applicazioni Apache Spark in corso ed eseguire il drill-down per visualizzare altri dettagli di esecuzione di un'applicazione Apache Spark.

Accedere al riquadro del Monitor

È possibile accedere al riquadro Monitoraggio per visualizzare varie attività di Apache Spark selezionando Monitoraggio dalla barra di navigazione.

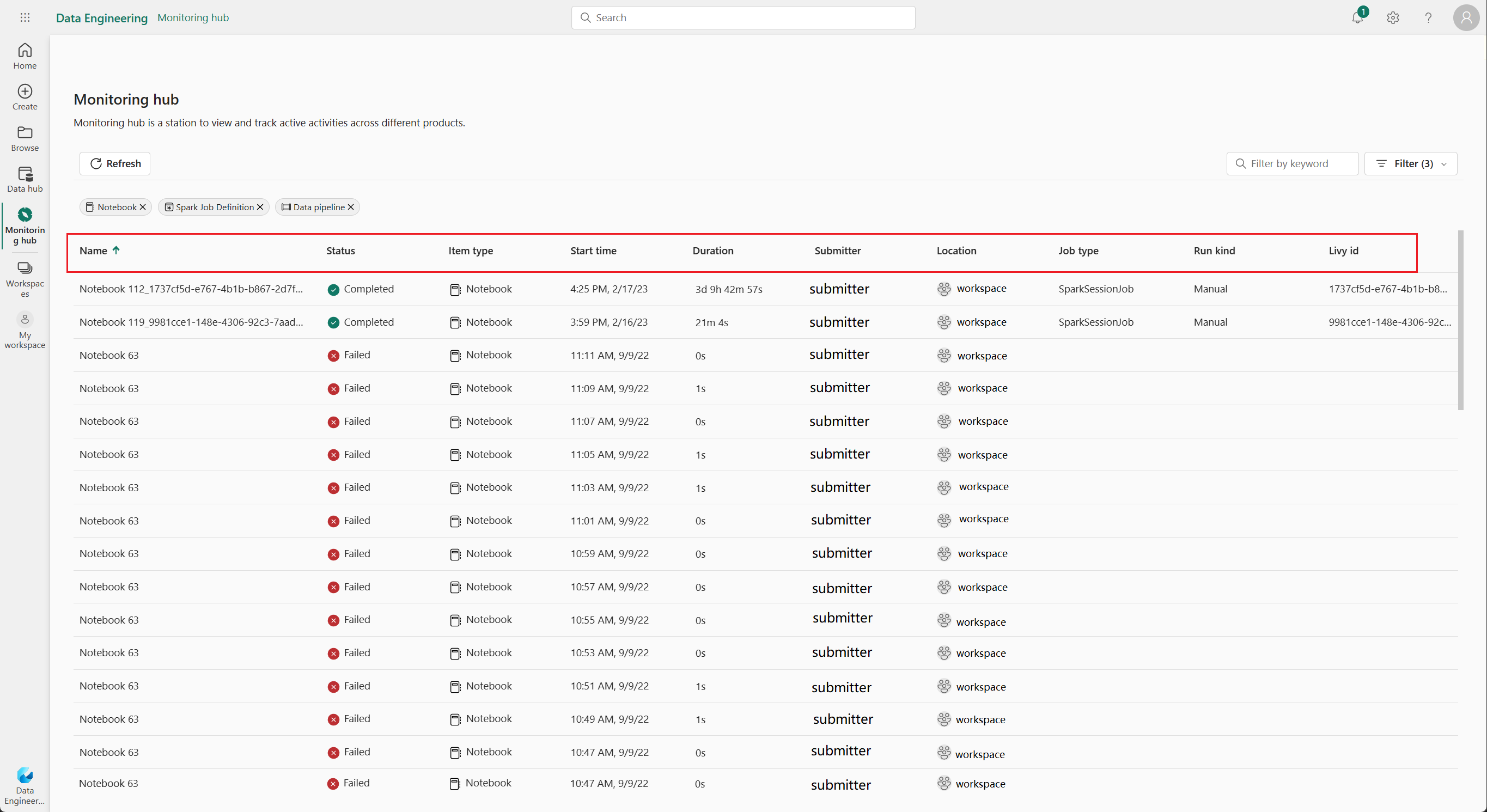

Opzioni di ordinamento, ricerca, filtro e colonna di applicazioni Apache Spark

Per migliorare l'utilizzabilità e l'individuabilità, è possibile ordinare le applicazioni Apache Spark selezionando colonne diverse nell'interfaccia utente. È anche possibile filtrare le applicazioni in base a colonne diverse e cercare applicazioni specifiche. È anche possibile adattare la visualizzazione e l'ordinamento delle colonne in modo indipendente tramite le opzioni di colonna.

Ordinare le applicazioni Apache Spark

Per ordinare le applicazioni Apache Spark, è possibile selezionare ogni intestazione di colonna, come Nome, Stato, Tipo di elemento, Ora di inizio, Posizione e così via.

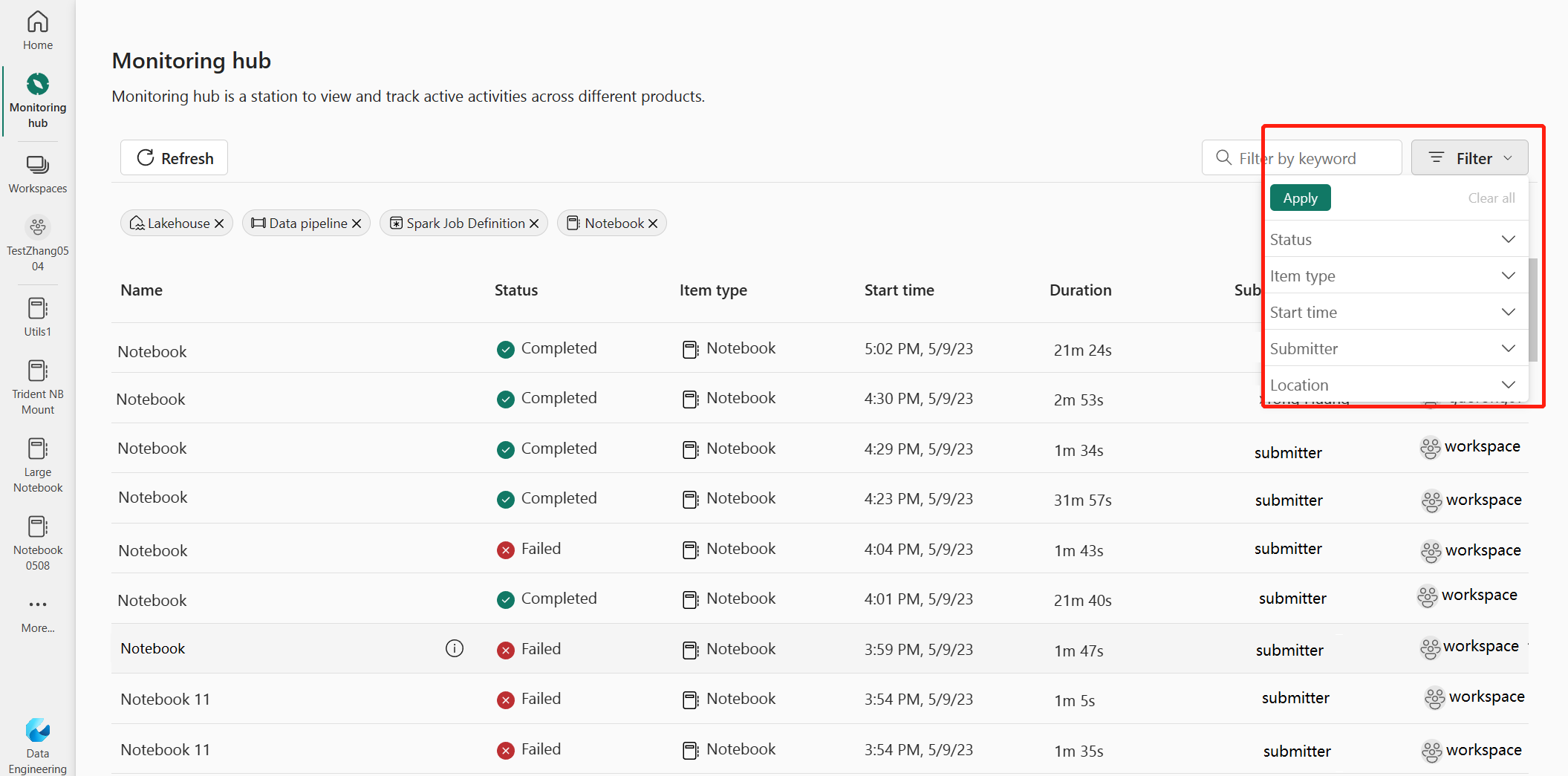

Filtrare le applicazioni Apache Spark

È possibile filtrare le applicazioni Apache Spark in base a Stato, Tipo di elemento, Ora di inizio, Autore invio e Posizione utilizzando il riquadro Filtro nell'angolo in alto a destra.

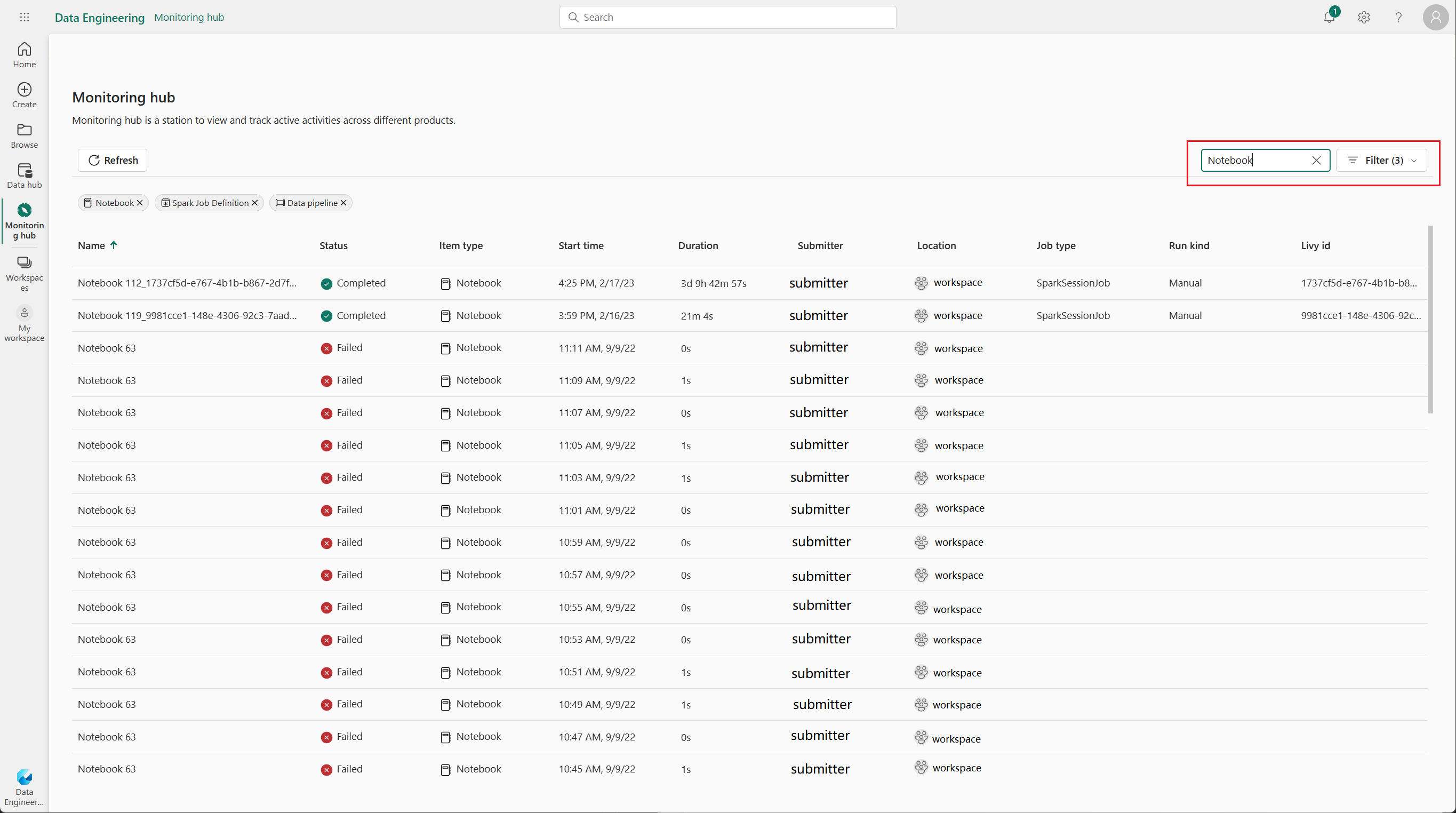

Cercare le applicazioni Apache Spark

Per cercare applicazioni Apache Spark specifiche, è possibile digitare determinate parole chiave nella casella di ricerca nell'angolo in alto a destra.

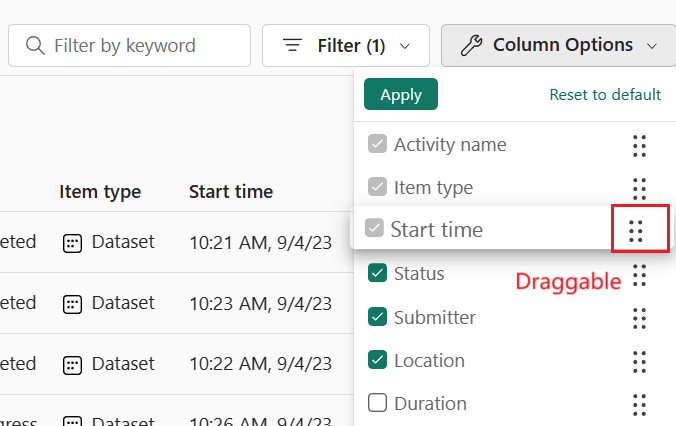

Opzioni di colonna per applicazioni Apache Spark

È possibile modificare l'ordine in cui vengono visualizzati gli elenchi selezionando l'elenco da visualizzare e quindi trascinando le opzioni dell'elenco.

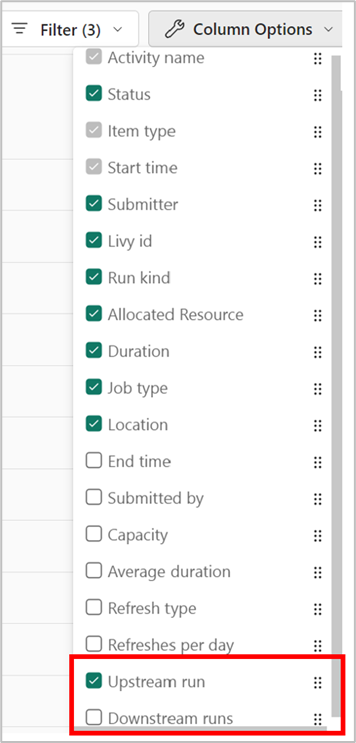

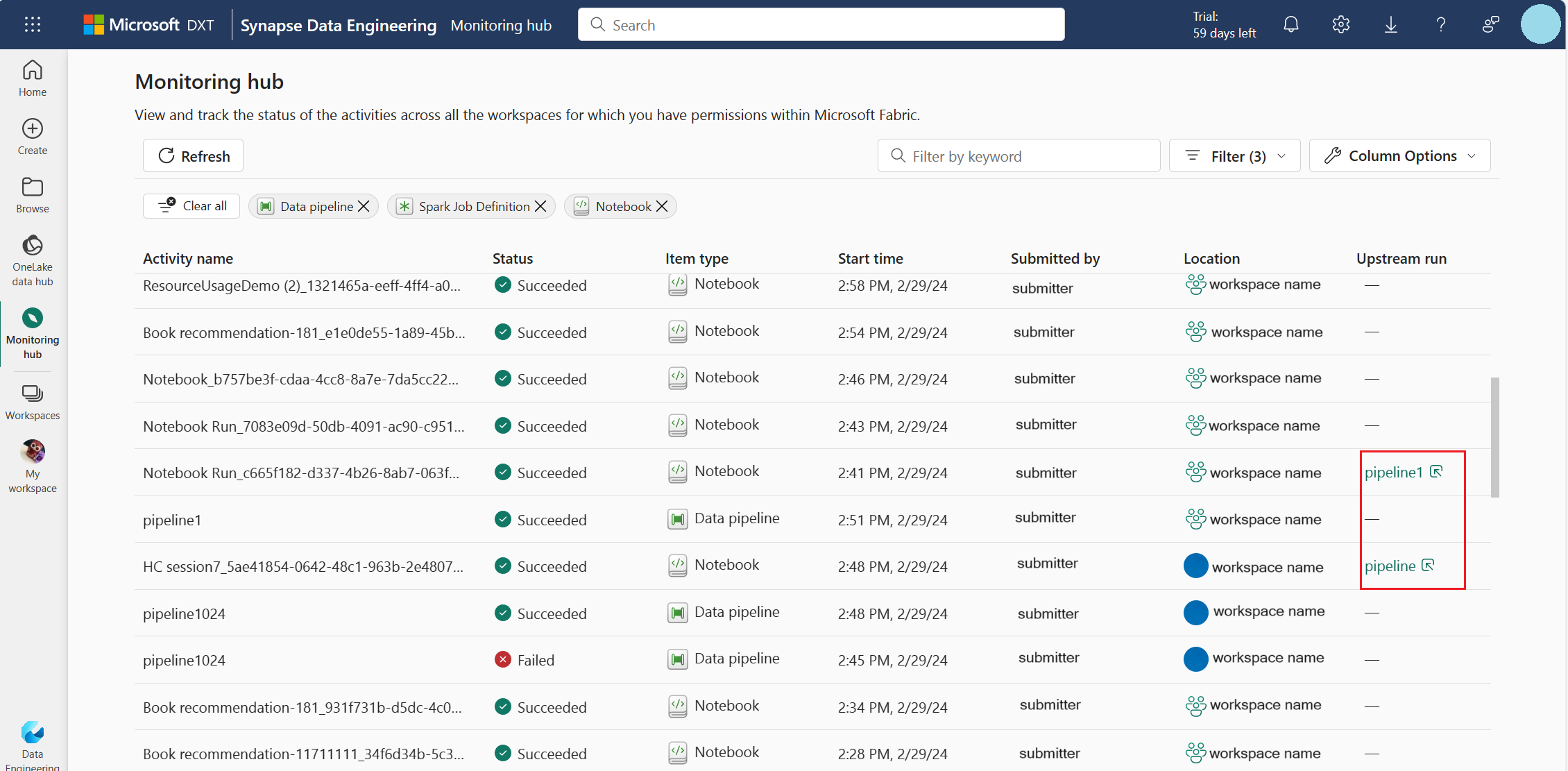

Abilitare la visualizzazione upstream per le pipeline correlate

Se sono state pianificate definizioni di notebook e processi Spark da eseguire nelle pipeline, è possibile visualizzare le attività Spark da questi notebook e definizioni di processi Spark nel riquadro Monitoraggio. Inoltre, è anche possibile visualizzare la pipeline padre corrispondente e tutte le relative attività nel riquadro Monitoraggio.

Selezionare l'opzione della colonna Esecuzione upstream.

Visualizzare l'esecuzione della pipeline padre correlata nella colonna Esecuzione upstream e fare clic sull'esecuzione della pipeline per visualizzare tutte le sue attività.

Gestire un'applicazione Apache Spark

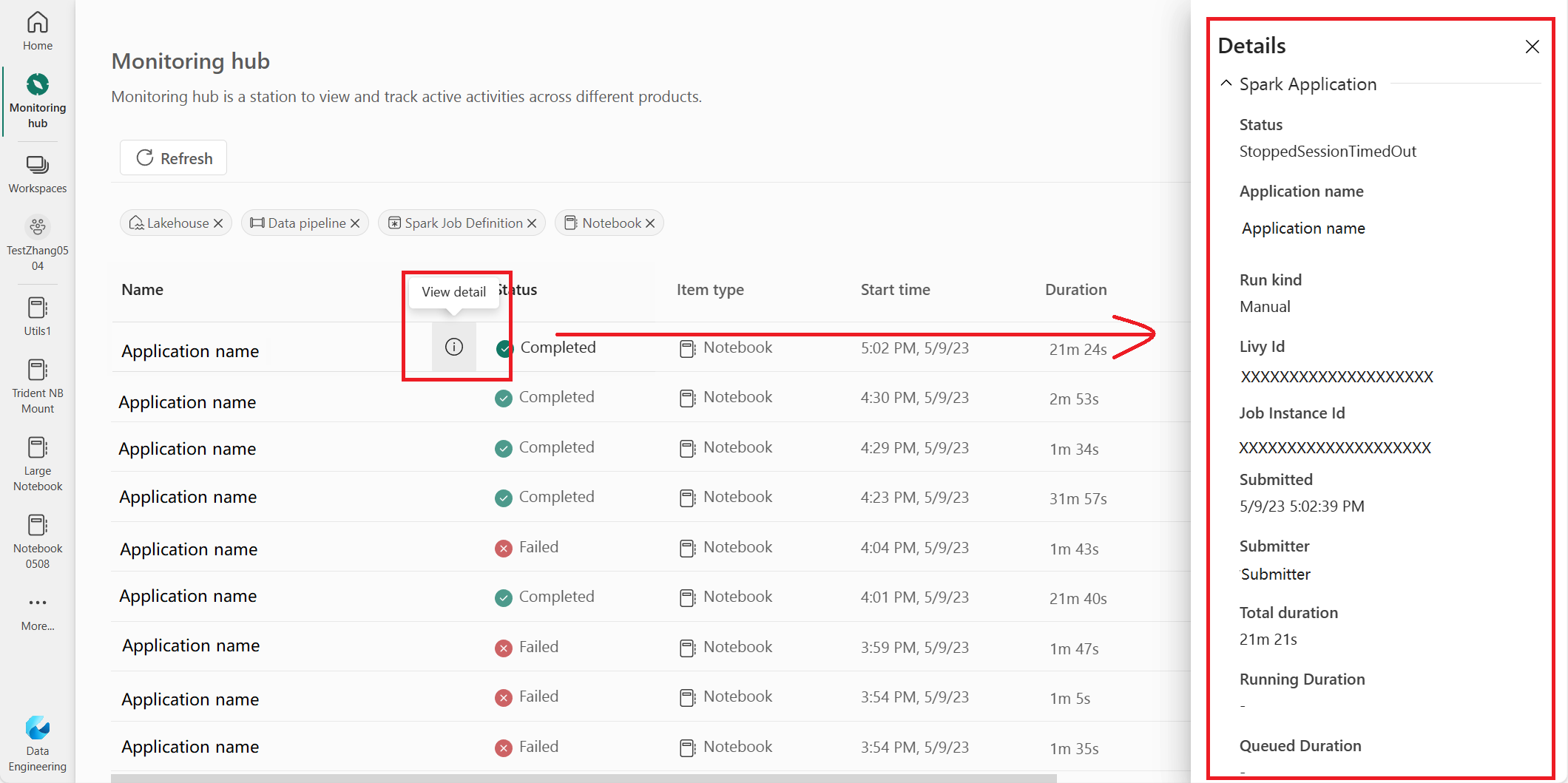

Quando si passa il puntatore del mouse su una riga dell'applicazione Apach Spark, è possibile vedere varie azioni a livello di riga che consentono di gestire una particolare applicazione Apache Spark.

Visualizzare il riquadro Dettagli dell'applicazione Apache Spark

È possibile passare il puntatore del mouse su una riga dell'applicazione Apache Spark e fare clic sull'icona Visualizza dettagli per aprire il riquadro Dettagli e visualizzare altri dettagli su un'applicazione Apache Spark.

Annullare un'applicazione Apache Spark

Se è necessario annullare un'applicazione Apache Spark in corso, passare il puntatore del mouse sulla riga e fare clic sull'icona Annulla.

Passare alla visualizzazione dettagli dell'applicazione Apache Spark

Se sono necessarie altre informazioni sulle statistiche di esecuzione di Apache Spark, accedere ai log di Apache Spark o controllare i dati di input e output; è possibile fare clic sul nome di un'applicazione Apache Spark per andare sulla corrispondente pagina dei dettagli dell'applicazione Apache Spark.