Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Un ambiente Microsoft Fabric è un elemento consolidato per tutte le impostazioni hardware e software. In un ambiente è possibile selezionare runtime Spark diversi, configurare le risorse di calcolo, installare librerie da repository pubblici o una directory locale e impostare altre impostazioni.

Questo articolo presenta una panoramica di come creare, configurare e usare un ambiente.

Crea un ambiente

È possibile creare nuovi ambienti da più punti di ingresso:

Punto di ingresso standard:

In Fabric, passare all'area di lavoro desiderata.

Selezionare Nuovo elemento e individuare Ambiente.

Assegnare un nome all'ambiente e selezionare Crea.

Crea durante la selezione:

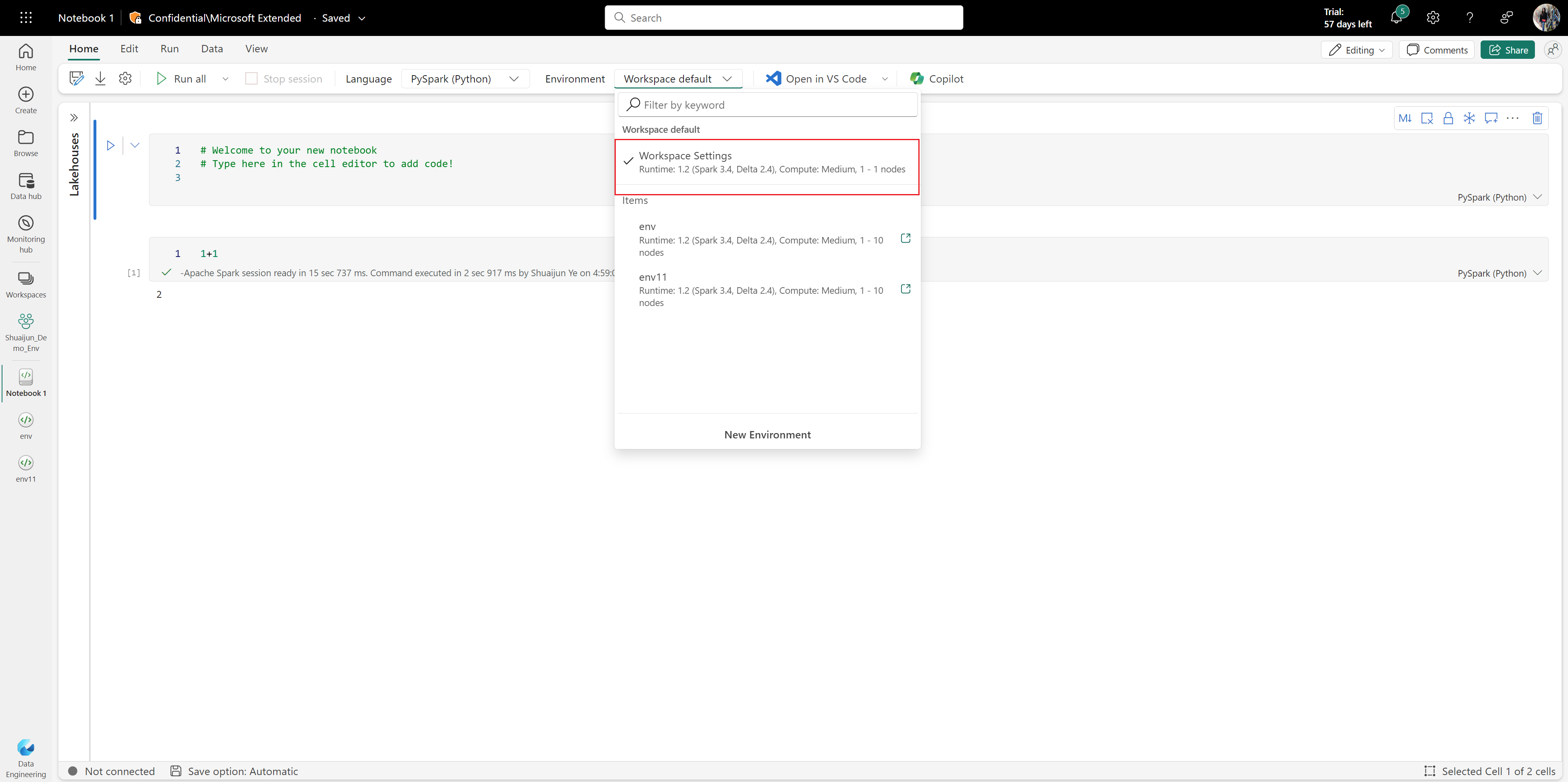

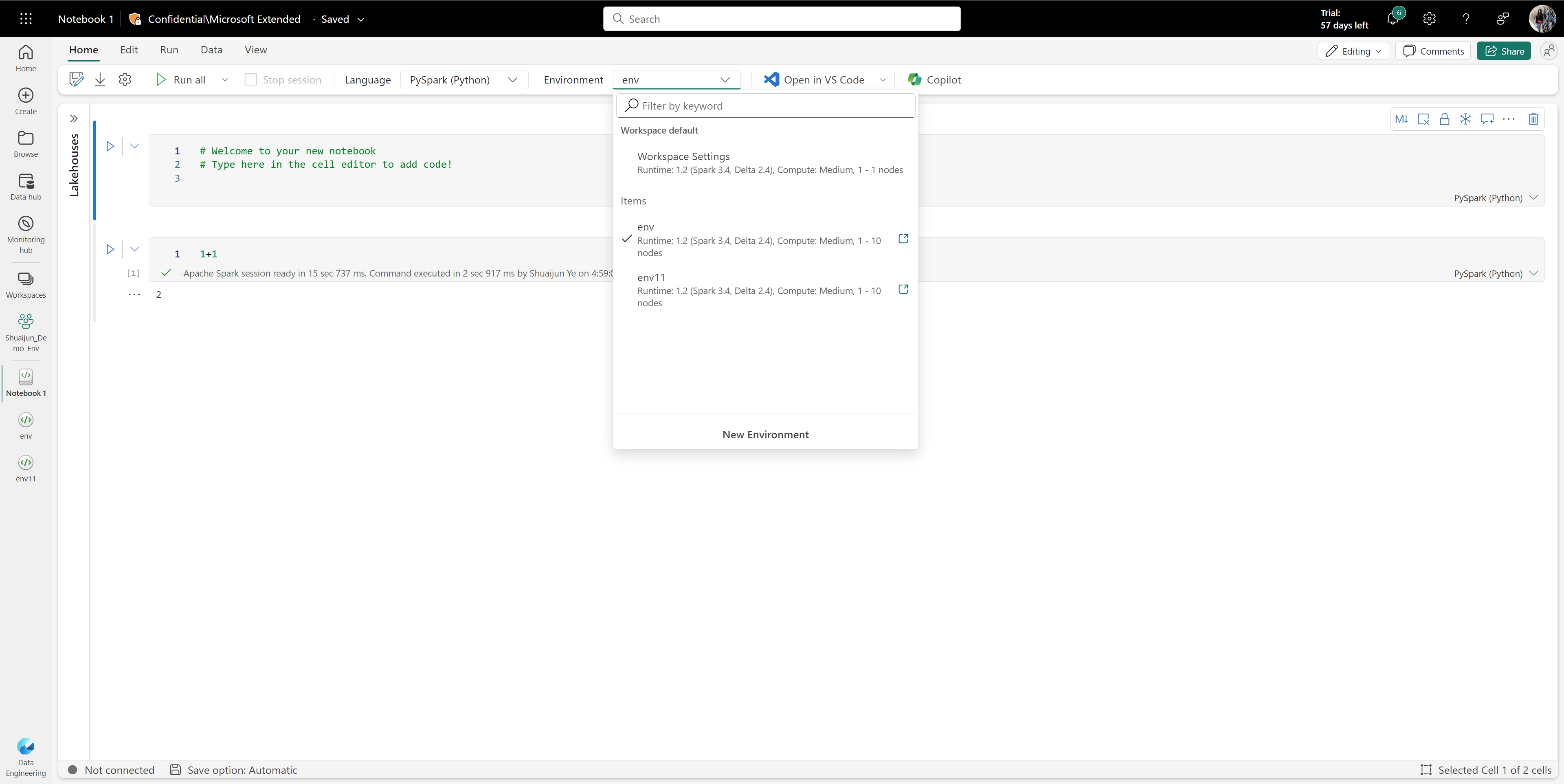

Aprire un notebook o una definizione di processo Spark.

Selezionare l'elenco a discesa Ambiente e quindi Selezionare Nuovo ambiente.

Assegnare un nome all'ambiente e selezionare Crea.

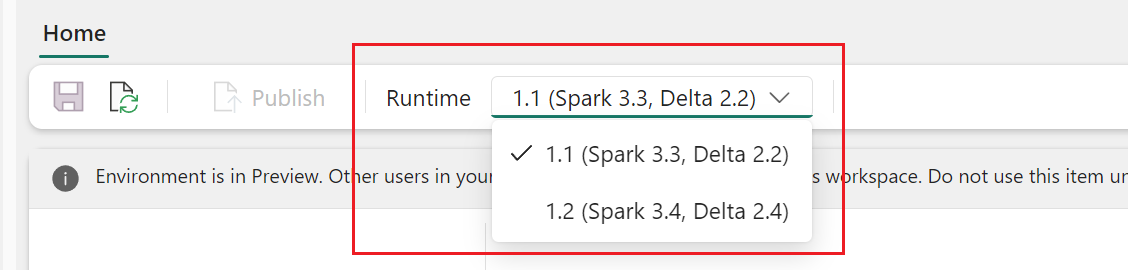

Dopo aver creato l'ambiente, selezionare la versione di runtime. Scegliere Runtime 1.3 (Spark 3.5, Delta 3.2) dal menu a discesa.

Configurare un ambiente

Un ambiente ha tre componenti principali:

- Calcolo Spark, che include il runtime di Spark.

- Biblioteche.

- Risorse.

Le configurazioni di calcolo e libreria Spark sono necessarie per rendere effettiva la pubblicazione. Le risorse sono risorse di archiviazione condivise che possono cambiare in tempo reale. Per altre informazioni, vedere Salvare e pubblicare le modifiche.

Configurare il calcolo Spark

Per un ambiente, è possibile scegliere tra vari runtime di Spark con le proprie impostazioni predefinite e pacchetti preinstallati. Per visualizzare i runtime disponibili, passare alla scheda Home dell'ambiente e selezionare Runtime. Scegliere il runtime più adatto alle esigenze.

Important

- Se si aggiorna il runtime di un ambiente con configurazioni o librerie esistenti, è necessario ripubblicare il contenuto in base alla versione di runtime aggiornata.

- Se le configurazioni o le librerie esistenti non sono compatibili con la versione di runtime appena aggiornata, la pubblicazione non riesce. È necessario rimuovere le configurazioni o le librerie incompatibili e pubblicare nuovamente l'ambiente.

L'ambiente di calcolo Spark di Fabric offre velocità e efficienza senza precedenti in esecuzione in Spark ed esperienze personalizzate sui requisiti. Nell'ambiente, è possibile scegliere tra vari pool creati dagli amministratori dell'area di lavoro e da amministratori della capacità. È possibile modificare ulteriormente le configurazioni e gestire le proprietà di Spark in modo tale che siano efficaci nelle sessioni Spark. Per altre informazioni, vedere Impostazioni di configurazione del calcolo Spark in ambienti Fabric.

Gestire le librerie

Ogni runtime di Spark offre librerie predefinite. Con l'ambiente Fabric è anche possibile installare librerie da origini pubbliche o caricare librerie personalizzate create dall'utente o dall'organizzazione. Dopo aver installato correttamente le librerie, queste sono disponibili nelle sessioni di Spark. Per altre informazioni, vedere Gestione delle librerie negli ambienti di Fabric. Per le procedure consigliate per la gestione delle librerie in Infrastruttura, vedere Gestire le librerie Apache Spark in Fabric.

Usare le risorse

La sezione Risorse in un ambiente facilita la possibilità di gestire piccole risorse durante la fase di sviluppo. I file caricati nell'ambiente sono accessibili tra notebook quando sono collegati. Per altre informazioni, vedere Gestire le risorse in un ambiente di infrastruttura.

Salva e pubblica le modifiche

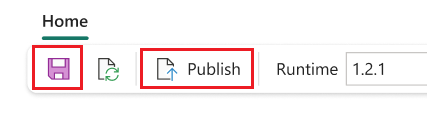

Nella scheda Home è possibile trovare facilmente Salva e pubblica. Vengono attivati quando sono presenti modifiche non salvate o non pubblicate in sospeso nelle sezioni Librerie e calcolo Spark .

Important

- Se il collegamento privato è abilitato, il primo processo Spark nell'area di lavoro deve attivare il provisioning della rete virtuale, che può richiedere circa 10-15 minuti. Poiché la pubblicazione dell'ambiente viene eseguita anche come processo Spark, potrebbe verificarsi un ritardo aggiuntivo se si verifica il primo processo Spark eseguito dopo l'abilitazione del collegamento privato.

Quando le modifiche in sospeso si trovano nelle sezioni Librerie e calcolo Spark , viene visualizzato anche un banner che richiede il salvataggio e la pubblicazione. Le funzionalità sono le stesse dei pulsanti:

- Le modifiche non salvate vengono perse se si aggiorna o si lascia aperto il browser. Selezionare Salva per assicurarsi che le modifiche vengano registrate prima di uscire. Il salvataggio non applica la configurazione, ma memorizza nella cache le modifiche nel sistema.

- Per applicare le modifiche alle librerie e all'ambiente di calcolo Spark, selezionarePubblica. La pagina Modifiche in sospeso viene visualizzata per la revisione finale prima della pubblicazione. Selezionare quindi Pubblica tutto per avviare la configurazione nell'ambiente Infrastruttura. Questo processo potrebbe richiedere del tempo, soprattutto se sono coinvolte modifiche alla libreria.

- Per annullare un processo di pubblicazione, selezionare Visualizza stato nel banner e annullare l'operazione.

- Al completamento della pubblicazione, appare una notifica. Se si verificano problemi durante il processo, si verifica una notifica di errore.

Un ambiente accetta una sola azione di pubblicazione alla volta. Non è possibile apportare modifiche alle sezioni dicalcolo Librerie o Spark durante un'azione di pubblicazione in corso.

La pubblicazione non influisce sull'aggiunta, l'eliminazione o la modifica dei file e delle cartelle nella sezione Risorse . Le azioni per gestire le risorse sono in tempo reale. L'azione Pubblica non blocca le modifiche nella sezione Risorse .

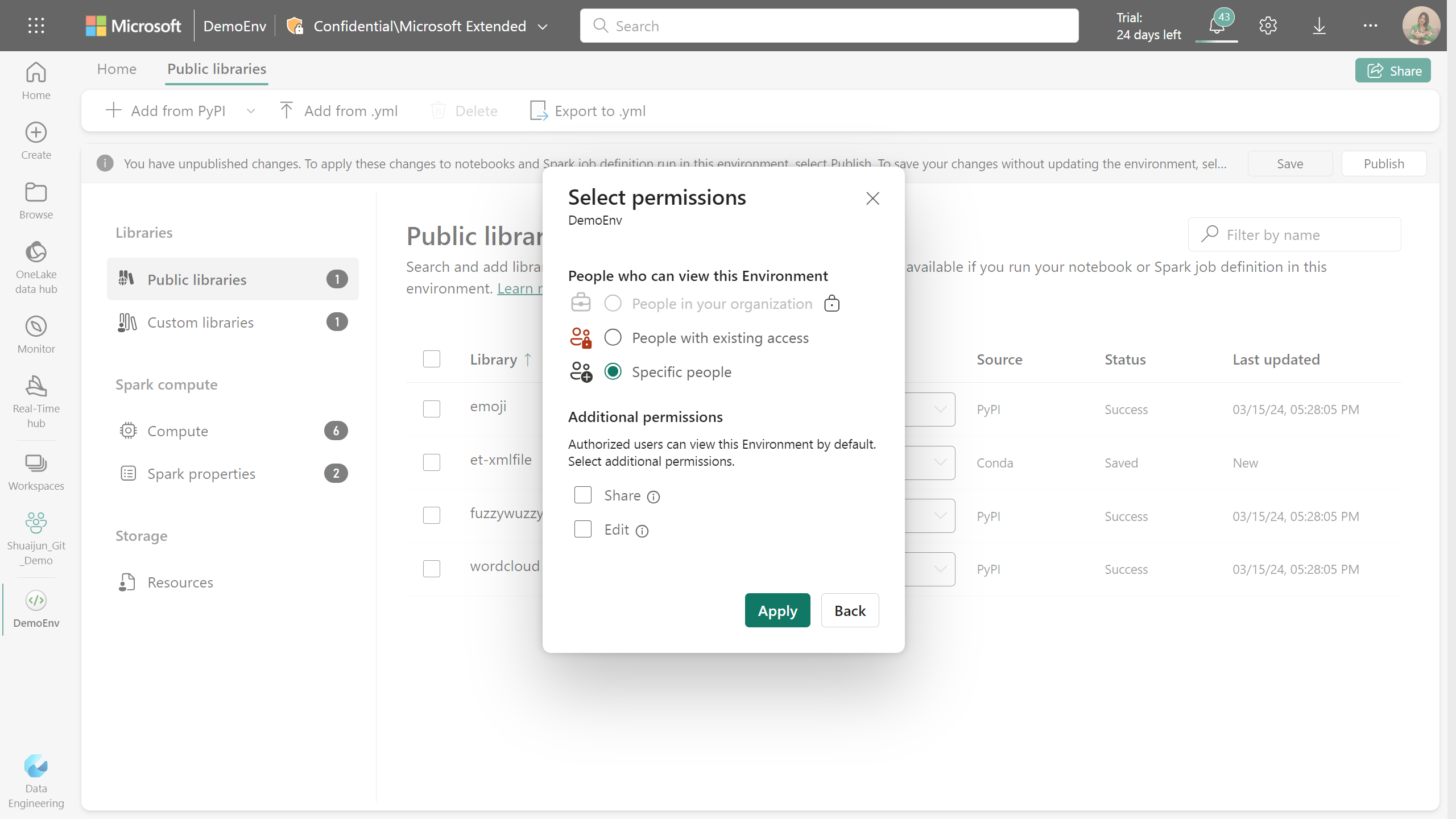

Condividere un ambiente esistente

Fabric supporta la condivisione di un elemento con diversi livelli di autorizzazioni.

Quando si condivide un elemento di ambiente, i destinatari ricevono automaticamente l'autorizzazione lettura. Con questa autorizzazione, possono esplorare le configurazioni dell'ambiente e collegarla ai notebook o ai processi Spark. Per un'esecuzione uniforme del codice, assicurarsi di concedere le autorizzazioni di lettura per gli ambienti collegati quando si condividono notebook e definizioni di processi Spark.

È anche possibile condividere l'ambiente con le autorizzazioni Condividi e Modifica. Gli utenti con autorizzazione condividi possono continuare a condividere l'ambiente con altri utenti. Nel frattempo, i destinatari con autorizzazione Modifica possono aggiornare il contenuto dell'ambiente.

Collegare un ambiente

È possibile collegare un ambiente fabric alle aree di lavoro Ingegneria dati/Scienza o ai notebook e alle definizioni dei processi Spark.

Collegare un ambiente come impostazione predefinita dell'area di lavoro

Important

Dopo aver selezionato un ambiente come impostazione predefinita dell'area di lavoro, solo gli amministratori dell'area di lavoro possono aggiornare il contenuto dell'ambiente predefinito.

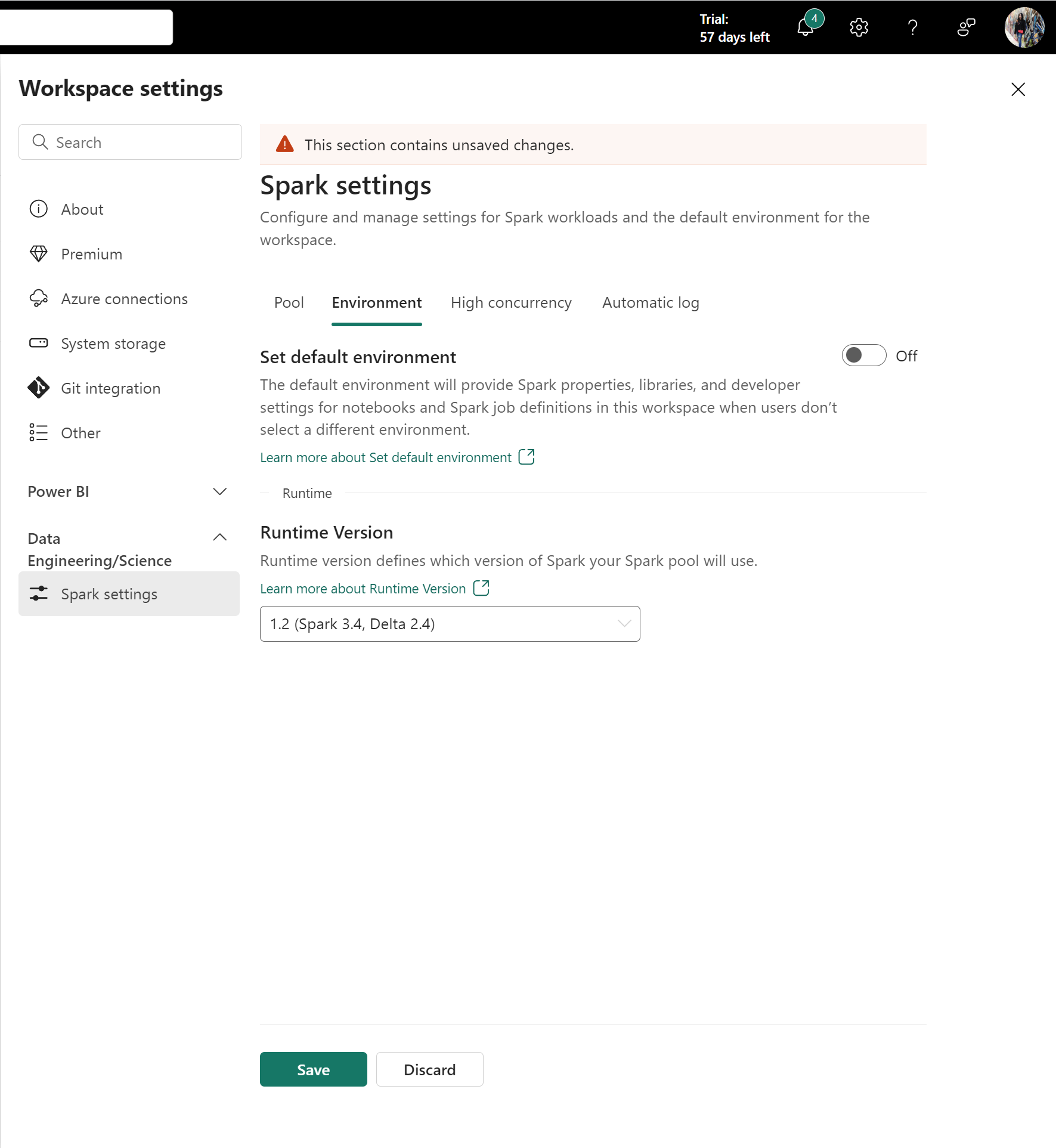

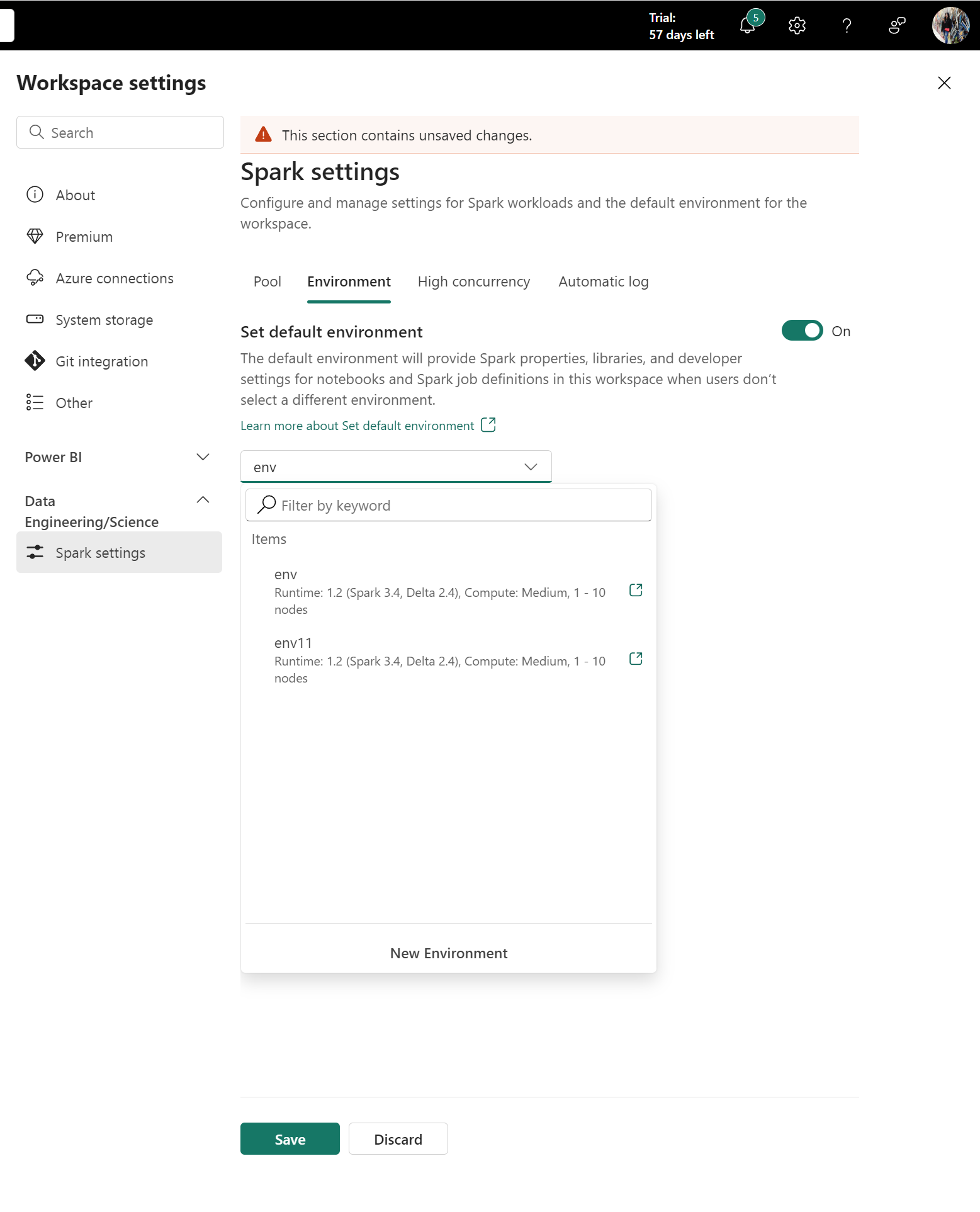

Selezionare Impostazioni area di lavoroData Engineering/Science> (Impostazioni di > Spark) per visualizzare la scheda Ambiente.

Gli amministratori dell'area di lavoro possono definire il carico di lavoro predefinito per intere aree di lavoro. I valori configurati qui sono effettivi per i notebook e le definizioni dei processi Spark che si collegano alle impostazioni dell'area di lavoro.

L'opzione Imposta ambiente predefinito può migliorare l'esperienza utente. Per impostazione predefinita, questa opzione è impostata su Off. Se non è richiesta alcuna proprietà o libreria Spark predefinita come impostazione predefinita dell'area di lavoro, è possibile definire il runtime di Spark in questa circostanza. Se si vuole preparare un ambiente di calcolo e librerie Spark predefinito per l'area di lavoro, è possibile impostare l'interruttore su Sì e collegare facilmente un ambiente come impostazione predefinita dell'area di lavoro. Questa opzione rende effettive tutte le configurazioni nell'ambiente come Impostazioni dell'area di lavoro.

Collegare un ambiente a un notebook o a una definizione di un lavoro Spark

L'ambiente è disponibile nelle schede Notebook e Spark Job Definition (Definizione processo Spark ). Quando i notebook e le definizioni dei processi Spark sono collegati a un ambiente, possono accedere alle librerie, alle configurazioni di calcolo e alle risorse. Esplora risorse elenca tutti gli ambienti disponibili condivisi con l'utente, provengono dall'area di lavoro corrente e provengono da altre aree di lavoro a cui si ha accesso.

Se si passa a un ambiente diverso durante una sessione attiva, l'ambiente appena selezionato non avrà effetto fino alla sessione successiva.

Quando si collega un ambiente da un'altra area di lavoro, entrambe le aree di lavoro devono avere le stesse impostazioni di capacità e sicurezza di rete. Sebbene sia possibile selezionare gli ambienti dalle aree di lavoro con capacità diverse o impostazioni di sicurezza di rete, la sessione non viene avviata.

Quando si collega un ambiente da un'altra area di lavoro, la configurazione di calcolo in tale ambiente viene ignorata. Per impostazione predefinita, le configurazioni di pool e calcolo sono le impostazioni dell'area di lavoro corrente.

Eliminare un ambiente

È possibile eliminare un ambiente quando non è più necessario. Prima di eliminare un ambiente, considerare quanto segue:

Important

- L'eliminazione di un ambiente è permanente e non può essere annullata.

- Tutti i notebook o le definizioni dei processi Spark attualmente collegati all'ambiente dovranno essere riconfigurati per l'uso di un ambiente o di impostazioni dell'area di lavoro diverse.

- Se l'ambiente è impostato come predefinito per l'area di lavoro, è prima necessario modificare l'impostazione predefinita dell'area di lavoro prima dell'eliminazione.

Eliminare un ambiente usando l'API REST

È possibile eliminare un ambiente a livello di codice usando l'API REST dell'infrastruttura:

Endpoint:DELETE https://api.fabric.microsoft.com/v1/workspaces/{workspaceId}/environments/{environmentId}

Autorizzazioni necessarie: Environment.ReadWrite.All o Item.ReadWrite.All

Per altre informazioni sull'API REST, vedere Eliminare l'ambiente.