Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Annotazioni

Fabric Runtime 2.0 è attualmente in fase di anteprima sperimentale. Per altre informazioni, vedere le limitazioni e le note.

Fabric Runtime offre una perfetta integrazione all'interno dell'ecosistema Microsoft Fabric, offrendo un ambiente affidabile per progetti di data engineering e data science basati su Apache Spark.

Questo articolo presenta Fabric Runtime 2.0 Experimental (Preview), il runtime più recente progettato per i calcoli di Big Data in Microsoft Fabric. Evidenzia le funzionalità e i componenti chiave che rendono questa versione un passo avanti significativo per l'analisi scalabile e i carichi di lavoro avanzati.

Fabric Runtime 2.0 incorpora i componenti e gli aggiornamenti seguenti progettati per migliorare le funzionalità di elaborazione dei dati:

- Apache Spark 4.0

- Sistema operativo: Azure Linux 3.0 (Mariner 3.0)

- Java: 21

- Scala: 2.13

- Python: 3.12

- Delta Lake: 4.0

Abilitare Runtime 2.0

È possibile abilitare Runtime 2.0 a livello di area di lavoro o di elemento dell'ambiente. Usare l'impostazione dell'area di lavoro per applicare Runtime 2.0 come impostazione predefinita per tutti i carichi di lavoro Spark nell'area di lavoro. In alternativa, creare un elemento Ambiente con Runtime 2.0 da utilizzare con notebook specifici o definizioni dei lavori Spark, sostituendo l'impostazione predefinita dell'area di lavoro.

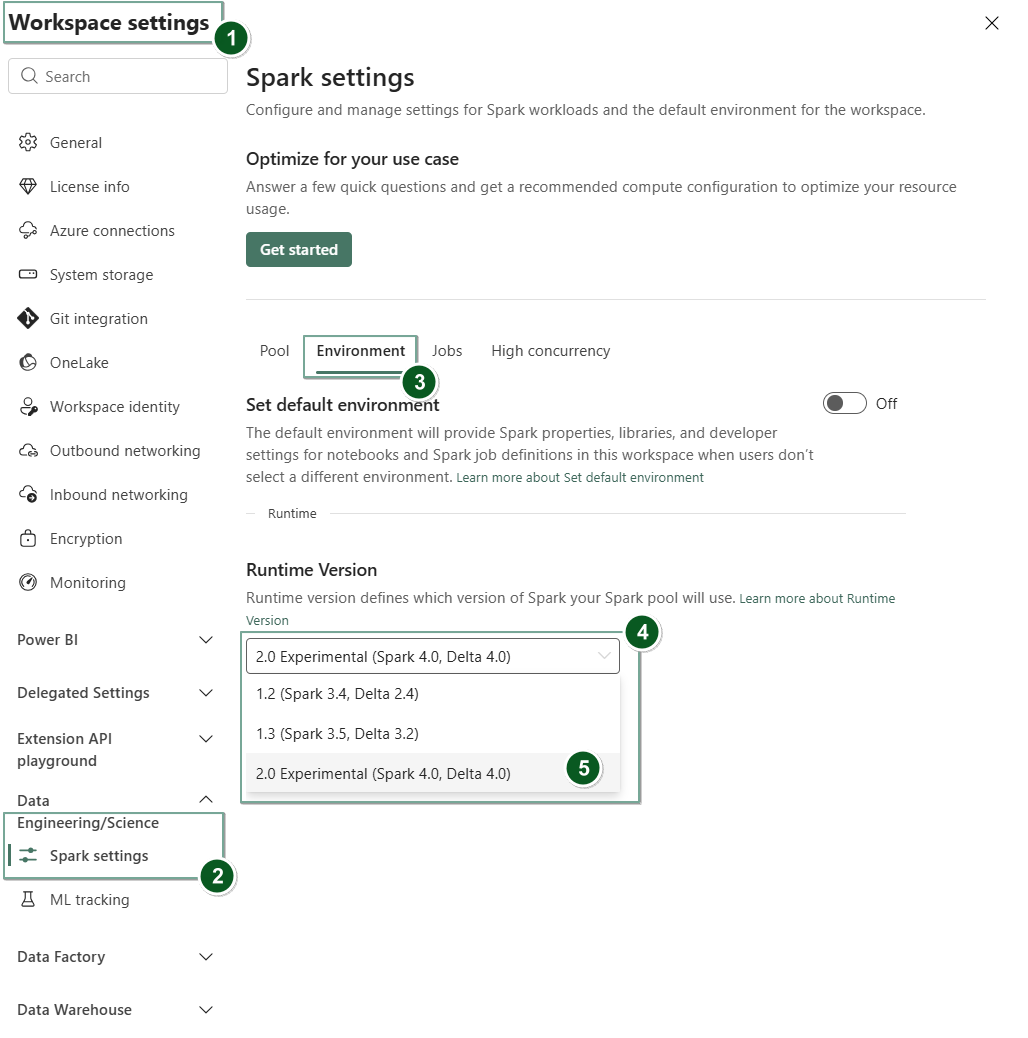

Abilitare Runtime 2.0 nelle impostazioni dell'area di lavoro

Per impostare Runtime 2.0 come predefinito per l'intera area di lavoro:

Passare alla scheda Impostazioni area di lavoro all'interno dell'area di lavoro di Fabric.

Passare alla scheda Ingegneria dati/Scienza e selezionare Impostazioni Spark.

Fare clic sulla scheda Ambiente.

Nell'elenco a discesa Versione runtime selezionare 2.0 Sperimentale (Spark 4.0, Delta 4.0) e salvare le modifiche. Questa azione imposta Runtime 2.0 come runtime predefinito per l'area di lavoro.

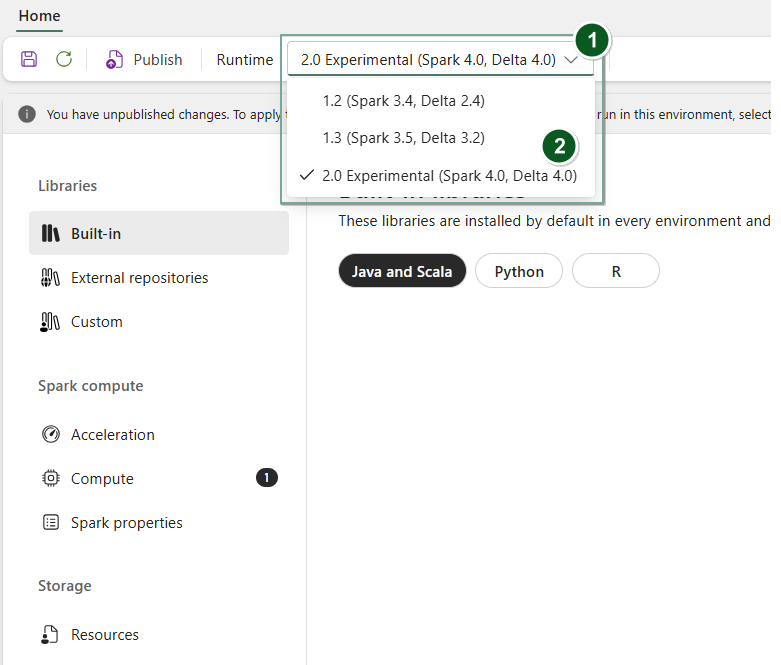

Abilitare Runtime 2.0 in un elemento Ambiente

Per utilizzare Runtime 2.0 con notebook specifici o definizioni di job Spark:

Creare un nuovo elemento Environment o aprirne uno esistente.

Nell'elenco a discesa Runtime selezionare 2.0 Experimental (Spark 4.0, Delta 4.0)

SaveePublishle modifiche apportate.Importante

L'avvio delle sessioni spark 2.0 può richiedere circa 2-5 minuti, perché i pool di avvio non fanno parte della versione sperimentale anticipata.

A questo punto, è possibile usare questo elemento Environment con

NotebookoSpark Job Definition.

È ora possibile iniziare a sperimentare i miglioramenti e le funzionalità più recenti introdotti in Fabric Runtime 2.0 (Spark 4.0 e Delta Lake 4.0).

Anteprima pubblica sperimentale

La fase di anteprima sperimentale del runtime di Fabric 2.0 offre l'accesso anticipato alle nuove funzionalità e API sia da Spark 4.0 che da Delta Lake 4.0. L'anteprima consente di usare immediatamente i miglioramenti basati su Spark più recenti, assicurando una corretta preparazione e transizione per le modifiche future, ad esempio le versioni più recenti di Java, Scala e Python.

Suggerimento

Per informazioni aggiornate, un elenco dettagliato delle modifiche e le note sulla versione specifiche per i runtime di Fabric, controllare e sottoscrivere Release e aggiornamenti dei runtime di Spark.

Limitazioni e note

Fabric Runtime 2.0 è attualmente in una fase di anteprima pubblica sperimentale, progettata per consentire agli utenti di esplorare ed sperimentare le funzionalità e le API più recenti di Spark e Delta Lake negli ambienti di sviluppo o test. Sebbene questa versione offra l'accesso alle funzionalità di base, esistono alcune limitazioni:

È possibile usare sessioni Spark 4.0, scrivere codice nei notebook, pianificare le definizioni dei processi Spark e usare con PySpark, Scala e Spark SQL. Tuttavia, il linguaggio R non è supportato in questa versione anticipata.

È possibile installare le librerie direttamente nel codice con pip e conda. È possibile impostare le impostazioni di Spark tramite le opzioni di %%configure nei notebook e nelle definizioni dei processi Spark .You can set Spark settings via the %%configure options in notebooks and Spark Job Definitions (SJDs).

È possibile leggere e scrivere in Lakehouse con Delta Lake 4.0, ma alcune funzionalità avanzate, ad esempio V-order, scrittura Parquet nativa, autocompattazione, ottimizzazione della scrittura, unione a basso shuffle, unione, evoluzione dello schema e viaggio nel tempo non sono incluse in questa versione anticipata.

Spark Advisor non è attualmente disponibile. Tuttavia, gli strumenti di monitoraggio, ad esempio l'interfaccia utente di Spark e i log, sono supportati in questa versione anticipata.

Le funzionalità come le integrazioni di data science, tra cui Copilot e connettori, tra cui Kusto, Analisi SQL, Cosmos DB e MySQL Java Connector non sono attualmente supportate in questa versione anticipata. Le librerie di data science non sono supportate negli ambienti PySpark. PySpark funziona solo con una configurazione Conda di base, che include PySpark da solo senza librerie aggiuntive.

Le integrazioni con l'elemento dell'ambiente e Visual Studio Code non sono supportate in questa versione anticipata.

Non supporta la lettura e la scrittura di dati in account di archiviazione di Azure per utilizzo generico v2 (GPv2) con protocolli WASB o ABFS.

Annotazioni

Condividere commenti e suggerimenti su Fabric Runtime nella piattaforma Ideas. Assicurarsi di menzionare la versione e la fase di rilascio a cui si fa riferimento. Microsoft valuta il feedback della community e assegna priorità ai miglioramenti in base ai voti, assicurandosi di soddisfare le esigenze degli utenti.

In primo piano

Apache Spark 4.0

Apache Spark 4.0 segna una pietra miliare significativa come versione inaugurale della serie 4.x, incarnando lo sforzo collettivo della vivace community open source.

In questa versione Spark SQL è notevolmente arricchita con potenti nuove funzionalità progettate per aumentare l'espressività e la versatilità per i carichi di lavoro SQL, ad esempio il supporto dei tipi di dati VARIANT, le funzioni definite dall'utente SQL, le variabili di sessione, la sintassi pipe e le regole di confronto di stringhe. PySpark vede l'impegno continuo sia per l'ampiezza funzionale che per l'esperienza di sviluppo complessiva, introducendo un'API nativa per i grafici, una nuova API per le origini dati Python, il supporto per UDTF Python e la profilatura unificata per gli UDF di PySpark, insieme a numerosi altri miglioramenti. Structured Streaming si evolve con aggiunte chiave che offrono maggiore controllo e facilità di debug, in particolare l'introduzione dell'API Stato arbitrario v2 per una gestione più flessibile dello stato e l'origine dati stato per semplificare il debug.

È possibile controllare l'elenco completo e le modifiche dettagliate qui: https://spark.apache.org/releases/spark-release-4-0-0.html.

Annotazioni

In Spark 4.0 SparkR è deprecato e potrebbe essere rimosso in una versione futura.

Delta Lake 4.0

Delta Lake 4.0 è un impegno collettivo per rendere l'interoperabilità delta Lake tra formati, più facile da usare e prestazioni più elevate. Delta 4.0 è una versione cardine ricca di potenti nuove funzionalità, ottimizzazioni delle prestazioni e miglioramenti fondamentali per il futuro di data lakehouse aperti.

È possibile controllare l'elenco completo e le modifiche dettagliate introdotte con Delta Lake 3.3 e 4.0 qui: https://github.com/delta-io/delta/releases/tag/v3.3.0. https://github.com/delta-io/delta/releases/tag/v4.0.0.

Importante

Le funzionalità specifiche di Delta Lake 4.0 sono sperimentali e funzionano solo su esperienze Spark, ad esempio notebook e definizioni di processi Spark. Se è necessario usare le stesse tabelle Delta Lake in più carichi di lavoro di Microsoft Fabric, non abilitare tali funzionalità. Per altre informazioni sulle versioni e sulle funzionalità del protocollo compatibili con tutte le esperienze di Microsoft Fabric, vedere Interoperabilità dei formati di tabella Delta Lake.

Contenuti correlati

- Runtime di Apache Spark in Fabric - Panoramica, controllo delle versioni e supporto di più runtime

- Guida alla migrazione di Spark Core

- Guide alla migrazione di SQL, set di dati e DataFrame

- Guida alla migrazione di Structured Streaming

- Guida alla migrazione di MLlib (Machine Learning)

- Guida alla migrazione di PySpark (Python in Spark)

- Guida alla migrazione di SparkR (R in Spark)