Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Data Wrangler, strumento basato su notebook per l'analisi esplorativa dei dati, supporta ora dataframe Spark e dataframe pandas. Genera codice PySpark, oltre al codice Python. Per una panoramica generale di Data Wrangler, che illustra come esplorare e trasformare i dataframe pandas, visita l'esercitazione principale. Questa esercitazione illustra come usare Data Wrangler per esplorare e trasformare i dataframe Spark.

Prerequisiti

Ottenere una sottoscrizione di Microsoft Fabric. In alternativa, iscriversi per ottenere una versione di valutazione di Microsoft Fabric gratuita.

Accedere a Microsoft Fabric.

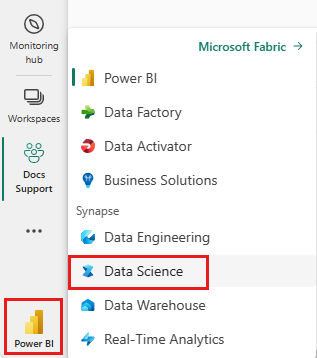

Usa l'interruttore dell'esperienza nell'angolo inferiore sinistro della tua home page per passare a Fabric.

Limiti

- Le operazioni di codice personalizzate sono attualmente supportate solo per i dataframe pandas.

- La visualizzazione Data Wrangler funziona meglio su monitor di grandi dimensioni, anche se è possibile ridurre o nascondere parti diverse dell'interfaccia per contenere schermi più piccoli.

Avvio di Data Wrangler con un dataframe Spark

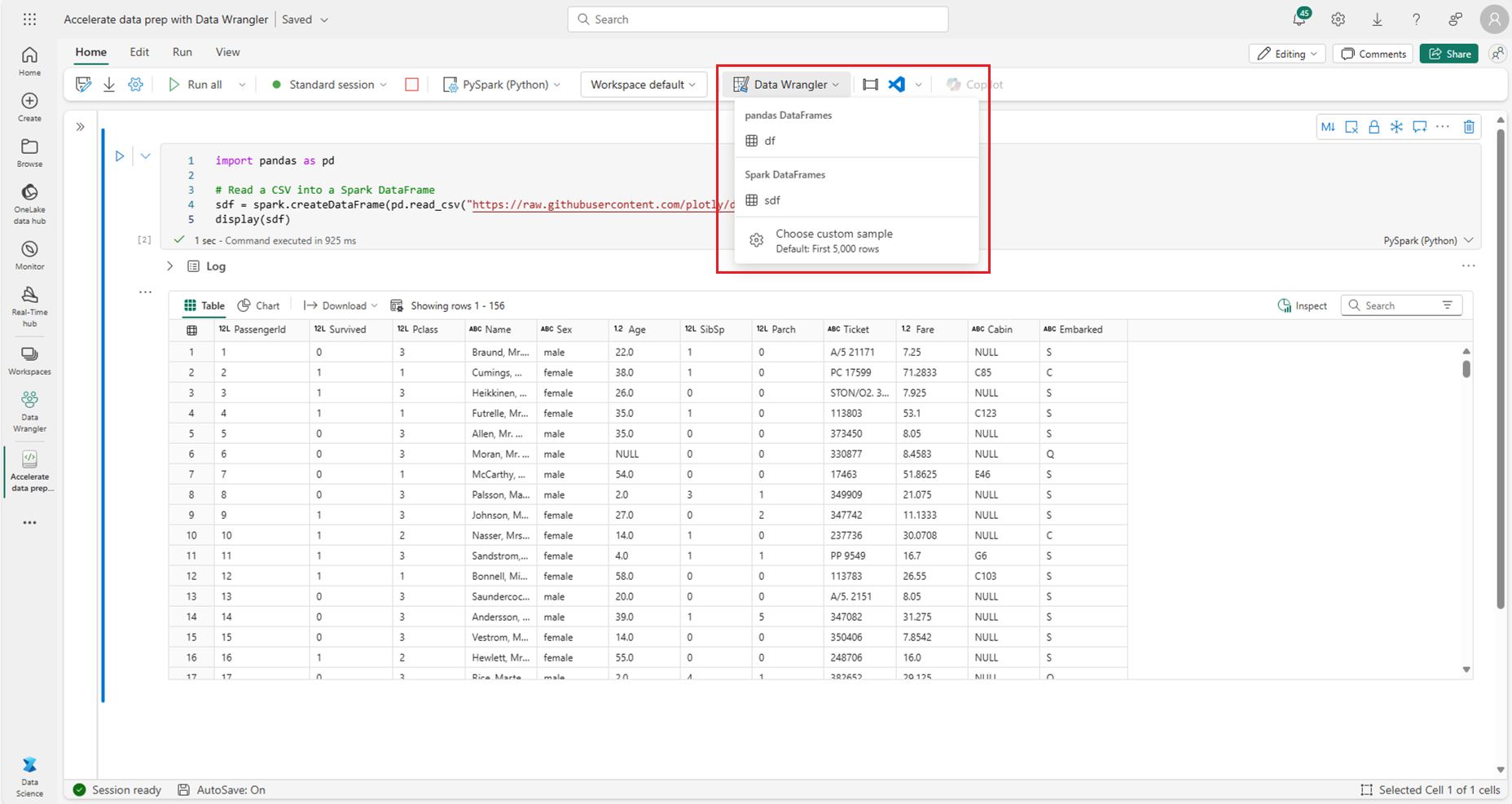

Gli utenti possono aprire i dataframe Spark in Data Wrangler direttamente da un notebook di Microsoft Fabric passando alla stessa richiesta di elenco a discesa in cui vengono visualizzati i dataframe pandas. Un elenco di dataframe Spark attivi viene visualizzato nell'elenco a discesa sotto l'elenco delle variabili pandas attive.

Questo frammento di codice crea un dataframe Spark con gli stessi dati di esempio usati nell'esercitazione su Data Wrangler pandas:

import pandas as pd

# Read a CSV into a Spark DataFrame

sdf = spark.createDataFrame(pd.read_csv("https://raw.githubusercontent.com/plotly/datasets/master/titanic.csv"))

display(sdf)

Nella scheda "Home" della barra multifunzione del notebook, usa il prompt a discesa Data Wrangler per esplorare i dataframe attivi disponibili per la modifica. Seleziona quello da aprire in Data Wrangler.

Suggerimento

Data Wrangler non può essere aperto mentre il kernel del notebook è occupato. Una cella in esecuzione deve terminare l'esecuzione prima che Data Wrangler possa essere avviata, come illustrato in questo screenshot:

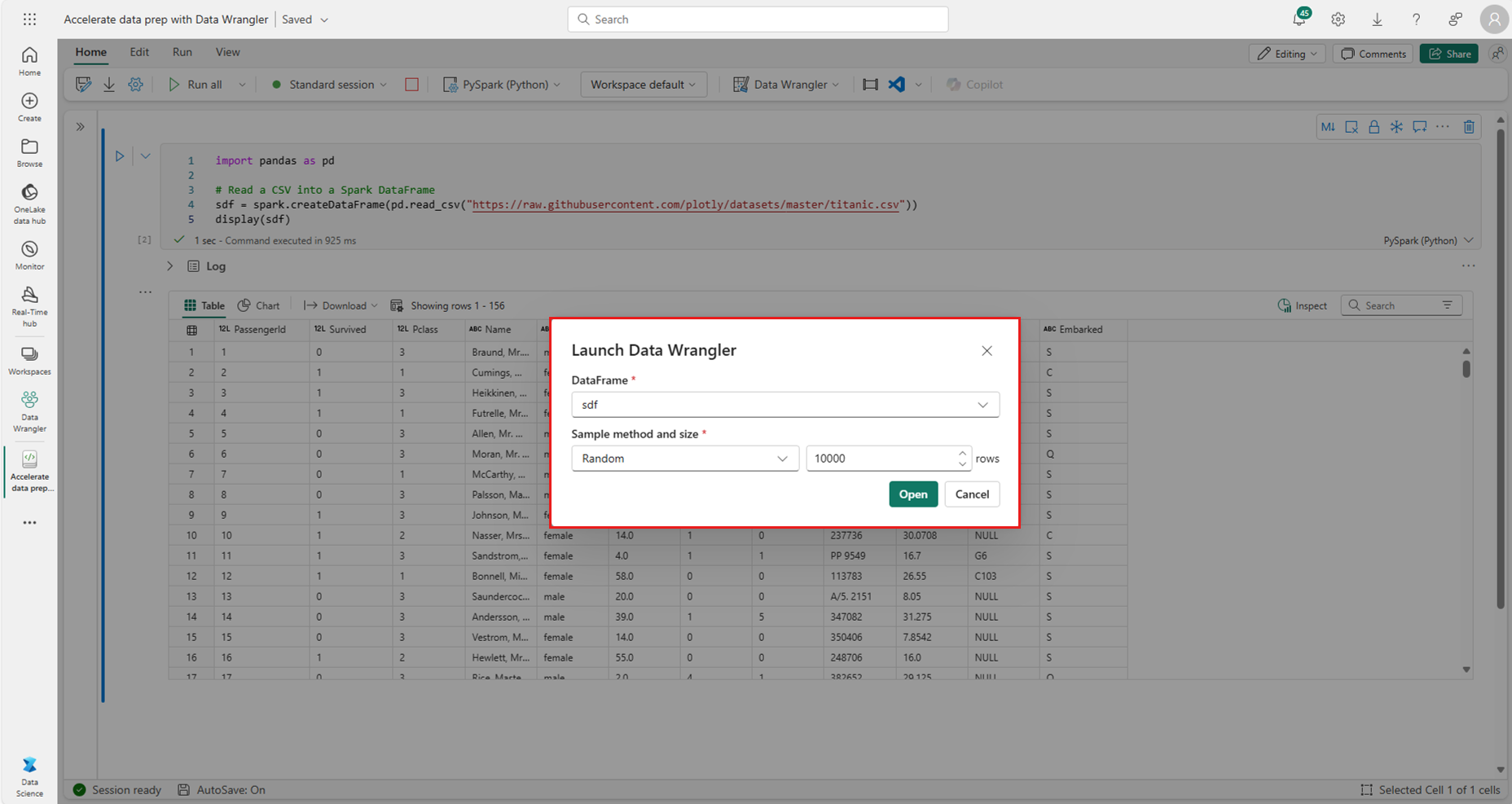

Scelta di esempi personalizzati

Data Wrangler converte automaticamente i dataframe Spark in campioni pandas per motivi di prestazioni. Tuttavia, tutto il codice generato dallo strumento viene infine convertito in PySpark quando esporta di nuovo nel notebook. Come per qualsiasi dataframe pandas, è possibile personalizzare l'esempio predefinito. Per aprire un esempio personalizzato di qualsiasi dataframe attivo con Data Wrangler, selezionare "Scegli esempio personalizzato" nell'elenco a discesa, come illustrato in questo screenshot:

Comparirà un popup con alcune opzioni, per specificare le dimensioni del campione desiderato (numero di righe) e il metodo di campionamento (primi record, ultimi record o set casuale), come mostrato in questo screenshot:

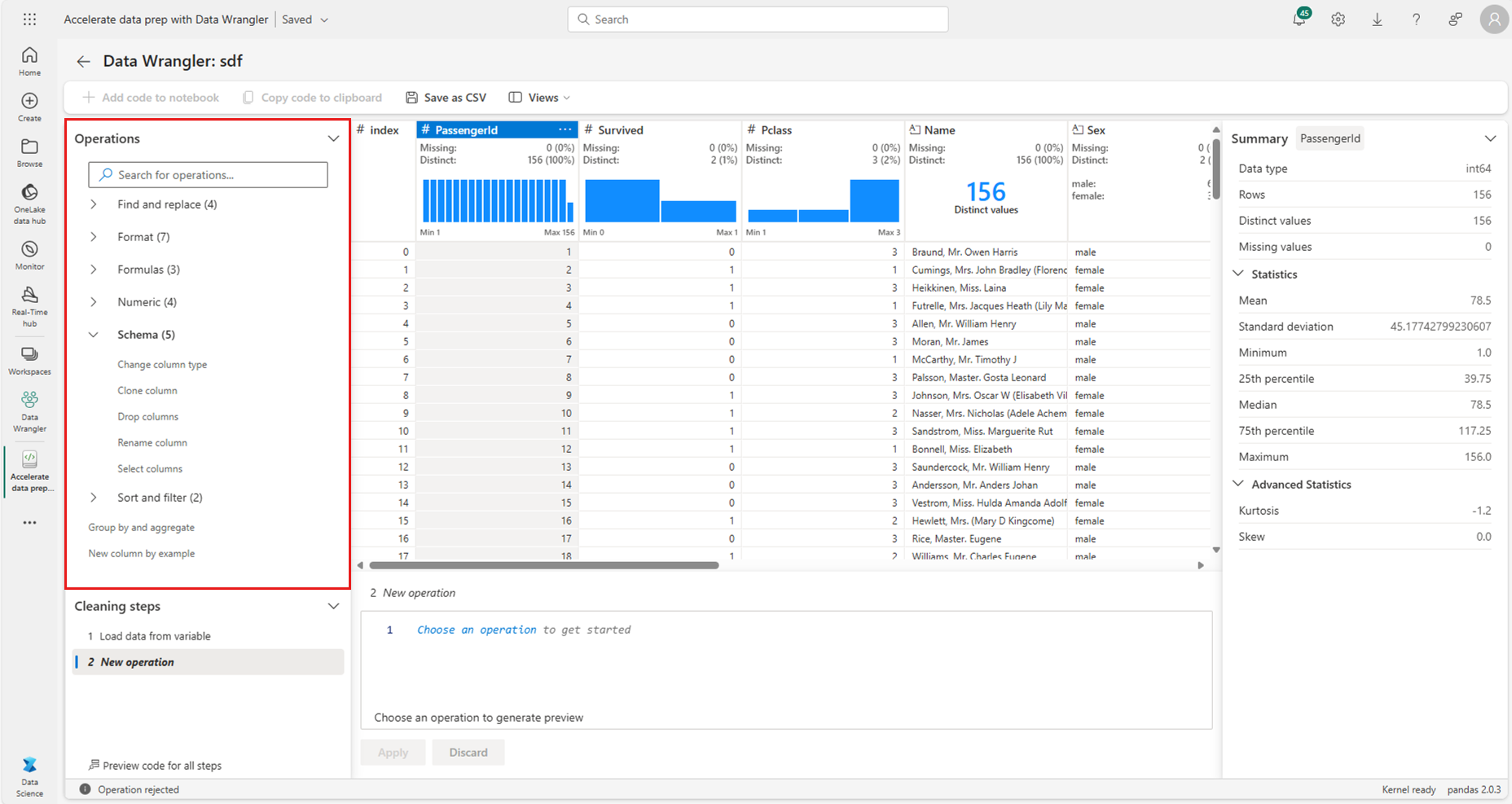

Visualizzare le statistiche di riepilogo

Quando Data Wrangler viene caricato, viene visualizzato un banner informativo sopra la griglia di anteprima. Questo banner indica che i dataframe Spark vengono convertiti temporaneamente in esempi pandas, ma tutto il codice generato viene infine convertito in PySpark. A parte ciò, usare Data Wrangler nei dataframe Spark è come usarlo nei dataframe pandas. Una panoramica descrittiva nel pannello "Riepilogo" visualizza informazioni sulle dimensioni dell'esempio, sui valori mancanti e altro ancora. La selezione di qualsiasi colonna nella griglia Data Wrangler richiede al pannello "Riepilogo" di aggiornare e visualizzare statistiche descrittive su tale colonna specifica. Le informazioni rapide su ogni colonna sono disponibili anche nella relativa intestazione.

Suggerimento

Le statistiche e gli oggetti visivi specifici della colonna (sia nel pannello "Riepilogo" che nelle intestazioni di colonna) dipendono dal tipo di dati della colonna. Ad esempio, nell'intestazione di colonna comparirà un istogramma di una colonna numerica sottoposto a binning, solo se viene eseguito il cast della colonna come tipo numerico, come mostrato in questo screenshot:

Esplorazione delle operazioni di pulizia dei dati

Un elenco ricercabile dei passaggi di pulizia dei dati è disponibile nel pannello "Operazioni". Nel pannello "Operazioni" la selezione di un passaggio di pulizia dei dati richiede di specificare una colonna o colonne di destinazione, insieme ai parametri necessari per completare il passaggio. Ad esempio, il prompt per ridimensionare numericamente una colonna richiede un nuovo intervallo di valori, come illustrato in questo screenshot:

Suggerimento

È possibile applicare una selezione più piccola di operazioni dal menu di ogni intestazione di colonna, come illustrato in questo screenshot:

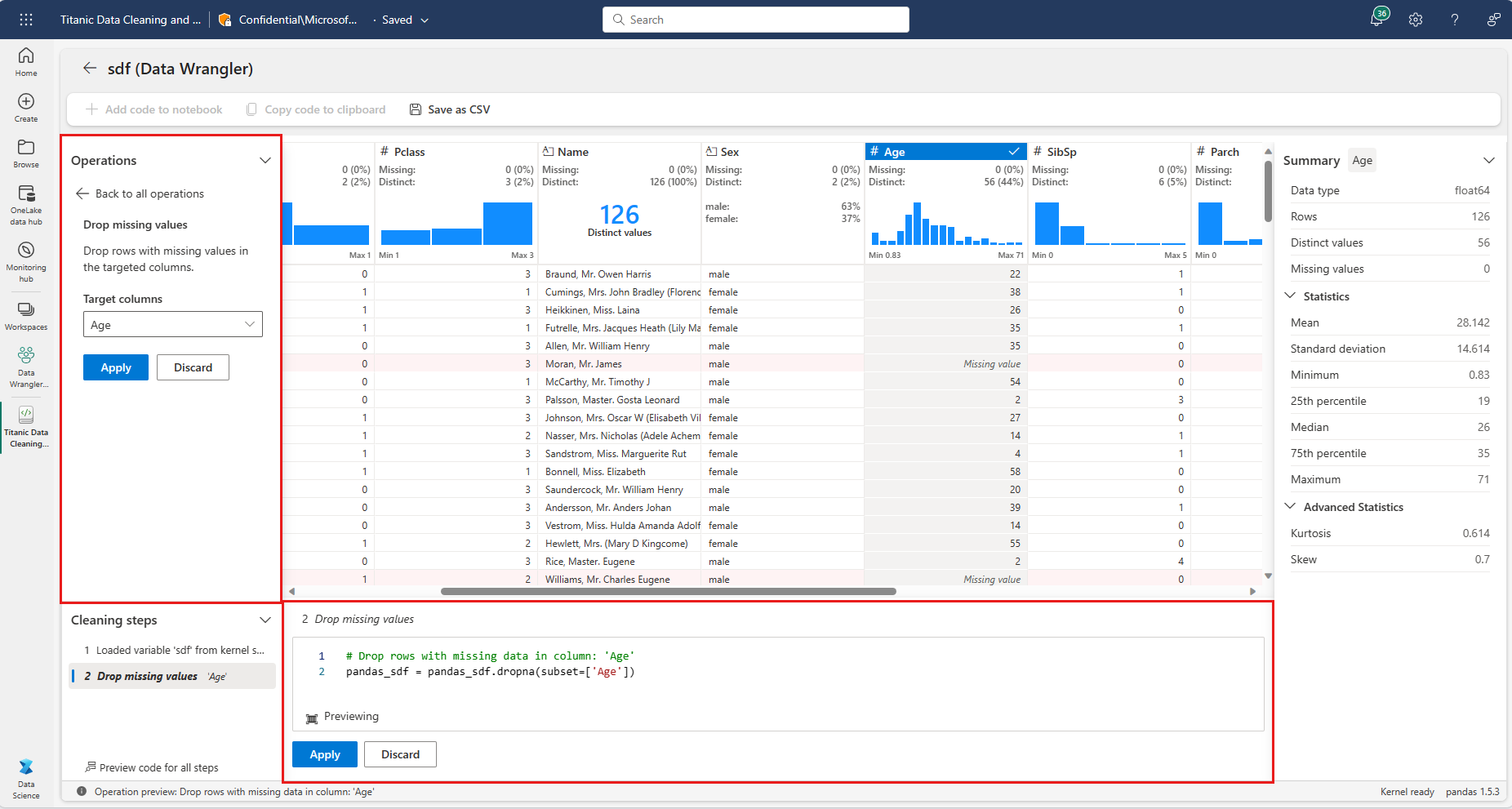

Anteprima e applicazione di operazioni

La griglia di visualizzazione Data Wrangler visualizza automaticamente i risultati di un'operazione selezionata e il codice corrispondente viene visualizzato automaticamente nel pannello sotto la griglia. Per eseguire il commit del codice in anteprima, selezionare "Applica" in entrambe le posizioni. Per eliminare il codice visualizzato in anteprima e provare una nuova operazione, selezionare "Ignora", come illustrato in questo screenshot:

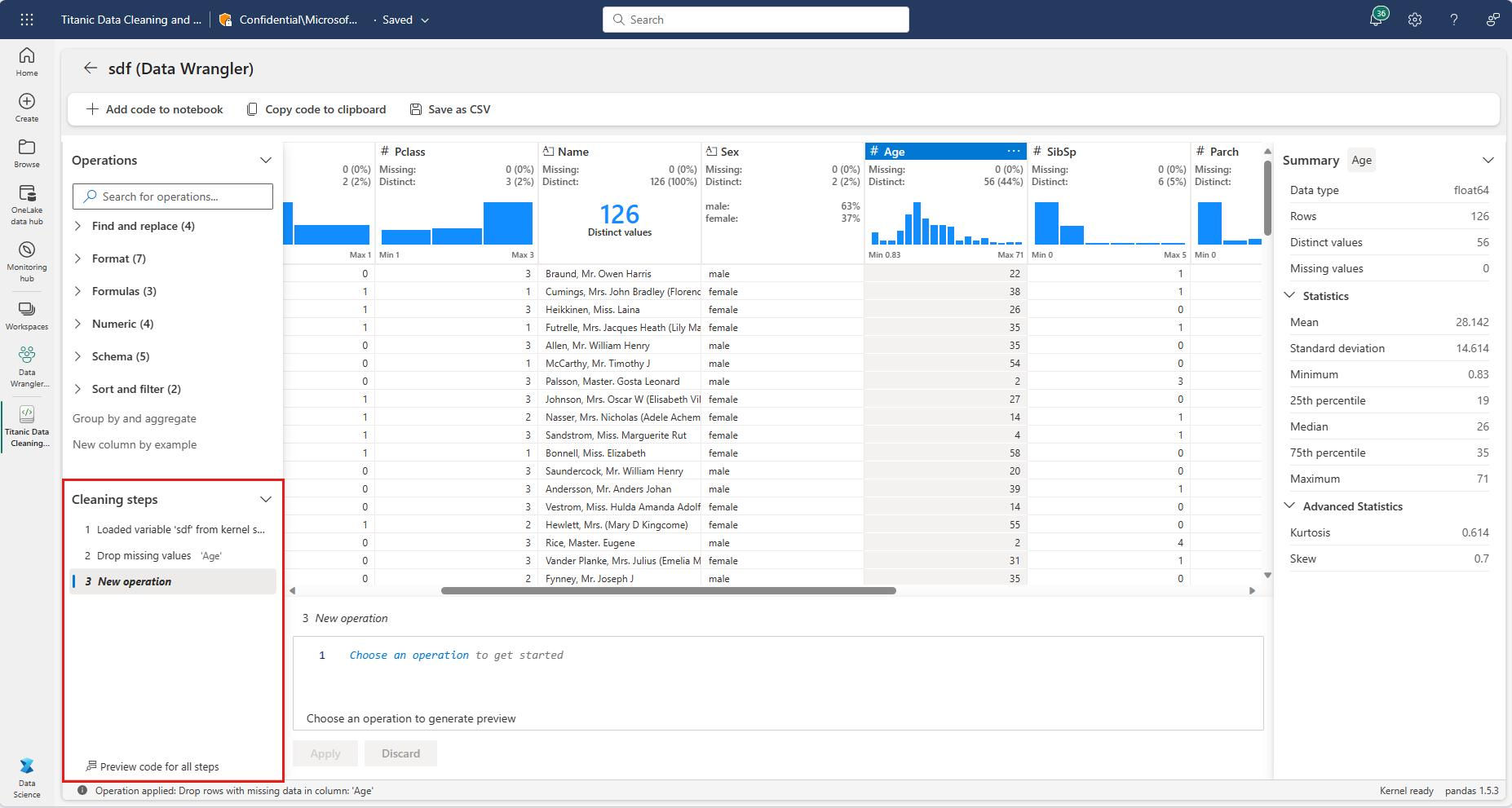

Dopo l'applicazione di un'operazione, la griglia di visualizzazione Dati Wrangler e le statistiche di riepilogo vengono aggiornate in modo da riflettere i risultati. Il codice viene visualizzato nell'elenco di operazioni di cui è stato eseguito il commit, che si trova nel pannello "Passaggi di pulizia", come illustrato in questo screenshot:

Suggerimento

È sempre possibile annullare il passaggio applicato più di recente. Nel pannello "Passaggi di pulizia" viene visualizzata un'icona del cestino se si passa il cursore sopra il passaggio applicato più di recente, come illustrato in questo screenshot:

Questa tabella riepiloga le operazioni attualmente supportate da Data Wrangler:

| Operazione | Descrizione |

|---|---|

| Sort | Ordinare una colonna in ordine crescente o decrescente |

| Filtra | Filtrare le righe i dati in base a una o più condizioni. |

| Codifica one-hot | Creare nuove colonne per ogni valore univoco in una colonna esistente, che indica la presenza o l'assenza di tali valori per riga |

| Codifica one-hot con delimitatore | Suddividere e codificare a caldo i dati categorici usando un delimitatore |

| Cambia tipi di colonne | Cambiare il tipo di dati di una colonna |

| Escludi colonna | Eliminare una o più colonne |

| Selezionare una colonna | Scegliere una o più colonne da mantenere ed elimina il resto |

| Rinominare una colonna | Rinominare una colonna |

| Escludere i valori mancanti | Rimuovere le righe con valori mancanti |

| Escludere le righe duplicate | Eliminare tutte le righe con valori duplicati in una o più colonne |

| Immettere i valori mancanti | Sostituire le celle con valori mancanti con un nuovo valore |

| Trova e sostituisci | Sostituire le celle con un criterio di corrispondenza esatto |

| Raggruppare per colonna e aggregare | Raggruppare per valori di colonna e risultati aggregati |

| Eliminare spazio vuoto | Rimuovere spazi vuoti dall'inizio e dalla fine del testo |

| Dividi testo | Dividere una colonna in più colonne in base a un delimitatore definito dall'utente |

| Conversione del testo in minuscolo | Conversione del testo in minuscolo |

| Convertire il testo in maiuscolo | Convertire il testo in MAIUSCOLO |

| Ridimensionare valori min/max | Ridimensionare una colonna numerica tra un valore minimo e massimo |

| Anteprima suggerimenti | Creare automaticamente una nuova colonna in base a esempi derivati da una colonna esistente |

Modificare la visualizzazione

In qualsiasi momento, è possibile personalizzare l'interfaccia con la scheda "Visualizzazioni" sulla barra degli strumenti che si trova sopra la griglia di visualizzazione Data Wrangler. In questo modo è possibile nascondere o visualizzare riquadri diversi in base alle preferenze e alle dimensioni dello schermo, come illustrato in questo screenshot:

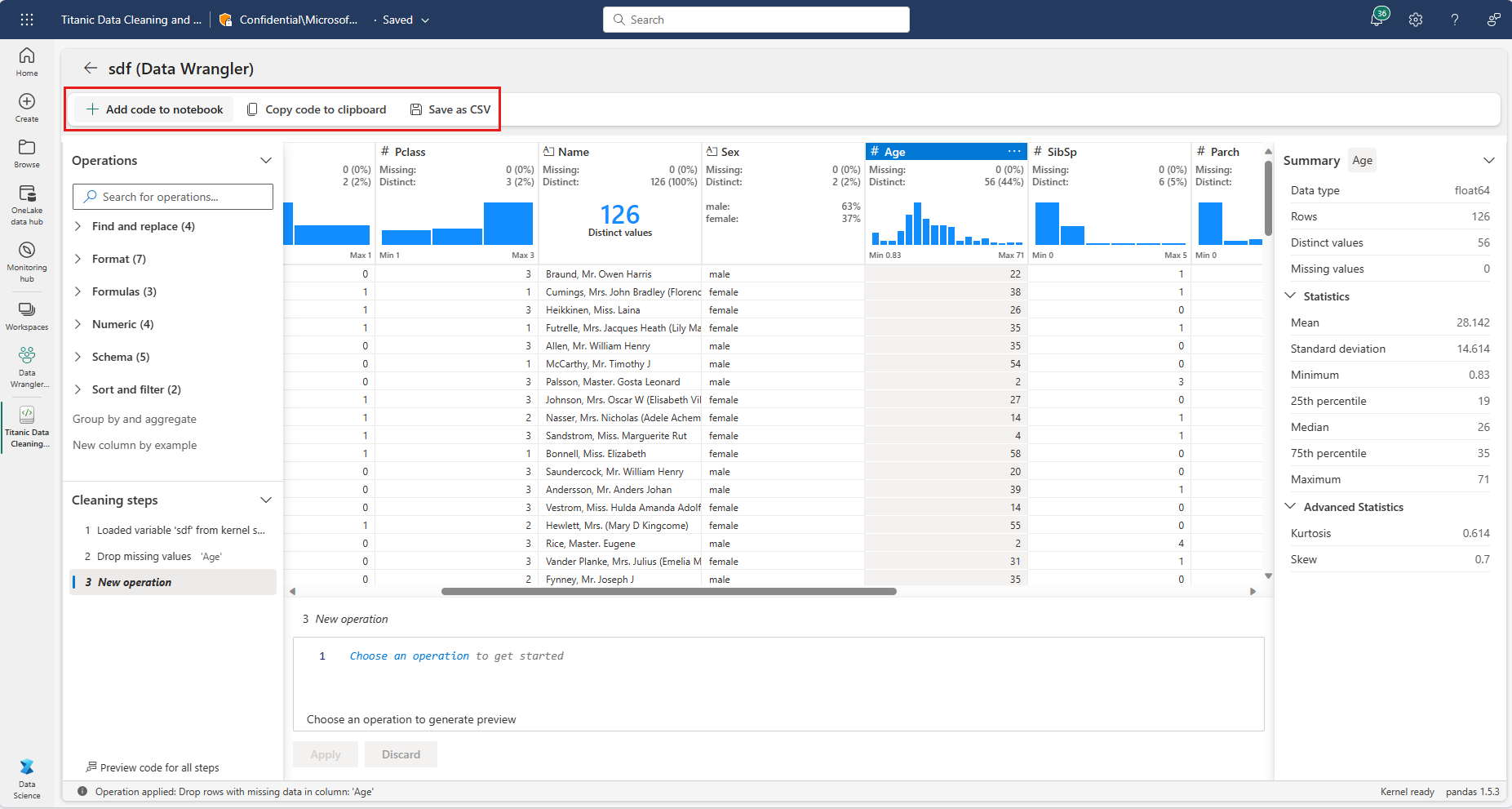

Salvataggio ed esportazione del codice

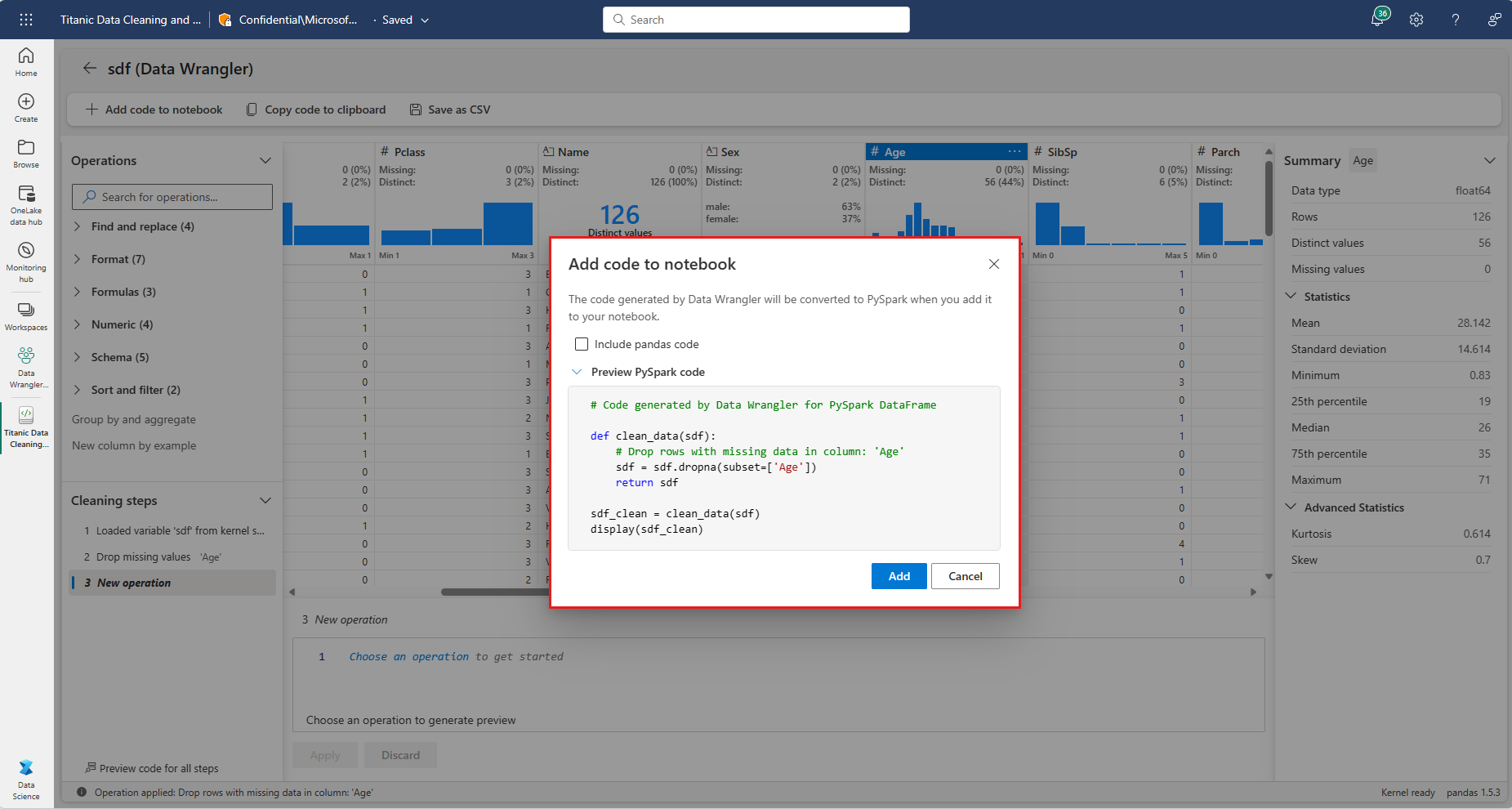

La barra degli strumenti sopra la griglia di visualizzazione Data Wrangler offre delle opzioni per salvare il codice generato. È possibile copiare il codice negli Appunti o esportarlo nel notebook come funzione. Per i dataframe Spark, tutto il codice generato nell'esempio pandas viene convertito in PySpark prima di tornare al notebook. Prima della chiusura di Data Wrangler, lo strumento visualizza un'anteprima del codice PySpark tradotto e offre anche un'opzione per esportare il codice pandas intermedio.

Suggerimento

I dati Wrangler generano codice applicato solo quando si esegue manualmente la nuova cella e non sovrascriverà il dataframe originale, come illustrato in questo screenshot:

Il codice viene convertito in PySpark, come mostrato in questo screenshot:

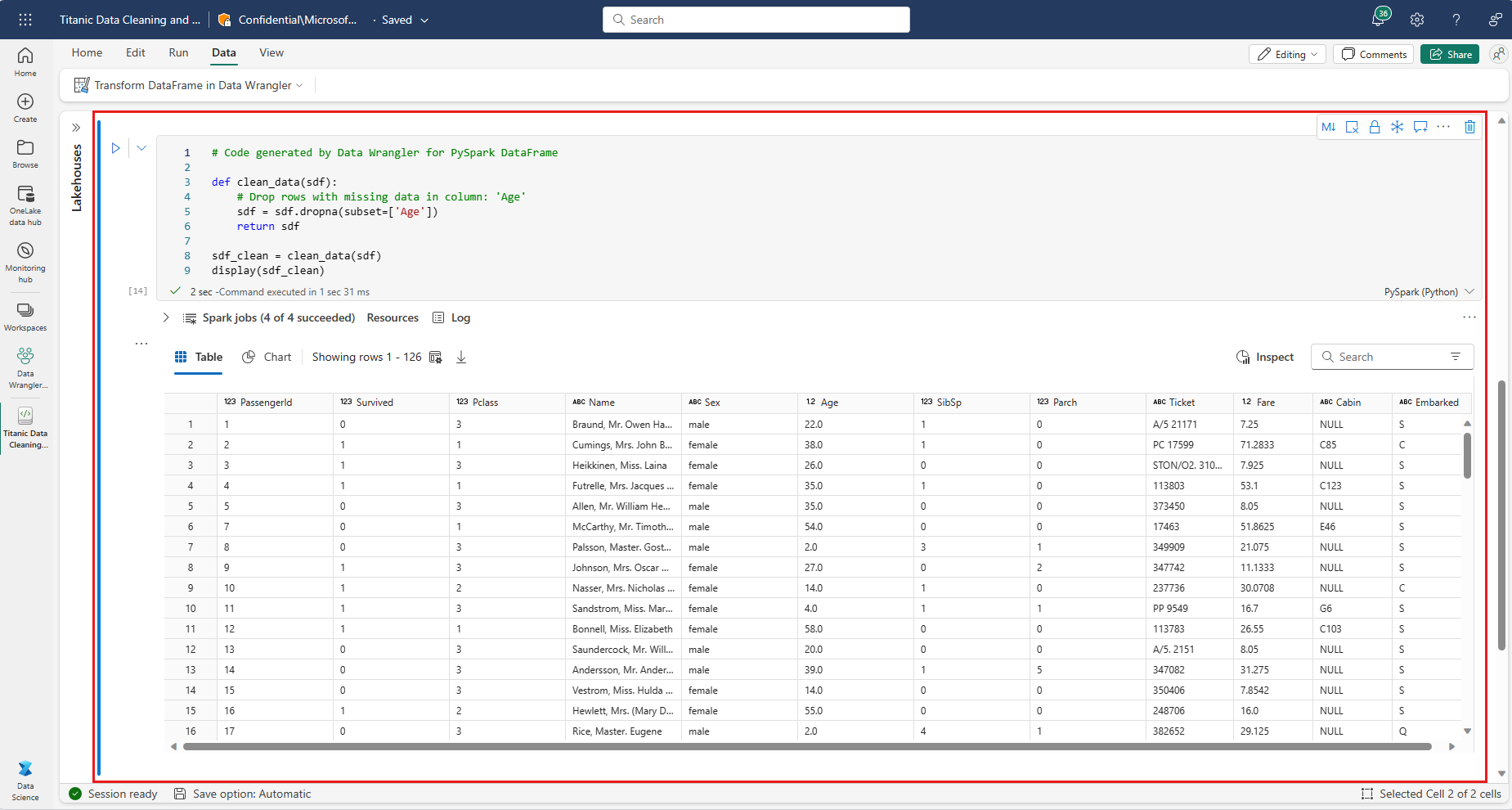

È quindi possibile eseguire il codice esportato, come illustrato in questo screenshot:

Contenuto correlato

- Per una panoramica di Data Wrangler, vedi questo articolo complementare

- Per provare Data Wrangler in Visual Studio Code, passare a Data Wrangler in VS Code

- Abbiamo perso una funzionalità necessaria? Faccelo sapere! Suggeriscilo nel forum Fabric Ideas