Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Si applica a:✅ Endpoint di analisi SQL in Microsoft Fabric

L'endpoint di analisi SQL consente di eseguire query sui dati nel lakehouse usando il linguaggio T-SQL e il protocollo TDS.

Ogni lakehouse ha un endpoint di analisi SQL. Il numero di endpoint di analisi SQL in un'area di lavoro corrisponde al numero di lakehouse e database con mirroring di cui è stato effettuato il provisioning in tale area di lavoro.

Un processo in background è responsabile dell'analisi del lakehouse per le modifiche e di mantenere aggiornato l'endpoint di analisi SQL per tutte le modifiche di cui è stato eseguito il commit in lakehouse in un'area di lavoro. Il processo di sincronizzazione viene gestito in modo trasparente dalla piattaforma Microsoft Fabric. Quando viene rilevata una modifica in un lakehouse, un processo in background aggiorna i metadati e l'endpoint di analisi SQL riflette le modifiche di cui è stato eseguito il commit nelle tabelle lakehouse. In condizioni operative normali, il ritardo tra un lakehouse e un endpoint di analisi SQL è inferiore a un minuto. Il periodo di tempo effettivo può variare da pochi secondi a minuti a seconda di molti fattori descritti in questo articolo. Il processo in background viene eseguito solo quando l'endpoint di analisi SQL è attivo e viene interrotto dopo 15 minuti di inattività.

Schema generato automaticamente nell'endpoint di analisi SQL di Lakehouse

L'endpoint di analisi SQL gestisce le tabelle generate automaticamente in modo che gli utenti dell'area di lavoro non possano modificarle. Gli utenti possono arricchire il modello di database aggiungendo schemi, viste, routine e altri oggetti di database SQL personalizzati.

Per ogni tabella Delta in Lakehouse, l'endpoint di analisi SQL genera automaticamente una tabella nello schema appropriato. Per i tipi di dati dello schema generati automaticamente per l'endpoint di analisi SQL, vedere Tipi di dati in Microsoft Fabric.

Le tabelle nell'endpoint di analisi SQL vengono create con un ritardo minore. Dopo aver creato o aggiornato la tabella Delta Lake nel lake, la tabella degli endpoint di analisi SQL che fa riferimento alla tabella Delta Lake viene creata/aggiornata automaticamente.

Il tempo necessario per aggiornare la tabella è correlato alla modalità di ottimizzazione delle tabelle Delta. Per altre informazioni, vedere Ottimizzazione delle tabelle Delta Lake e V-Order per altre informazioni sugli scenari chiave e una guida approfondita su come gestire in modo efficiente le tabelle Delta per ottenere prestazioni ottimali.

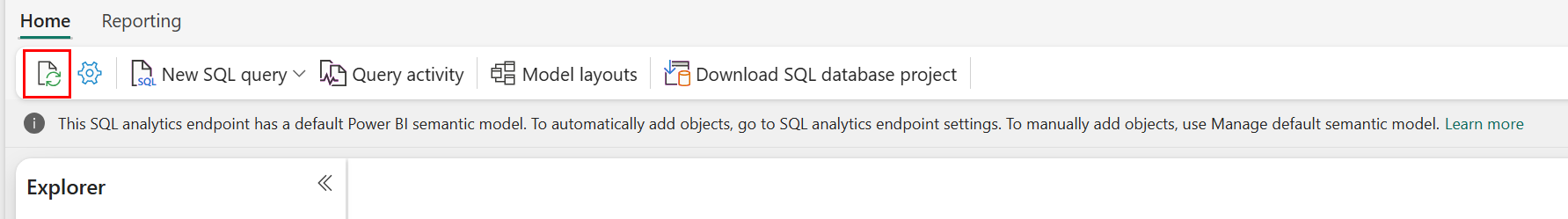

È possibile forzare manualmente un aggiornamento dell'analisi automatica dei metadati nel portale di Fabric. Nella pagina per l'endpoint di analisi SQL selezionare il pulsante Aggiorna nella barra degli strumenti di Explorer per aggiornare lo schema. Passare a Eseguire una query sull'endpoint di analisi SQL e cercare il pulsante di aggiornamento, come illustrato nell'immagine seguente.

È anche possibile forzare a livello di codice un aggiornamento dell'analisi automatica dei metadati usando l'API REST Aggiorna metadati dell'endpoint SQL.

Indicazioni

- L'individuazione automatica dei metadati tiene traccia delle modifiche di cui è stato eseguito il commit in lakehouse ed è una singola istanza per ogni area di lavoro Fabric. Se si osserva una maggiore latenza per le modifiche alla sincronizzazione tra lakehouse e l'endpoint di analisi SQL, potrebbe essere dovuto a un numero elevato di lakehouse in un'area di lavoro. In uno scenario di questo tipo, valutare la possibilità di eseguire la migrazione di ogni lakehouse a un'area di lavoro separata, in quanto consente di ridimensionare l'individuazione automatica dei metadati.

- I file Parquet non sono modificabili per impostazione predefinita. Quando è presente un'operazione di aggiornamento o eliminazione, una tabella Delta aggiungerà nuovi file Parquet con il set di modifiche, aumentando il numero di file nel tempo, a seconda della frequenza di aggiornamenti ed eliminazioni. Se non è pianificata alcuna manutenzione, alla fine questo modello crea un sovraccarico di lettura e questo influisce sul tempo necessario per sincronizzare le modifiche all'endpoint di analisi SQL. Per risolvere questo problema, pianificare le normali operazioni di manutenzione delle tabelle lakehouse.

- In alcuni scenari, è possibile osservare che le modifiche di cui è stato eseguito il commit in un lakehouse non sono visibili nell'endpoint di analisi SQL associato. Ad esempio, potrebbe essere stata creata una nuova tabella in lakehouse, ma non è ancora elencata nell'endpoint di analisi SQL. In alternativa, potrebbe essere stato eseguito il commit di un numero elevato di righe in una tabella in un lakehouse, ma questi dati non sono ancora visibili nell'endpoint di analisi SQL. È consigliabile avviare una sincronizzazione dei metadati su richiesta, attivata dall'opzione Aggiorna della barra multifunzione dell'editor di query SQL o dall'API REST Aggiorna metadati dell'endpoint SQL. Questa opzione forza la sincronizzazione dei metadati su richiesta, anziché attendere il completamento della sincronizzazione dei metadati in background.

- Non tutte le funzionalità Delta sono comprese dal processo di sincronizzazione automatica. Per altre informazioni sulle funzionalità supportate da ogni motore in Fabric, vedere Interoperabilità dei formati di tabella Delta Lake.

- Se è presente un volume estremamente elevato di modifiche alle tabelle durante l'elaborazione ETL (Extract Transform and Load), è possibile che si verifichi un ritardo previsto fino a quando non vengono elaborate tutte le modifiche.

Ottimizzazione delle tabelle lakehouse per l'esecuzione di query sull'endpoint di analisi SQL

Quando l'endpoint di analisi SQL legge le tabelle archiviate in un lakehouse, le prestazioni delle query sono fortemente influenzate dal layout fisico dei file Parquet sottostanti.

Un numero elevato di file Parquet di piccole dimensioni crea un sovraccarico e influisce negativamente sulle prestazioni delle query. Per garantire prestazioni prevedibili ed efficienti, è consigliabile mantenere l'archiviazione delle tabelle in modo che ogni file parquet contenga due milioni di righe. Questo numero di righe fornisce un livello bilanciato di parallelismo senza frammentare il set di dati in sezioni eccessivamente piccole.

Oltre alle linee guida per il conteggio delle righe, le dimensioni dei file sono ugualmente importanti. L'endpoint di analisi SQL offre prestazioni ottimali quando i file Parquet sono sufficientemente grandi per ridurre al minimo il sovraccarico di gestione dei file, ma non così grandi che limitano l'efficienza di scansione parallela. Per la maggior parte dei carichi di lavoro, mantenere i singoli file Parquet intorno a 400 MB raggiunge il miglior equilibrio. Per ottenere questo equilibrio, seguire questa procedura:

- Impostare

maxRecordsPerFilesu 2.000.000 prima che si verifichino modifiche ai dati. - Eseguire le modifiche ai dati (inserimento dati, aggiornamenti, eliminazioni).

- Impostare

maxFileSizesu 400 MB. - Eseguire

OPTIMIZE. Per informazioni dettagliate sull'uso diOPTIMIZE, vedere Operazioni di manutenzione tabelle.

Lo script seguente fornisce un modello per questi passaggi e deve essere eseguito in un lakehouse:

from delta.tables import DeltaTable

# 1. CONFIGURE LIMITS

# Cap files to 2M rows during writes. This should be done before data ingestion occurs.

spark.conf.set("spark.sql.files.maxRecordsPerFile", 2000000)

# 2. INGEST DATA

# Here, you ingest data into your table

# 3. CAP FILE SIZE (~400 MB)

spark.conf.set("spark.databricks.delta.optimize.maxFileSize", 400 * 1024 * 1024)

# 4. RUN OPTIMIZE (bin-packing)

spark.sql("""

OPTIMIZE myTable

""")

Per mantenere le dimensioni dei file integre, gli utenti devono eseguire periodicamente operazioni di ottimizzazione Delta, ad esempio OPTIMIZE, in particolare per le tabelle che ricevono frequenti scritture incrementali, aggiornamenti ed eliminazioni. Queste operazioni di manutenzione compattano i file di piccole dimensioni in quelli di dimensioni appropriate, assicurandosi che l'endpoint di analisi SQL possa elaborare le query in modo efficiente.

Annotazioni

Per indicazioni sulla manutenzione generale delle tabelle lakehouse, vedere Eseguire la manutenzione di tabelle ad hoc in una tabella Delta usando Lakehouse.

Considerazioni sulle dimensioni delle partizioni

La scelta della colonna di partizione per una tabella delta in un lakehouse influisce anche sul tempo necessario per sincronizzare le modifiche all'endpoint di analisi SQL. Il numero e le dimensioni delle partizioni della colonna di partizione sono importanti per le prestazioni:

- Una colonna con cardinalità elevata (per lo più o interamente costituita da valori univoci) comporta un numero elevato di partizioni. Un numero elevato di partizioni influisce negativamente sulle prestazioni dell'analisi di individuazione dei metadati per individuare le modifiche. Se la cardinalità di una colonna è elevata, scegliere un'altra colonna per il partizionamento.

- Anche le dimensioni di ogni partizione possono influire sulle prestazioni. È consigliabile usare una colonna che genera una partizione di almeno (o vicino a) 1 GB. È consigliabile seguire le procedure consigliate per la manutenzione delle tabelle differenziali; ottimizzazione. Per uno script Python per valutare le partizioni, vedere Script di esempio per i dettagli della partizione.

Un volume elevato di file Parquet di piccole dimensioni aumenta il tempo necessario per sincronizzare le modifiche tra una lakehouse e l'endpoint di analisi SQL associato. È possibile che si verifichi un numero elevato di file Parquet in una tabella delta per uno o più motivi:

- Se si sceglie una partizione per una tabella delta con un numero elevato di valori univoci, viene partizionata da ogni valore univoco e potrebbe essere sovra partizionata. Scegliere una colonna di partizione che non ha una cardinalità elevata e comporta almeno 1 GB di partizioni singole.

- La velocità di inserimento dei dati in batch e di streaming può comportare anche file di piccole dimensioni a seconda della frequenza e delle dimensioni delle modifiche scritte in un lakehouse. Ad esempio, potrebbe esserci un piccolo volume di modifiche che arrivano al lakehouse, che generano piccoli file parquet. Per risolvere questo problema, è consigliabile implementare la manutenzione regolare della tabella lakehouse.

Script di esempio per i dettagli della partizione

Usare il notebook seguente per stampare un report che illustra in dettaglio le dimensioni e i dettagli delle partizioni alla base di una tabella differenziale.

- Prima di tutto, è necessario specificare il percorso ABSFF per la tabella delta nella variabile

delta_table_path.- È possibile ottenere il percorso ABFSS di una tabella delta da Esplora del portale di Fabric. Fare clic con il pulsante destro del mouse sul nome della tabella, quindi scegliere

COPY PATHdall'elenco di opzioni.

- È possibile ottenere il percorso ABFSS di una tabella delta da Esplora del portale di Fabric. Fare clic con il pulsante destro del mouse sul nome della tabella, quindi scegliere

- Lo script restituisce tutte le partizioni per la tabella delta.

- Lo script scorre ogni partizione per calcolare le dimensioni totali e il numero di file.

- Lo script restituisce i dettagli delle partizioni, dei file per partizioni e delle dimensioni per partizione in GB.

Lo script completo può essere copiato dal blocco di codice seguente:

# Purpose: Print out details of partitions, files per partitions, and size per partition in GB.

from notebookutils import mssparkutils

# Define ABFSS path for your delta table. You can get ABFSS path of a delta table by simply right-clicking on table name and selecting COPY PATH from the list of options.

delta_table_path = "abfss://<workspace id>@<onelake>.dfs.fabric.microsoft.com/<lakehouse id>/Tables/<tablename>"

# List all partitions for given delta table

partitions = mssparkutils.fs.ls(delta_table_path)

# Initialize a dictionary to store partition details

partition_details = {}

# Iterate through each partition

for partition in partitions:

if partition.isDir:

partition_name = partition.name

partition_path = partition.path

files = mssparkutils.fs.ls(partition_path)

# Calculate the total size of the partition

total_size = sum(file.size for file in files if not file.isDir)

# Count the number of files

file_count = sum(1 for file in files if not file.isDir)

# Write partition details

partition_details[partition_name] = {

"size_bytes": total_size,

"file_count": file_count

}

# Print the partition details

for partition_name, details in partition_details.items():

print(f"{partition_name}, Size: {details['size_bytes']:.2f} bytes, Number of files: {details['file_count']}")