Accesso all'area di lavoro attendibile (anteprima)

Fabric consente di accedere agli account Azure Data Lake Gen2 abilitati per il firewall in modo sicuro. Le aree di lavoro di Infrastruttura con un'identità dell'area di lavoro possono accedere in modo sicuro agli account Azure Data Lake Gen 2 con accesso alla rete pubblica abilitato da reti virtuali e indirizzi IP selezionati. È possibile limitare l'accesso ad ADLS Gen 2 a aree di lavoro di Fabric specifiche.

Le aree di lavoro dell'infrastruttura che accedono a un account di archiviazione con accesso all'area di lavoro attendibile richiedono un'autorizzazione appropriata per la richiesta. L'autorizzazione è supportata con le credenziali di Microsoft Entra per gli account aziendali o le entità servizio. Per altre informazioni sulle regole dell'istanza delle risorse, vedere Concedere l'accesso dalle istanze delle risorse di Azure.

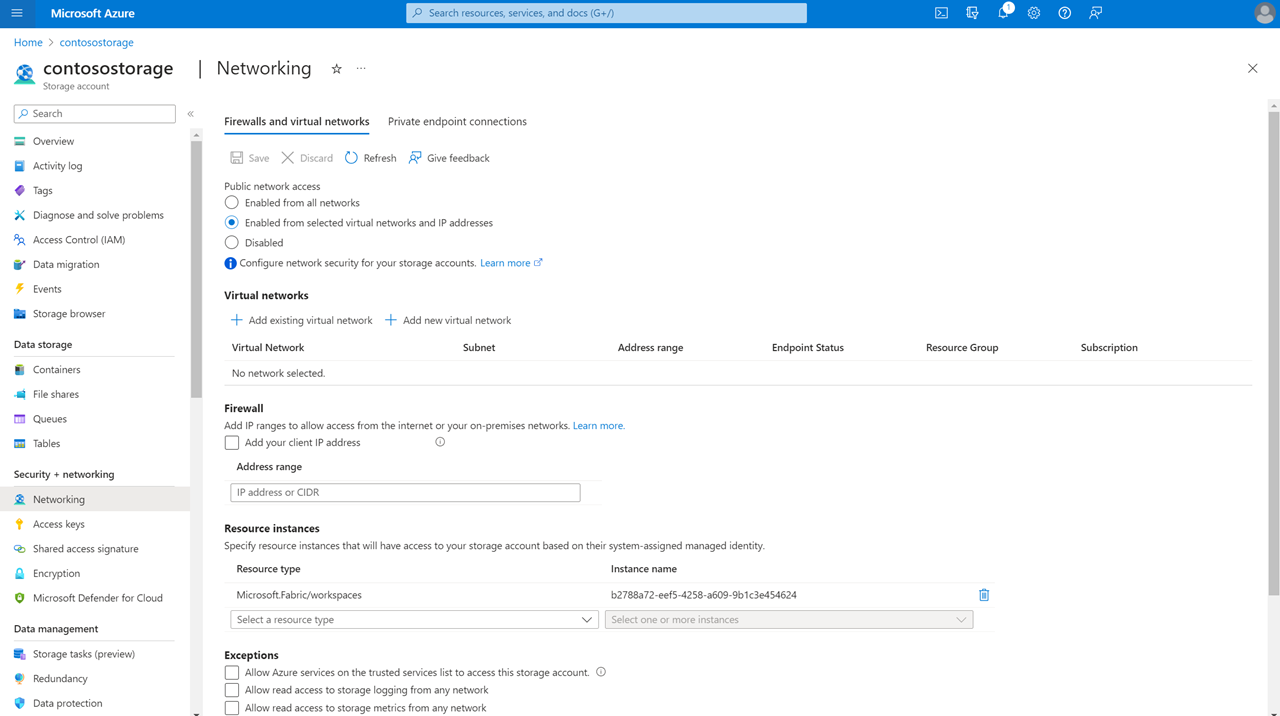

Per limitare e proteggere l'accesso agli account di archiviazione abilitati per il firewall da determinate aree di lavoro di Fabric, è possibile configurare la regola dell'istanza delle risorse per consentire l'accesso da aree di lavoro di Infrastruttura specifiche.

Nota

L'accesso all'area di lavoro attendibile è attualmente disponibile in anteprima pubblica. L'identità dell'area di lavoro infrastruttura può essere creata solo nelle aree di lavoro associate a una capacità infrastruttura (F64 o versione successiva). Per informazioni sull'acquisto di una sottoscrizione di Fabric, vedere Acquistare una sottoscrizione di Microsoft Fabric.

Questo articolo illustra come:

Configurare l'accesso all'area di lavoro attendibile in un account di archiviazione di Azure Data Lake Gen2.

Creare un collegamento OneLake in un'entità Fabric Lakehouse che si connette a un account di archiviazione di Azure Data Lake Gen 2 abilitato per l'accesso all'area di lavoro attendibile.

Creare una pipeline di dati per connettersi direttamente a un account Azure Data Lake Gen 2 abilitato per il firewall con accesso all'area di lavoro attendibile abilitato.

Configurare l'accesso all'area di lavoro attendibile in ADLS Gen2

Regola dell'istanza di risorsa

È possibile configurare aree di lavoro di Fabric specifiche per accedere all'account di archiviazione in base all'identità dell'area di lavoro. È possibile creare una regola dell'istanza di risorsa distribuendo un modello di Resource Manager con una regola di istanza della risorsa. Per creare una regola di istanza della risorsa:

Accedere al portale di Azure e passare a Distribuzione personalizzata.

Scegliere Creare un modello personalizzato nell'editor. Alla fine di questo documento viene fornito un modello di Resource Manager di esempio che crea una regola dell'istanza di risorsa.

Creare la regola dell'istanza della risorsa nell'editor. Al termine, scegliere Rivedi e crea.

Nella scheda Informazioni di base visualizzata specificare i dettagli del progetto e dell'istanza necessari. Al termine, scegliere Rivedi e crea.

Nella scheda Rivedi e crea visualizzata esaminare il riepilogo e quindi selezionare Crea. La regola verrà inviata per la distribuzione.

Al termine della distribuzione, sarà possibile passare alla risorsa.

Nota

- Le regole dell'istanza delle risorse per le aree di lavoro di Infrastruttura possono essere create solo tramite modelli di Resource Manager. La creazione tramite il portale di Azure non è supportata.

- Il valore subscriptionId "00000000-0000-0000-0000-000000000000" deve essere usato per l'id risorsa dell'area di lavoro infrastruttura.

- È possibile ottenere l'ID dell'area di lavoro per un'area di lavoro infrastruttura tramite il relativo URL della barra degli indirizzi.

Ecco un esempio di regola dell'istanza di risorsa che può essere creata tramite il modello di Resource Manager:

"resourceAccessRules": [

{ "tenantId": " df96360b-9e69-4951-92da-f418a97a85eb",

"resourceId": "/subscriptions/00000000-0000-0000-0000-000000000000/resourcegroups/Fabric/providers/Microsoft.Fabric/workspaces/b2788a72-eef5-4258-a609-9b1c3e454624”

}

]

Eccezione del servizio attendibile

Se si seleziona l'eccezione del servizio attendibile per un account Azure Data Lake Gen 2 con accesso alla rete pubblica abilitato da reti virtuali e indirizzi IP selezionati, le aree di lavoro di Infrastruttura con un'identità dell'area di lavoro potranno accedere all'account di archiviazione. Quando viene selezionata la casella di controllo eccezione del servizio attendibile, tutte le aree di lavoro nelle capacità fabric del tenant con un'identità dell'area di lavoro possono accedere ai dati archiviati nell'account di archiviazione.

Questa configurazione non è consigliata e il supporto potrebbe essere sospeso in futuro. È consigliabile usare le regole dell'istanza delle risorse per concedere l'accesso a risorse specifiche.

Chi può configurare gli account Archiviazione per l'accesso ai servizi attendibili?

Un collaboratore nell'account di archiviazione (un ruolo Controllo degli accessi in base al ruolo di Azure) può configurare le regole dell'istanza delle risorse o l'eccezione del servizio attendibile.

Come usare l'accesso all'area di lavoro attendibile in Fabric

Esistono attualmente due modi per usare l'accesso all'area di lavoro attendibile per accedere ai dati da Fabric in modo sicuro:

È possibile creare un nuovo collegamento ADLS in un'istanza di Fabric Lakehouse per iniziare ad analizzare i dati con Spark, SQL e Power BI.

È possibile creare una pipeline di dati che sfrutta l'accesso all'area di lavoro attendibile per accedere direttamente a un account Azure Data Lake Gen 2 abilitato per il firewall.

Le sezioni seguenti illustrano come usare questi due metodi.

Creare un collegamento OneLake all'account di archiviazione con accesso all'area di lavoro attendibile

Con l'identità dell'area di lavoro configurata in Fabric e l'accesso all'area di lavoro attendibile abilitato nell'account di archiviazione DI ADLS Gen2, è possibile creare collegamenti OneLake per accedere ai dati da Fabric. È sufficiente creare un nuovo collegamento ADLS in un'infrastruttura Lakehouse ed è possibile iniziare ad analizzare i dati con Spark, SQL e Power BI.

Prerequisiti

- Un'area di lavoro infrastruttura associata a una capacità di Infrastruttura. Vedere Identità dell'area di lavoro.

- Creare un'identità dell'area di lavoro associata all'area di lavoro Infrastruttura.

- L'account utente o l'entità servizio usata per la creazione del collegamento devono avere ruoli controllo degli accessi in base al ruolo di Azure nell'account di archiviazione. L'entità deve avere un ruolo collaboratore ai dati BLOB Archiviazione, Archiviazione proprietario dei dati BLOB o Archiviazione ruolo lettore di dati BLOB nell'ambito dell'account di archiviazione oppure un ruolo delegante Archiviazione BLOB nell'ambito dell'account di archiviazione oltre a un ruolo lettore di dati BLOB Archiviazione nell'ambito del contenitore.

- Configurare una regola di istanza della risorsa per l'account di archiviazione.

Nota

I collegamenti preesistenti in un'area di lavoro che soddisfa i prerequisiti inizieranno automaticamente a supportare l'accesso al servizio attendibile.

Passaggi

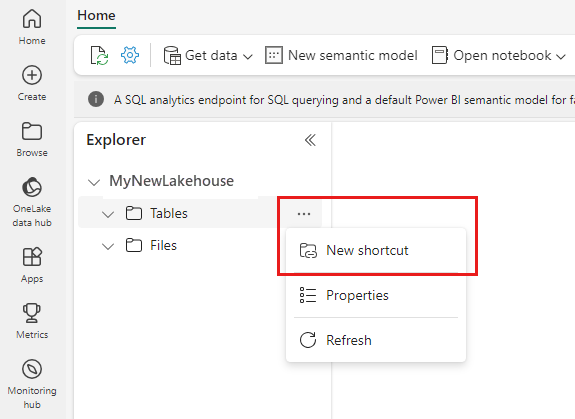

Per iniziare, creare un nuovo collegamento in una lakehouse.

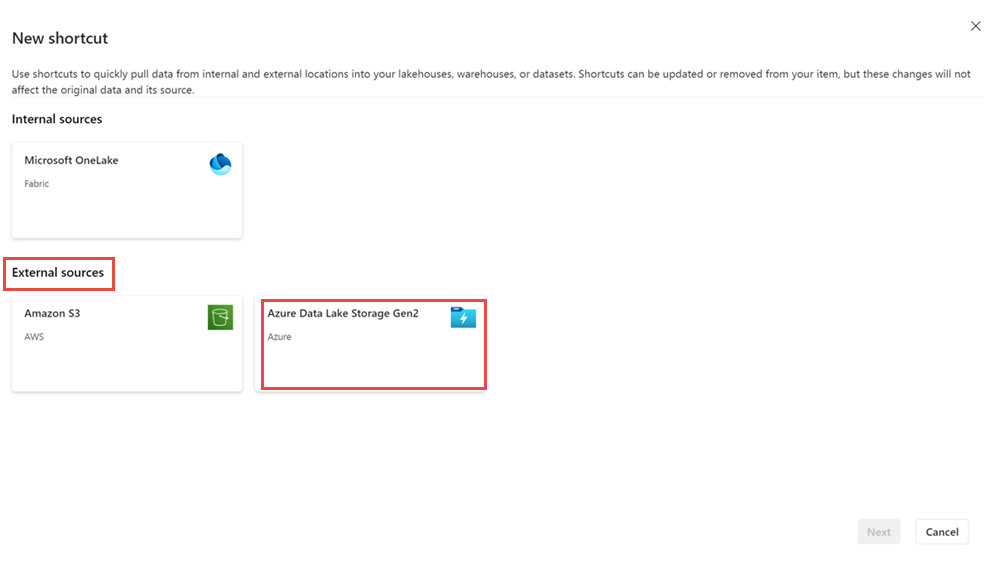

Verrà visualizzata la procedura guidata Nuovo collegamento.

In Origini esterne selezionare Azure Data Lake Archiviazione Gen 2.

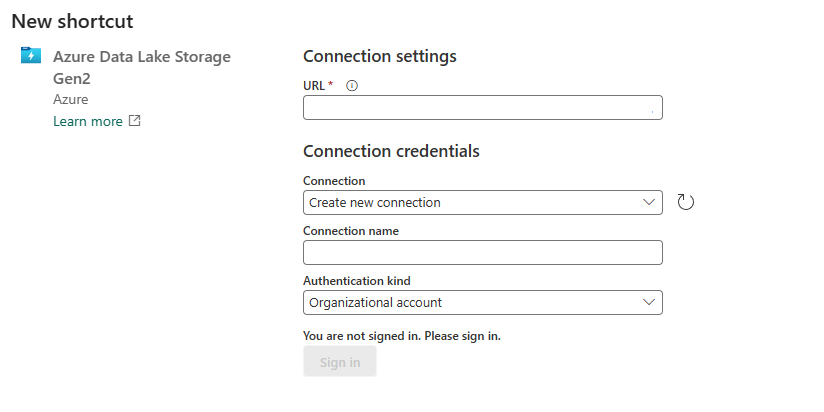

Specificare l'URL dell'account di archiviazione configurato con accesso all'area di lavoro attendibile e scegliere un nome per la connessione. Per Tipo di autenticazione scegliere Account aziendale o Entità servizio.

Al termine scegliere Avanti.

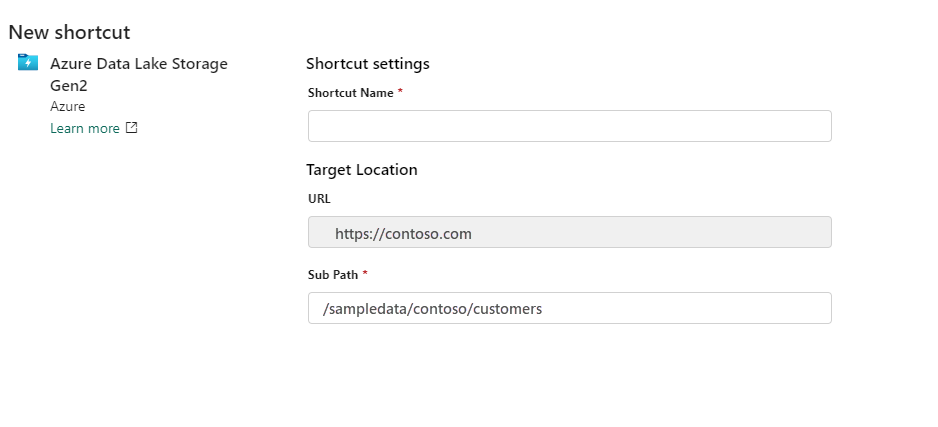

Specificare il nome del collegamento e il percorso secondario.

Al termine, scegliere Crea.

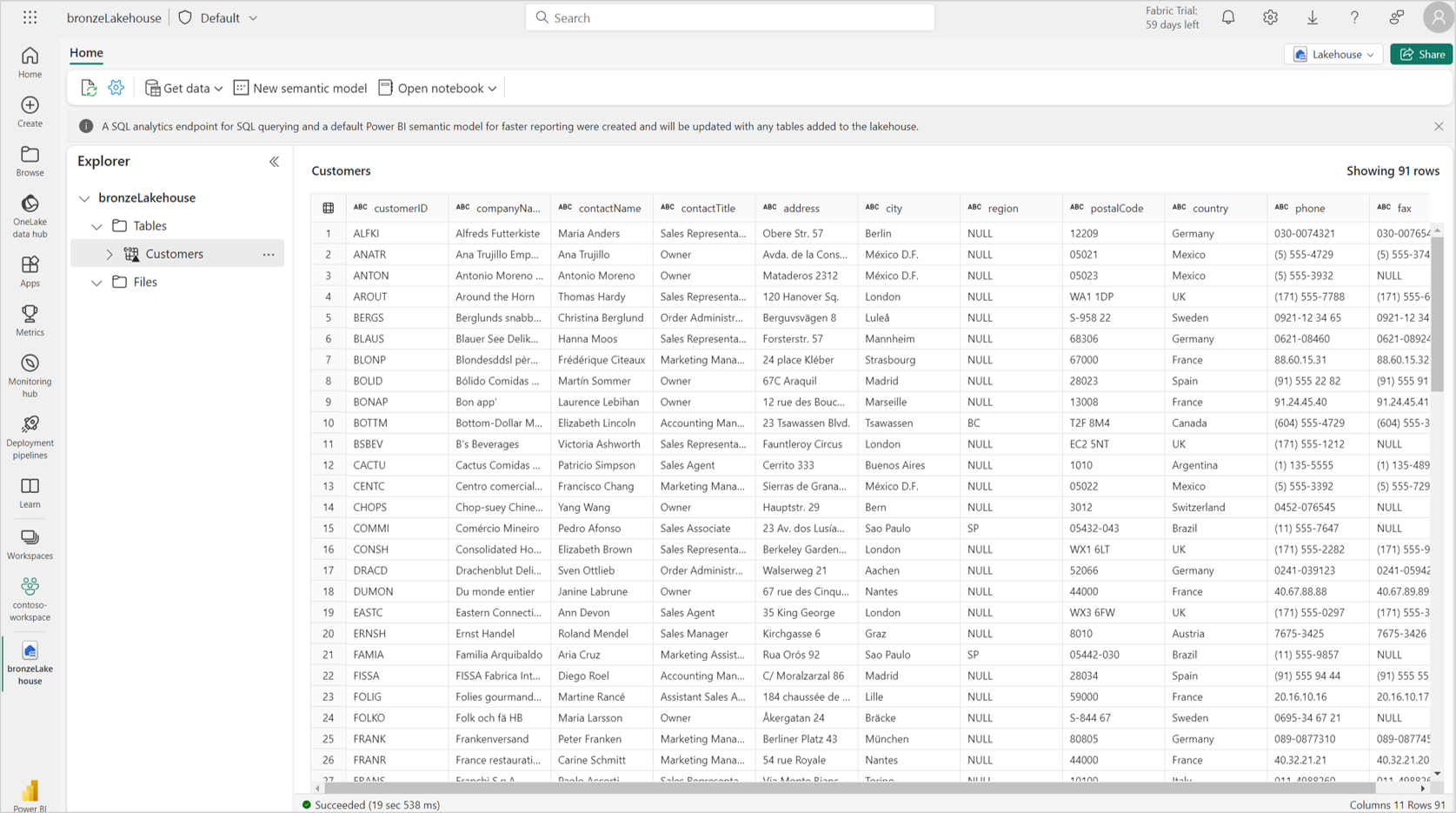

Il collegamento lakehouse viene creato e dovrebbe essere possibile visualizzare in anteprima i dati di archiviazione nel collegamento.

Usare il collegamento OneLake a un account di archiviazione con accesso all'area di lavoro attendibile negli elementi di Fabric

Con OneCopy in Fabric è possibile accedere ai collegamenti OneLake con accesso attendibile da tutti i carichi di lavoro di Fabric.

Spark: è possibile usare Spark per accedere ai dati dai collegamenti a OneLake. Quando i collegamenti vengono usati in Spark, vengono visualizzati come cartelle in OneLake. È sufficiente fare riferimento al nome della cartella per accedere ai dati. È possibile usare il collegamento OneLake agli account di archiviazione con accesso all'area di lavoro attendibile nei notebook Spark.

Endpoint SQL: i collegamenti creati nella sezione "Tabelle" del lakehouse sono disponibili anche nell'endpoint SQL. È possibile aprire l'endpoint SQL ed eseguire query sui dati esattamente come qualsiasi altra tabella.

Pipeline: le pipeline di dati possono accedere ai collegamenti gestiti agli account di archiviazione con accesso all'area di lavoro attendibile. Le pipeline di dati possono essere usate per leggere o scrivere in account di archiviazione tramite collegamenti a OneLake.

Flussi di dati v2: i flussi di dati Gen2 possono essere usati per accedere ai collegamenti gestiti agli account di archiviazione con accesso all'area di lavoro attendibile. I flussi di dati Gen2 possono leggere o scrivere in account di archiviazione tramite collegamenti OneLake.

Modelli e report semantici: il modello semantico predefinito associato a un endpoint SQL lakehouse può leggere collegamenti gestiti agli account di archiviazione con accesso all'area di lavoro attendibile. Per visualizzare le tabelle gestite nel modello semantico predefinito, passare all'endpoint SQL, selezionare Creazione di report e scegliere Aggiorna automaticamente il modello semantico.

È anche possibile creare nuovi modelli semantici che fanno riferimento a collegamenti di tabella agli account di archiviazione con accesso all'area di lavoro attendibile. Passare all'endpoint SQL, selezionare Creazione di report e scegliere Nuovo modello semantico.

È possibile creare report oltre ai modelli semantici predefiniti e ai modelli semantici personalizzati.

Database KQL: è anche possibile creare collegamenti OneLake ad Azure Data Lake Archiviazione Gen 2 in un database KQL. I passaggi per creare il collegamento gestito con l'accesso all'area di lavoro attendibile rimangono invariati.

Creare una pipeline di dati in un account di archiviazione con accesso all'area di lavoro attendibile

Con l'identità dell'area di lavoro configurata in Fabric e l'accesso attendibile abilitato nell'account di archiviazione DI ADLS Gen2, è possibile creare pipeline di dati per accedere ai dati da Fabric. È possibile creare una nuova pipeline di dati per copiare i dati in un'infrastruttura lakehouse e quindi iniziare ad analizzare i dati con Spark, SQL e Power BI.

Prerequisiti

- Un'area di lavoro infrastruttura associata a una capacità di Infrastruttura. Vedere Identità dell'area di lavoro.

- Creare un'identità dell'area di lavoro associata all'area di lavoro Infrastruttura.

- L'account utente o l'entità servizio usata per la creazione della connessione devono avere ruoli controllo degli accessi in base al ruolo di Azure nell'account di archiviazione. L'entità deve avere un ruolo di collaboratore ai dati BLOB Archiviazione, Archiviazione proprietario dei dati BLOB o Archiviazione ruolo lettore di dati BLOB nell'ambito dell'account di archiviazione.

- Configurare una regola di istanza della risorsa per l'account di archiviazione.

Passaggi

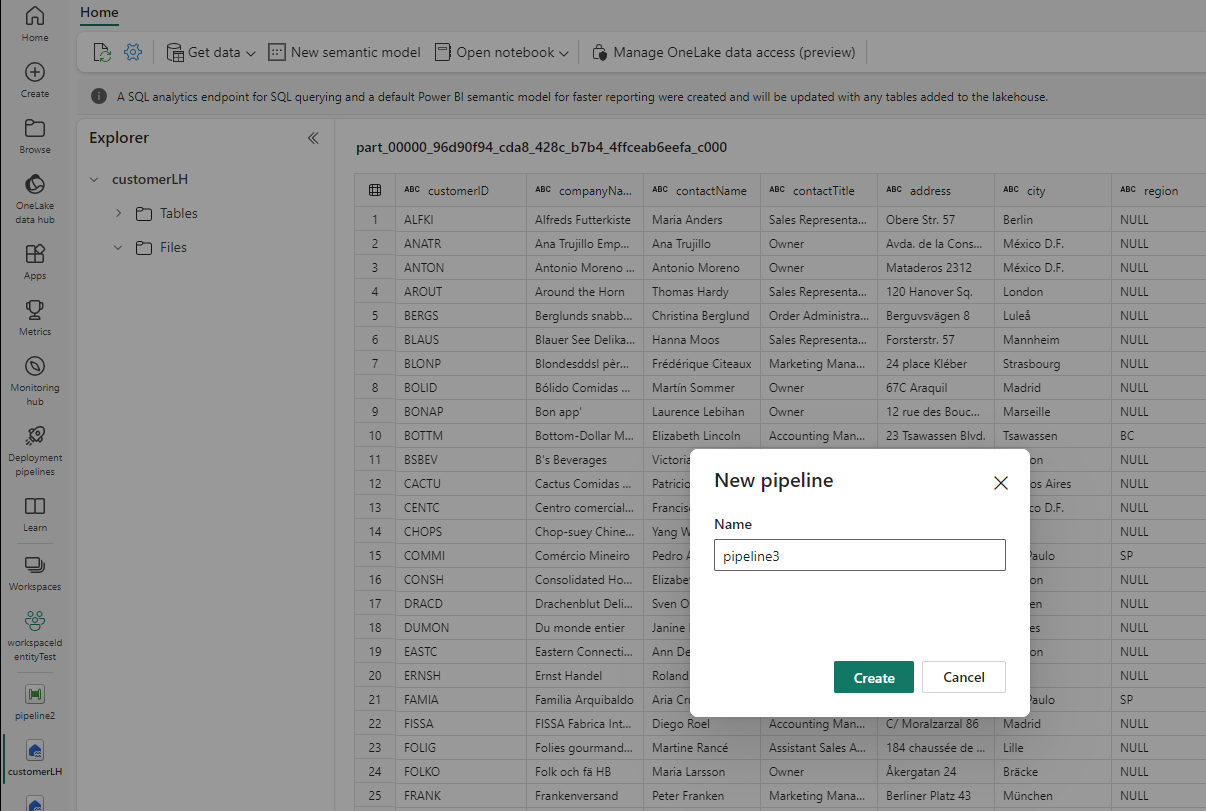

Per iniziare, selezionare Recupera dati in un lakehouse.

Selezionare Nuova pipeline di dati. Specificare un nome per la pipeline e quindi selezionare Crea.

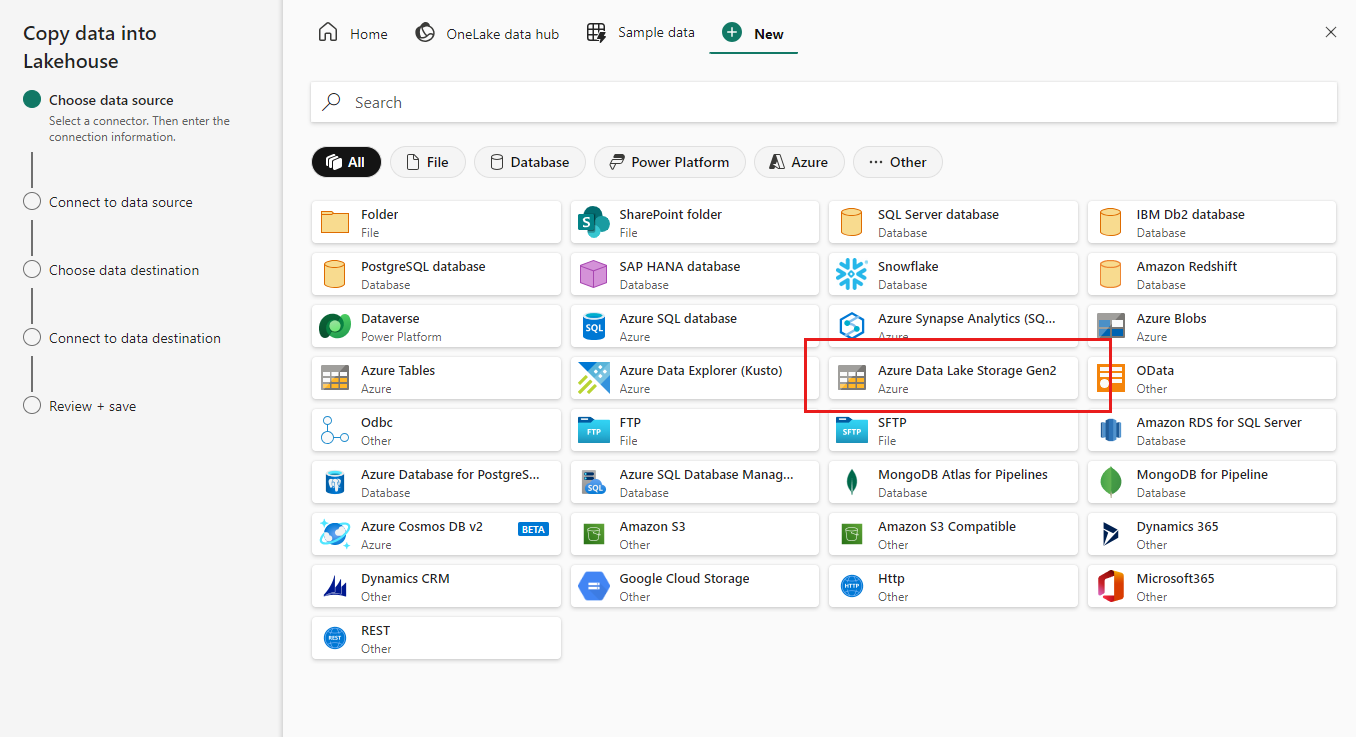

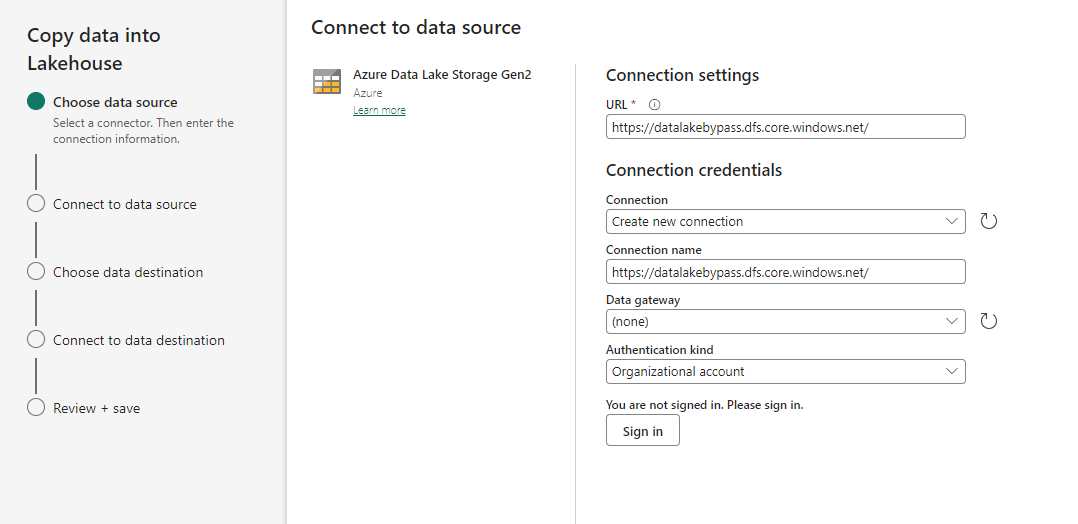

Scegliere Azure Data Lake Gen 2 come origine dati.

Specificare l'URL dell'account di archiviazione configurato con accesso all'area di lavoro attendibile e scegliere un nome per la connessione. Per Tipo di autenticazione scegliere Account aziendale o Entità servizio.

Al termine scegliere Avanti.

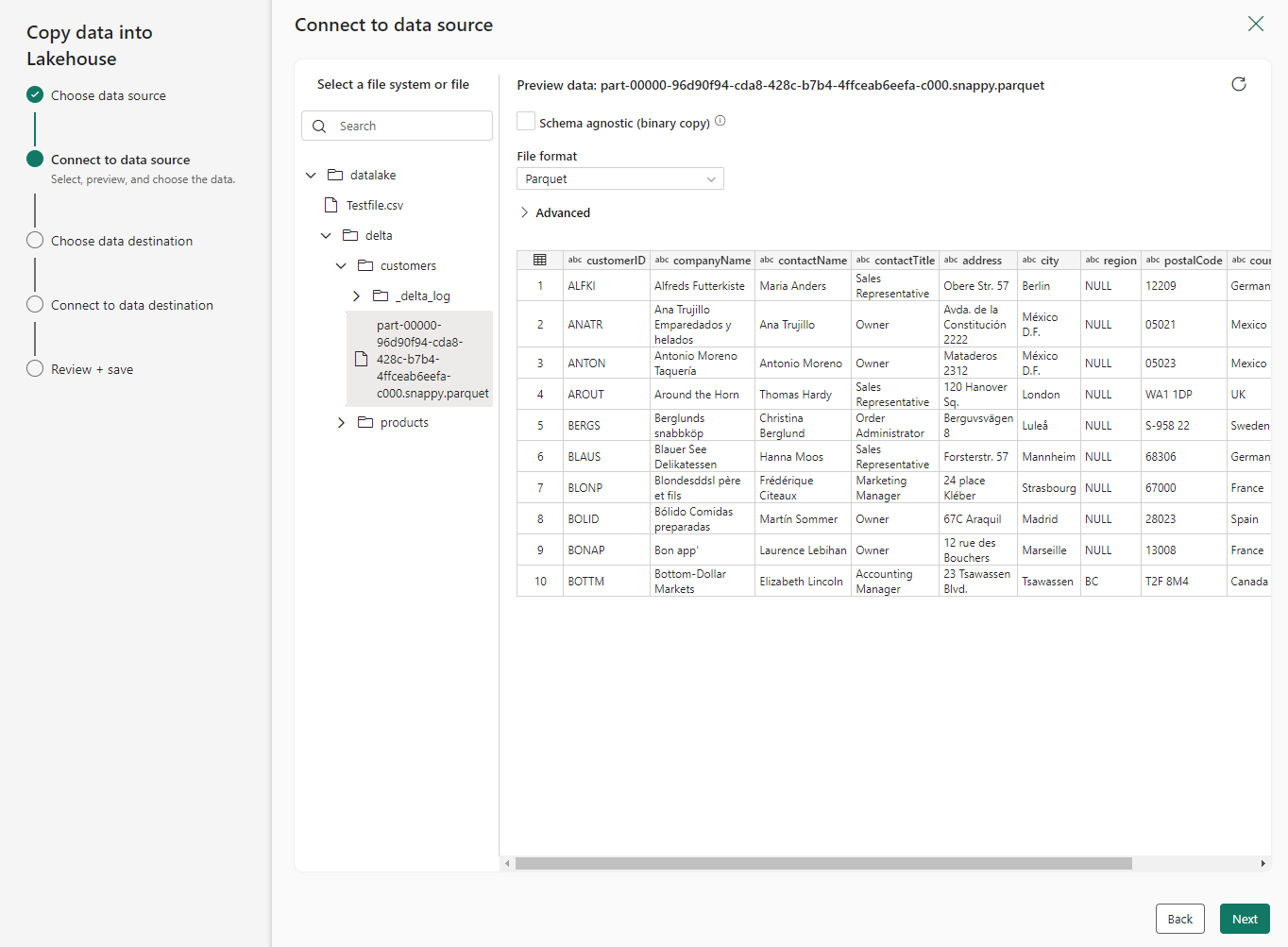

Selezionare il file che è necessario copiare nella lakehouse.

Al termine scegliere Avanti.

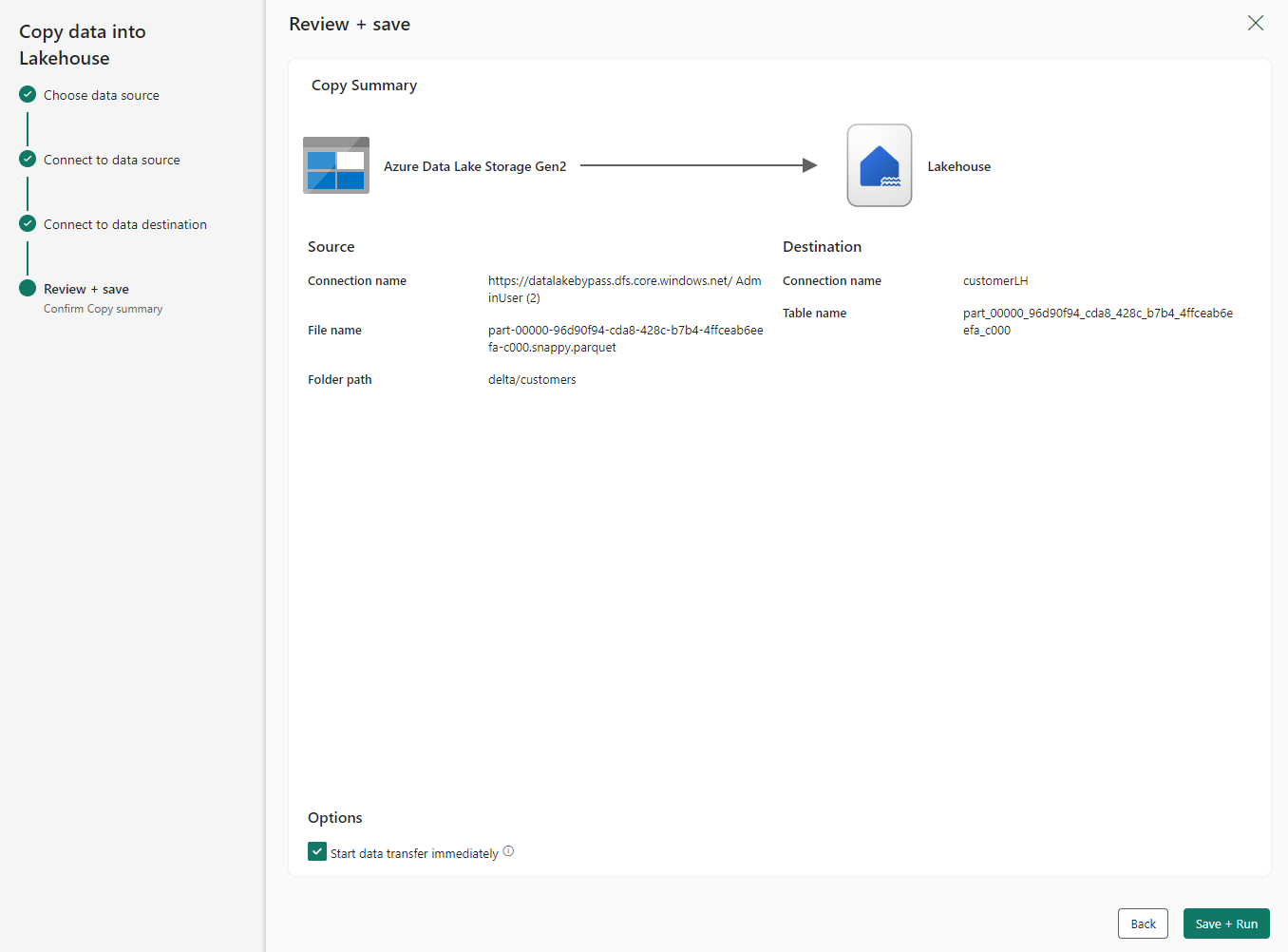

Nella schermata Rivedi e salva selezionare Avvia trasferimento dati immediatamente. Al termine, selezionare Salva + Esegui.

Quando lo stato della pipeline passa da Queued a Succeeded, passare al lakehouse e verificare che le tabelle di dati siano state create.

Restrizioni e considerazioni

- L'accesso all'area di lavoro attendibile è supportato solo per le aree di lavoro nelle capacità di Infrastruttura (F64 o versione successiva).

- È possibile usare l'accesso all'area di lavoro attendibile solo in collegamenti a OneLake e nelle pipeline di dati. Per accedere in modo sicuro agli account di archiviazione da Fabric Spark, vedere Endpoint privati gestiti per Fabric.

- Se viene eseguita la migrazione di un'area di lavoro con un'identità dell'area di lavoro a una capacità non infrastruttura o a una capacità infrastruttura inferiore a F64, l'accesso all'area di lavoro attendibile smetterà di funzionare dopo un'ora.

- I collegamenti preesistenti creati prima del 10 ottobre 2023 non supportano l'accesso all'area di lavoro attendibile.

- non è possibile creare o modificare Connessione ions per l'accesso all'area di lavoro attendibile in Gestire connessioni e gateway.

- Se si riutilizzano le connessioni che supportano l'accesso all'area di lavoro attendibile negli elementi di Infrastruttura diversi da collegamenti e pipeline o in altre aree di lavoro, potrebbero non funzionare.

- Solo l'account aziendale o l'entità servizio devono essere usati per l'autenticazione agli account di archiviazione per l'accesso all'area di lavoro attendibile.

- Le pipeline non possono scrivere collegamenti a tabelle OneLake sugli account di archiviazione con accesso all'area di lavoro attendibile. Si tratta di una limitazione temporanea.

- È possibile configurare un massimo di 200 regole dell'istanza di risorsa. Per altre informazioni, vedere Limiti e quote delle sottoscrizioni di Azure - Azure Resource Manager.

- L'accesso all'area di lavoro attendibile funziona solo quando l'accesso pubblico è abilitato da reti virtuali e indirizzi IP selezionati.

- Le regole dell'istanza di risorsa per le aree di lavoro di Infrastruttura devono essere create tramite i modelli di Resource Manager. Le regole dell'istanza di risorsa create tramite l'interfaccia utente di portale di Azure non sono supportate.

- I collegamenti preesistenti in un'area di lavoro che soddisfa i prerequisiti inizieranno automaticamente a supportare l'accesso al servizio attendibile.

Esempio di modello di Resource Manager

{

"$schema": "https://schema.management.azure.com/schemas/2019-04-01/deploymentTemplate.json#",

"contentVersion": "1.0.0.0",

"resources": [

{

"type": "Microsoft.Storage/storageAccounts",

"apiVersion": "2023-01-01",

"name": "<storage account name>",

"id": "/subscriptions/<subscription id of storage account>/resourceGroups/<resource group name>/providers/Microsoft.Storage/storageAccounts/<storage account name>",

"location": "<region>",

"sku": {

"name": "Standard_RAGRS",

"tier": "Standard"

},

"kind": "StorageV2",

"properties": {

"networkAcls": {

"resourceAccessRules": [

{

"tenantId": "<tenantid>",

"resourceId": "/subscriptions/00000000-0000-0000-0000-000000000000/resourcegroups/Fabric/providers/Microsoft.Fabric/workspaces/<workspace-id>"

}]

}

}

}

]

}

Contenuto correlato

Commenti e suggerimenti

Presto disponibile: Nel corso del 2024 verranno gradualmente disattivati i problemi di GitHub come meccanismo di feedback per il contenuto e ciò verrà sostituito con un nuovo sistema di feedback. Per altre informazioni, vedere https://aka.ms/ContentUserFeedback.

Invia e visualizza il feedback per