Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Importante

Il supporto dello studio di Azure Machine Learning (versione classica) terminerà il 31 agosto 2024. È consigliabile passare ad Azure Machine Learning entro tale data.

A partire dal 1° dicembre 2021 non sarà possibile creare nuove risorse dello studio di Azure Machine Learning (versione classica). Fino al 31 agosto 2024 sarà possibile continuare a usare le risorse dello studio di Azure Machine Learning (versione classica).

- Vedere leinformazioni sullo spostamento di progetti di Machine Learning da ML Studio (versione classica) ad Azure Machine Learning.

- Altre informazioni sulle Azure Machine Learning.

La documentazione relativa allo studio di Machine Learning (versione classica) è in fase di ritiro e potrebbe non essere aggiornata in futuro.

Carica i dati da origini esterne sul Web; da varie forme di archiviazione basata sul cloud in Azure, ad esempio tabelle, BLOB e database SQL e da database SQL Server locali

Categoria: Input e output dei dati

Nota

Si applica a: solo Machine Learning Studio (versione classica)

I moduli di trascinamento della selezione simili sono disponibili in Azure Machine Learning finestra di progettazione.

Panoramica del modulo

Questo articolo descrive come usare il modulo Importa dati in Machine Learning Studio (versione classica) per caricare i dati in un esperimento di Machine Learning da servizi dati cloud esistenti.

Il modulo include ora una procedura guidata che consente di scegliere un'opzione di archiviazione e selezionare tra sottoscrizioni e account esistenti per configurare rapidamente tutte le opzioni. È necessario modificare una connessione dati esistente? Nessun problema; La procedura guidata carica tutti i dettagli di configurazione precedenti in modo che non sia necessario ricominciare da zero.

Dopo aver definito i dati desiderati e connessi all'origine, Importa dati deduce il tipo di dati di ogni colonna in base ai valori contenuti e carica i dati nell'area di lavoro di Machine Learning Studio (versione classica). L'output di Import Data è un set di dati che può essere usato con qualsiasi esperimento.

Importante

Attualmente, esistono limitazioni per i tipi di account di archiviazione supportati. Per altre informazioni, vedere Note tecniche.

Se i dati di origine cambiano, è possibile aggiornare il set di dati e aggiungere nuovi dati eseguendo di nuovo Importa dati. Tuttavia, se non si vuole ripetere la lettura dall'origine ogni volta che si esegue l'esperimento, selezionare l'opzione Usa risultati memorizzati nella cache su TRUE. Quando questa opzione è selezionata, il modulo controlla se l'esperimento è stato eseguito in precedenza usando la stessa origine e le stesse opzioni di input. Se viene trovata un'esecuzione precedente, i dati nella cache vengono usati anziché ricaricare i dati dall'origine.

Nota

Questo modulo era precedentemente denominato Reader. Se in precedenza è stato usato il modulo Reader in un esperimento, viene rinominato Importa dati quando si aggiorna l'esperimento.

Origini dati

Il modulo Import Data supporta le origini dati seguenti. Fare clic sui collegamenti per istruzioni dettagliate ed esempi sull'uso di ogni origine dati.

Se non si è certi di come o dove archiviare i dati, vedere questa guida agli scenari di dati comuni nel processo di data science: Scenari per l'analisi avanzata in Machine Learning.

| Origine dati | Usato con |

|---|---|

| URL Web tramite HTTP | Ottenere dati ospitati in un URL Web che usa HTTP e forniti nei formati CSV, TSV, ARFF o SvmLight |

| Hive Query | Ottenere dati dall'archiviazione distribuita in Hadoop. Specificare i dati desiderati usando il linguaggio HiveQL |

| Database SQL di Azure | Ottenere dati da database SQL di Azure o da Azure SQL Data Warehouse |

| Tabella di Azure | Ottenere i dati archiviati nel servizio tabelle di Azure |

| Importare da Archiviazione BLOB di Azure | Ottenere i dati archiviati nel servizio BLOB di Azure |

| Provider di feed di dati | Ottenere i dati esposti come feed in formato OData |

| Importare da un database di SQL Server locale | Ottenere dati da un database SQL Server locale usando Microsoft Gestione dati Gateway |

| Azure Cosmos DB | Ottenere i dati archiviati in formato JSON in Azure Cosmos DB. |

Suggerimento

È necessario importare dati nel formato JSON? Sia R che Python supportano le API REST, quindi usare i moduli Execute Python Script (Esegui script Python) o Execute R Script (Esegui script R) per analizzare i dati e salvarli come set di dati di Azure ML.

In alternativa, usare l'API SQL DB per CosmosDB, che supporta più archivi JSON, tra cui MongoDB, per leggere i dati usando l'opzione Importa da Azure Cosmos DB. Per altre informazioni, vedere Importare da Azure Cosmos DB.

Come usare Importa dati

Aggiungere il modulo Import Data (Importa dati ) all'esperimento. Questo modulo è disponibile nella categoria Input e output dei dati in Studio (versione classica).

Fare clic su Avvia importazione guidata dati per configurare l'origine dati tramite una procedura guidata.

La procedura guidata ottiene il nome e le credenziali dell'account e consente di configurare altre opzioni. Se si modifica una configurazione esistente, carica prima i valori correnti.

Se non si vuole usare la procedura guidata, fare clic su Origine dati e scegliere il tipo di archiviazione basata sul cloud da cui si esegue la lettura.

Le impostazioni aggiuntive dipendono dal tipo di archiviazione scelto e dal fatto che l'archiviazione sia protetta o meno. Potrebbe essere necessario specificare il nome dell'account, il tipo di file o le credenziali. Alcune origini non richiedono l'autenticazione; per altri utenti, potrebbe essere necessario conoscere il nome dell'account, una chiave o il nome del contenitore.

Per informazioni dettagliate, vedere l'elenco delle origini dati.

Selezionare l'opzione Usa risultati memorizzati nella cache se si vuole memorizzare nella cache il set di dati da riutilizzare nelle esecuzioni successive.

Supponendo che non siano state apportate altre modifiche ai parametri del modulo, l'esperimento carica i dati solo la prima volta che il modulo viene eseguito e successivamente usa una versione memorizzata nella cache del set di dati.

Deselezionare questa opzione se è necessario ricaricare i dati ogni volta che si esegue l'esperimento.

Eseguire l'esperimento.

Quando Importa dati carica i dati in Studio (versione classica), deduce il tipo di dati di ogni colonna in base ai valori contenuti, numerici o categorici.

Se è presente un'intestazione, questa viene usata per assegnare un nome alle colonne dal set di dati di output.

Se non sono presenti intestazioni di colonna esistenti nei dati, i nuovi nomi di colonna vengono generati usando il formato col1, col2,... , coln.

Risultati

Al termine dell'importazione, fare clic sul set di dati di output e selezionare Visualizza per verificare se i dati sono stati importati correttamente.

Se si desidera salvare i dati da riutilizzare, anziché importare un nuovo set di dati ogni volta che viene eseguito l'esperimento, fare clic con il pulsante destro del mouse sull'output e scegliere Salva come set di dati. Scegliere un nome per il set di dati. Il set di dati salvato mantiene i dati al momento del salvataggio e i dati non vengono aggiornati quando l'esperimento viene nuovamente eseguito, anche se il set di dati nell'esperimento cambia. Ciò può essere utile per creare snapshot di dati.

Dopo l'importazione dei dati, potrebbero essere necessari alcuni preparativi aggiuntivi per la modellazione e l'analisi:

Generare riepiloghi statistici dei dati usando Summarize Data o Compute Elementary Statistics.

Utilizzare Modifica metadati per modificare i nomi delle colonne, gestire una colonna come tipo di dati diverso o per indicare che alcune colonne sono etichette o funzionalità.

Usare Select Columns in Dataset (Seleziona colonne nel set di dati ) per selezionare un subset di colonne da trasformare o usare nella modellazione. Le colonne trasformate o rimosse possono essere facilmente unite al set di dati originale usando il modulo Aggiungi colonne o il modulo Join Data .

Usare Partition e Sample per dividere il set di dati, eseguire il campionamento o ottenere le prime n righe.

Usare Apply SQL Transformation (Applica trasformazione SQL) per aggregare dati, filtrare o trasformare usando istruzioni SQL.

Usare questi moduli per pulire le colonne di testo e generare nuove funzionalità di testo:

- Preprocess Text (Preelabora il testo)

- Extract N-Gram Features from Text

- Riconoscimento di entità denominate

- Eseguire script Python per implementare la prevenzione della perdita di rete personalizzata basata su nltk.

Note tecniche

In questa sezione viene fornito un elenco dei problemi noti relativi al modulo Importa dati , oltre ad alcune informazioni generali sulla risoluzione dei problemi non specifiche di un tipo di origine.

Tipi di account supportati

Spesso Azure rilascia nuovi servizi o nuovi tipi di archiviazione; Tuttavia, si verifica in genere un ritardo durante l'implementazione del supporto per i nuovi tipi di account in Machine Learning Studio (versione classica).

Attualmente, Machine Learning supporta tutti gli account di archiviazione per utilizzo generico, ad eccezione di quelli che usano l'archiviazione con ridondanza della zona.

Sono supportate le opzioni di archiviazione con ridondanza locale e archiviazione con ridondanza geografica.

I BLOB in blocchi sono supportati, ma i BLOB di accodamento non sono.

Domande e problemi comuni

Questa sezione descrive alcuni problemi noti, domande comuni e soluzioni alternative.

Le intestazioni devono essere singole righe

Se si importano da file CSV, tenere presente che Machine Learning consente una singola riga di intestazione. Non è possibile inserire intestazioni a più righe.

Separatori personalizzati supportati nell'importazione ma non nell'esportazione

Il modulo Import Data supporta l'importazione di dati che usano separatori di colonna alternativi, ad esempio il punto e virgola (;), che viene spesso usato in Europa. Quando si importano dati da file CSV in archiviazione esterna, selezionare l'opzione CSV con codifiche e selezionare una codifica supportata.

Non è tuttavia possibile generare separatori alternativi quando si preparano i dati per l'esportazione usando il modulo Converti in csv .

Separazione delle colonne scadente sui dati stringa contenenti virgole

Quasi tutti i caratteri che possono essere specificati come separatore di colonna (tabulazioni, spazi, virgole e così via) possono essere trovati in modo casuale anche nei campi di testo. L'importazione di testo da CSV richiede sempre attenzione per evitare di separare il testo tra nuove colonne non necessarie. Si tratta di un problema comune nell'elaborazione del testo che probabilmente si è verificato e gestito in modi diversi.

I problemi possono verificarsi anche quando si tenta di esportare una colonna di dati stringa che contiene virgole. Machine Learning non supporta alcuna gestione speciale o una traduzione speciale di tali dati, ad esempio racchiudere le stringhe tra virgolette. Inoltre, non è possibile usare caratteri di escape prima di una virgola per assicurarsi che le virgole vengano gestite come carattere letterale. Di conseguenza, i nuovi campi vengono creati nel file di output per ogni virgola rilevata nel campo stringa.

Per evitare problemi durante l'esportazione, usare il modulo Pre-elabora testo per rimuovere i caratteri di punteggiatura dai campi stringa.

È anche possibile usare script R personalizzato o script Python per elaborare testo complesso e assicurarsi che i dati possano essere importati o esportati correttamente.

Codifica UTF-8 obbligatoria

Machine Learning richiede la codifica UTF-8. Se i dati importati usano una codifica diversa o sono stati esportati da un'origine dati che usa una codifica predefinita diversa, potrebbero essere visualizzati vari problemi nel testo.

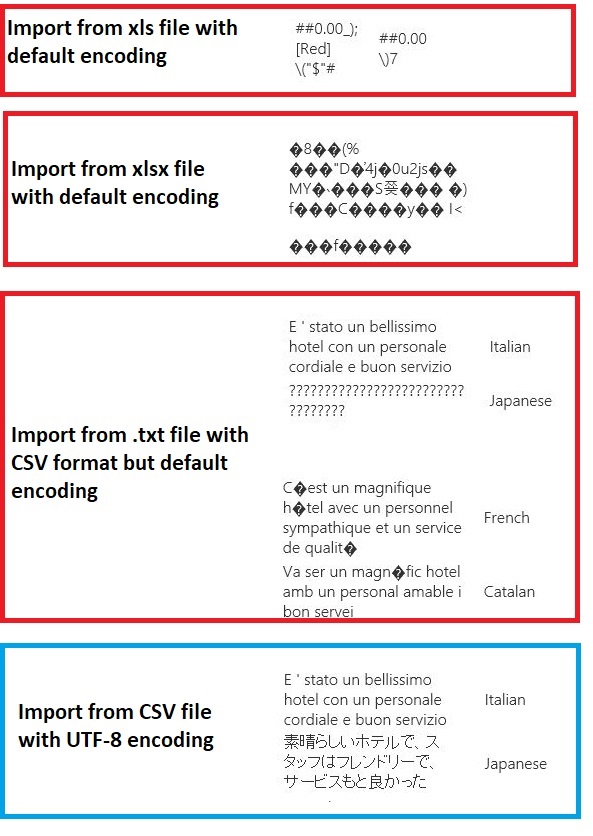

Ad esempio, l'immagine seguente contiene lo stesso set di dati multilanguage esportato da Excel e quindi importato in Machine Learning in quattro combinazioni diverse di tipo di file e codifica.

Il terzo esempio rappresenta i dati persi durante il salvataggio da Excel in formato CSV, perché la codifica corretta non è stata specificata in quel momento. Pertanto, se si verificano problemi, assicurarsi di controllare non solo il file da cui si sta importando, ma se il file è stato esportato correttamente dall'origine.

Il set di dati non ha nomi di colonna

Se il set di dati da importare non include nomi di colonna, assicurarsi di specificare una delle opzioni "nessuna intestazione". In questo caso, Import Data aggiunge nomi di colonna predefiniti usando il formato Col1, Col2 e così via. Successivamente, usare Modifica metadati per correggere i nomi delle colonne.

Se si esporta un set di dati in un file CSV, usare Modifica metadati per aggiungere nomi di colonna prima di convertirlo o esportarlo.

Soluzioni alternative per origini dati non supportate

Se è necessario ottenere dati da un'origine non presente nell'elenco, è possibile provare diverse soluzioni alternative:

Per caricare dati da un file nel computer, fare clic su Nuovo in Studio (versione classica), selezionare Set di dati e quindi selezionare Da file locale. Individuare il file e specificare il formato (TSV, CSV e così via). Per altre informazioni, vedere Importare i dati di training in Studio (versione classica).For more information, see Import training data into Studio (classic).

Usare R o Python. È possibile usare il modulo Execute R Script con un pacchetto R appropriato per ottenere dati da altri database cloud.

Il modulo Execute Python Script consente anche di leggere e convertire i dati da un'ampia gamma di origini. Vedere questi esempi di data scientist Microsoft nella raccolta di intelligence di Cortana:

Ottenere dati dai cluster AWS. È possibile eseguire una query su un cluster Hive generico con WebHCat o endpoint HCatalog abilitato. Oppure pubblicare come pagina e leggere dall'URL Web.

Ottenere dati da MongoDB. L'utilità di migrazione dei dati per Azure Cosmos DB supporta un'ampia gamma di origini e formati. Per altre informazioni ed esempi, vedere Azure Cosmos DB: Strumento di migrazione dei dati

Per altre idee e soluzioni alternative, vedere il forum Machine Learning o Azure AI Gallery.

Parametri del modulo

Ogni origine dati deve essere configurata usando opzioni diverse. Questa tabella elenca solo le opzioni comuni a tutte le origini dati.

| Name | Intervallo | Type | Predefinito | Descrizione |

|---|---|---|---|---|

| Origine dati | Elenco | Origine dati o sink | Servizio BLOB in Archiviazione di Azure | L'origine dati può essere HTTP, HTTPS anonima, un file nel servizio BLOB o nel servizio tabelle, un database SQL in Azure, un Azure SQL Data Warehouse, una tabella Hive o un endpoint OData. |

| Usare i risultati memorizzati nella cache | VERO/FALSO | Boolean | FALSE | Se TRUE, il modulo verificherà se l'esperimento è stato eseguito in precedenza usando la stessa origine e le stesse opzioni di input e, se viene trovata un'esecuzione precedente, vengono usati i dati nella cache. Se FALSE o se vengono trovate modifiche, i dati verranno ricaricati dall'origine. |

Output

| Nome | Tipo | Descrizione |

|---|---|---|

| Set di dati di risultati | Tabella dati | Set di dati con dati scaricati |

Eccezioni

| Eccezione | Descrizione |

|---|---|

| Errore 0027 | Viene generata un'eccezione quando due oggetti che dovrebbero essere delle stesse dimensioni sono differenti. |

| Errore 0003 | Si verifica un'eccezione se uno o più input sono Null o vuoti. |

| Errore 0029 | Viene generata un'eccezione quando viene passato un URI non valido. |

| Errore 0030 | Viene generata un'eccezione se non è possibile scaricare un file. |

| Errore 0002 | Viene generata un'eccezione se non è stato possibile analizzare o convertire uno o più parametri dal tipo specificato nel tipo richiesto dal metodo di destinazione. |

| Errore 0009 | Viene generata un'eccezione se il nome dell'account di Archiviazione di Azure o il nome del contenitore non è stato specificato correttamente. |

| Errore 0048 | Viene generata un'eccezione quando non è possibile aprire un file. |

| Errore 0015 | Viene generata un'eccezione se la connessione al database non è riuscita. |

| Errore 0046 | Viene generata un'eccezione quando non è possibile creare una directory nel percorso specificato. |

| Errore 0049 | Viene generata un'eccezione quando non è possibile analizzare un file. |

Per un elenco di errori specifici dei moduli di Studio (versione classica), vedere Machine Learning Codici di errore.

Per un elenco di eccezioni API, vedere Machine Learning codici di errore dell'API REST.

Vedi anche

Input e output dei dati

Conversioni di formato dati

Esportazione dei dati

Elenco moduli A-Z