Esercizio - Integrare e usare riconoscimento vocale e trascrizione

In questo modulo verrà creata un'applicazione di Realtà mista per esplorare l'uso dei servizi Voce di Azure con HoloLens 2. Al termine di questa serie, sarà possibile usare il microfono del dispositivo per trascrivere il parlato in tempo reale, tradurre il parlato in altre lingue e usare la funzionalità Riconoscimento finalità per comprendere i comandi vocali usando l'intelligenza artificiale.

Creare e preparare il progetto Unity

In questa sezione verrà creato un nuovo progetto Unity per prepararsi allo sviluppo con MRTK.

Come prerequisito, assicurarsi di aver completato i passaggi seguenti per inizializzare il progetto e l'applicazione:

- Creazione del progetto Unity e assegnazione di un nome appropriato, ad esempio MRTK Tutorials

- Passaggio a un'altra piattaforma di compilazione

- Importazione delle risorse essenziali TextMeshPro

- Importazione di Mixed Reality Toolkit

- Configurazione del progetto Unity

- Creazione e configurazione della scena e assegnazione di un nome appropriato; Ad esempio, AzureSpeechServices

Nota

Per informazioni su come configurare il progetto di realtà mista, vedere il modulo Introduzione a Realtà mista Toolkit.

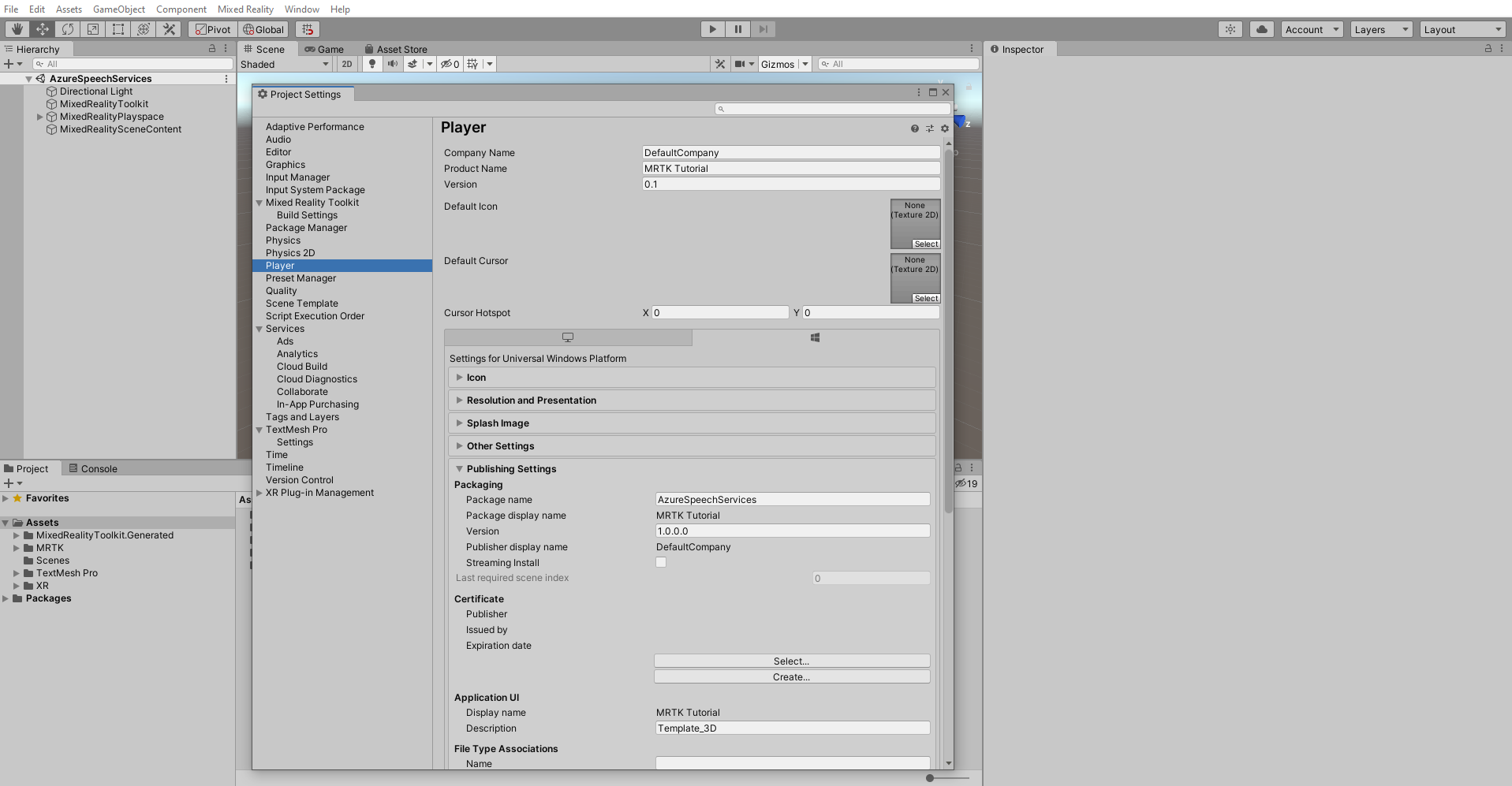

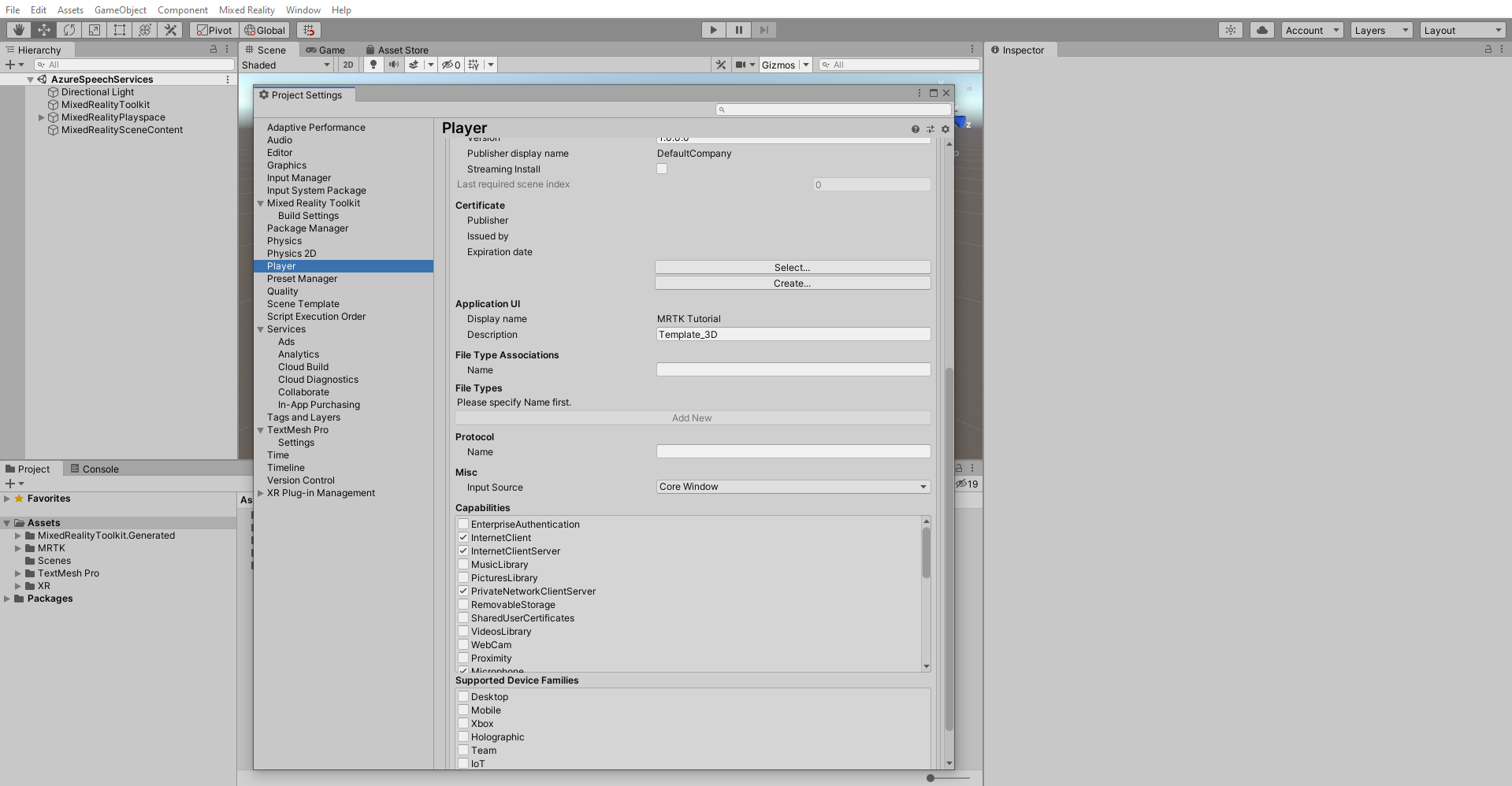

Configurare le funzionalità

Dal menu Unity scegli Edit>Project Settings... (Modifica > Impostazioni del progetto) per aprire la finestra Project Settings (Impostazioni del progetto) e quindi individua la sezione Player>Publishing Settings (Lettore > Impostazioni di pubblicazione):

In Impostazioni di pubblicazione scorrere verso il basso fino alla sezione Funzionalità e verificare che siano abilitate le funzionalità InternetClient, Microfono e SpatialPerception, che sono state abilitate al momento della creazione del progetto all'inizio dell'esercitazione. Abilitare quindi le funzionalità InternetClientServer e PrivateNetworkClientServer .

Importare gli asset dell'esercitazione

Scaricare e importare i pacchetti personalizzati unity seguenti nell'ordine in cui sono elencati:

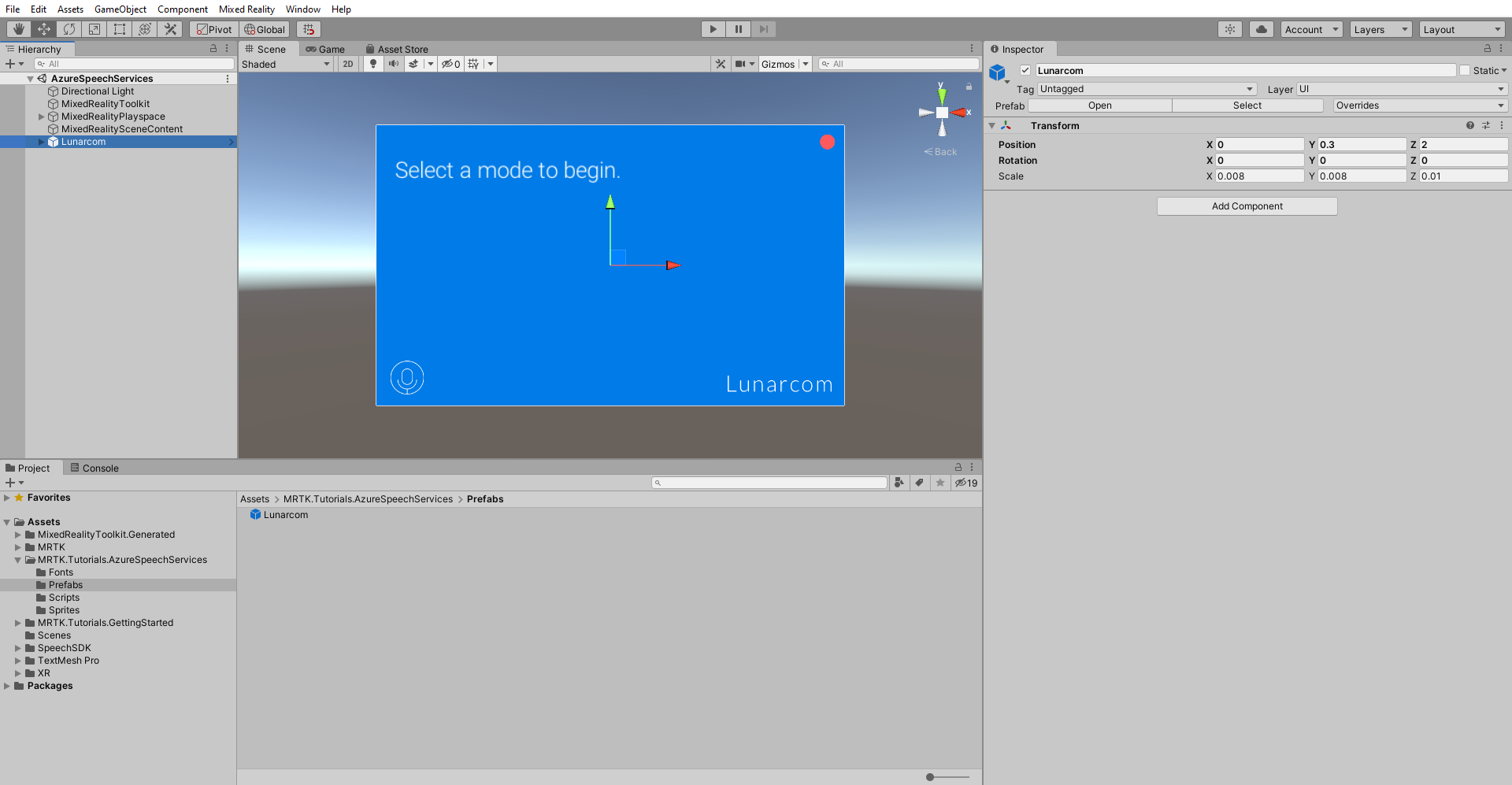

Dopo aver importato gli asset dell'esercitazione, la finestra Progetto avrà un aspetto simile al seguente:

Preparare la scena

In questa sezione si preparerà la scena aggiungendo il prefab dell'esercitazione e si configurerà il componente Lunarcom Controller (Script) per controllare la scena.

Nella finestra Progetto passare a Asset>MRTK. Tutorials.AzureSpeechServices Prefabs> cartella e trascinare il prefab Lunarcom nella finestra Hierarchy (Gerarchia) per aggiungerlo alla scena.

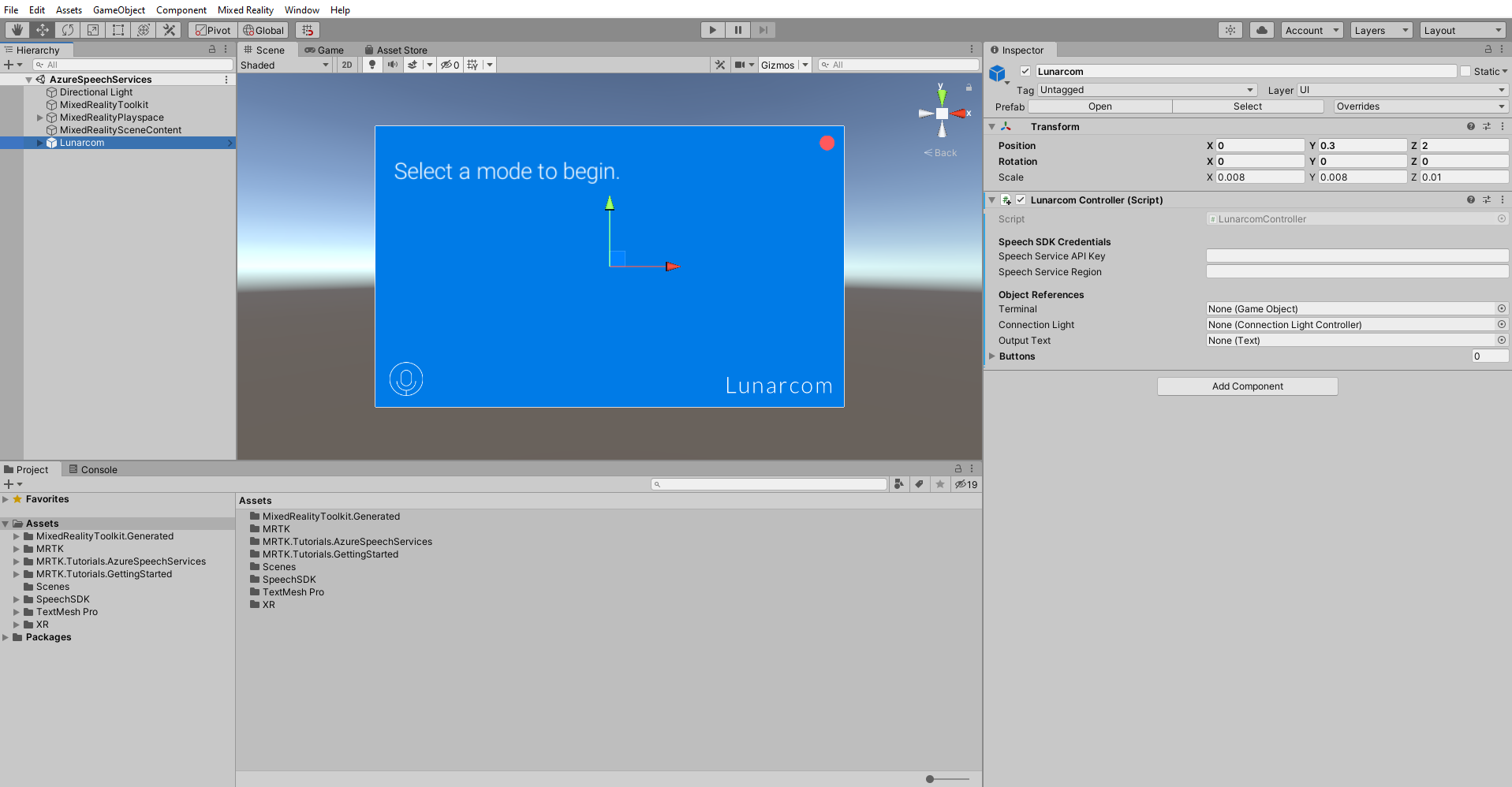

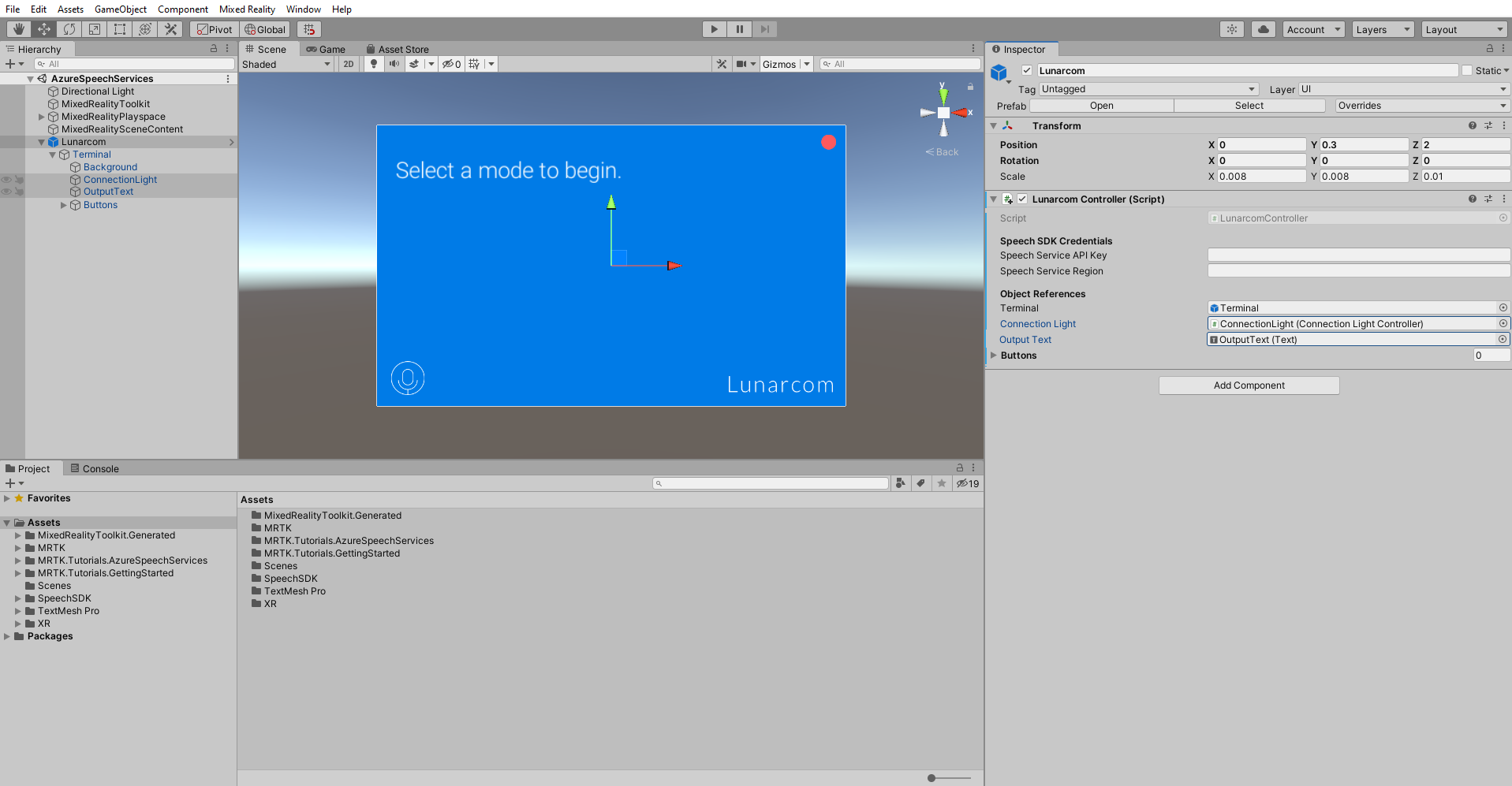

Con l'oggetto Lunarcom ancora selezionato nella finestra Hierarchy (Gerarchia), nella finestra Inspector (Controllo) usare il pulsante Aggiungi componente per aggiungere il componente Lunarcom Controller (Script) all'oggetto Lunarcom.

Con l'oggetto Lunarcom ancora selezionato, espanderlo per visualizzare i relativi oggetti figlio, quindi trascinare l'oggetto Terminal nel campo Terminale del componente Lunarcom Controller (Script).

Con l'oggetto Lunarcom ancora selezionato, espandere l'oggetto Terminal per visualizzare gli oggetti figlio, quindi trascinare l'oggetto Connessione ionLight nel campo Connessione Ion Light del componente Lunarcom Controller (Script) e l'oggetto OutputText nel campo Testo di output.

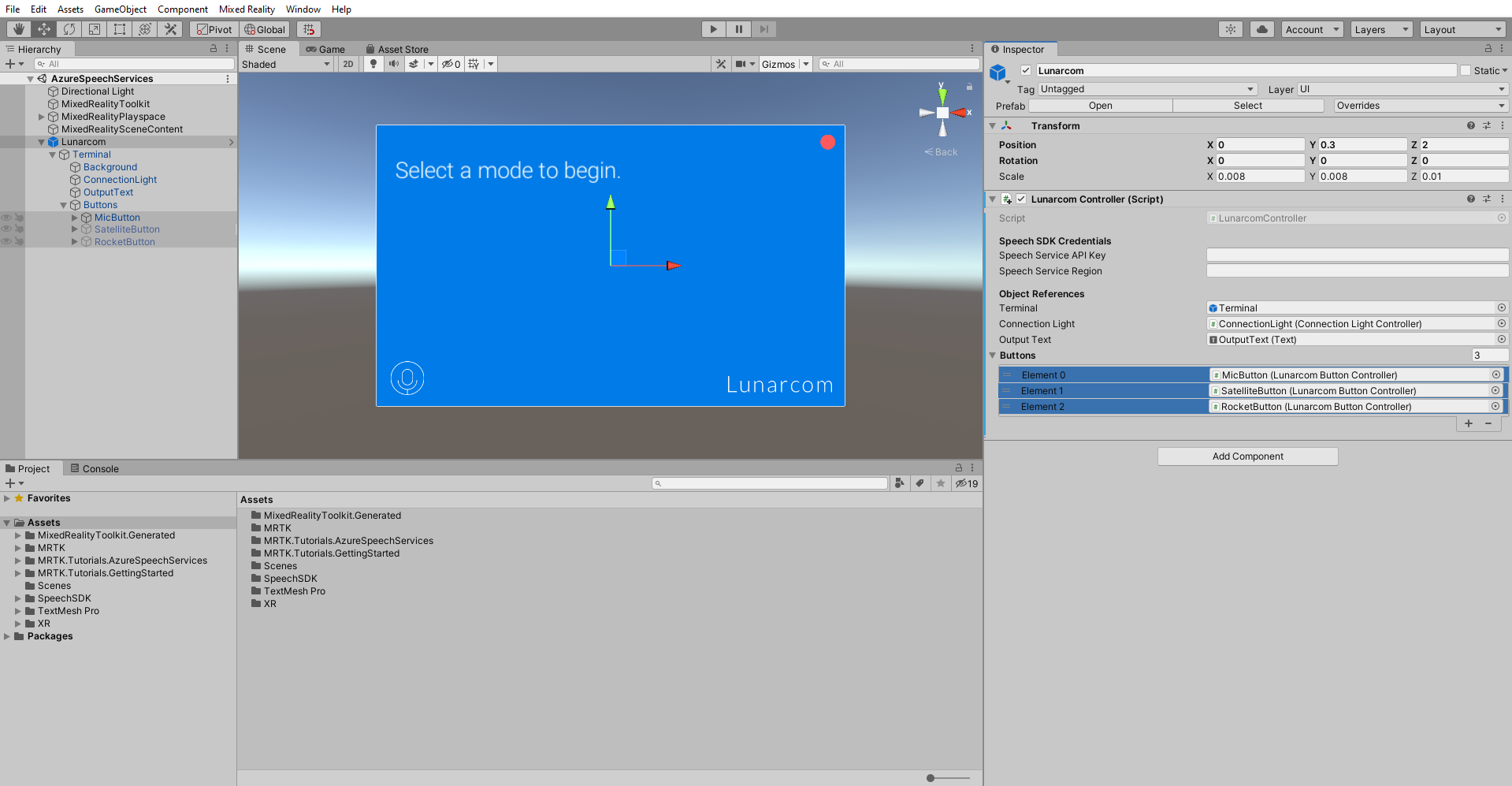

Con l'oggetto Lunarcom ancora selezionato, espandere l'oggetto Buttons per visualizzare gli oggetti figlio, quindi nella finestra Inspector espandere l'elenco Pulsanti, impostare il campo Buttons su 3 e trascinare gli oggetti MicButton, SatelliteButton e RocketButton rispettivamente nei campi Element 0, 1 e 2.

Collegare il progetto Unity alla risorsa di Azure

Per usare i servizi vocali di Azure, devi creare una risorsa di Azure e ottenere una chiave API per il servizio vocale. Seguire le istruzioni di avvio rapido e prendere nota dell'area del servizio (nota anche come Località) e della chiave API (nota anche come Key1 o Key2).

Nella finestra Hierarchy (Gerarchia) seleziona l'oggetto Lunarcom e quindi nella finestra Inspector (Controllo) individua la sezione Speech SDK Credentials (Credenziali Speech SDK) del componente Lunarcom Controller (Script) (Controller Lunarcom - Script) e configurala come indicato di seguito:

- Nel campo Chiave API servizio voce immettere la chiave API (Key1 o Key2).

- Nel campo Area servizio voce immettere l'area del servizio (località) usando lettere minuscole e spazi rimossi.

Usare il riconoscimento vocale per la trascrizione di testo

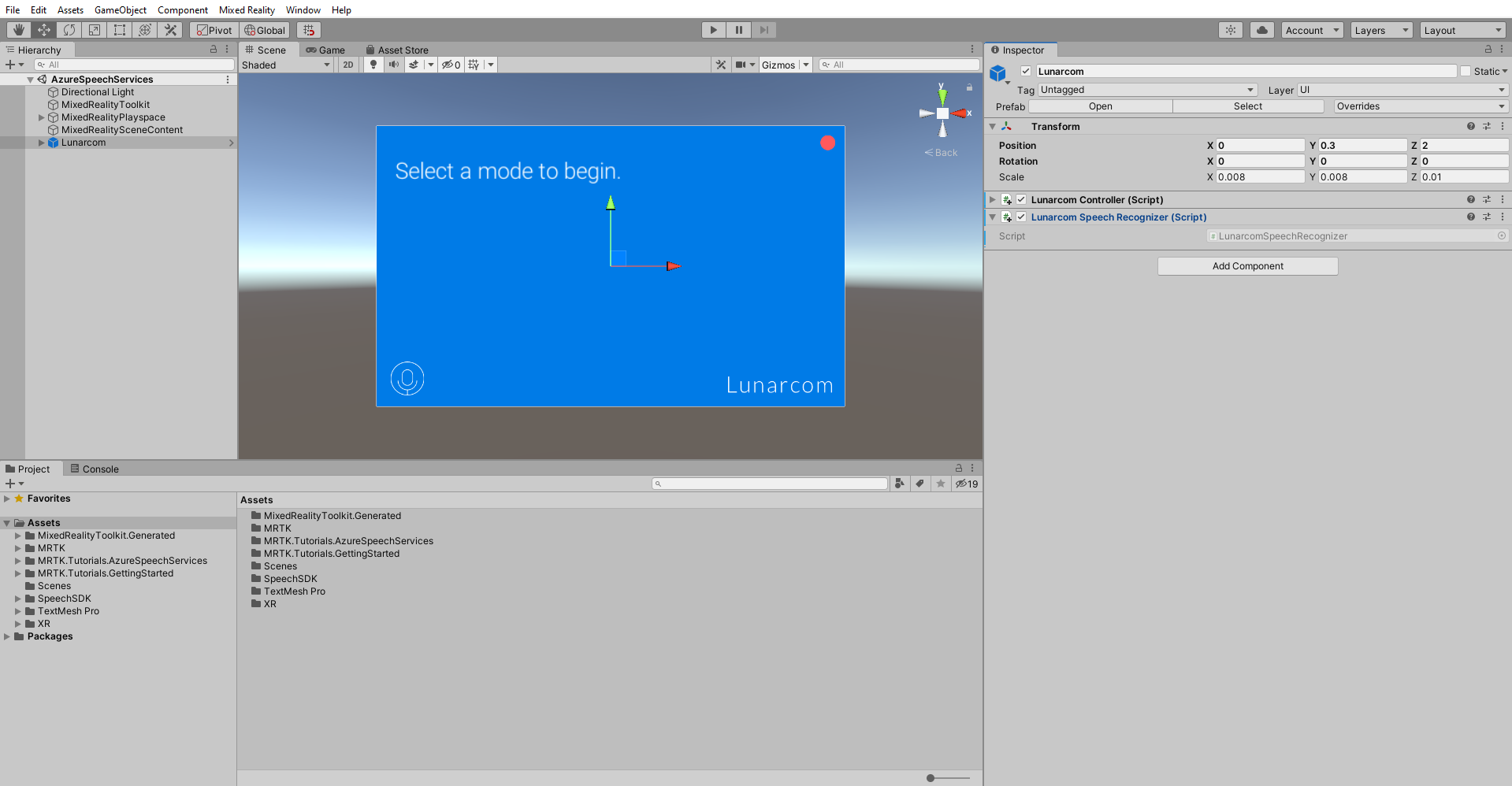

Nella finestra Hierarchy (Gerarchia) selezionare l'oggetto Lunarcom , quindi nella finestra Inspector (Controllo) usare il pulsante Aggiungi componente per aggiungere il componente Lunarcom Speech Recognizer (Script) all'oggetto Lunarcom.

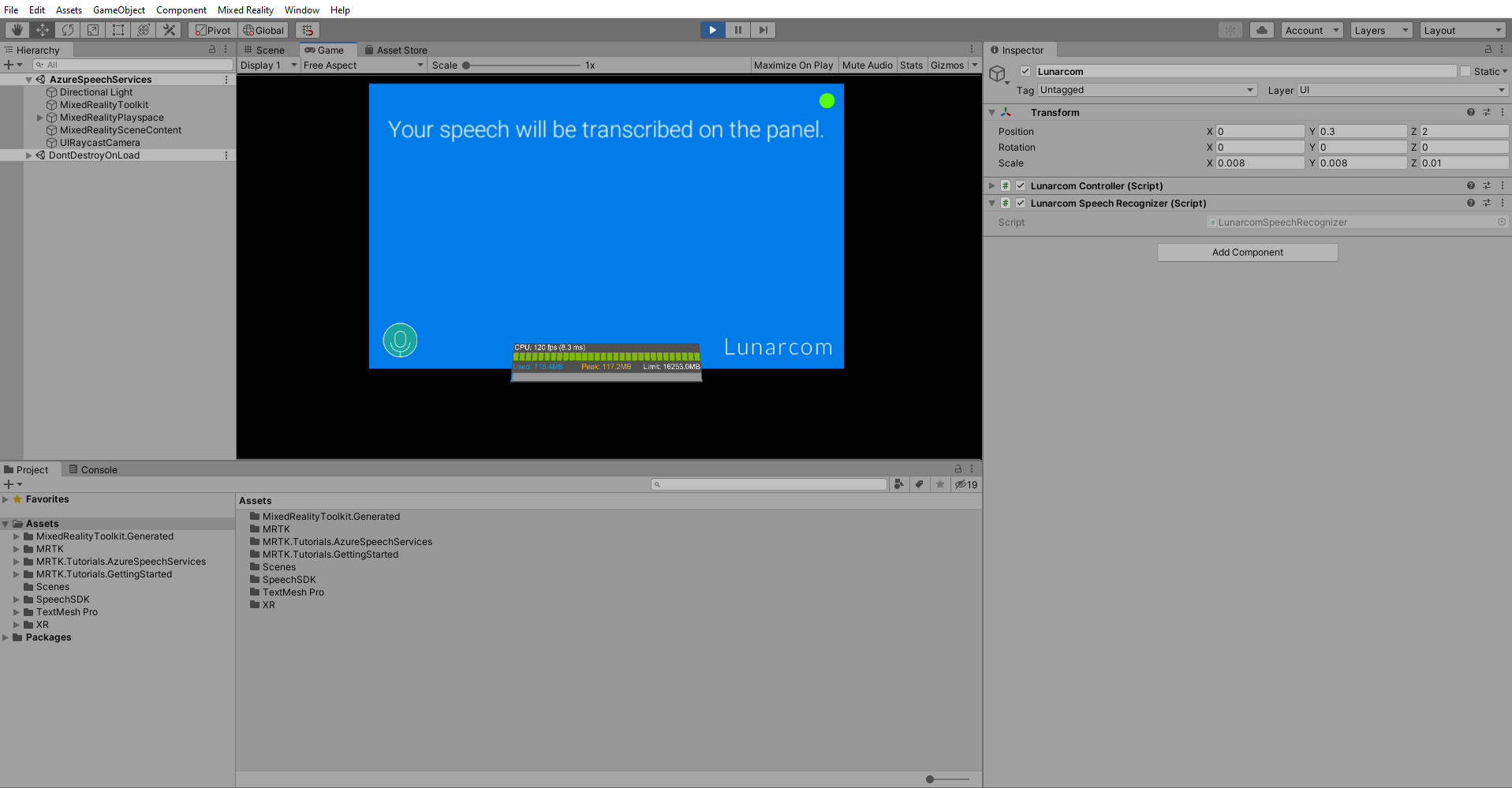

Se ora si entra in modalità gioco e si seleziona il pulsante Riproduci , è possibile testare il riconoscimento vocale premendo prima il pulsante del microfono:

Supponendo quindi che il computer disponga di un microfono, quando pronunci una frase, questa verrà trascritta nel pannello del terminale:

Attenzione

Poiché l'applicazione deve connettersi ad Azure, assicurati che il computer o il dispositivo sia connesso a Internet.