Eseguire il debug del flusso di dati per mapping

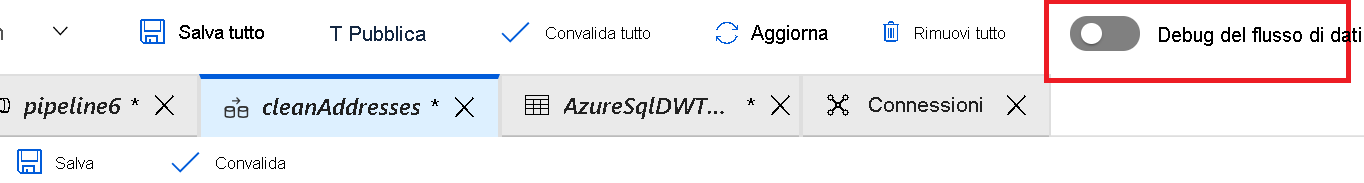

Durante la creazione di flussi di dati per mapping, è possibile esaminare in modo interattivo l'esecuzione delle trasformazioni di dati, in modo che sia possibile eseguirne il debug. Per usare questa funzionalità, è prima di tutto necessario attivare la funzionalità "Debug del flusso di dati".

Se si fa clic su Debug, verrà effettuato il provisioning dei cluster Spark necessari per l'interazione con le trasformazioni del flusso di dati per mapping. Quando si attiva l'opzione Debug, verrà richiesta la selezione dell'infrastruttura di Integration Runtime che deve essere usata nell'ambiente. Se si seleziona AutoResolveIntegrationRuntime, si otterrà un cluster con otto core che sarà disponibile con un valore di durata pari a 60 minuti.

Nota

La creazione del cluster richiede in genere 5-7 minuti. Quando questa modalità è attivata e i cluster Spark sono in esecuzione, sarà possibile creare il flusso di dati un passaggio alla volta e visualizzare i dati mentre vengono sottoposti a ogni fase di trasformazione.

Nella modalità di debug è disponibile una scheda Anteprima dei dati che consentirà di visualizzare i dati in ogni fase della pipeline. È possibile visualizzare i dati dopo ogni trasformazione. Il visualizzatore anteprima dei dati consente anche di eseguire azioni sui dati, ad esempio esaminare le statistiche descrittive per i dati o modificare i dati.

È infine possibile usare le impostazioni di debug per controllare il numero di righe restituite nel visualizzatore anteprima dei dati.

Nota

È consigliabile limitare il numero di righe restituite specificando un valore sufficiente per consentire all'utente di confermare la correttezza dei dati. Più grande è il set di dati, maggiore sarà il tempo necessario per restituire i risultati. È anche possibile usare le impostazioni di debug per specificare i valori dei parametri da usare durante l'esecuzione della pipeline.