Descrivere le considerazioni per la distribuzione di modelli

Nell'ambito del Machine Learning, la distribuzione di modelli può essere considerata un processo tramite il quale si integrano i modelli di Machine Learning con training in un ambiente di produzione in modo che le applicazioni aziendali o degli utenti finali possano usare le stime del modello per prendere decisioni o ottenere informazioni dettagliate sui dati. Il modo più comune per distribuire un modello usando Azure Machine Learning da Azure Databricks è distribuire il modello come servizio di inferenza in tempo reale. In questo caso, per inferenza si intende l'uso di un modello sottoposto a training per fare previsioni su nuovi dati di input su cui non è stato eseguito il training del modello.

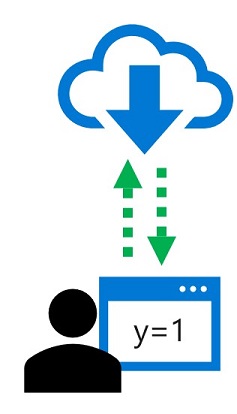

Che cos'è l'inferenza in tempo reale?

Il modello viene distribuito come parte di un servizio che consente alle applicazioni di richiedere previsioni immediate, o in tempo reale, per singole osservazioni di dati o per un numero limitato di esse.

In Azure Machine Learning è possibile creare soluzioni di inferenza in tempo reale distribuendo un modello come servizio in tempo reale, ospitato in una piattaforma di contenitori come Servizi Azure Kubernetes (AKS).